Содержание

- 2. В качестве механизмов управления перегрузками применяются: сброс на пакетном уровне (ранний сброс или сброс остатков); управляемые

- 3. Ранний сброс пакетов. Пакет размещается в n-ом количестве ячеек. Сброс одной ячейки этого пакета в его

- 4. Управляемые буферы позволяют организовать индивидуальные очереди для каждого соединения. Объем буфера и алгоритм обработки данных определены

- 5. Для организации индивидуальных очередей для каждого виртуального соединения общую буферную память необходимо делить на несколько частей.

- 6. Алгоритмы организации очередей в буферах: - по принципу FIFO, когда все соединения, относящиеся к одной категории

- 8. Скачать презентацию

Развитие и политический режим

Развитие и политический режим Державно - територіальний устрій України

Державно - територіальний устрій України Особенности построения систем подвижной радиосвязи

Особенности построения систем подвижной радиосвязи Carlson Hotel Zheleznogorsк

Carlson Hotel Zheleznogorsк  Цены и особенности ценообразования на мировых рынках Юрлова Виктория, М-102

Цены и особенности ценообразования на мировых рынках Юрлова Виктория, М-102 Соціальна політика Республіки Польща

Соціальна політика Республіки Польща Crâşma Haiducului. Meniu

Crâşma Haiducului. Meniu ДУХОВНО-НРАВСТВЕННОЕ ВОСПИТАНИЕ ПОДРАСТАЮЩЕГО ПОКОЛЕНИЯ КАК ГОСУДАРСТВЕННАЯ ПАРАДИГМА Викулов А.В., кандидат педагогических н

ДУХОВНО-НРАВСТВЕННОЕ ВОСПИТАНИЕ ПОДРАСТАЮЩЕГО ПОКОЛЕНИЯ КАК ГОСУДАРСТВЕННАЯ ПАРАДИГМА Викулов А.В., кандидат педагогических н Техническое оснащение коммерческого банка

Техническое оснащение коммерческого банка Муниципальное общеобразовательное учреждение средняя общеобразовательная школа №4 Муниципальное общеобразовательное учрежде

Муниципальное общеобразовательное учреждение средняя общеобразовательная школа №4 Муниципальное общеобразовательное учрежде Brama

Brama Совершенствование ГБЦ двигателя МеМЗ 307

Совершенствование ГБЦ двигателя МеМЗ 307 Информационные технологии

Информационные технологии  Прионы

Прионы Понятие производной Алгебра и начала анализа 11 класс

Понятие производной Алгебра и начала анализа 11 класс  Откуда берутся шоколад, изюм и мёд? Шаршукова В.А., учитель начальных классов МАОУСОШ № 8 г.Старая Русса

Откуда берутся шоколад, изюм и мёд? Шаршукова В.А., учитель начальных классов МАОУСОШ № 8 г.Старая Русса Продовольственная безопасность России

Продовольственная безопасность России Структура персонала ПАО «Аэрофлот»

Структура персонала ПАО «Аэрофлот» Содержательная линия «Алгоритмизации и программирования»

Содержательная линия «Алгоритмизации и программирования» Анализ и управление кредиторской задолженностью организации АО «Туймазыторг»

Анализ и управление кредиторской задолженностью организации АО «Туймазыторг» Дипломная работа на тему: «Горнолыжные курорта Австрии» Выполнила: ст-ка гр. ФТЗ 05 Филипенко Екатерина

Дипломная работа на тему: «Горнолыжные курорта Австрии» Выполнила: ст-ка гр. ФТЗ 05 Филипенко Екатерина Милосердие, забота о слабых, взаимопомощь

Милосердие, забота о слабых, взаимопомощь Компьютерные сети

Компьютерные сети  Кузов. Диагностика двигателя, электрики, ходовой

Кузов. Диагностика двигателя, электрики, ходовой Скрипчук П.М. д.э.н., професор, НУВГП, Ровно Жизненый цикл продукции и критерии экологической маркировки

Скрипчук П.М. д.э.н., професор, НУВГП, Ровно Жизненый цикл продукции и критерии экологической маркировки  Эпоха Возрождения

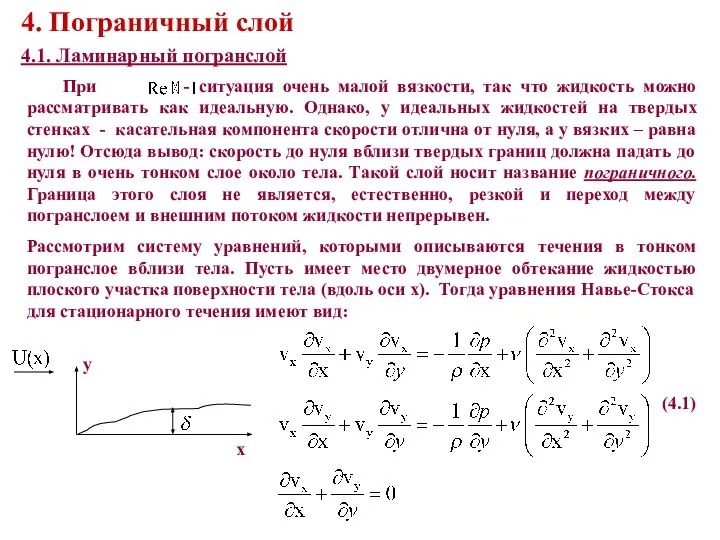

Эпоха Возрождения Пограничный слой

Пограничный слой Презентация "Проблема продовольственной безопасности России в современных условиях2" - скачать презентации по Экономике

Презентация "Проблема продовольственной безопасности России в современных условиях2" - скачать презентации по Экономике