Содержание

- 2. Введение Измерение – нахождение значения физической величины опытным путем с помощью специальных технических средств. Мера –

- 3. Введение Рис. 1.1 Меры информации

- 4. Введение В синтаксическом подходе выделяют: Структурная теория рассматривает дискретное строение массивов информации и их измерение простым

- 5. 1.1. Синтаксические меры информации. Структурная теория. При использовании структурной теории (структурных мер) учитывается только дискретное строение

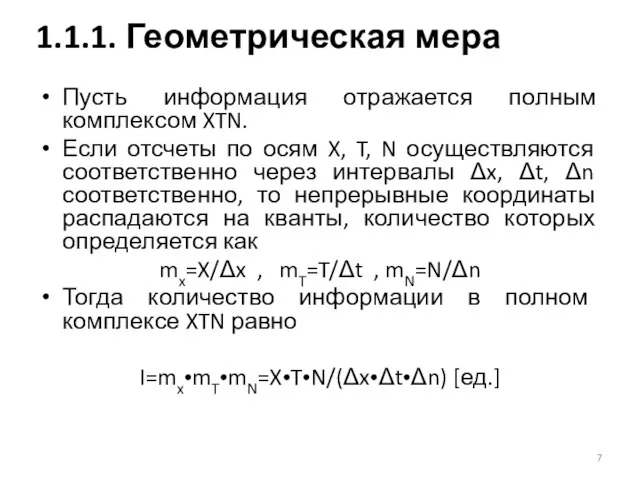

- 6. 1.1.1. Геометрическая мера Определение количества информации геометрическим методом сводится к измерению длины лини, площади или объёма

- 7. Пусть информация отражается полным комплексом XTN. Если отсчеты по осям X, T, N осуществляются соответственно через

- 8. К этой мере целесообразно прибегать тогда, когда требуется оценить возможность передачи информации при помощи различных комбинаций

- 9. В комбинаторике рассматривают различные виды соединения из n элементов по m элементов, например: сочетания Cnm=n!/[m!•(n-m)!] перестановки

- 10. Количество информации в комбинаторной мере вычисляется как количество комбинаций информационных элементов. Т.е. производится оценка структурного разнообразия,

- 11. Например, при сочетаниях из n=10 по m=0, 1, 2, 3 …9, 10 элементов имеем C=10!/0!(10-0)!+10!/1!(10-1)!+…+10!/10!(10-10)!=1+10+45+120+210+252+210+120+45+10+1=1024 комбинации

- 12. Не всегда все возможные комбинации составляют действительные степени свободы данной системы. Тогда расчет ведется по реализуемым

- 13. Из теории вероятностей: Проводится некий опыт, исход которого называется событием. Например, при бросании монеты имеем 2

- 14. Из теории вероятностей: Меру случайности называют вероятностью и обозначают P(A). Если P(A)=1, то имеем достоверное событие,

- 15. Из теории вероятностей: Событие A называется независимым от события B, если P(A) не зависит от того,

- 16. Из теории вероятностей: События A и B называют несовместными, если в результате опыта они никогда не

- 17. Из теории вероятностей: Суммой событий A и B называется событие, состоящее в появлении хотя бы одного

- 18. Из теории вероятностей: Совокупность событий составляют полную группу, если в результате опыта непременно должно произойти одно

- 19. Рассмотрим 2 независимых опыта с числом равновероятных исходов N1 и N2 Предположим, что в результате наблюдения

- 20. Искомая функция f(*) должна удовлетворять условию: f(N1)+f(N2)=f(N1•N2) Единственной функцией удовлетворяющей этому условию является f(*)=loga(*) Формула Р.Хартли

- 21. В зависимости от выбора основания логарифма получаем следующие меры количества информации: a=e I=ln N [нит] –

- 22. Иной подход к выводу формулы Хартли: Пусть передаваемое сообщение имеет вид числа, представленного в той или

- 23. В случае, когда все N состояний равновероятны, получаем следующую формулу для оценки количества информации: I=logaN=n•logam Если

- 24. При статистическом (вероятностном) подходе информация рассматривается как сообщения о случайных событиях – исходах некоторого опыта, а

- 25. Последовательность знаков с таким свойством называется шенноновским сообщением. Поскольку сами знаки и содержащаяся в них информация

- 26. Упорядоченным называется состояние системы, осуществляемое относительно малым числом способов, а беспорядочным – состояние, реализуемое относительно большим

- 27. Рассмотрим в качестве системы сосуд, разделенный проницаемой перегородкой на две равные части и содержащий 4 молекулы

- 28. 1.2.1. Понятие энтропии Таблица 1.1 Распределение четырех молекул в двух зонах

- 29. Формула: K=N!/(N1!•N2!)=N!/[N1!•(N-N1)!] С увеличением числа молекул различия в вероятностях будут резко возрастать (таблица 1.2) 1.2.1. Понятие

- 30. 1.2.1. Понятие энтропии Таблица 1.2. Распределение N молекул в двух зонах

- 31. Вероятность скопления N молекул газа в одной половине сосуда объемом 1 см3 можно оценить следующим образом:

- 32. Второй закон термодинамики: Природа стремится от состояний менее вероятных к состояниям более вероятным (Л. Больцман). 1.2.1.

- 33. Пример: Если взять 4-разрядные двоичные числа, то в 6 комбинациях из 16 возможных имеем равное количество

- 34. Энтропия в термодинамике – количественная мера неупорядоченности, мера вероятности осуществления какого-либо состояния системы. В физику понятие

- 35. Статистический смысл второго закона (начала) термодинамики: Макроскопическое состояние газа с некоторыми значениями параметров представляет собой смену

- 36. В соответствии со вторым законом для замкнутого пространства (изолированной системы) энтропия равна S=-1/N•Σni ln(ni/N)=-Σpi ln pi

- 37. Иная трактовка - энтропия как мера вероятности осуществления какого-либо состояния системы: S=-Σpi ln pi =k lnW

- 38. Третий смысл энтропии получается из понятия упорядоченности: коль скоро неупорядоченные состояния системы достижимы большим числом способов

- 39. Энтропия в теории информации – количественная мера неопределенности. Трактовку ввел в 1948 г. Клод Шеннон 1.2.2.

- 40. Главным свойством рассмотренных опытов является неопределенность, т.к. каждый исход – случайное событие. Важно уметь численно оценить

- 41. Для опыта с N равновероятными исходами x1, x2,…xN (полная группа случайных событий) таблица вероятностей имеет вид:

- 42. Рассматривая количество информации как меру неопределенности такого опыта в соответствии с формулой Хартли имеем I= ld

- 43. В общем случае для опыта с N неравновероятными исходами: Мера неопределенности: H(X)=-p1 ld p1-p2ld p2 -…-pN

- 44. H(X) – энтропия случайного опыта или просто энтропия. H(X)=-Σpi ld pi при Σpi=1 Это основное определение

- 45. Единице измерения энтропии 1 бит соответствует опыт, имеющий N=2 равновероятных исходов H(X)=-1/2 ld ½-1/2 ld ½=1/2+1/2=1

- 46. Сопоставление термодинамической формулы (Больцмана) и информационной (Хартли и Шеннона) трактовок понятия энтропии приводит к фундаментальному соотношению

- 47. H(X) – величина вещественная и неотрицательная H(X)min=0 когда pk=1, pi=1 H(X)max=ld N когда pi=1/N H(X)min H(X)>=H(f(X))

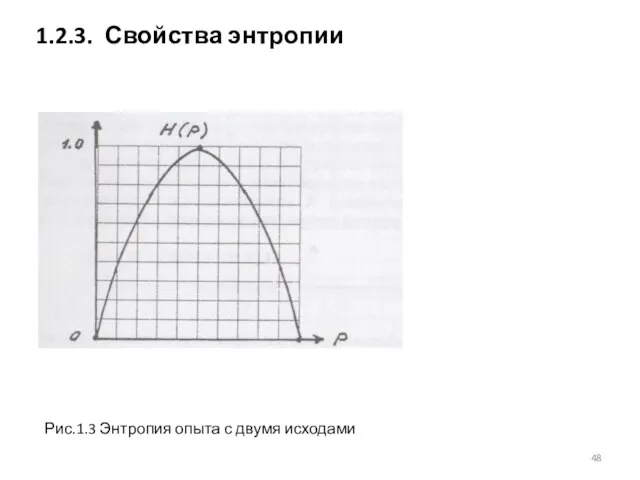

- 48. 1.2.3. Свойства энтропии Рис.1.3 Энтропия опыта с двумя исходами

- 49. Условная энтропия HY(X) является мерой остаточной неопределенности. 1.2.4. Количество информации Рис.1.4. Упрощенная схема передачи сообщений

- 50. Пусть источник сообщений (испытатель), наблюдая за случайными исходами, генерирует и передает исходное сообщение X, характеризуемое энтропией

- 51. Количество информации – числовая характеристика сигнала, позволяющая оценить исходную степень неопределенности, которая исчезает после выбора (получения)

- 52. Для латинского алфавита (26 букв) H=ld 26≈4,7 бит/букву Для кириллицы (33 буквы) H=ld 33≈5,05 бит/букву С

- 53. Рассмотрим оценки, отвечающие как семантическому, так и прагматическому подходам. Это обусловлено тем, что в инженерных применениях

- 54. Оценка содержательности основана на математической логике, в которой логические функции истинности m(A) и имеют формальное сходство

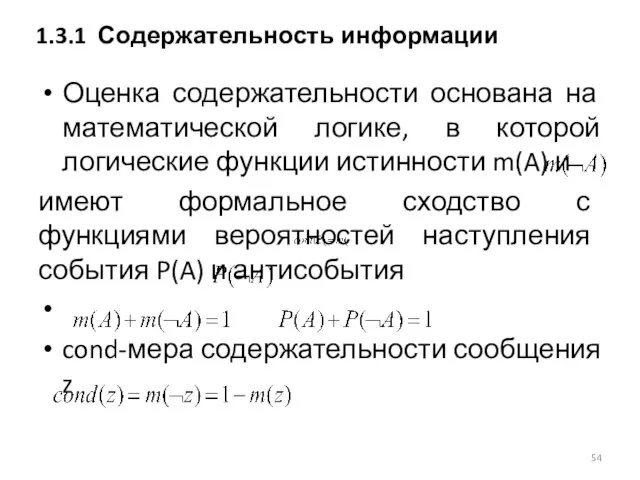

- 55. Логическая оценка информации: Отличие статистической оценки от логической состоит в том, что в первом случае учитываются

- 56. А.А.Харткевичем предложена мера целесообразности информации, которая определяется как изменение вероятности достижения цели при получении дополнительной информации.

- 57. Мера целесообразности в общем виде может выть выражена соотношением I=Ld p1-ld p0=ld(p1/p0) где p0, p1 –

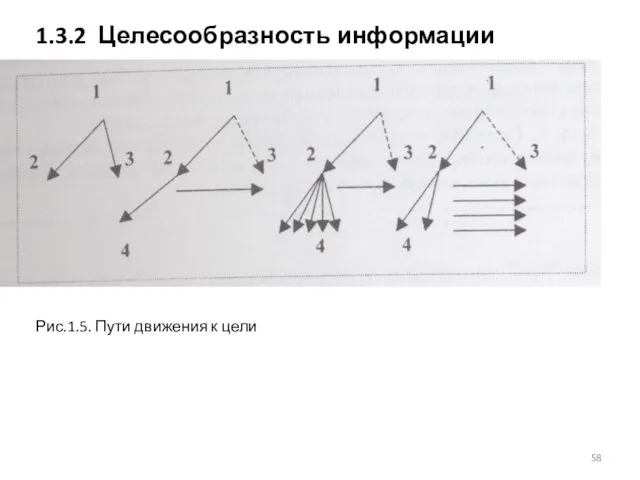

- 58. 1.3.2 Целесообразность информации Рис.1.5. Пути движения к цели

- 59. Пусть имеется некоторое исходное состояние (точка 1), цель (точка 3), и некоторое промежуточное состояние (точка2). Из

- 61. Скачать презентацию

![Формула: K=N!/(N1!•N2!)=N!/[N1!•(N-N1)!] С увеличением числа молекул различия в вероятностях будут резко](/_ipx/f_webp&q_80&fit_contain&s_1440x1080/imagesDir/jpg/563721/slide-28.jpg)

Програмні засоби навчального призначення. Інформаційні технології у навчанні

Програмні засоби навчального призначення. Інформаційні технології у навчанні Общие вопросы поиска информации в Интернет

Общие вопросы поиска информации в Интернет Собственные звуки и рисунки

Собственные звуки и рисунки Логические основы построения компьютера

Логические основы построения компьютера Персональный компьютер

Персональный компьютер Интеллектуальная игра по информатике

Интеллектуальная игра по информатике Презентация Программное обеспечение в трудовой деятельности Цели, задачи, перспективы, недостакти

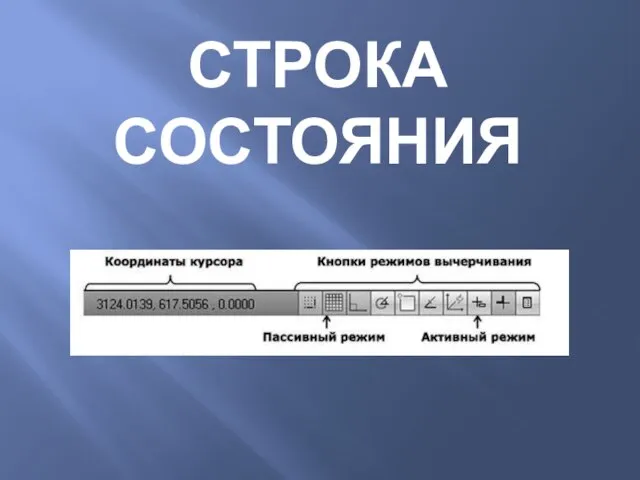

Презентация Программное обеспечение в трудовой деятельности Цели, задачи, перспективы, недостакти  Строка состояния

Строка состояния Автоматическое оглавление. Документ Word

Автоматическое оглавление. Документ Word Кибер-безопасность

Кибер-безопасность Методологии проектирования информационных систем

Методологии проектирования информационных систем Функционалдық тәуелділік түсінігі. Қатынастық деректер қоры

Функционалдық тәуелділік түсінігі. Қатынастық деректер қоры Информационные процессы: обработка, защита и представление информации

Информационные процессы: обработка, защита и представление информации «Алгоритмы с ветвлениями» Урок информатики 4 класс Учитель информатики МБОУ СОШ № 10 Андреева Оксана Евгеньевна г. Сургут

«Алгоритмы с ветвлениями» Урок информатики 4 класс Учитель информатики МБОУ СОШ № 10 Андреева Оксана Евгеньевна г. Сургут Мобильные приложения как явление постсоветской культуры

Мобильные приложения как явление постсоветской культуры Розробка web-сторінки кафедри інформаційних технологій

Розробка web-сторінки кафедри інформаційних технологій Information technology

Information technology Информационные процессы

Информационные процессы Інженерія програмного забезпечення. (Лекція 2)

Інженерія програмного забезпечення. (Лекція 2) Investigating OpenFlow negotiations. Lecture 6

Investigating OpenFlow negotiations. Lecture 6 Алфавиты, слова, языки, алгоритмические проблемы

Алфавиты, слова, языки, алгоритмические проблемы PowerPoint

PowerPoint Понятие о динамических данных. Работа с динамическими массивами

Понятие о динамических данных. Работа с динамическими массивами Техническое обучение ISaGRAF. Обзор Workbench

Техническое обучение ISaGRAF. Обзор Workbench Основные понятия и средства языка программирования

Основные понятия и средства языка программирования Информатика Учебник для 6 класса Л. Босова Выполнил: Фролов. А. 231группа

Информатика Учебник для 6 класса Л. Босова Выполнил: Фролов. А. 231группа  Как устроен компьютер

Как устроен компьютер Кто создал Интернет

Кто создал Интернет