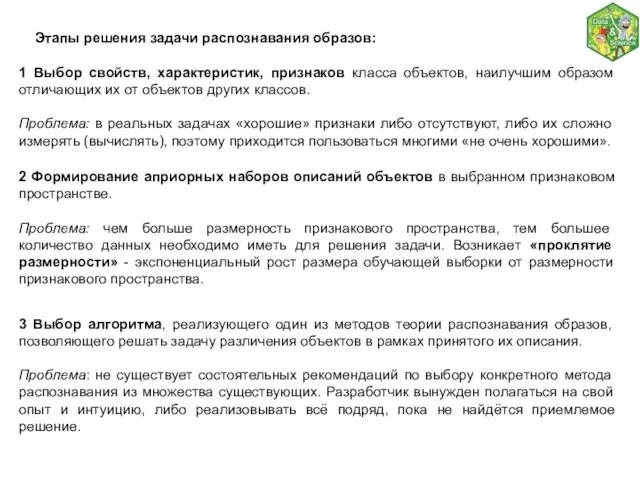

Этапы решения задачи распознавания образов:

1 Выбор свойств, характеристик, признаков класса

объектов, наилучшим образом отличающих их от объектов других классов.

Проблема: в реальных задачах «хорошие» признаки либо отсутствуют, либо их сложно измерять (вычислять), поэтому приходится пользоваться многими «не очень хорошими».

2 Формирование априорных наборов описаний объектов в выбранном признаковом пространстве.

Проблема: чем больше размерность признакового пространства, тем большее количество данных необходимо иметь для решения задачи. Возникает «проклятие размерности» - экспоненциальный рост размера обучающей выборки от размерности признакового пространства.

3 Выбор алгоритма, реализующего один из методов теории распознавания образов, позволяющего решать задачу различения объектов в рамках принятого их описания.

Проблема: не существует состоятельных рекомендаций по выбору конкретного метода распознавания из множества существующих. Разработчик вынужден полагаться на свой опыт и интуицию, либо реализовывать всё подряд, пока не найдётся приемлемое решение.

Программирование (Python)

Программирование (Python) Навигационно-программный комплекс Навигационно-программный комплекс «СитиГИД-Диспетчер»

Навигационно-программный комплекс Навигационно-программный комплекс «СитиГИД-Диспетчер»  Тема 13 Понятие об алгоритме 1. Понятие об алгоритме 2. Способы записи алгоритмов 3. Алгоритмы ветвления 4. Циклические алгоритмы

Тема 13 Понятие об алгоритме 1. Понятие об алгоритме 2. Способы записи алгоритмов 3. Алгоритмы ветвления 4. Циклические алгоритмы Метод координат, как форма представления информации

Метод координат, как форма представления информации Мультимедиа. Аналоговый и цифровой звук. Технические средства мультимедиа Информатика 8 класс. Диденко В.В.

Мультимедиа. Аналоговый и цифровой звук. Технические средства мультимедиа Информатика 8 класс. Диденко В.В. Программирование на языке Python

Программирование на языке Python Знакомство с языком программирования Python. Ввод. Вывод. Оператор присваивания. Математические операции

Знакомство с языком программирования Python. Ввод. Вывод. Оператор присваивания. Математические операции Шаблоны интеграционных взаимодействий

Шаблоны интеграционных взаимодействий Физическая среда передачи данных

Физическая среда передачи данных Этапы разработки базы данных дата проведения: 04.02.09 Провела: Учитель информатики и ВТ Хрусцелевская Н.В. Прослушал: 11 класс

Этапы разработки базы данных дата проведения: 04.02.09 Провела: Учитель информатики и ВТ Хрусцелевская Н.В. Прослушал: 11 класс Разработка алгоритма и программы расчета пропускной способности системы обмена данными

Разработка алгоритма и программы расчета пропускной способности системы обмена данными CMS системы (1 занятие )

CMS системы (1 занятие ) Презентация по информатике Безопасный интернет

Презентация по информатике Безопасный интернет  [EPAM Java Training] Client-Server

[EPAM Java Training] Client-Server Қосымша басқару элементтерін қолдану. Microsoft Web Browser, Calendar, RefEdit басқару элементтері

Қосымша басқару элементтерін қолдану. Microsoft Web Browser, Calendar, RefEdit басқару элементтері Процессоры фирмы AMD до Athlon XP (Thorton/Model 10)

Процессоры фирмы AMD до Athlon XP (Thorton/Model 10)  26 ноября – Всемирный день информации

26 ноября – Всемирный день информации  Как работать сYouTube? Социальный сервис, предоставляющие услуги хостинга любительского видео.

Как работать сYouTube? Социальный сервис, предоставляющие услуги хостинга любительского видео. Программирование на языках высокого уровня

Программирование на языках высокого уровня УМК нового поколения для начальной школы Музыка системы Перспектива

УМК нового поколения для начальной школы Музыка системы Перспектива Видеохостинг нацеленный на Кавказскую тематику

Видеохостинг нацеленный на Кавказскую тематику ПРАВОВАЯ ИНФОРМАТИКА

ПРАВОВАЯ ИНФОРМАТИКА Создание бронирования в GDS Amadeus. (Лекция 1)

Создание бронирования в GDS Amadeus. (Лекция 1) SQL - структурированный язык запросов

SQL - структурированный язык запросов Информационная безопасность при работе со сторонними организациями и информационная безопасность активов организации

Информационная безопасность при работе со сторонними организациями и информационная безопасность активов организации Часы

Часы Компьютерные вирусы и антивирусные программы

Компьютерные вирусы и антивирусные программы Методы и строки. Часть 3

Методы и строки. Часть 3