Содержание

- 2. 07.11.2021 Лекция 1. Введение в дисциплину «Теоретические основы информатики"

- 3. 07.11.2021 Понятие информации Информация (от лат. informātiō «разъяснение, представление, понятие о чём-либо»— сведения независимо от формы

- 4. 07.11.2021 Свойства информации Значимость. Свойство информации сохранять свою потребительскую ценность для получения в течение времени, то

- 5. 07.11.2021 Понятие информатики Информатика — фундаментальная естественная наука, изучающая общие свойства информации, процессы, методы и средства

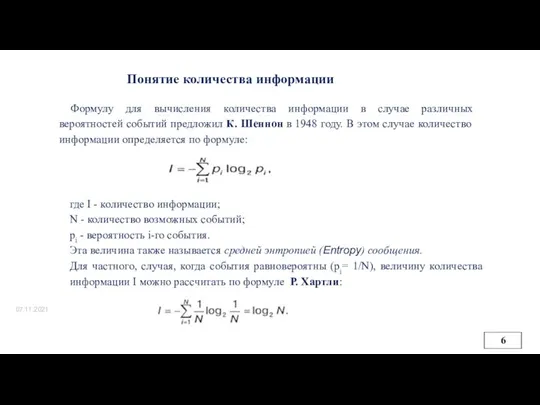

- 6. 07.11.2021 Понятие количества информации Формулу для вычисления количества информации в случае различных вероятностей событий предложил К.

- 7. Частота встречаемости букв русского алфавита

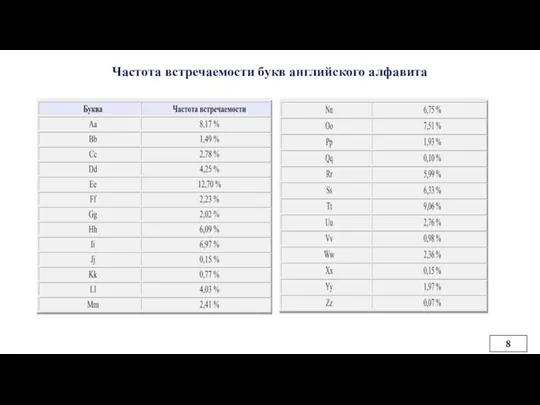

- 8. Частота встречаемости букв английского алфавита

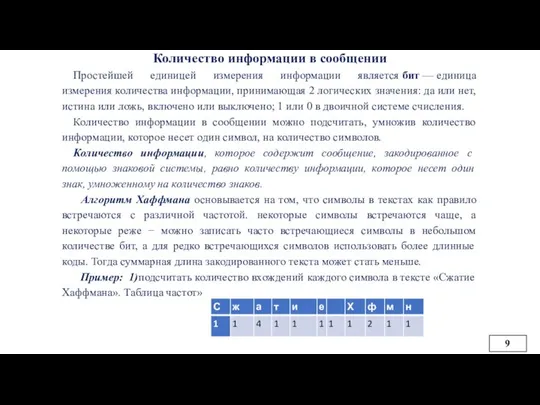

- 9. Количество информации в сообщении Простейшей единицей измерения информации является бит — единица измерения количества информации, принимающая

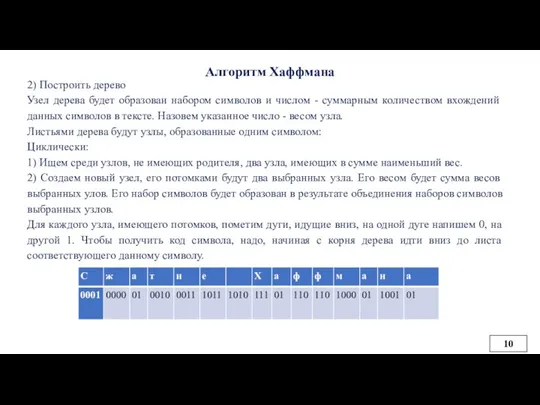

- 10. Алгоритм Хаффмана 2) Построить дерево Узел дерева будет образован набором символов и числом - суммарным количеством

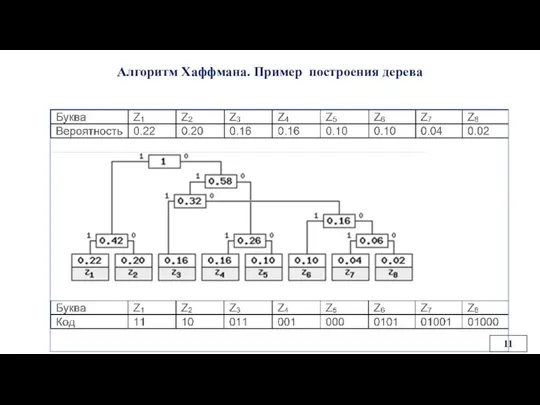

- 11. Алгоритм Хаффмана. Пример построения дерева

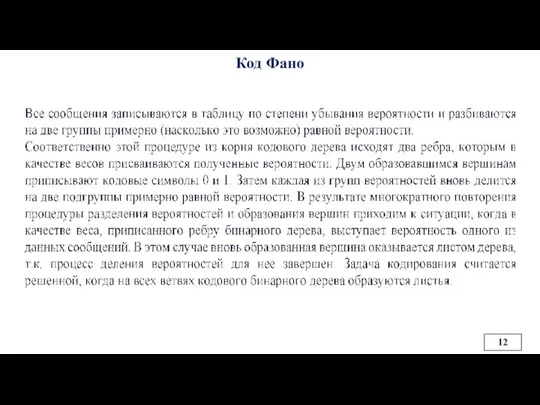

- 12. Код Фано

- 13. Код Фано Цена кодирования (средняя длина кодового слова является критерием степени оптимальности кодирования. Это сумма произведений

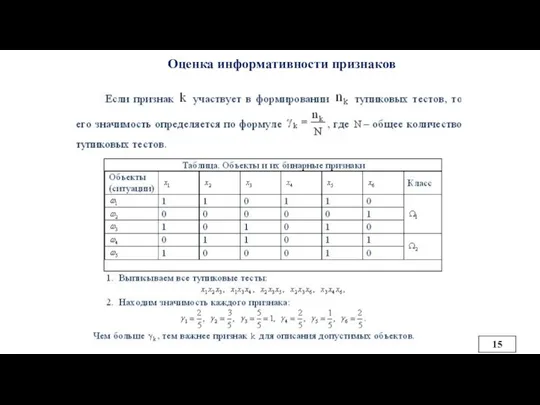

- 14. Оценка информационной значимости признаков (ак. Журавлев Ю.И.) Пусть задана таблица бинарных признаков для случая двух классов.

- 15. Оценка информативности признаков

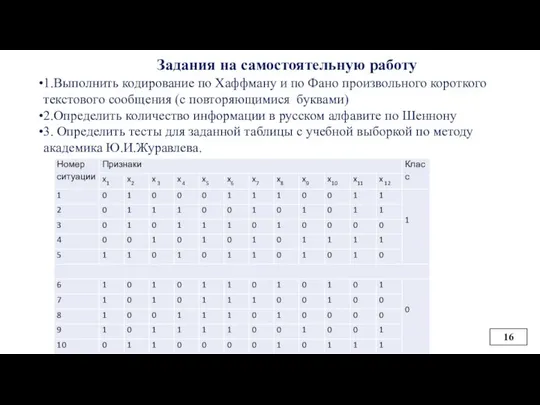

- 16. Задания на самостоятельную работу 1.Выполнить кодирование по Хаффману и по Фано произвольного короткого текстового сообщения (с

- 18. Скачать презентацию

«МОЙ КОМПЬЮТЕР»

«МОЙ КОМПЬЮТЕР» Графика языка паскаль

Графика языка паскаль Модель как отражение существующих свойств реального объекта. 6 класс

Модель как отражение существующих свойств реального объекта. 6 класс ОБЩАЯ ХАРАКТЕРИСТИКА ТАБЛИЧНОГО ПРОЦЕССОРА

ОБЩАЯ ХАРАКТЕРИСТИКА ТАБЛИЧНОГО ПРОЦЕССОРА Персональный компьютер. Компьютер как унивесальное устройство для работы с информацией

Персональный компьютер. Компьютер как унивесальное устройство для работы с информацией Managing and optimizing subscriber QoE with geo-located subscriber intelligence

Managing and optimizing subscriber QoE with geo-located subscriber intelligence Знакомство с компьютером

Знакомство с компьютером Презентация "Хотите научиться создавать различные творческие проекты?" - скачать презентации по Информатике

Презентация "Хотите научиться создавать различные творческие проекты?" - скачать презентации по Информатике Алгоритм. Решение задач

Алгоритм. Решение задач Создание форм (Майоров гр-31гс)

Создание форм (Майоров гр-31гс) Технология обработки графической информации

Технология обработки графической информации История создания ОС. Семейство ОС MS Windows.

История создания ОС. Семейство ОС MS Windows. Феномен женской интернет-поэзии (на примере творчества Ах Астаховой)

Феномен женской интернет-поэзии (на примере творчества Ах Астаховой) Презентация История развития вычислительной техники

Презентация История развития вычислительной техники Оформление Претензии Клиентом. Порядок действий для оператора в отделении

Оформление Претензии Клиентом. Порядок действий для оператора в отделении Модели жизненного цикла. Прикладное программирование

Модели жизненного цикла. Прикладное программирование Устройства вывода информации

Устройства вывода информации  КОМПЬЮТЕРНАЯ БЕЗОПАСНОСТЬ

КОМПЬЮТЕРНАЯ БЕЗОПАСНОСТЬ  Локализация сайтов на примере Kaspersky Online Help

Локализация сайтов на примере Kaspersky Online Help Graphical User. Interface

Graphical User. Interface Презентация о презентации Для Участников Питерского клуба своего дела

Презентация о презентации Для Участников Питерского клуба своего дела Power Point 2007. Програма для створення яскравих презентацій

Power Point 2007. Програма для створення яскравих презентацій Электронные ресурсы: правила составления библиографического описания

Электронные ресурсы: правила составления библиографического описания Учимся создавать неплохие сайты

Учимся создавать неплохие сайты Замена прошивки MICOM в плате наружного блока AQVPSBX Maldives с помощью GMAN

Замена прошивки MICOM в плате наружного блока AQVPSBX Maldives с помощью GMAN Модели жизненного цикла ПО

Модели жизненного цикла ПО X.509 at the University of Michigan. Project Goals

X.509 at the University of Michigan. Project Goals Что будет делать бот

Что будет делать бот