Содержание

- 2. Нейросетевой подход: основные положения Процессы познания -- результат взаимодействия большого числа простых перерабатывающих элементов, связанных друг

- 3. Классы задач, решаемых современными нейросетями: Классификация: распознавание образов, распознавание голосов, верификация подписей, постановка диагноза, анализ экспериментальных

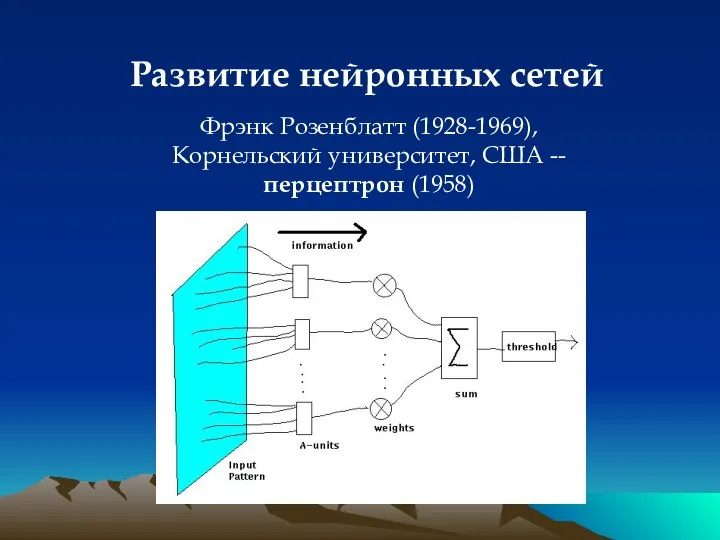

- 4. Развитие нейронных сетей Фрэнк Розенблатт (1928-1969), Корнельский университет, США -- перцептрон (1958)

- 5. Развитие нейронных сетей Фрэнк Розенблатт (1928-1969), Корнельский университет, США 1962 -- «Принципы нейродинамики: перцептроны и теория

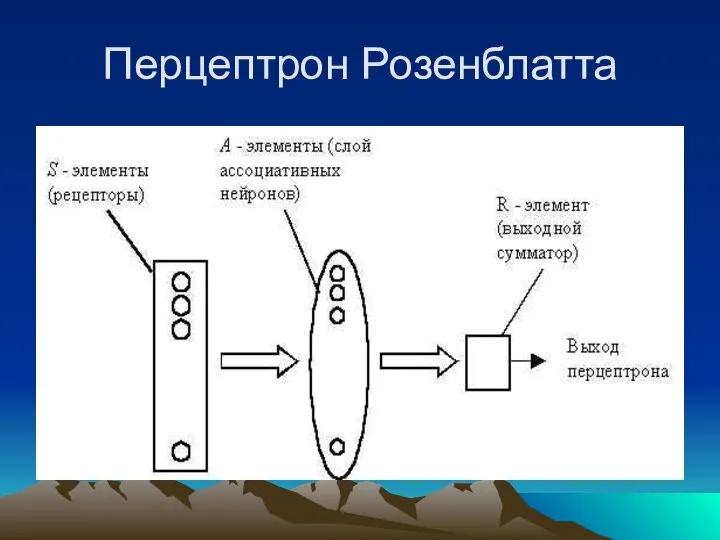

- 6. Перцептрон Розенблатта

- 7. Перцептрон Розенблатта Однослойный персептрон характеризуется матрицей синаптических связей ||W|| от S- к A-элементам. Элемент матрицы отвечает

- 8. Обучение нейронной сети Нейронная сеть обучается, чтобы для некоторого множества входных сигналов давать желаемое множество выходных

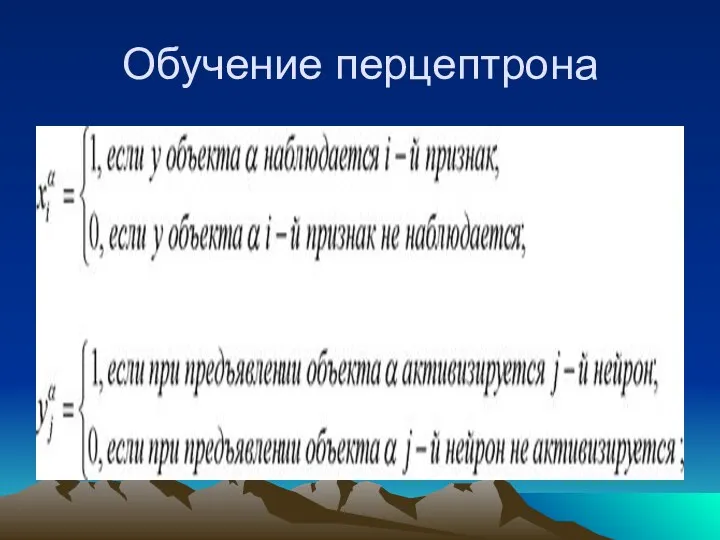

- 9. Обучение перцептрона Обучение классической нейронной сети состоит в подстройке весовых коэффициентов каждого нейрона. Пусть имеется набор

- 10. Обучение перцептрона

- 11. Обучение перцептрона Будем называть нейронную сеть обученной на данной обучающей выборке, если при подаче на вход

- 12. Обучение перцепторна Система связей между рецепторами S и A - элементами, так же как и пороги

- 13. Обучение перцептрона Предъявляем обучающую выборку: объекты (например, круги либо квадраты) с указанием класса, к которым они

- 14. ОБУЧЕНИЕ НЕЙРОННОЙ СЕТИ Дональд Олдинг Хебб (1904-1985) Итог -- образование «нейронного ансамбля», который все быстрее активируется

- 15. Основные понятия: «Нейрон» (unit, node) -- элемент сети, который суммирует входные сигналы и, в случае превышения

- 16. Алгоритм обучения (метод градиентного спуска - обратное распространение ошибки) Выбрать очередную пару векторов Xk и Yk

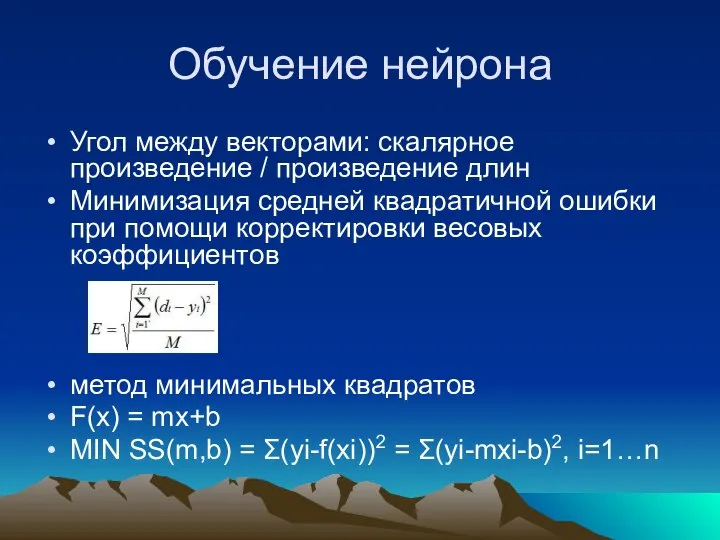

- 17. Обучение нейрона Угол между векторами: скалярное произведение / произведение длин Минимизация средней квадратичной ошибки при помощи

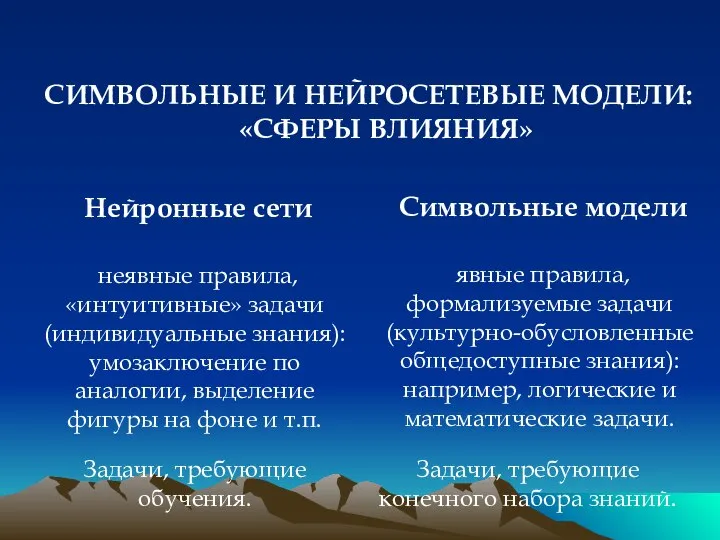

- 18. Нейронные сети Символьные модели неявные правила, «интуитивные» задачи (индивидуальные знания): умозаключение по аналогии, выделение фигуры на

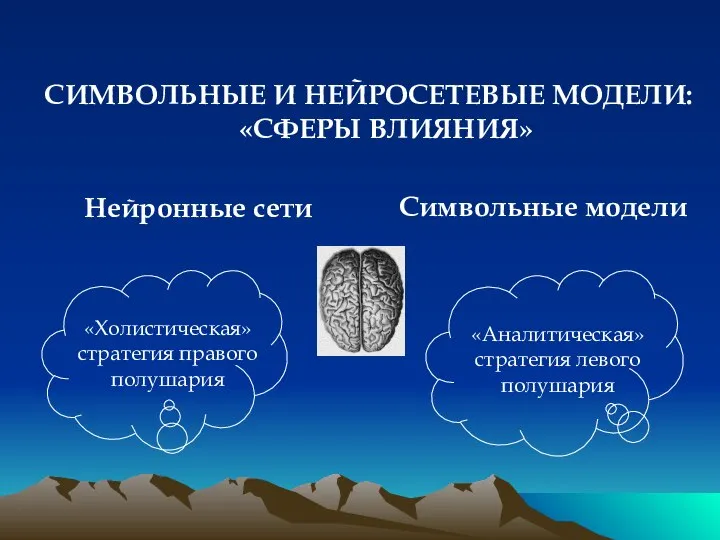

- 19. Нейронные сети Символьные модели СИМВОЛЬНЫЕ И НЕЙРОСЕТЕВЫЕ МОДЕЛИ: «СФЕРЫ ВЛИЯНИЯ»

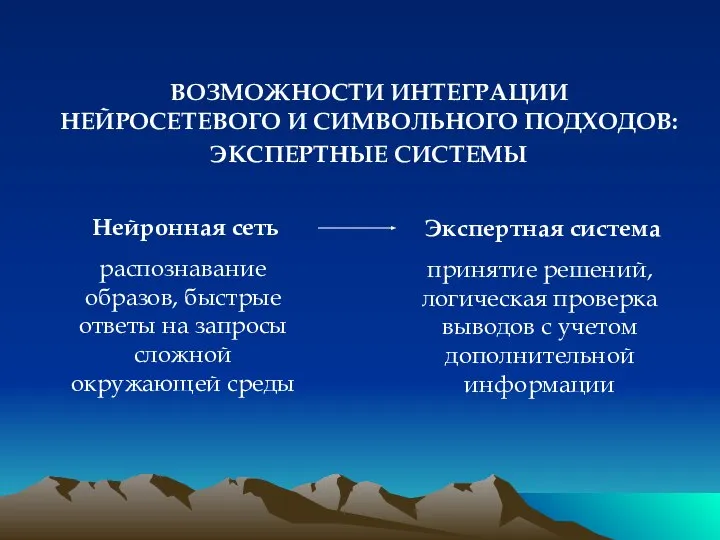

- 20. Нейронная сеть распознавание образов, быстрые ответы на запросы сложной окружающей среды ВОЗМОЖНОСТИ ИНТЕГРАЦИИ НЕЙРОСЕТЕВОГО И СИМВОЛЬНОГО

- 22. Скачать презентацию

Maintenance Seminar. Dosing to Perfection

Maintenance Seminar. Dosing to Perfection Профилактика подросткового суицида Prezentacii.com

Профилактика подросткового суицида Prezentacii.com  Расчет фильтрационных характеристик призабойной части пласта по ИД

Расчет фильтрационных характеристик призабойной части пласта по ИД Соціальна відповідальность в процесі реалізації права володіння, користування, розпорядження національним капіталом

Соціальна відповідальность в процесі реалізації права володіння, користування, розпорядження національним капіталом Многопоточное программирование (Лекция 0)

Многопоточное программирование (Лекция 0) Земельные, водные и биологические ресурсы России Подготовила Студентка группы Э122б Арсёнова В.

Земельные, водные и биологические ресурсы России Подготовила Студентка группы Э122б Арсёнова В. Правосознание и правовая культура

Правосознание и правовая культура Python. Цикл while. Условие завершения цикла. Составное условие. Логические операторы. Порядок выполнения действий

Python. Цикл while. Условие завершения цикла. Составное условие. Логические операторы. Порядок выполнения действий Концепция свадьбы по мотивам фильма «В живых останутся только любовники»

Концепция свадьбы по мотивам фильма «В живых останутся только любовники» Перекрестные системы

Перекрестные системы Основы программирования. Эффективные алгоритмы сортировки

Основы программирования. Эффективные алгоритмы сортировки Т4 ТКЗ.ppt

Т4 ТКЗ.ppt Черенков Фёдор Фёдорович

Черенков Фёдор Фёдорович Художественные промыслы Нижегородской области - Презентация_

Художественные промыслы Нижегородской области - Презентация_ 8 класс М.С. Батяева

8 класс М.С. Батяева Презентация История развития федерализма в России

Презентация История развития федерализма в России  Обмен веществ и энергии

Обмен веществ и энергии Эрик Вайхенмайер - единственный в мире слепой альпинист

Эрик Вайхенмайер - единственный в мире слепой альпинист КАМПИЛОБАКТЕРИОЗЫ СПбГУ 2015г.

КАМПИЛОБАКТЕРИОЗЫ СПбГУ 2015г.  Краткая история возникновения волейбола

Краткая история возникновения волейбола Введение в динамику механической системы

Введение в динамику механической системы 3-х этажный жилой блок-дом для молодых семей со стенами из блоков

3-х этажный жилой блок-дом для молодых семей со стенами из блоков Противодействие необоснованным требованиям, подтвержденным судебным актом. Дела о банкротстве

Противодействие необоснованным требованиям, подтвержденным судебным актом. Дела о банкротстве Диссертационное исследование требования

Диссертационное исследование требования  Презентация на тему "Как помочь ребенку стать внимательным" - скачать презентации по Педагогике

Презентация на тему "Как помочь ребенку стать внимательным" - скачать презентации по Педагогике Самоконтроль при занятиях физической культурой и спортом

Самоконтроль при занятиях физической культурой и спортом Массивы в языке программирования

Массивы в языке программирования паровоз

паровоз