Содержание

- 2. Классификации подходов к оценке количества информации Синтаксическая мера количества информации оперирует с обезличенной информацией, не выражающей

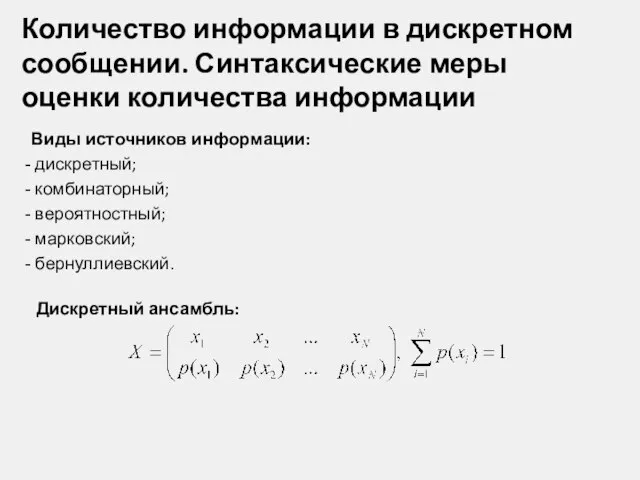

- 3. Количество информации в дискретном сообщении. Синтаксические меры оценки количества информации Виды источников информации: дискретный; комбинаторный; вероятностный;

- 4. Количество информации в дискретном сообщении. Синтаксические меры оценки количества информации Требования к вводимой мере оценки количества

- 5. Количество информации в дискретном сообщении. Синтаксические меры оценки количества информации Комбинаторный подход к оценке количества информации

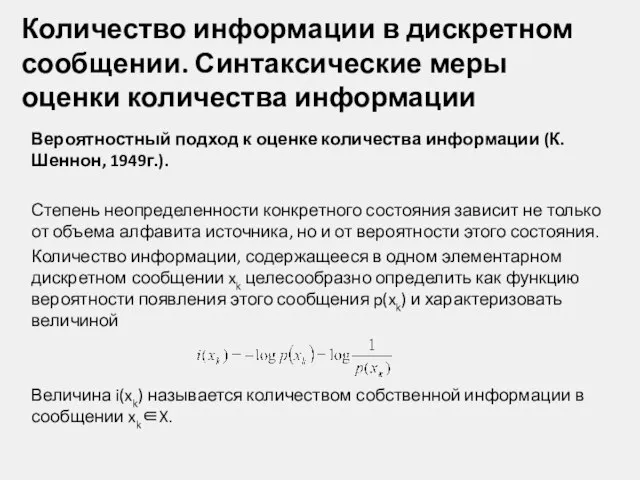

- 6. Количество информации в дискретном сообщении. Синтаксические меры оценки количества информации Вероятностный подход к оценке количества информации

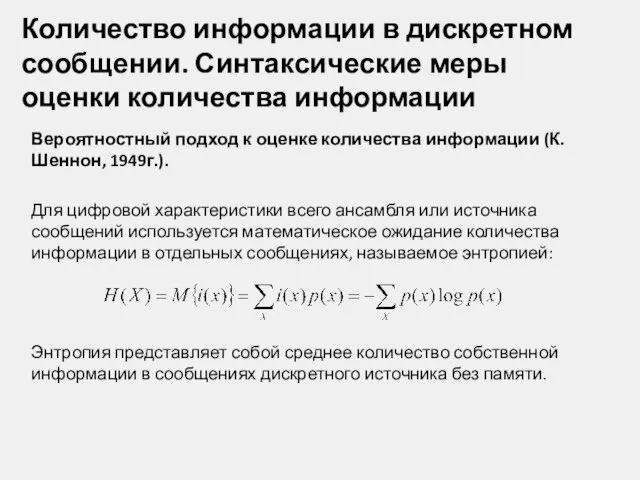

- 7. Количество информации в дискретном сообщении. Синтаксические меры оценки количества информации Вероятностный подход к оценке количества информации

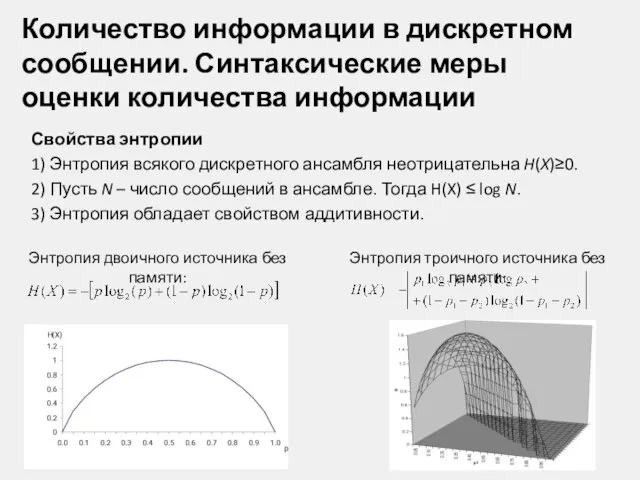

- 8. Количество информации в дискретном сообщении. Синтаксические меры оценки количества информации Свойства энтропии 1) Энтропия всякого дискретного

- 9. Количество информации в дискретном сообщении. Синтаксические меры оценки количества информации Алгоритмический подход к оценке количества информации

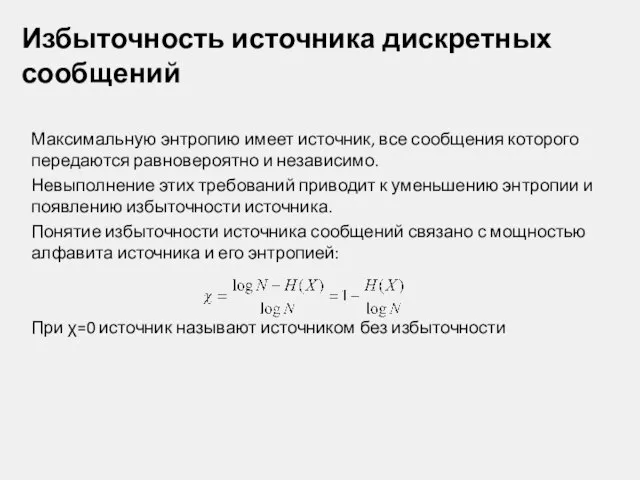

- 10. Избыточность источника дискретных сообщений Максимальную энтропию имеет источник, все сообщения которого передаются равновероятно и независимо. Невыполнение

- 11. Количественные информационные оценки дискретных источников с памятью Источник сообщения обладает памятью, если между элементами сообщения одного

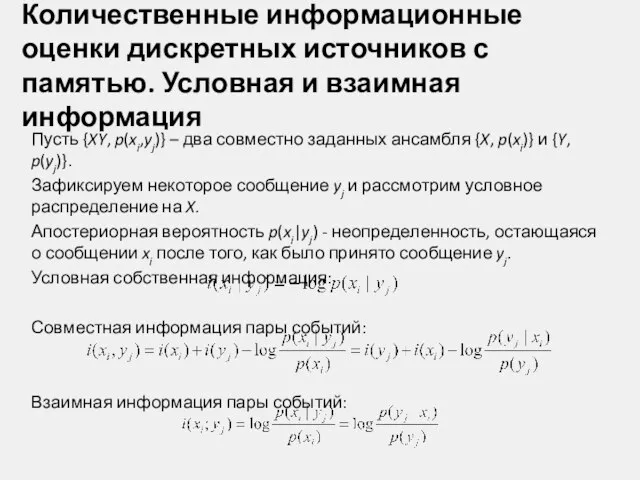

- 12. Количественные информационные оценки дискретных источников с памятью. Условная и взаимная информация Пусть {XY, p(xi,yj)} – два

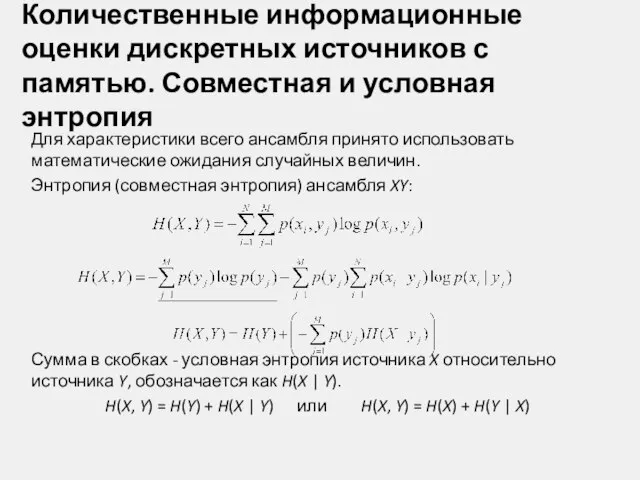

- 13. Количественные информационные оценки дискретных источников с памятью. Совместная и условная энтропия Для характеристики всего ансамбля принято

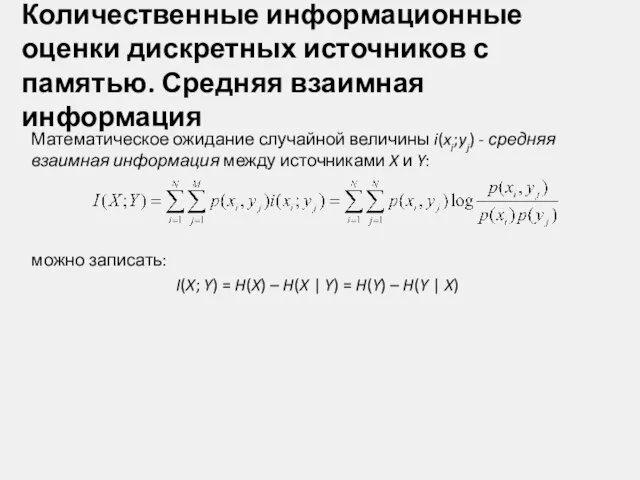

- 14. Количественные информационные оценки дискретных источников с памятью. Средняя взаимная информация Математическое ожидание случайной величины i(xi;yj) -

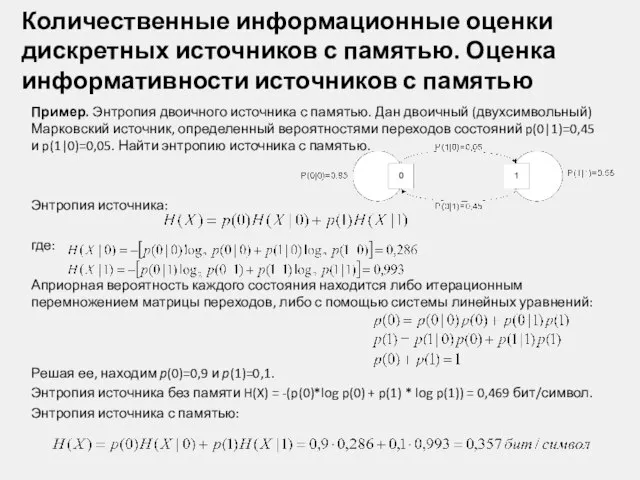

- 15. Количественные информационные оценки дискретных источников с памятью. Оценка информативности источников с памятью Пример. Энтропия двоичного источника

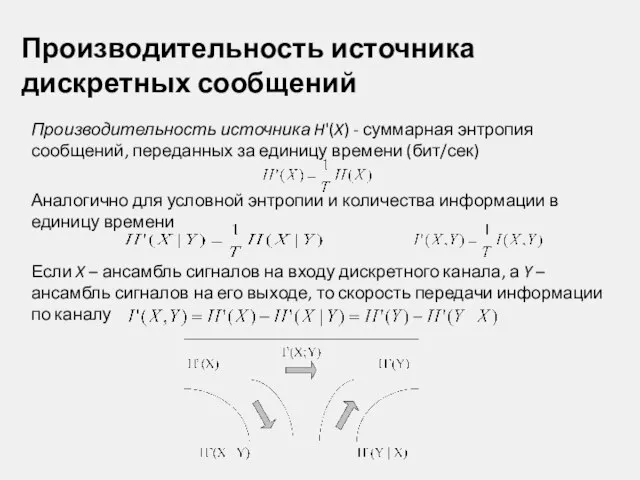

- 16. Производительность источника дискретных сообщений Производительность источника H'(X) - суммарная энтропия сообщений, переданных за единицу времени (бит/сек)

- 18. Скачать презентацию

Компьютерные системы компании Noldus: Observer XT FaceReader

Компьютерные системы компании Noldus: Observer XT FaceReader Создание чат - бота в мессенджере Телеграмм

Создание чат - бота в мессенджере Телеграмм Язык запросов к реляционным базам данных

Язык запросов к реляционным базам данных Возможности текстового процессора WORD

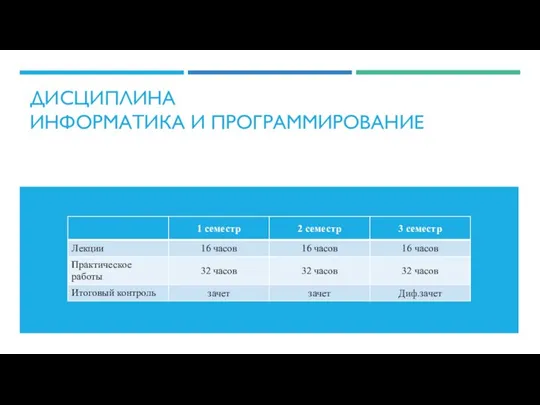

Возможности текстового процессора WORD Информатика и программирование

Информатика и программирование Antivirus 441. Преимущества

Antivirus 441. Преимущества Cmpe 466 computer graphics. 2d geometric transformations. (Chapter 7)

Cmpe 466 computer graphics. 2d geometric transformations. (Chapter 7) Стандартные и служебные приложения Windows

Стандартные и служебные приложения Windows ВКР: Разработка приложения 3D Модель Солнечной системы

ВКР: Разработка приложения 3D Модель Солнечной системы Презентация "Операционная система MS-DOS" - скачать презентации по Информатике

Презентация "Операционная система MS-DOS" - скачать презентации по Информатике Monitory

Monitory مروی بر فضای شبکه های ماهواره ای

مروی بر فضای شبکه های ماهواره ای Зрительные иллюзии. Оптические обманы

Зрительные иллюзии. Оптические обманы Анализ программ для сканирования

Анализ программ для сканирования Аттестационная работа. Использование и роль Интернета в образовательном пространстве школы

Аттестационная работа. Использование и роль Интернета в образовательном пространстве школы Pascal ABC Модуль GraphABC

Pascal ABC Модуль GraphABC Безопасность в интернете Выполнила учитель информатики и ИКТ Стасева М.С.

Безопасность в интернете Выполнила учитель информатики и ИКТ Стасева М.С. Продвижение деструктивных форм поведения в социальных сетях через родительскую общественность и профессиональные сообщества

Продвижение деструктивных форм поведения в социальных сетях через родительскую общественность и профессиональные сообщества Компьютер – универсальная машина для работы с информацией. Ввод информации в память компьютера

Компьютер – универсальная машина для работы с информацией. Ввод информации в память компьютера Магистрально-модульный принцип построения компьютера

Магистрально-модульный принцип построения компьютера Презентация по информатике История вычислительной техники – Суперкомпьютеры

Презентация по информатике История вычислительной техники – Суперкомпьютеры  Развитие средств связи С древнейших времен и до наших дней

Развитие средств связи С древнейших времен и до наших дней Очистка изображений от импульсного шума с использованием медианной фильтрации

Очистка изображений от импульсного шума с использованием медианной фильтрации Алгоритм - модель деятельности

Алгоритм - модель деятельности Инфологическое проектирование на основе принципов нормализации

Инфологическое проектирование на основе принципов нормализации Сортировка в массивах

Сортировка в массивах База даних Access. Загальна характеристика програми

База даних Access. Загальна характеристика програми Мәліметтер қоры

Мәліметтер қоры