Содержание

- 2. ОСНОВНЫЕ ТЕМЫ ЛЕКЦИИ КОЛИЧЕСТВЕННАЯ ОЦЕНКА ИНФОР-МАЦИИ ЭНТРОПИЯ СЛОЖНЫХ СООБЩЕНИЙ

- 3. КОЛИЧЕСТВЕННАЯ ОЦЕНКА ИНФОРМАЦИИ Всякая информация получается потребителем после принятия сообщения, т.е. в результате опыта. Сообщение, получаемое

- 4. Пусть опыт имеет два исхода Х1 и Х2 с вероятно-стями Р(Х1) и Р(Х2). Например, результат контроля

- 5. В общем случае источник может передавать "n" независимых и несовместимых сообщений Х1, Х2,... Хn , с

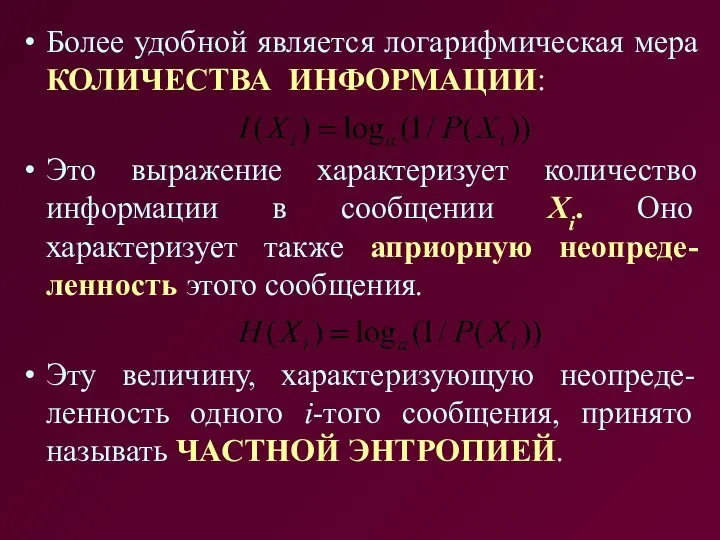

- 6. Более удобной является логарифмическая мера КОЛИЧЕСТВА ИНФОРМАЦИИ: Это выражение характеризует количество информации в сообщении Xi. Оно

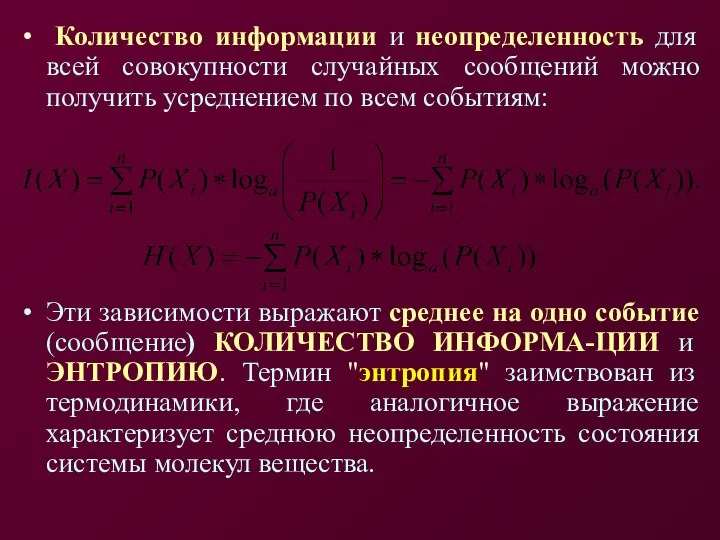

- 7. Количество информации и неопределенность для всей совокупности случайных сообщений можно получить усреднением по всем событиям: Эти

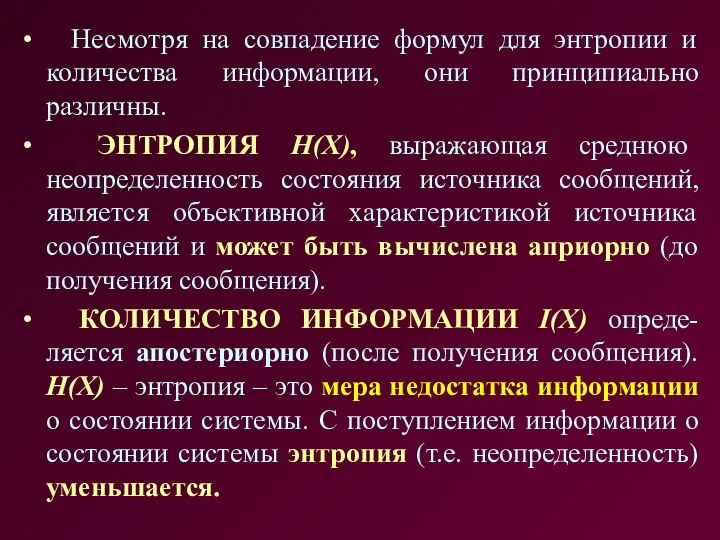

- 8. Несмотря на совпадение формул для энтропии и количества информации, они принципиально различны. ЭНТРОПИЯ H(X), выражающая среднюю

- 9. Количество получаемой информации I(X) равно численно энтропии Н(Х), которая имела место относительно источника сообщения до передачи

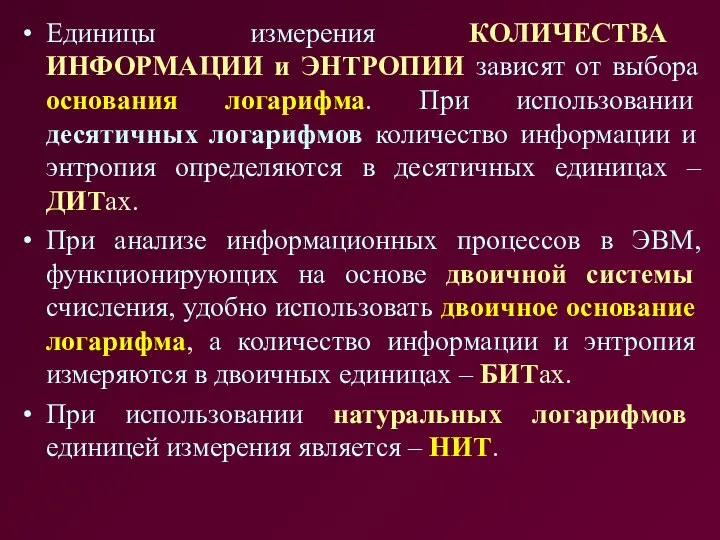

- 10. Единицы измерения КОЛИЧЕСТВА ИНФОРМАЦИИ и ЭНТРОПИИ зависят от выбора основания логарифма. При использовании десятичных логарифмов количество

- 11. СВОЙСТВА ЭНТРОПИИ ДИСКРЕТНЫХ СООБЩЕНИЙ ⮚ Энтропия есть величина вещественная, неотрицательная и ограниченная (если учесть, что: 0

- 12. ЭНТРОПИЯ СЛОЖНЫХ СООБЩЕНИЙ Реально наблюдаемые случайные процессы могут быть НЕЗАВИСИМЫМИ или ВЗАИМОСВЯ-ЗАННЫМИ. Например, бросание игральной кости

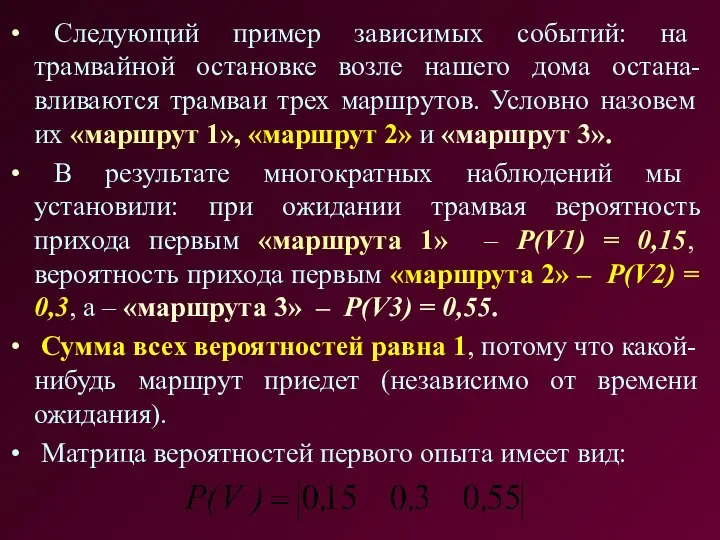

- 13. Следующий пример зависимых событий: на трамвайной остановке возле нашего дома остана-вливаются трамваи трех маршрутов. Условно назовем

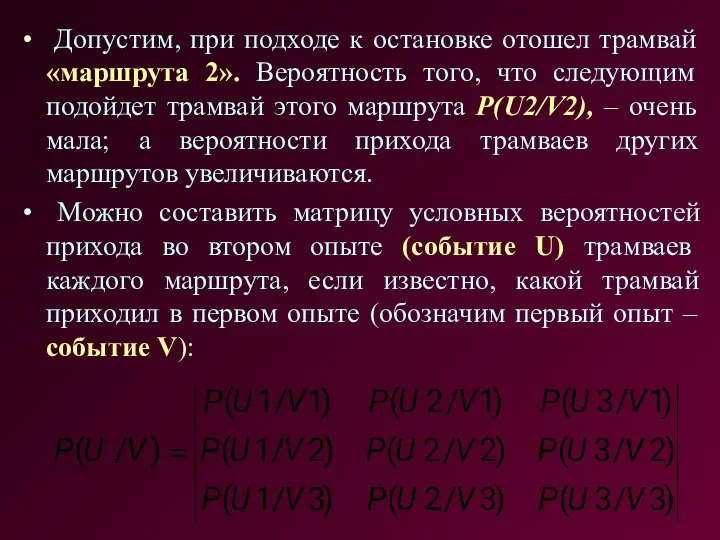

- 14. Допустим, при подходе к остановке отошел трамвай «маршрута 2». Вероятность того, что следующим подойдет трамвай этого

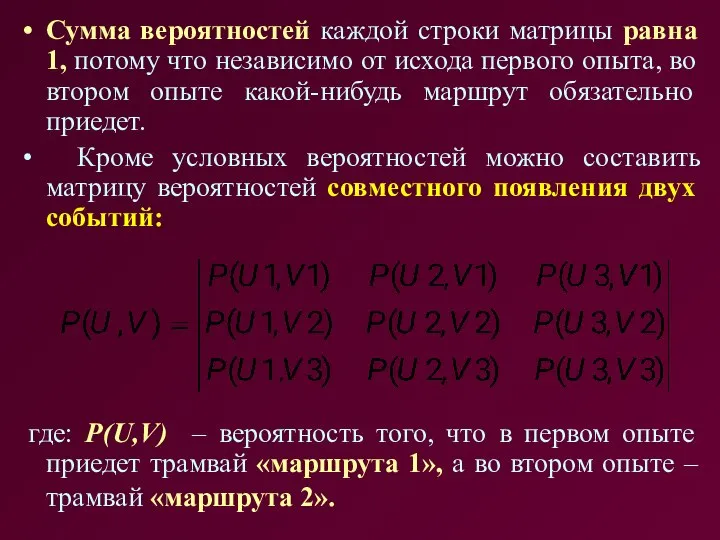

- 15. Сумма вероятностей каждой строки матрицы равна 1, потому что независимо от исхода первого опыта, во втором

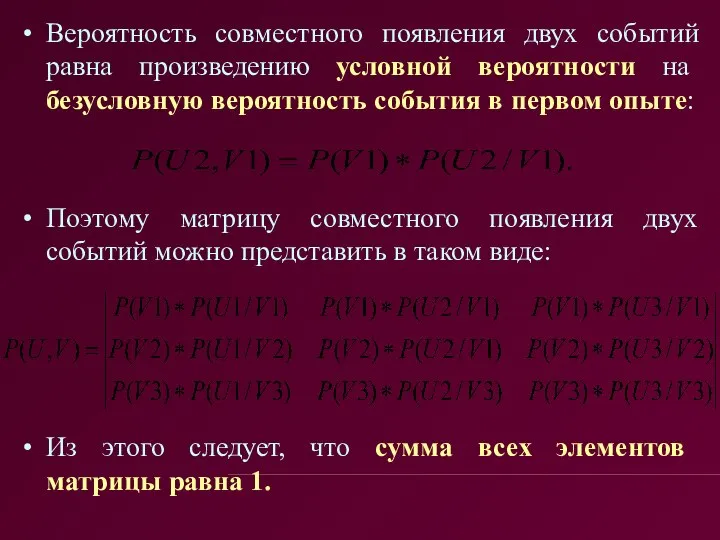

- 16. Вероятность совместного появления двух событий равна произведению условной вероятности на безусловную вероятность события в первом опыте:

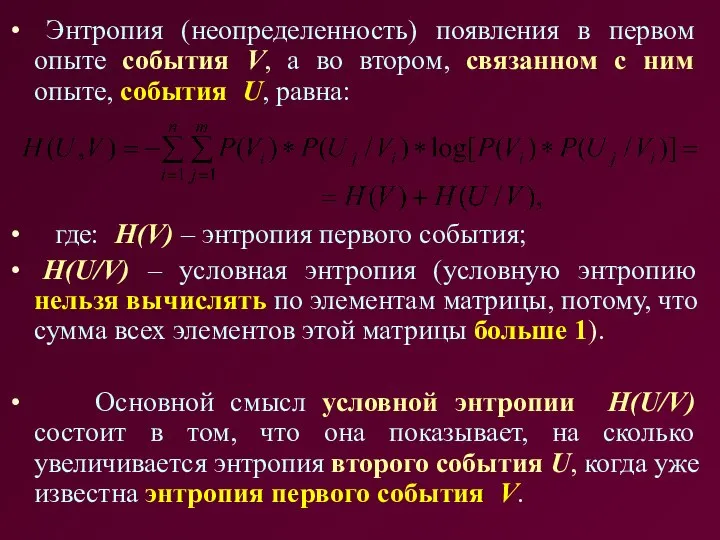

- 17. Энтропия (неопределенность) появления в первом опыте события V, а во втором, связанном с ним опыте, события

- 18. СВОЙСТВА ЭНТРОПИИ СЛОЖНЫХ СООБЩЕНИЙ ⮚ При статистически независимых сообщениях U и V совместная энтропия равна сумме

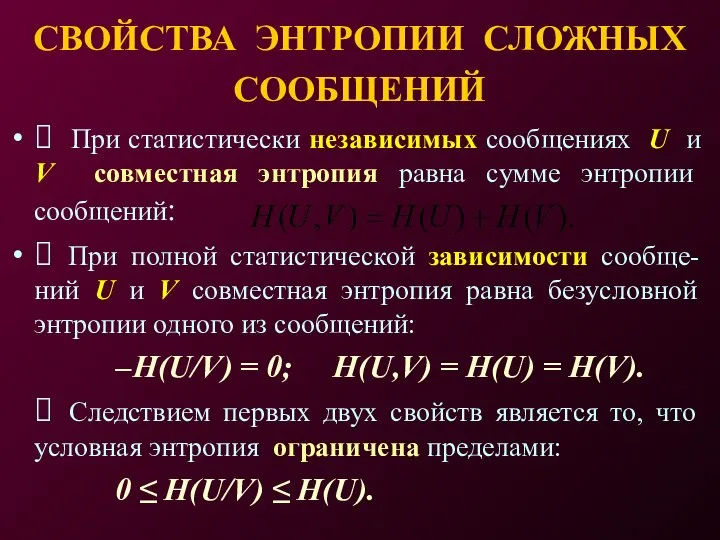

- 19. Вопросы для экспресс-контроля 1. В чем различие и сходство терминов КОЛИ-ЧЕСТВО ИНФОРМАЦИИ и ЭНТРОПИЯ? 2. Единицы

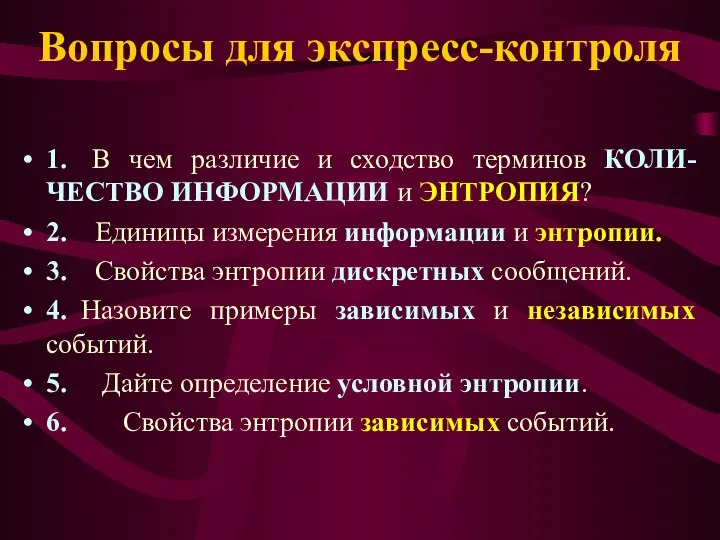

- 21. Скачать презентацию

Монтаж, наладка и эксплуатация электрооборудования учебных мастерских

Монтаж, наладка и эксплуатация электрооборудования учебных мастерских Могилёвский областной художественный музей имени Масленникова

Могилёвский областной художественный музей имени Масленникова Доказательства и доказывание в уголовном судопроизводстве

Доказательства и доказывание в уголовном судопроизводстве  Managing Change. What is organisational change?

Managing Change. What is organisational change? Прокурорская этика Выполнила: Студенка 1 курса Группа ЮБ1302 Житкова Арина

Прокурорская этика Выполнила: Студенка 1 курса Группа ЮБ1302 Житкова Арина IT образование для школьников

IT образование для школьников Проблеми світового туризму

Проблеми світового туризму Орган слуха и равновесия

Орган слуха и равновесия  Патофизиология белой крови

Патофизиология белой крови Способы построения разверток гранных поверхностей

Способы построения разверток гранных поверхностей Презентация на тему "Классные часы в школе" - скачать презентации по Педагогике

Презентация на тему "Классные часы в школе" - скачать презентации по Педагогике Культура Иудаизма

Культура Иудаизма Виды и уровни менеджмента Выполнила: Дуденкова Светлана Группа «СКС»

Виды и уровни менеджмента Выполнила: Дуденкова Светлана Группа «СКС» Основные понятия физической культуры и ее структурные компоненты

Основные понятия физической культуры и ее структурные компоненты Қасым Аманжолов — (1911-1955)

Қасым Аманжолов — (1911-1955) Черная металлургия Значение черной металлургии Технологические стадии при производстве черных металлов Добыча и запасы железн

Черная металлургия Значение черной металлургии Технологические стадии при производстве черных металлов Добыча и запасы железн Притча – источник народной мудрости

Притча – источник народной мудрости Химия элементов р-элементы-2

Химия элементов р-элементы-2  Условия включения в реестр владельцев склада временного хранения Подготовила студентка группы 1403 Хорькова Юлия

Условия включения в реестр владельцев склада временного хранения Подготовила студентка группы 1403 Хорькова Юлия  Нечеткие множества

Нечеткие множества  Установка EEPROM SRC в платы наружных блоков инверторных кондиционеров с помощью SnetPro и I-converter (SRSC)

Установка EEPROM SRC в платы наружных блоков инверторных кондиционеров с помощью SnetPro и I-converter (SRSC) Строительство жилого трехэтажного кирпичного дома

Строительство жилого трехэтажного кирпичного дома Зона психологической разгрузки

Зона психологической разгрузки Достопримечательности Лондона

Достопримечательности Лондона Split of Sudan

Split of Sudan Примеры экономических задач линейного программирования

Примеры экономических задач линейного программирования Внутренняя политика России в 1894-1904 гг

Внутренняя политика России в 1894-1904 гг Тема урока: Жизнь египетского вельможи План урока: В усадьбе вельможи Служба вельмож Вельможа при дворе фараона

Тема урока: Жизнь египетского вельможи План урока: В усадьбе вельможи Служба вельмож Вельможа при дворе фараона