Содержание

- 2. Введение Message Passing Interface (MPI, интерфейс передачи сообщений) — программный интерфейс (API) для передачи информации, который

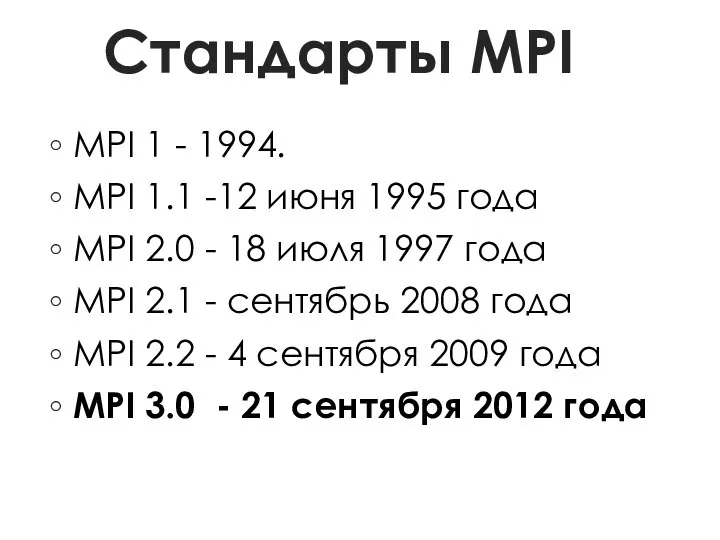

- 3. Стандарты MPI MPI 1 - 1994. MPI 1.1 -12 июня 1995 года MPI 2.0 - 18

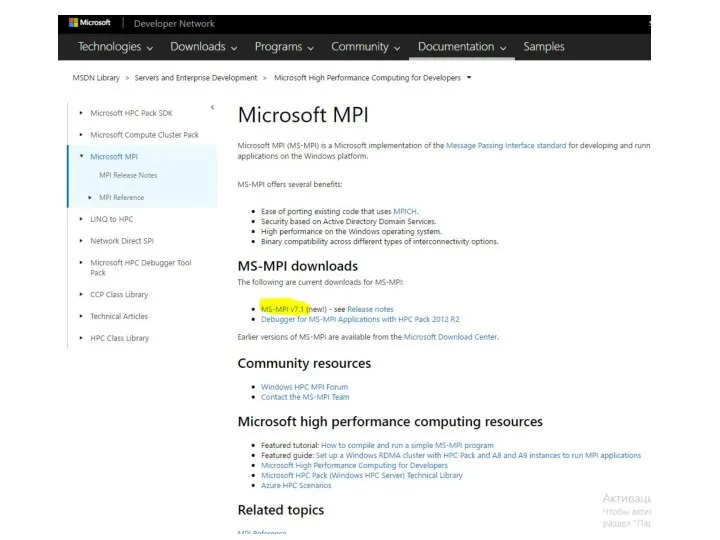

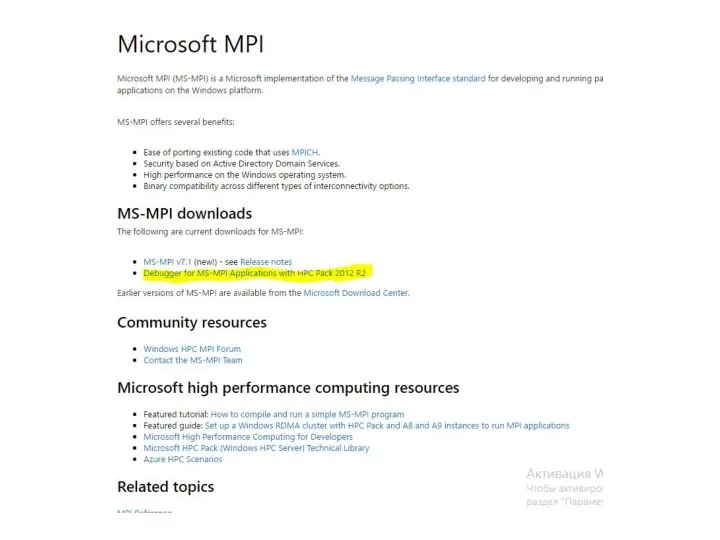

- 4. Реализации MPI MPICH — одна из самых распространенных реализация MPI, работает на UNIX и Windows-системах Open

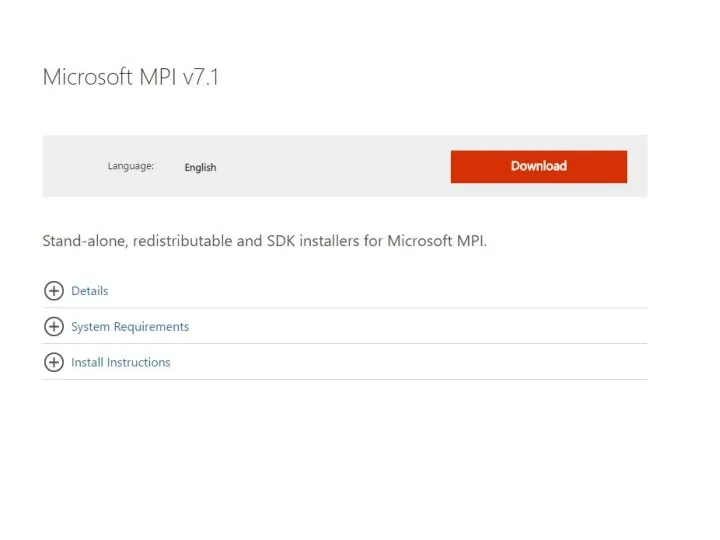

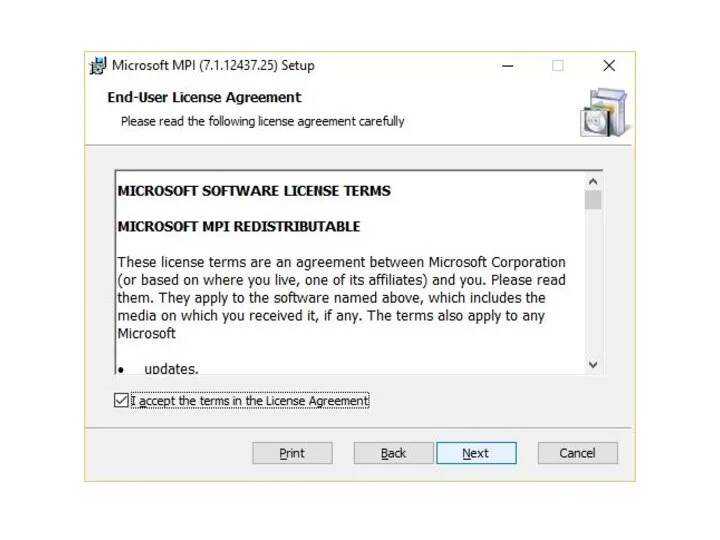

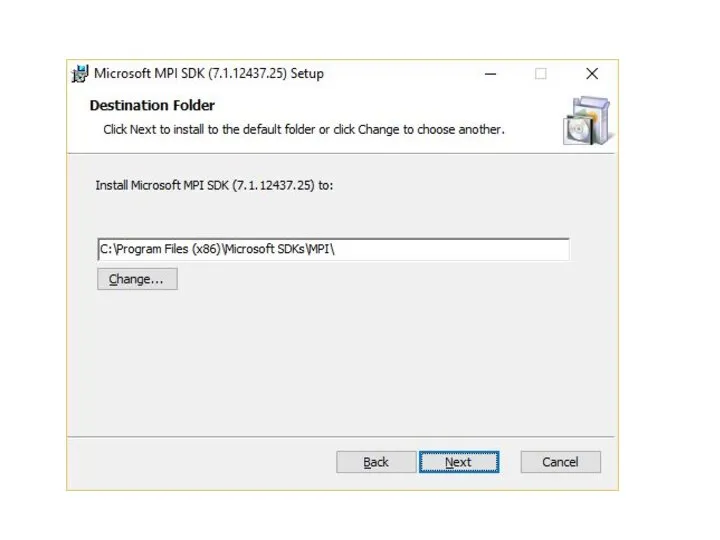

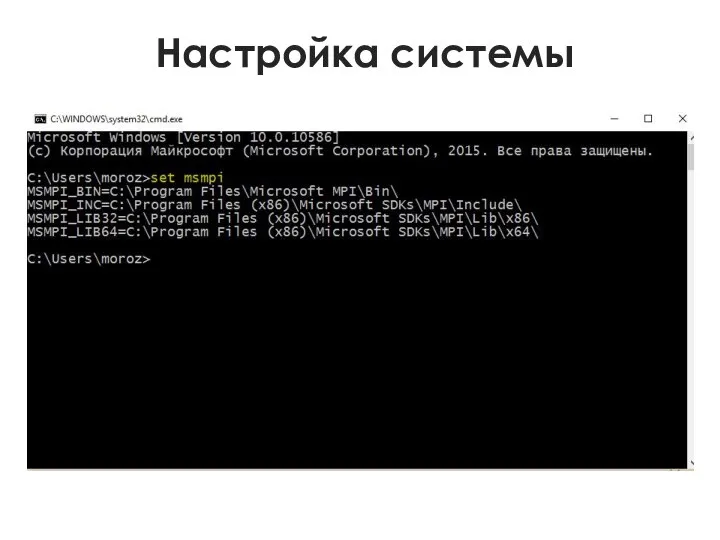

- 11. Настройка системы

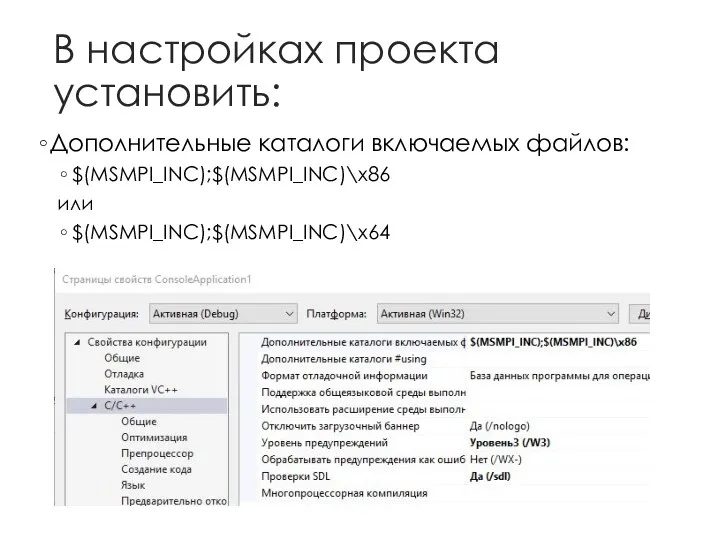

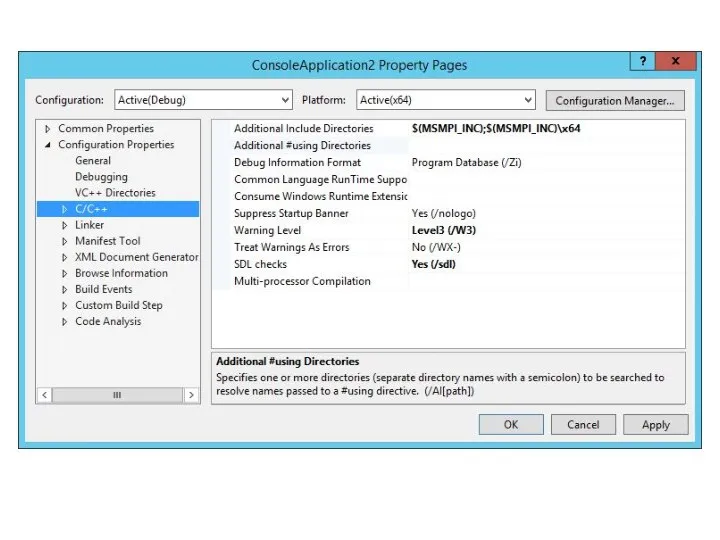

- 12. В настройках проекта установить: Дополнительные каталоги включаемых файлов: $(MSMPI_INC);$(MSMPI_INC)\x86 или $(MSMPI_INC);$(MSMPI_INC)\x64

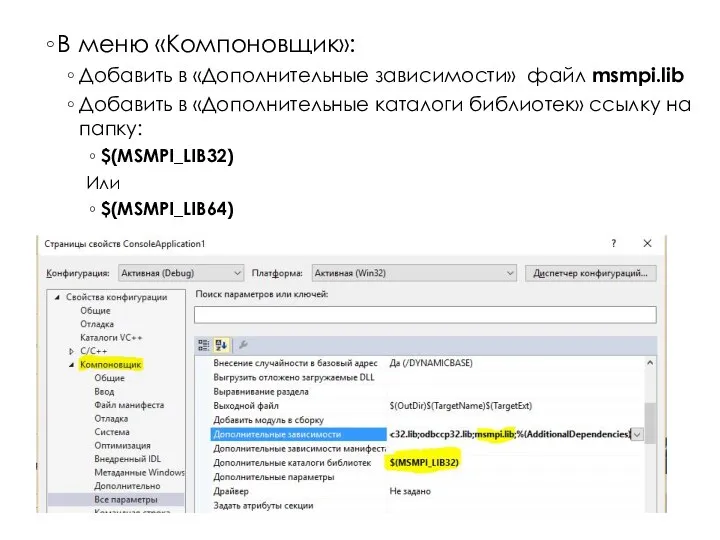

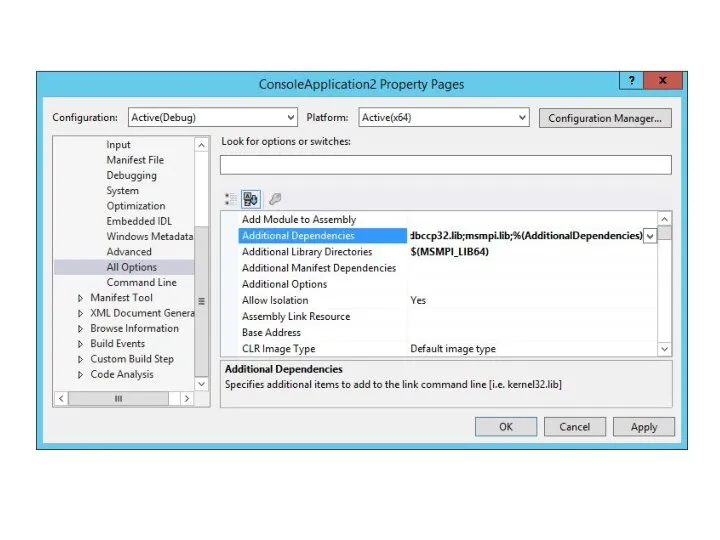

- 14. В меню «Компоновщик»: Добавить в «Дополнительные зависимости» файл msmpi.lib Добавить в «Дополнительные каталоги библиотек» ссылку на

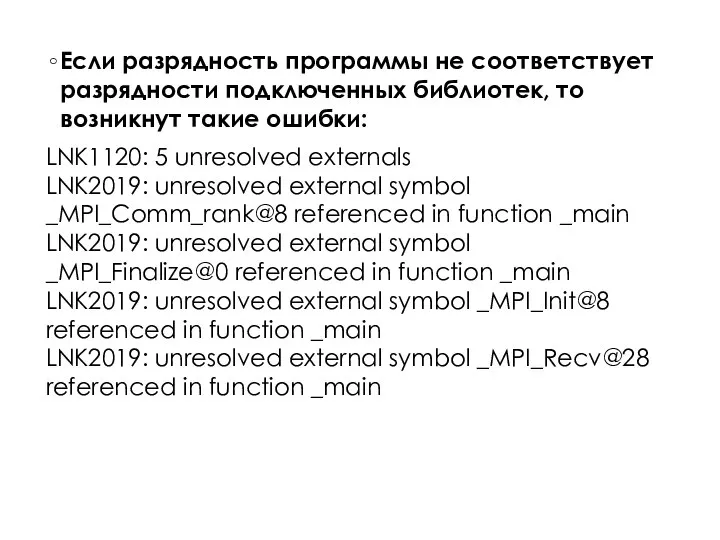

- 16. Если разрядность программы не соответствует разрядности подключенных библиотек, то возникнут такие ошибки: LNK1120: 5 unresolved externals

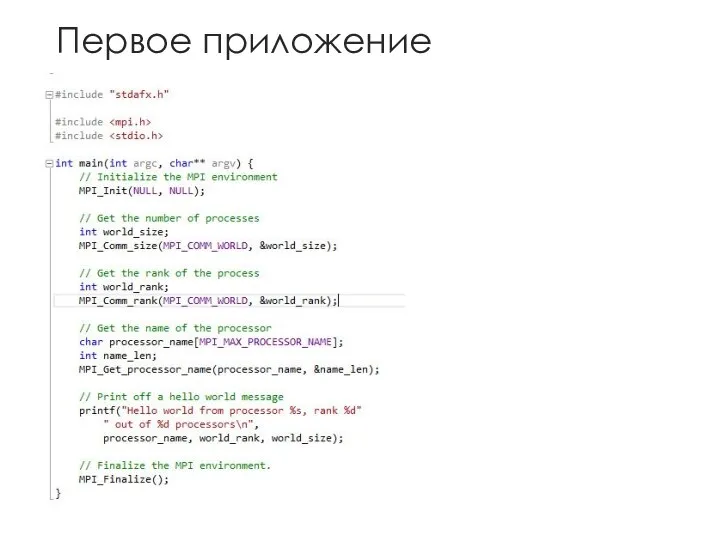

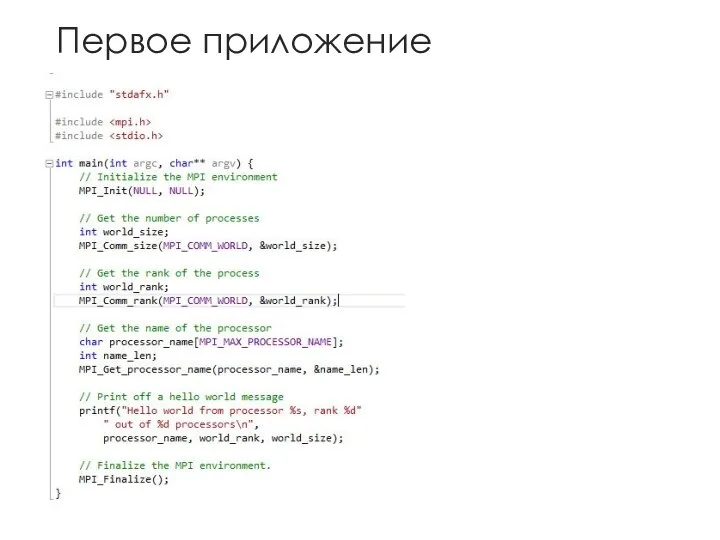

- 17. Первое приложение

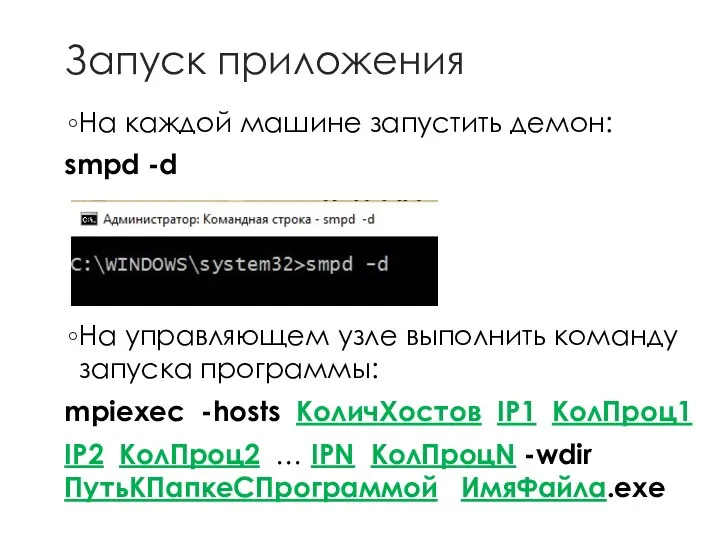

- 18. Запуск приложения На каждой машине запустить демон: smpd -d На управляющем узле выполнить команду запуска программы:

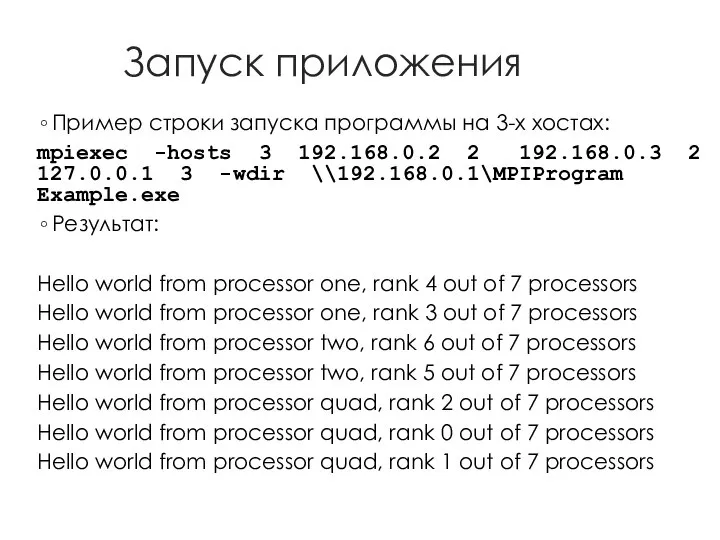

- 19. Запуск приложения Пример строки запуска программы на 3-х хостах: mpiexec -hosts 3 192.168.0.2 2 192.168.0.3 2

- 20. Общая схема работы MPICH на кластере

- 21. Первое приложение

- 22. Константы

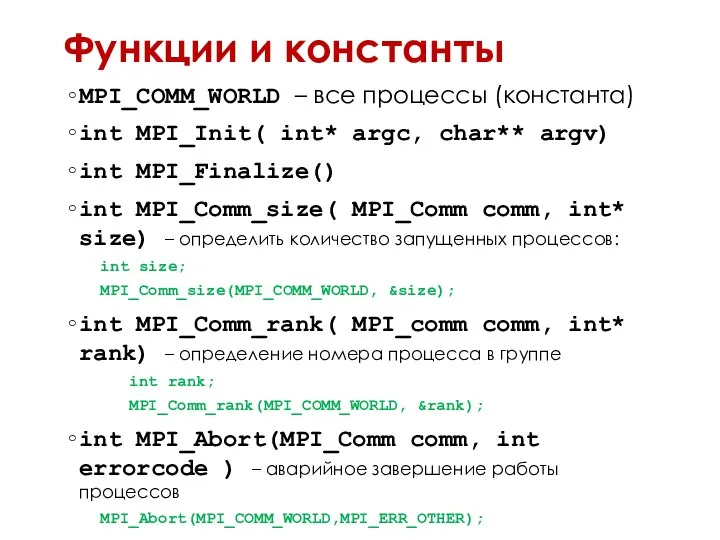

- 23. Функции и константы MPI_COMM_WORLD – все процессы (константа) int MPI_Init( int* argc, char** argv) int MPI_Finalize()

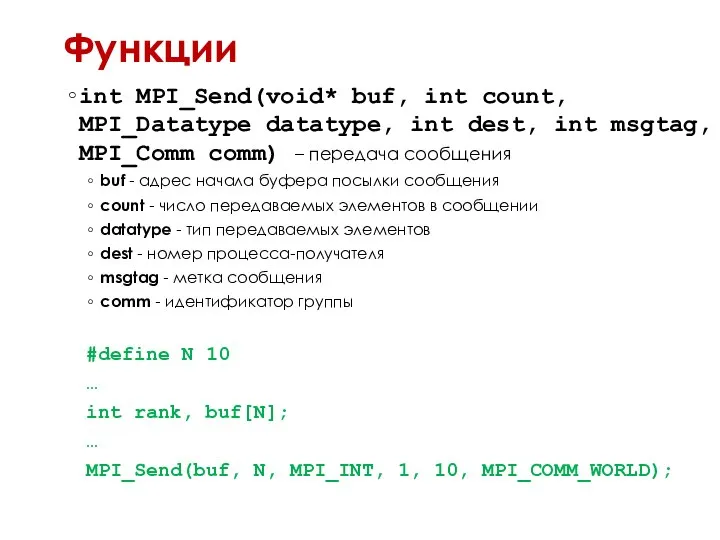

- 24. Функции int MPI_Send(void* buf, int count, MPI_Datatype datatype, int dest, int msgtag, MPI_Comm comm) – передача

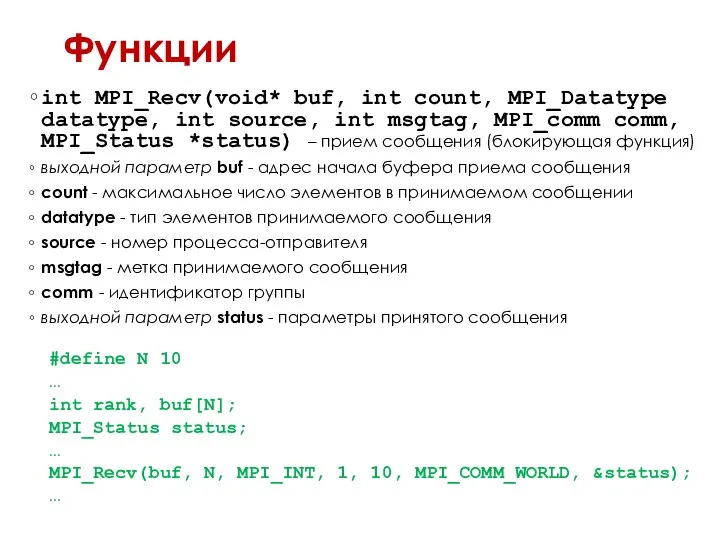

- 25. Функции int MPI_Recv(void* buf, int count, MPI_Datatype datatype, int source, int msgtag, MPI_comm comm, MPI_Status *status)

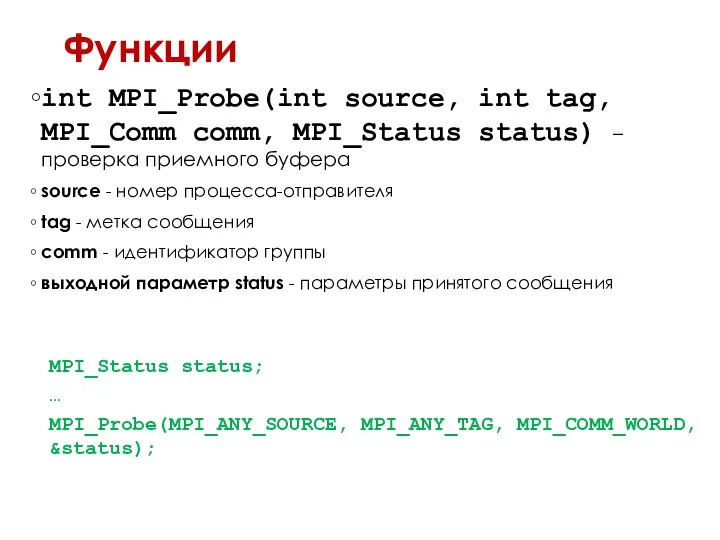

- 26. Функции int MPI_Probe(int source, int tag, MPI_Comm comm, MPI_Status status) – проверка приемного буфера source -

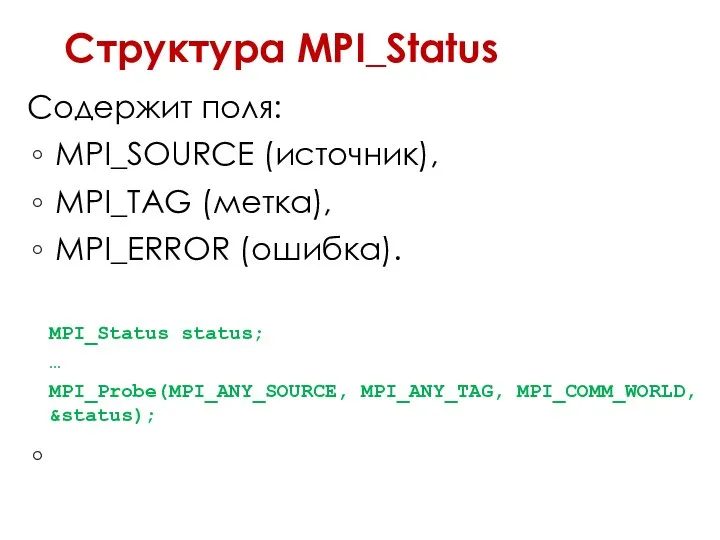

- 27. Структура MPI_Status Содержит поля: MPI_SOURCE (источник), MPI_TAG (метка), MPI_ERROR (ошибка). MPI_Status status; … MPI_Probe(MPI_ANY_SOURCE, MPI_ANY_TAG, MPI_COMM_WORLD,

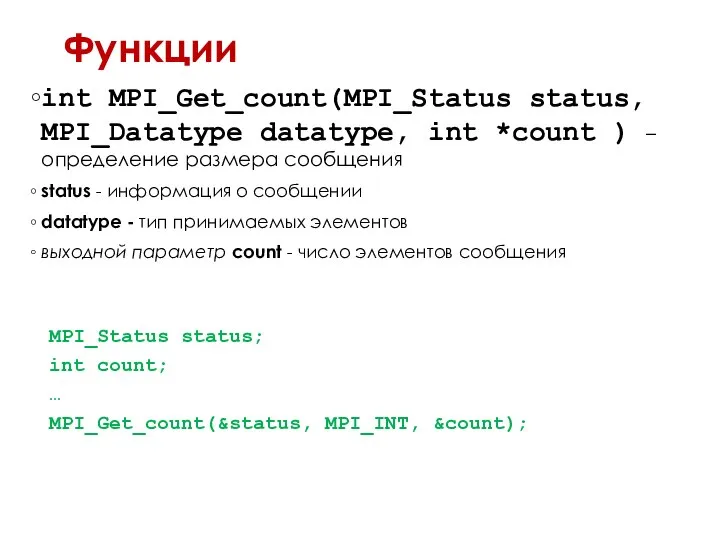

- 28. Функции int MPI_Get_count(MPI_Status status, MPI_Datatype datatype, int *count ) – определение размера сообщения status - информация

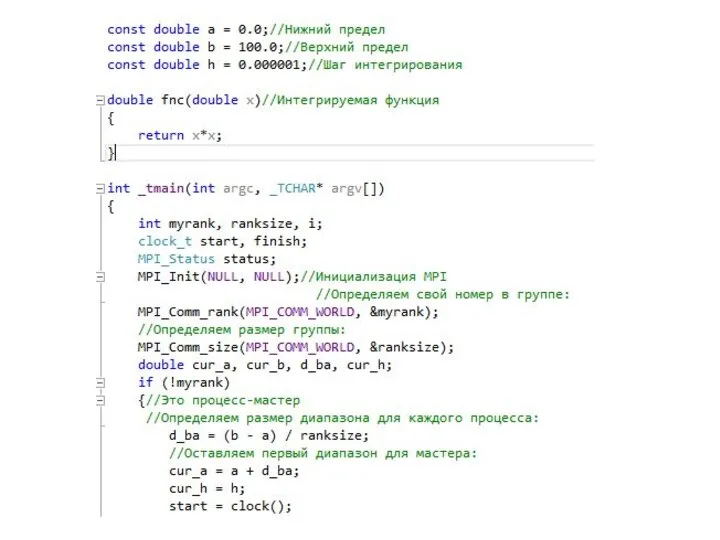

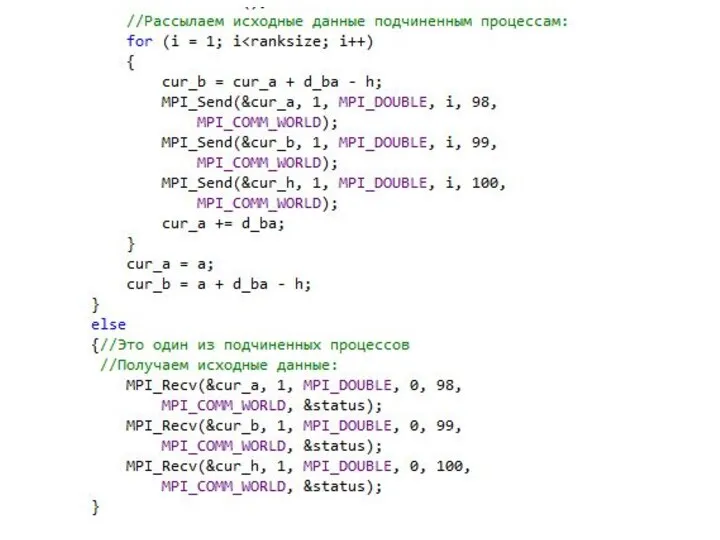

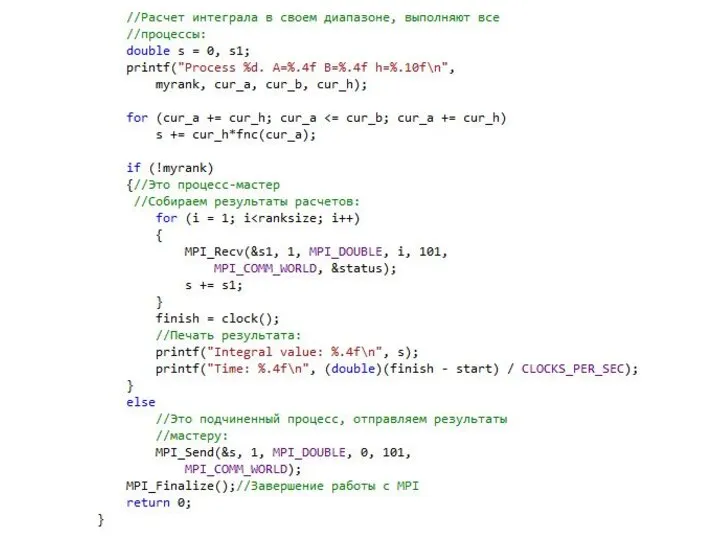

- 29. Простой пример 1

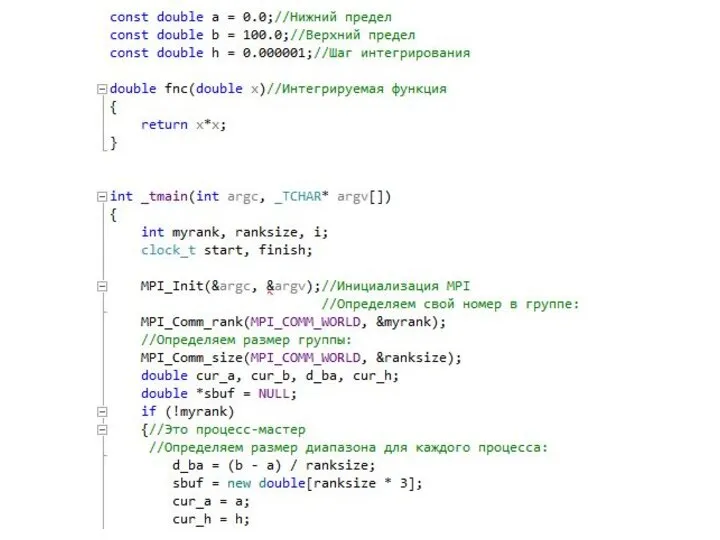

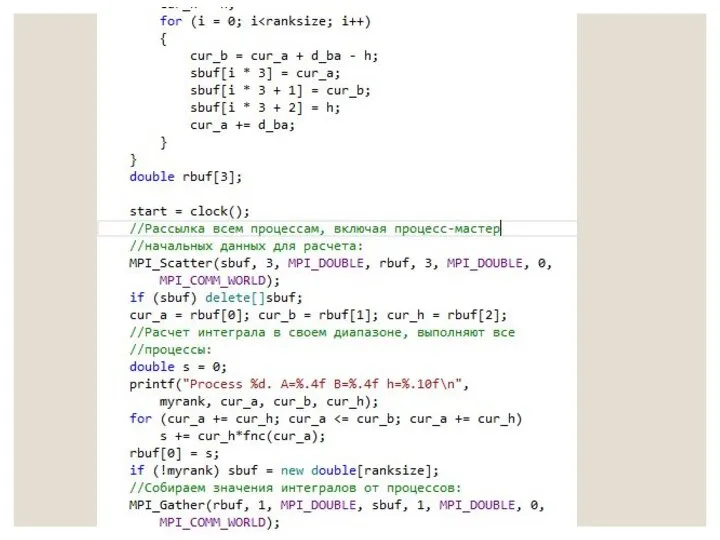

- 33. Простой пример 2

- 37. Скачать презентацию

Теневая экономика в современных условиях. Выполнила: Учащаяся экономического факультета Гринева Наталия группы Э091

Теневая экономика в современных условиях. Выполнила: Учащаяся экономического факультета Гринева Наталия группы Э091 Мехатронные системы в различных сферах производственной деятельности

Мехатронные системы в различных сферах производственной деятельности Методология исследований в менеджменте и маркетинге

Методология исследований в менеджменте и маркетинге Презентация "Теория спроса и предложения. Равновесие на рынке" - скачать презентации по Экономике

Презентация "Теория спроса и предложения. Равновесие на рынке" - скачать презентации по Экономике Молодежное открытое правительство

Молодежное открытое правительство 79842

79842 Мотивация учения и ее формирование у учащихся начальной школы. ДЕНИСОВА В.А.

Мотивация учения и ее формирование у учащихся начальной школы. ДЕНИСОВА В.А.  Башкиры. Народы Поволжья

Башкиры. Народы Поволжья Программирование на языке ассемблер

Программирование на языке ассемблер Масленица

Масленица Диагностика систем управления

Диагностика систем управления Великий Леонардо да Винчи

Великий Леонардо да Винчи Оперативный ток

Оперативный ток Проектирование здания учебно-тренажерного комплекса Саратовского подразделения Приволжского УЦПК

Проектирование здания учебно-тренажерного комплекса Саратовского подразделения Приволжского УЦПК Оценка сложности алгоритмов

Оценка сложности алгоритмов Презентация Товары к которым применяются запреты или ограничения на ввоз или вывоз

Презентация Товары к которым применяются запреты или ограничения на ввоз или вывоз Нуклеофильное замещение у винильного атома углерода

Нуклеофильное замещение у винильного атома углерода

СТУПЕНЬКИ К ШКОЛЕ ПСИХОЛОГО-ПЕДАГОГИЧЕСКАЯ ГОТОВНОСТЬ РЕБЕНКА К ШКОЛЕ

СТУПЕНЬКИ К ШКОЛЕ ПСИХОЛОГО-ПЕДАГОГИЧЕСКАЯ ГОТОВНОСТЬ РЕБЕНКА К ШКОЛЕ Новый год в Китае

Новый год в Китае Диаграмма классов UML. The Unified Modeling Language

Диаграмма классов UML. The Unified Modeling Language Организация и проведение криминологического исследования

Организация и проведение криминологического исследования Обычаи, обряды и традиции русского народа

Обычаи, обряды и традиции русского народа Есептеуіш жүйенің даму тарихы

Есептеуіш жүйенің даму тарихы Қылмыстық кодекс

Қылмыстық кодекс Вина во Франции

Вина во Франции  Мезенская роспись - презентация_

Мезенская роспись - презентация_ Презентация Основы таможенного дела

Презентация Основы таможенного дела Никола́й Ива́нович Лобаче́вский (1793-1856) - русский математик, создатель неевклидовой геометрии

Никола́й Ива́нович Лобаче́вский (1793-1856) - русский математик, создатель неевклидовой геометрии