Содержание

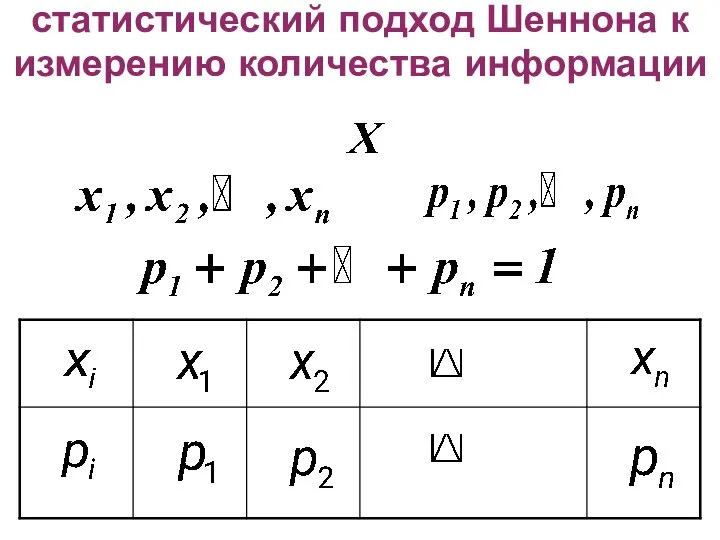

- 2. статистический подход Шеннона к измерению количества информации

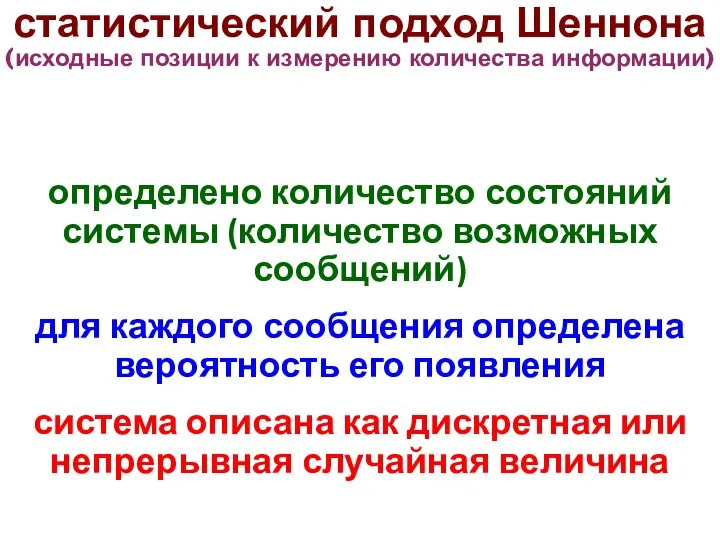

- 3. статистический подход Шеннона (исходные позиции к измерению количества информации) определено количество состояний системы (количество возможных сообщений)

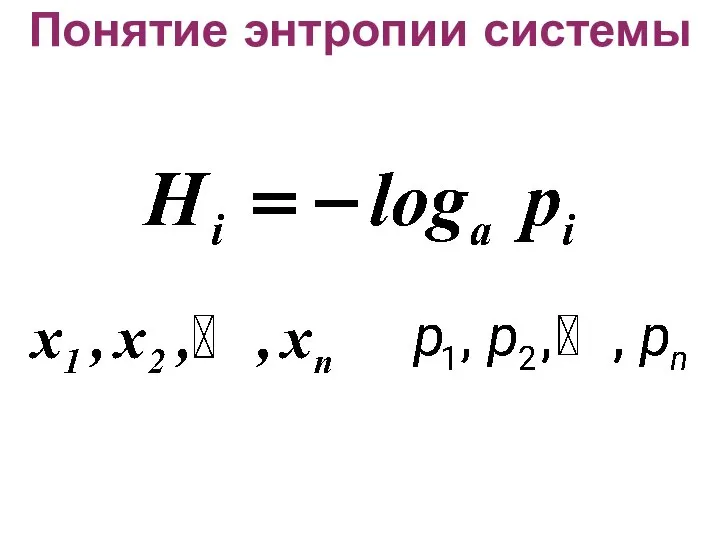

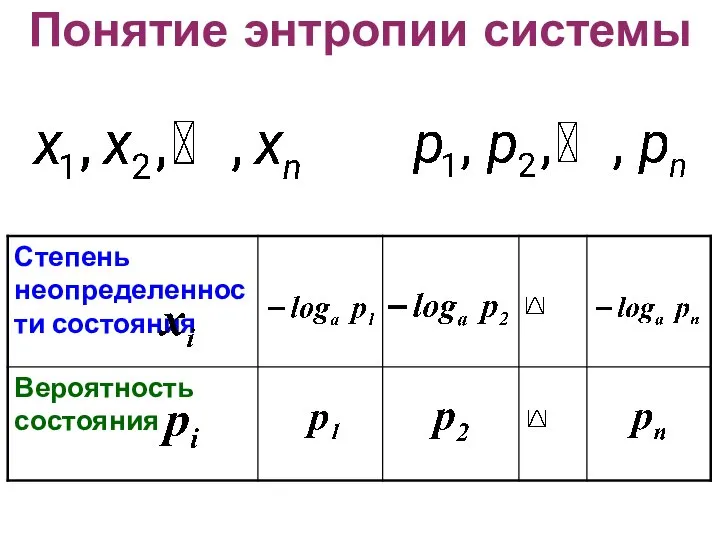

- 4. Понятие энтропии системы

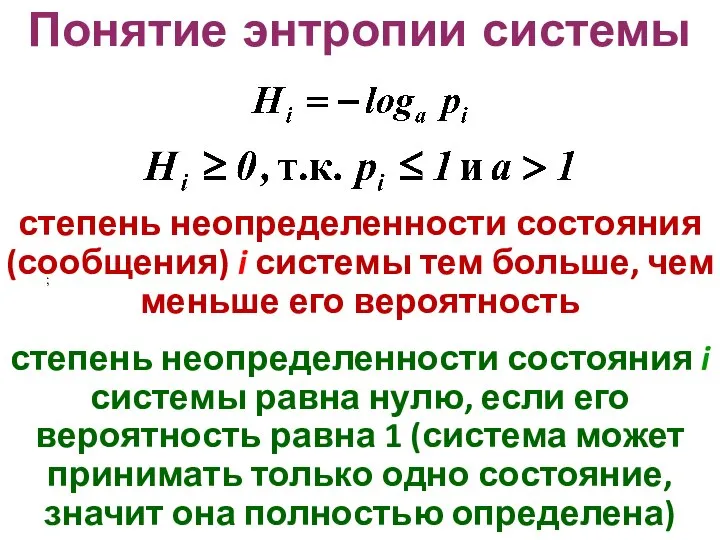

- 5. Понятие энтропии системы степень неопределенности состояния (сообщения) i системы тем больше, чем меньше его вероятность степень

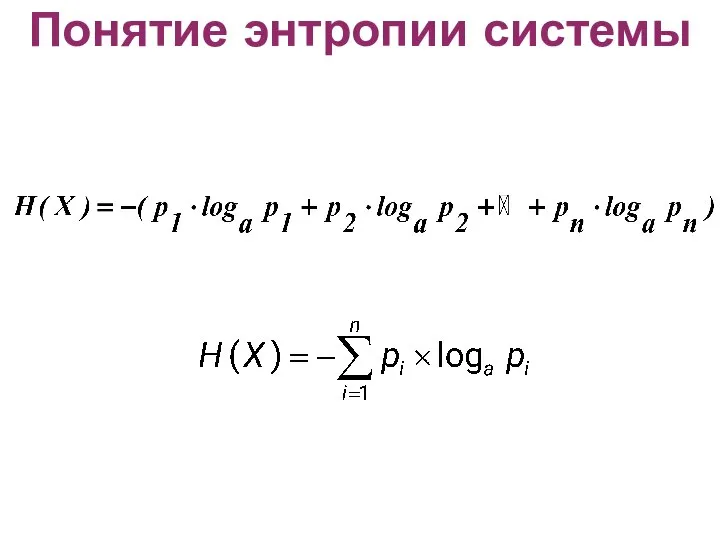

- 6. Понятие энтропии системы

- 7. Понятие энтропии системы

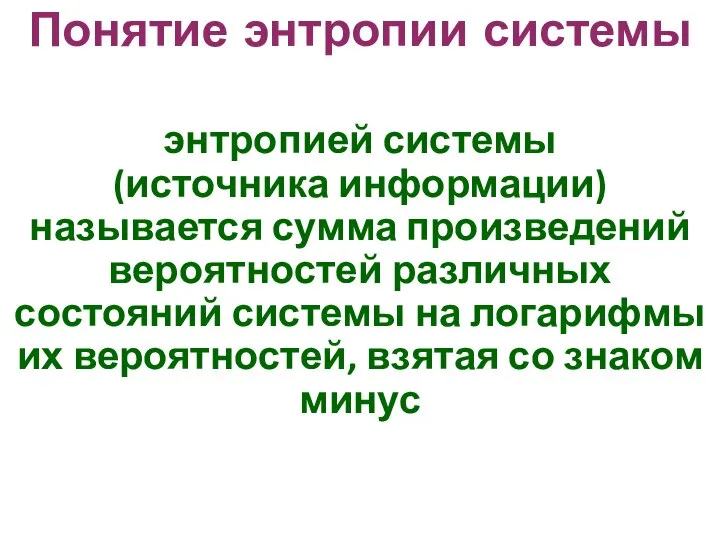

- 8. Понятие энтропии системы энтропией системы (источника информации) называется сумма произведений вероятностей различных состояний системы на логарифмы

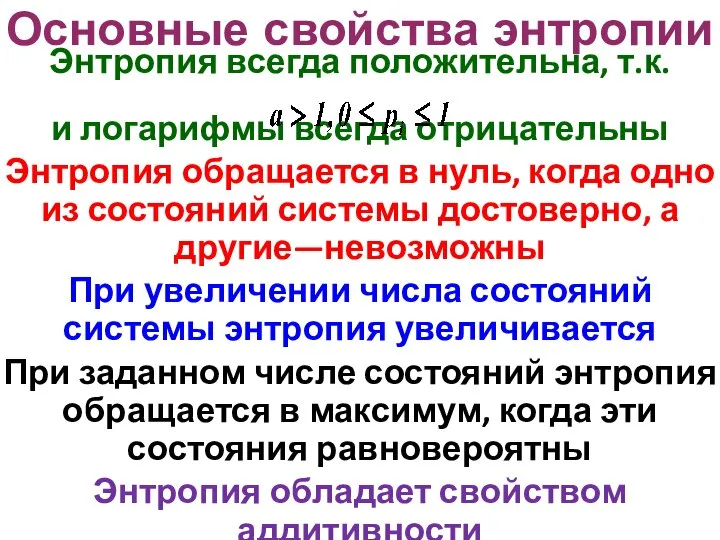

- 9. Основные свойства энтропии Энтропия всегда положительна, т.к. и логарифмы всегда отрицательны Энтропия обращается в нуль, когда

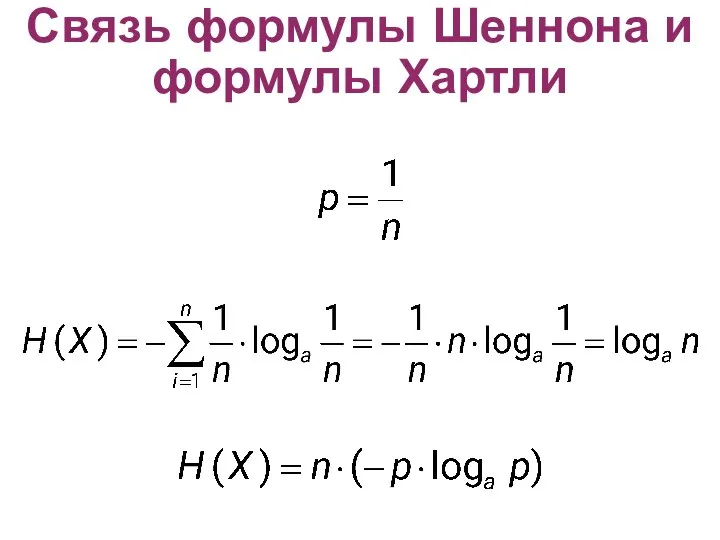

- 10. Связь формулы Шеннона и формулы Хартли

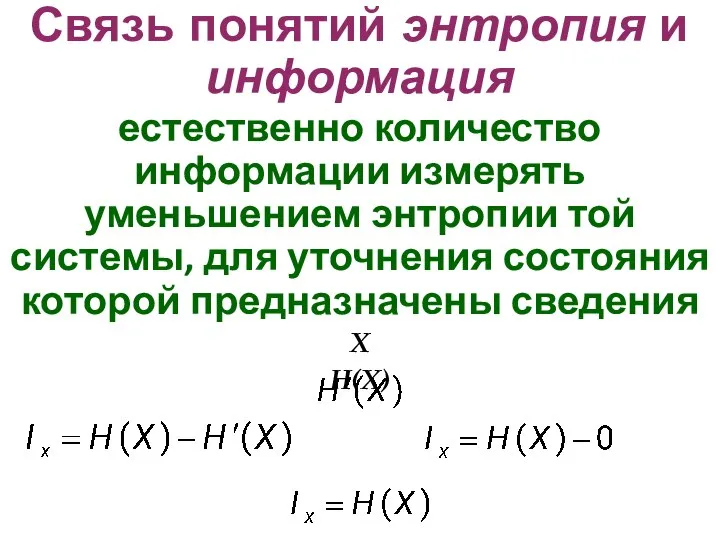

- 11. Связь понятий энтропия и информация естественно количество информации измерять уменьшением энтропии той системы, для уточнения состояния

- 12. Связь понятий энтропия и информация количество информации, приобретаемое при полном выяснении состояния некоторой системы равно энтропии

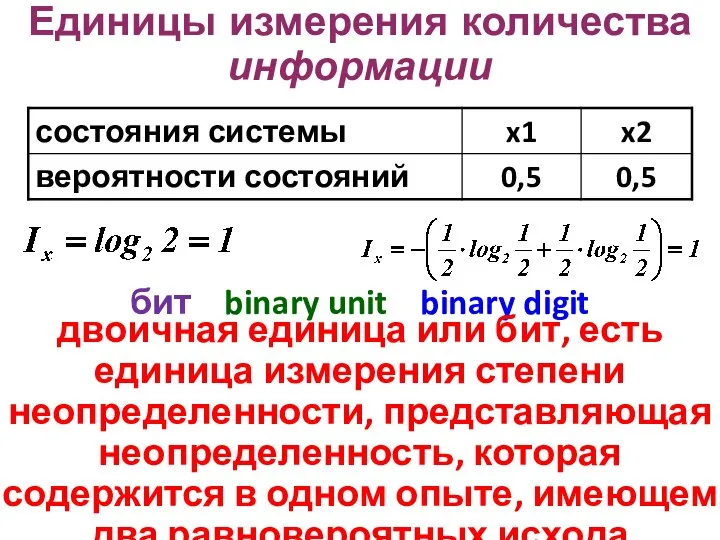

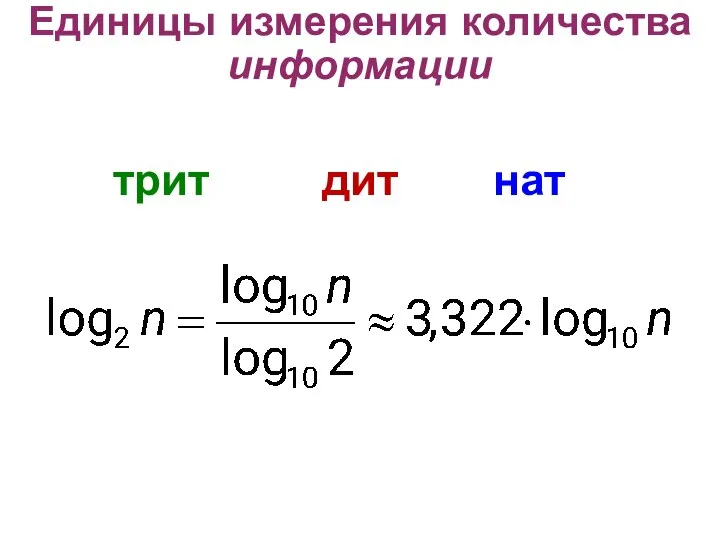

- 13. Единицы измерения количества информации бит binary unit binary digit двоичная единица или бит, есть единица измерения

- 14. Единицы измерения количества информации трит дит нат

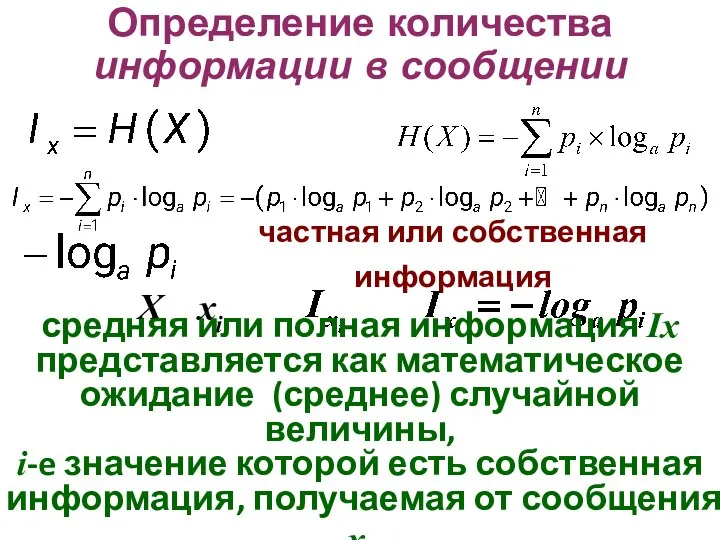

- 15. Определение количества информации в сообщении частная или собственная информация X xi средняя или полная информация Ix

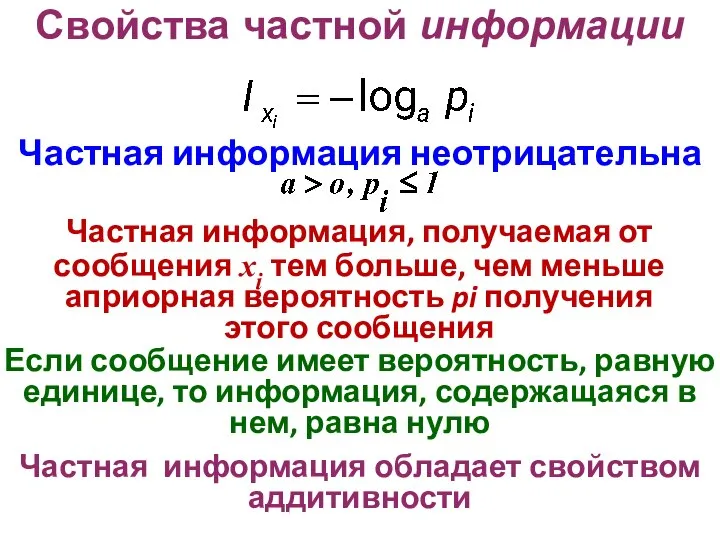

- 16. Свойства частной информации Частная информация неотрицательна Частная информация, получаемая от сообщения xi тем больше, чем меньше

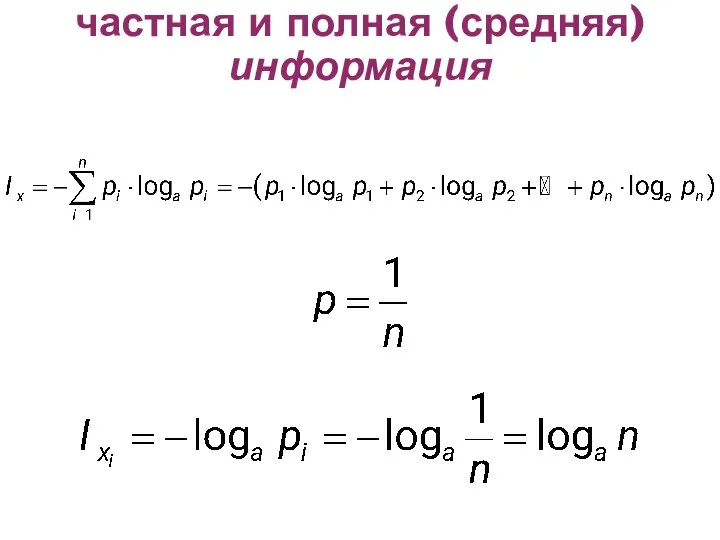

- 17. частная и полная (средняя)информация

- 18. частная и полная (средняя)информация Если все состояния системы равновероятны, то частная информация от каждого отдельного сообщения

- 19. ВОПРОС ЗАКОНЧЕН

- 20. семантический подход к измерению количества информации Тезаурусная мера Ю.А. Шрейдер Тезаурус ? Под тезаурусом (от греческого

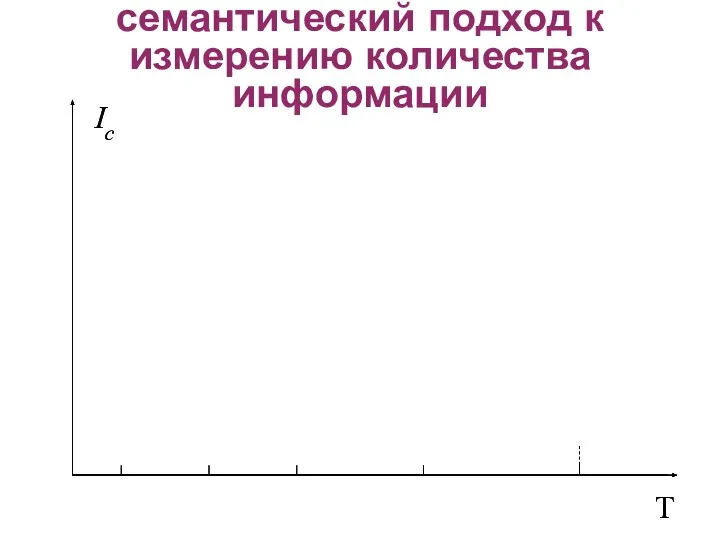

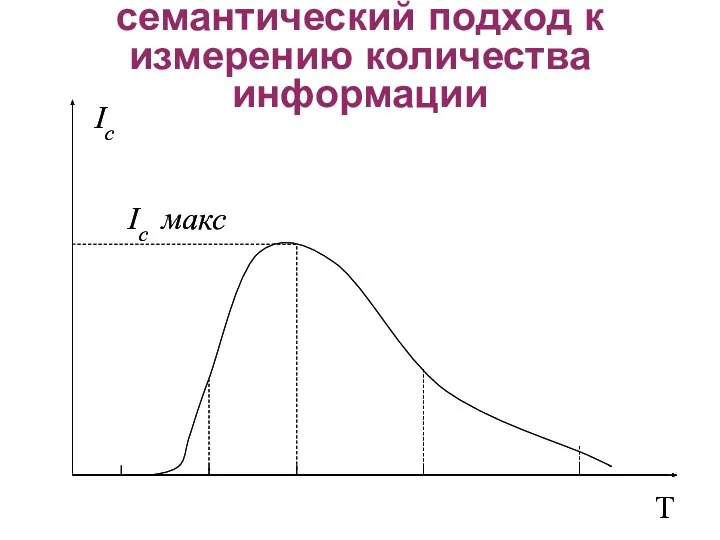

- 21. Ic T Ic T семантический подход к измерению количества информации

- 22. Ic макс Ic T Ic макс Ic T семантический подход к измерению количества информации

- 23. Р. Карнапом и Бар–Хиллелом разработан подход к определению количество семантической информации на основе изменения логической вероятности.

- 25. Скачать презентацию

косвенные налоги

косвенные налоги  Пересмотр вступивших в законную силу судебных решений

Пересмотр вступивших в законную силу судебных решений Дауыссыз дыбыстар

Дауыссыз дыбыстар Финансовая отчетность банка ВТБ Петрова Маргарита Куркина анна 3 курс фм

Финансовая отчетность банка ВТБ Петрова Маргарита Куркина анна 3 курс фм Каменные стены МКД

Каменные стены МКД Физиология заднего мозга

Физиология заднего мозга Искусство Древней Греции Афинский Акрополь

Искусство Древней Греции Афинский Акрополь Структура и типология культуры

Структура и типология культуры Ярмарка талантов. Российское движение школьников

Ярмарка талантов. Российское движение школьников Весёлые задачки - презентация для начальной школы_

Весёлые задачки - презентация для начальной школы_ Системы Счисления

Системы Счисления Описание слайда:

Модели поведения человека в институциональной экономике

Описание слайда:

Модели поведения человека в институциональной экономике Плавкие предохранители

Плавкие предохранители Семиотика и синдромология болезней крови. Геморраг. диатезы, лейкозы

Семиотика и синдромология болезней крови. Геморраг. диатезы, лейкозы Nikolay Vasilievich Sklifosovsky

Nikolay Vasilievich Sklifosovsky Паллиативная медицинская помощь в Российской Федерации. Изменения законодательства

Паллиативная медицинская помощь в Российской Федерации. Изменения законодательства Ранние формы религии. Часть III

Ранние формы религии. Часть III «Условия применения компьютерных программ в начальной школе» "Скажи мне, и я забуду. Покажи мне, - я см

«Условия применения компьютерных программ в начальной школе» "Скажи мне, и я забуду. Покажи мне, - я см История развития самбо

История развития самбо Презентация Целеполагание

Презентация Целеполагание Таможенная флотилия в современных условиях Подготовила студентка ФТД-1, группы Т-102 Телкова Алина

Таможенная флотилия в современных условиях Подготовила студентка ФТД-1, группы Т-102 Телкова Алина Рычаги в технике, быту и природе

Рычаги в технике, быту и природе Тектоника

Тектоника Правовое государство

Правовое государство Имя прилагательное как часть речи. Правописание прилагательных.

Имя прилагательное как часть речи. Правописание прилагательных. Вакуумный экскаватор

Вакуумный экскаватор Медицина в эпоху возрождения Выполнил:студент гр.102 стом. фак. Пеньковский Б.Г.

Медицина в эпоху возрождения Выполнил:студент гр.102 стом. фак. Пеньковский Б.Г.  черно-белые - презентация для начальной школы

черно-белые - презентация для начальной школы