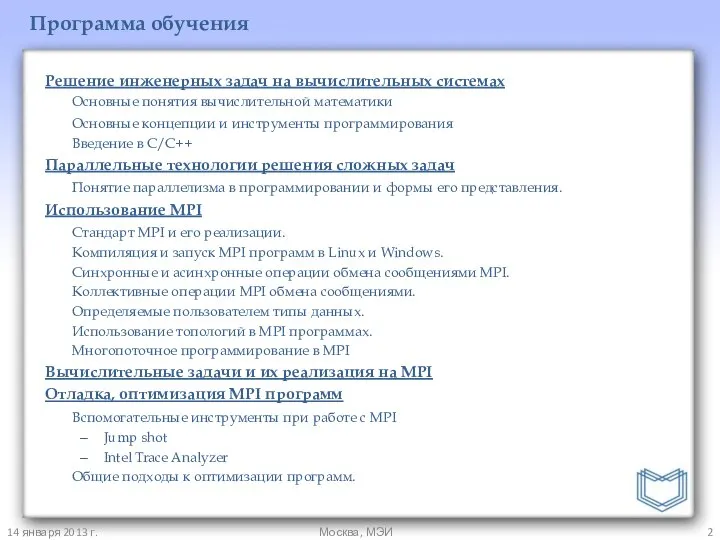

Программа обучения

Решение инженерных задач на вычислительных системах

Основные понятия вычислительной математики

Основные концепции

и инструменты программирования

Введение в C/С++

Параллельные технологии решения сложных задач

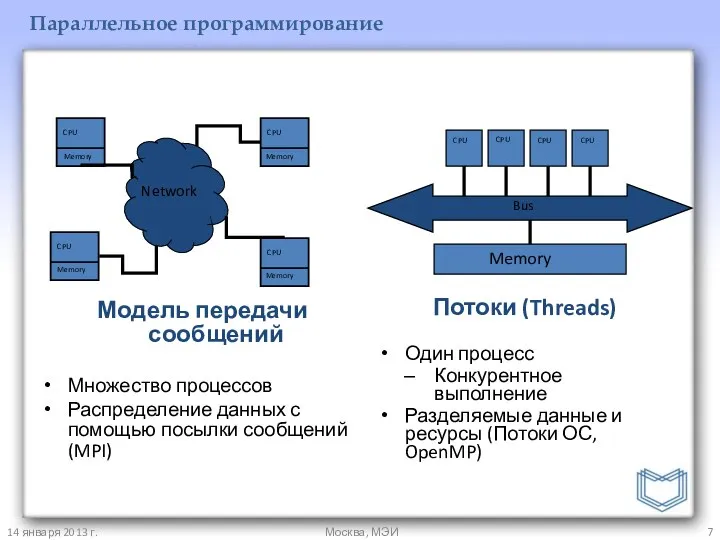

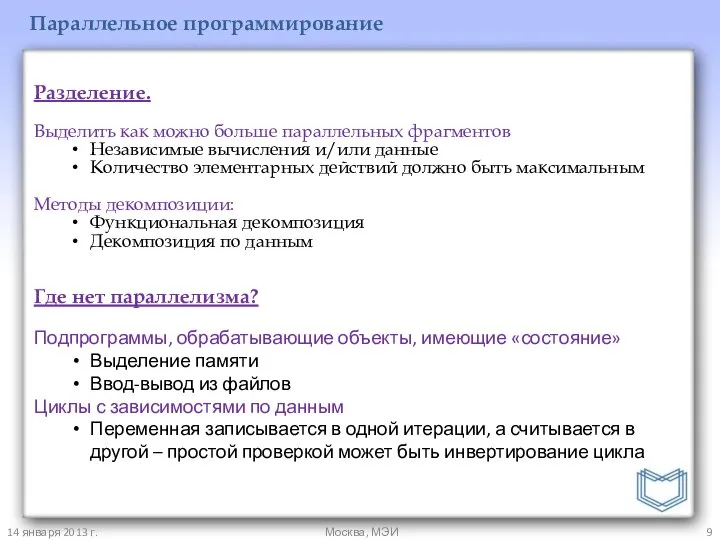

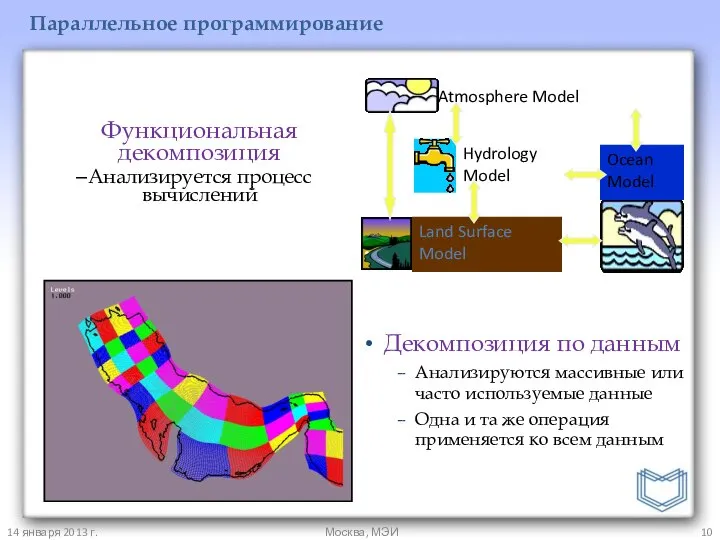

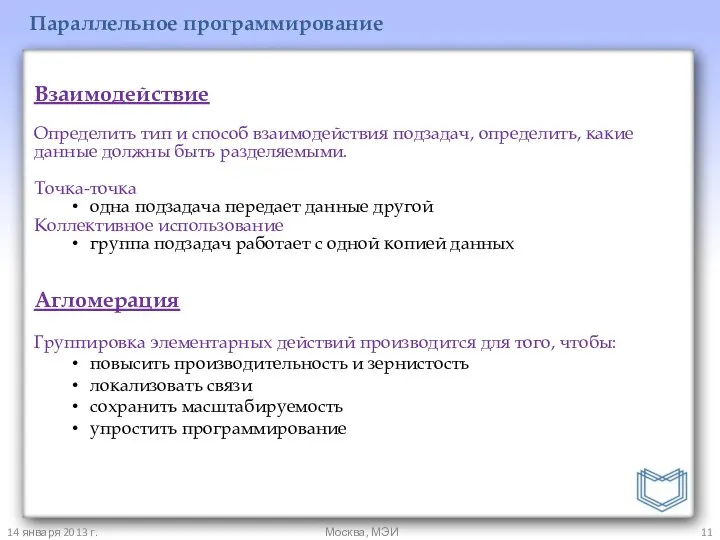

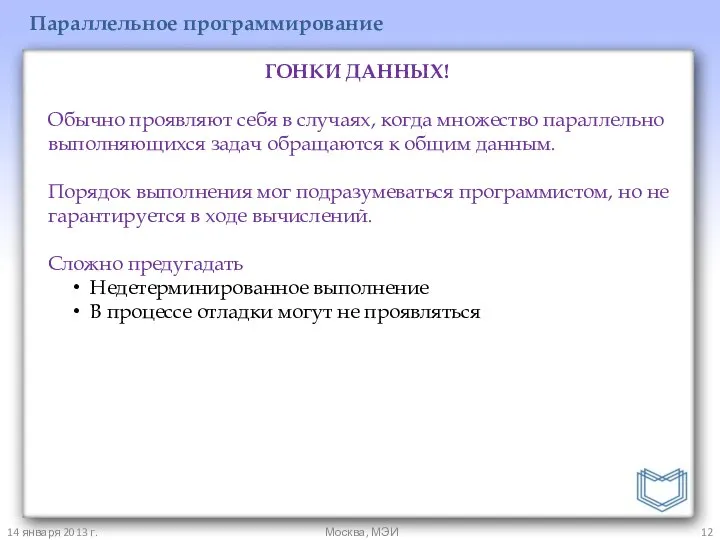

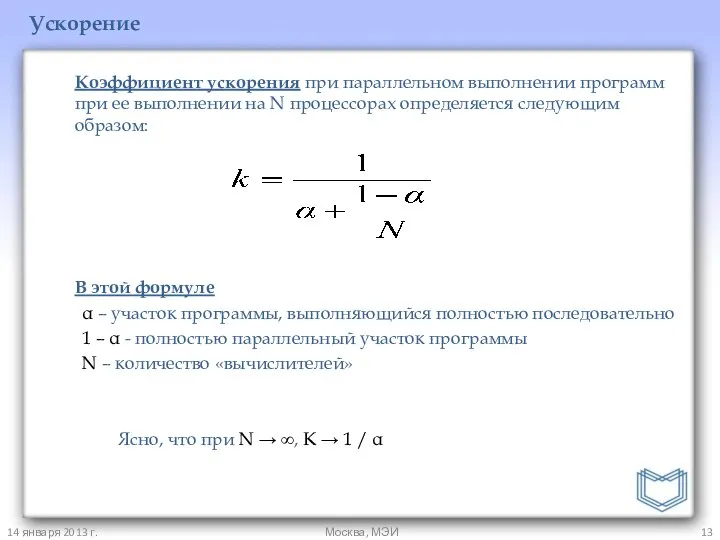

Понятие параллелизма в программировании и формы его представления.

Использование MPI

Стандарт MPI и его реализации.

Компиляция и запуск MPI программ в Linux и Windows.

Синхронные и асинхронные операции обмена сообщениями MPI.

Коллективные операции MPI обмена сообщениями.

Определяемые пользователем типы данных.

Использование топологий в MPI программах.

Многопоточное программирование в MPI

Вычислительные задачи и их реализация на MPI

Отладка, оптимизация MPI программ

Вспомогательные инструменты при работе с MPI

Jump shot

Intel Trace Analyzer

Общие подходы к оптимизации программ.

14 января 2013 г.

Москва, МЭИ

![Вектор aT=(a1,a2,…,an) Матрица A (m x n), A[i,j] Функция O(f(n)) Округление!](/_ipx/f_webp&q_80&fit_contain&s_1440x1080/imagesDir/jpg/1306570/slide-4.jpg)

буква а - презентация для начальной школы

буква а - презентация для начальной школы Мини-музей «Русская Матрешка»

Мини-музей «Русская Матрешка» Типы специальных инвестиционных проектов

Типы специальных инвестиционных проектов Месопотамия

Месопотамия Классификация промышленных зданий. Требования, предъявляемые к промышленным зданиям

Классификация промышленных зданий. Требования, предъявляемые к промышленным зданиям Атопічний марш. Атопічний дерматит.

Атопічний марш. Атопічний дерматит. Искусственный интеллект

Искусственный интеллект ГОСТ 2.307-2011 — «Нанесение размеров и предельных отклонений»

ГОСТ 2.307-2011 — «Нанесение размеров и предельных отклонений» Замісник (проксі). Патерни проектування

Замісник (проксі). Патерни проектування Презентация "Алгоритм «Подготовка к рисованию»" - скачать презентации по МХК

Презентация "Алгоритм «Подготовка к рисованию»" - скачать презентации по МХК Тестирование DVM

Тестирование DVM Паскаль. Основы

Паскаль. Основы Книги читать - скуки не знать - презентация для начальной школы_

Книги читать - скуки не знать - презентация для начальной школы_ Тема урока: Написание НЕ с наречиями на –О, -Е.

Тема урока: Написание НЕ с наречиями на –О, -Е. Цифровые интегральные микросхемы (ИМС)

Цифровые интегральные микросхемы (ИМС) Методы верификации прогнозных моделей

Методы верификации прогнозных моделей Модель ООН – путь к развитию личности

Модель ООН – путь к развитию личности Социальный проект «Каток для села Абалаково» (Организация досуга для детей села)

Социальный проект «Каток для села Абалаково» (Организация досуга для детей села) Бактерии

Бактерии Судебная система Российской Федерации: Мировые судьи

Судебная система Российской Федерации: Мировые судьи Валентин Григорьевич Распутин

Валентин Григорьевич Распутин Религии Океании и Австралии

Религии Океании и Австралии Полный цветовой круг

Полный цветовой круг Mirror Maze. Игра про нахождение выхода из лабиринта

Mirror Maze. Игра про нахождение выхода из лабиринта Тема 12. Оценка финансового состояния предприятия.

Тема 12. Оценка финансового состояния предприятия.  Дозиметрические приборы и приборы химической разведки

Дозиметрические приборы и приборы химической разведки Условия включения в реестр владельцев склада временного хранения Подготовила студентка группы 1403 Хорькова Юлия

Условия включения в реестр владельцев склада временного хранения Подготовила студентка группы 1403 Хорькова Юлия  Труд в изобразительном искусстве Выполнила учитель ИЗО Шаньшерова М.М. г. Белоярский ХМАО-Югра

Труд в изобразительном искусстве Выполнила учитель ИЗО Шаньшерова М.М. г. Белоярский ХМАО-Югра