Содержание

- 2. Информация - приращение, развитие, актуализация знаний, возникающее в процессе целеполагающей интеллектуальной деятельности человека. Актуализация – действие,

- 3. Основные понятия Количество информации – это числовая величина, адекватно характеризующая актуализируюмую информацию по разнообразию, сложности, структурируемости

- 4. Мера Р. Хартли Пусть имеется N состояний системы S или N опытов с различными, равновозможными последовательными

- 5. Мера Р. Хартли - в эспоненциальной системе k=1, H=lnN (нат) в двоичной системе k=1/ln2 H=log2N (бит)

- 6. Пример Определить положение точки в системе из двух клеток. Для этого нужно задать 1 вопрос –

- 7. Утверждение Р. Хартли Если в некоторм множестве X={x1,x2,…,xn} необходимо найти некоторый элемент xi, то для того,

- 8. Пример Имеется 12 монеты. Одна из них фальшивая более легкого веса). Определить, сколько взвешиваний нужно произвести,

- 9. Решение Если положить на вемы равное количество монет, то получим три возможных варианта: левая чаша ниже,

- 10. Выводы Формула Р.Хартли отвлечена от семантических и качественных, индивидуальных свойств системы (качества информации в проявлениях системы

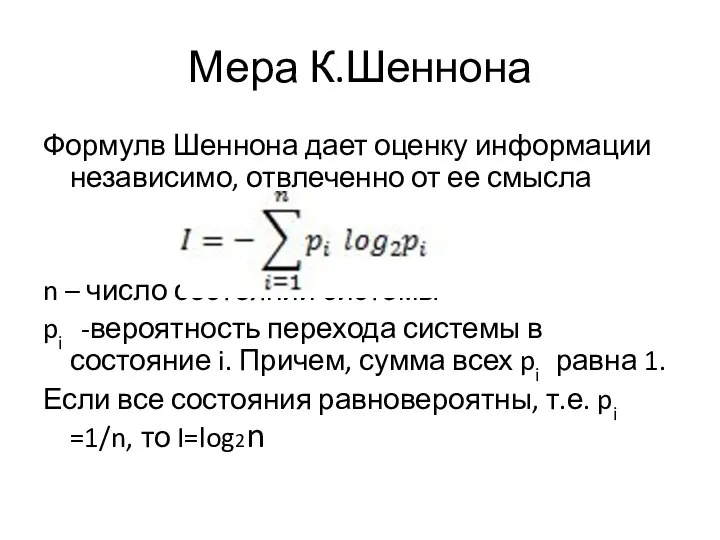

- 11. Мера К.Шеннона Формулв Шеннона дает оценку информации независимо, отвлеченно от ее смысла n – число состояний

- 12. К.Шеноном доказана теорема о единственности меры количества информации. Для случая равномерного закона распределения плотности вероятности марв

- 13. Если выбор i-го варианта предопределен заранее (т.е. выбра нет, pi=1) , то I=0. Сообщение о наступлении

- 14. Пример Если положение точки в системе известно, например она в k-ой клетке, т.е. все pi=0 и

- 15. Пример Сколько бит информации несет в себе произвольное двузначное число со всеми значащими цифрами. Т.к. таких

- 16. Если в формуле Шеннона обозначить fi=-nlog2pi, то получим, что I можно понимать как среднеарифметическое величин fi.

- 17. Пример Пусть рассматривается алфавит из двух символов русского языка - "к" и "а". Относительные частоты встречаемости

- 18. Пример В сообщении 4 буквы "a", 2 буквы "б", 1 буква "и", 6 букв "р". Определим

- 19. Энтропия (мера хаоса) Если в формуле k - коэффициент Больцмана, известный в физике как k=1.38×10-16 эрг/град,

- 20. При переходе от состояния S1 с информацией I1 к состоянию S2 с информацией I2 возможны случаи:

- 21. Преимущества и недостатки формулы Шеннона Преимущества: Отвлеченность от семантических и качественных, индивидуальных свойств системы. В отличие

- 22. Теория Шеннона разработана как теория передачи данных по каналам связи, а мера Шеннона - мера количества

- 23. Термодинамическая мера Информационно-термодинамический подход связывает величину энтропии систе-мы с недостатком информации о внутренней структуре системы (не

- 24. Пусть дана термодинамическая система (процесс) S, а Н0, Н1 – термодинамические энтропии системы S в началь-ном

- 25. Энергоинформационная (квантово-механическая) мера Энергия (ресурс) и информация (структура) - две фундаменталь-ные характеристики систем реального мира, связывающие

- 26. Другие меры информации мера, базирующаяся на понятии цели (А. Харкевич и другие); мера, базирующаяся на понятии

- 27. Тестовый вопрос 1 Вариант1 Какое определение – правильное количество информации – числовая характеристика порядка в системе

- 28. Тестовый вопрос 2 Вариант 1 Уменьшение количества инфор-мации в системе (по Шеннону) говорит: об уменьшении энтропии

- 29. Тестовый вопрос 3 Вариант 1 Верно утверждение: нулевой энтропии соответствует минимальная информация максимальной энтропии соответствует минимальная

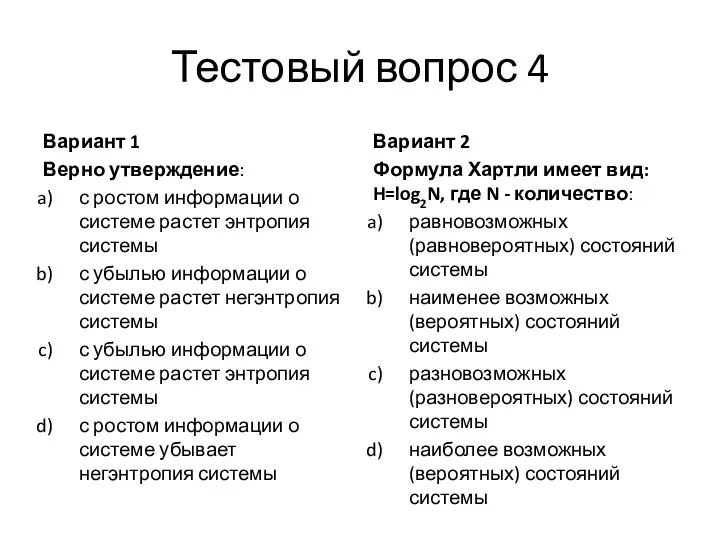

- 30. Тестовый вопрос 4 Вариант 1 Верно утверждение: с ростом информации о системе растет энтропия системы с

- 32. Скачать презентацию

Data types. SQL general data types

Data types. SQL general data types Бази даних. Системи управління базами даних. Пошук, сортування, створення форм, звітів та запитів в СУБД Access

Бази даних. Системи управління базами даних. Пошук, сортування, створення форм, звітів та запитів в СУБД Access Сайты страховых компаний

Сайты страховых компаний вирус это одна из величайших загадок биологии

вирус это одна из величайших загадок биологии  Системы автоматизированного проектирования технологических процессов (САПР ТП). Подсистемы САПР ТП. (Лекция 2)

Системы автоматизированного проектирования технологических процессов (САПР ТП). Подсистемы САПР ТП. (Лекция 2) Алгоритм

Алгоритм Big Data. Революция в области хранения и обработки данных

Big Data. Революция в области хранения и обработки данных «ФАЙЛОВАЯ СТРУКТУРА ДИСКА» 7 КЛАСС 2008 – 09 год

«ФАЙЛОВАЯ СТРУКТУРА ДИСКА» 7 КЛАСС 2008 – 09 год Управление проектами. Определения и концепции

Управление проектами. Определения и концепции Триггеры. Триггеры в презентации. Применение. Создание слайдов с триггерами

Триггеры. Триггеры в презентации. Применение. Создание слайдов с триггерами Тармақталу алгоритмдерін программалау

Тармақталу алгоритмдерін программалау Программа на Паскале для тестирования учащихся начальной школы как эффективный способ проверки знаний

Программа на Паскале для тестирования учащихся начальной школы как эффективный способ проверки знаний Компьютер и здоровье глаз Автор: Вялова Лариса Владимировна

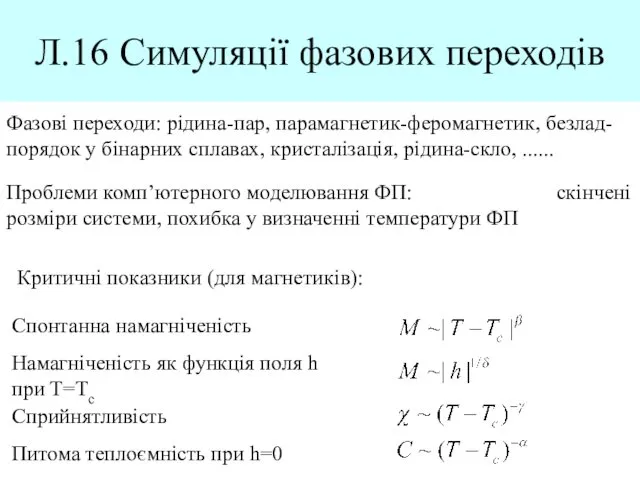

Компьютер и здоровье глаз Автор: Вялова Лариса Владимировна  Симуляції фазових переходів

Симуляції фазових переходів Перспективы развития информационно-коммуникационных технологий

Перспективы развития информационно-коммуникационных технологий Программирование на языке Q BASIC Выполнила: ученица 11 класса Гинкель Кристина Руководитель: Скульбеда Н.И.

Программирование на языке Q BASIC Выполнила: ученица 11 класса Гинкель Кристина Руководитель: Скульбеда Н.И.  SQL запросы

SQL запросы Угадай слово. Ребусы по информатике

Угадай слово. Ребусы по информатике Презентация "знатоки информатики" - скачать презентации по Информатике

Презентация "знатоки информатики" - скачать презентации по Информатике Базы данных. Теоретические основы

Базы данных. Теоретические основы Над презентацией работали учащиеся 9б класса: Ваврик Алина, Соловьева Дарья, Рыжов Дмитрий Руководитель: Кашина Ольга Валерьевна

Над презентацией работали учащиеся 9б класса: Ваврик Алина, Соловьева Дарья, Рыжов Дмитрий Руководитель: Кашина Ольга Валерьевна Талисман Sega

Талисман Sega Про решение 26-го задания в Excel

Про решение 26-го задания в Excel Купи продай. Искусство постосложения

Купи продай. Искусство постосложения Курсовая работа на тему «Разработка базы данных средствами СУБД MS Access. База данных двигателей постоянного тока»

Курсовая работа на тему «Разработка базы данных средствами СУБД MS Access. База данных двигателей постоянного тока»  Арифметические операции в позиционных системах счисления (4). 8 класс

Арифметические операции в позиционных системах счисления (4). 8 класс Введение в массивы. Типы массивов в C#. Класс Array. (Модуль 5)

Введение в массивы. Типы массивов в C#. Класс Array. (Модуль 5) Свой канал и позиционирование

Свой канал и позиционирование