Содержание

- 2. Пусть имеется пространство элементарных событий U, на нем построено поле событий и для каждого события А

- 3. Примеры: 1 . Координаты молекулы, находящейся в сосуде с газом, (x,y,z) или компоненты ее скорости (Vx,Vy,Vz)

- 4. 2 . В задаче "о встрече" время прихода одного участника (х1) и другого (х2), если условия

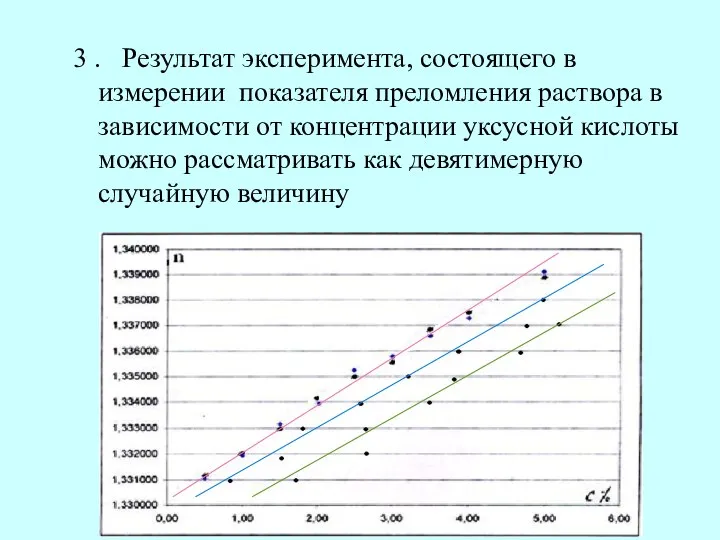

- 5. 3 . Результат эксперимента, состоящего в измерении показателя преломления раствора в зависимости от концентрации уксусной кислоты

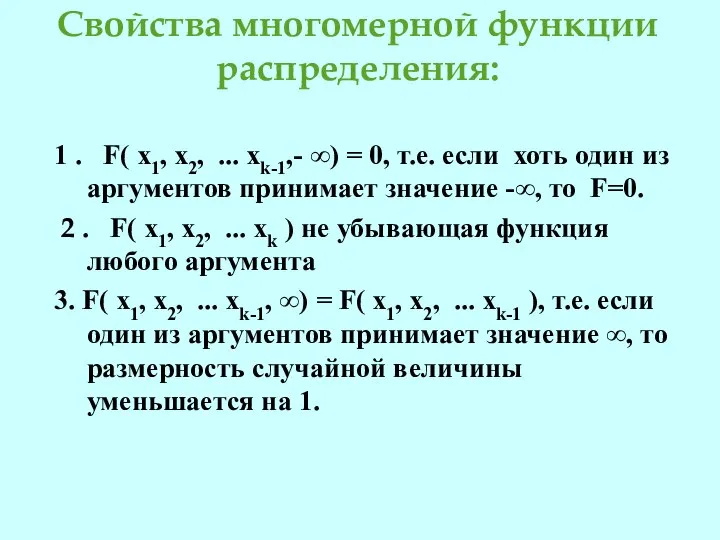

- 6. Свойства многомерной функции распределения: 1 . F( x1, x2, ... xk-1,- ∞) = 0, т.е. если

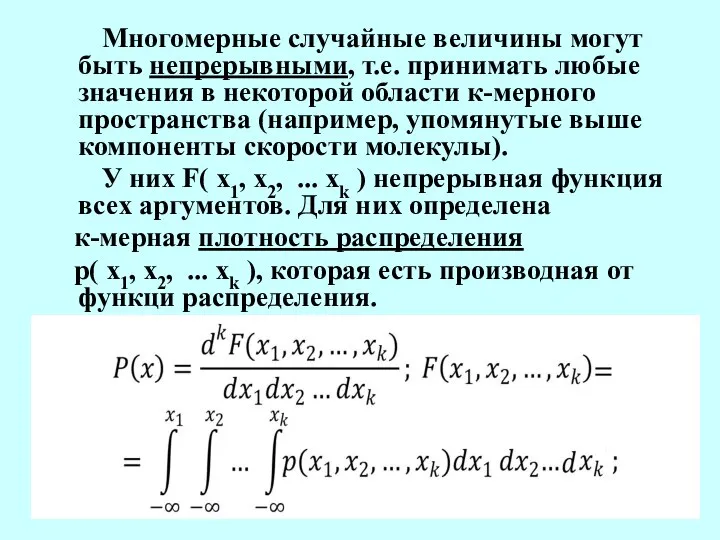

- 7. Многомерные случайные величины могут быть непрерывными, т.е. принимать любые значения в некоторой области к-мерного пространства (например,

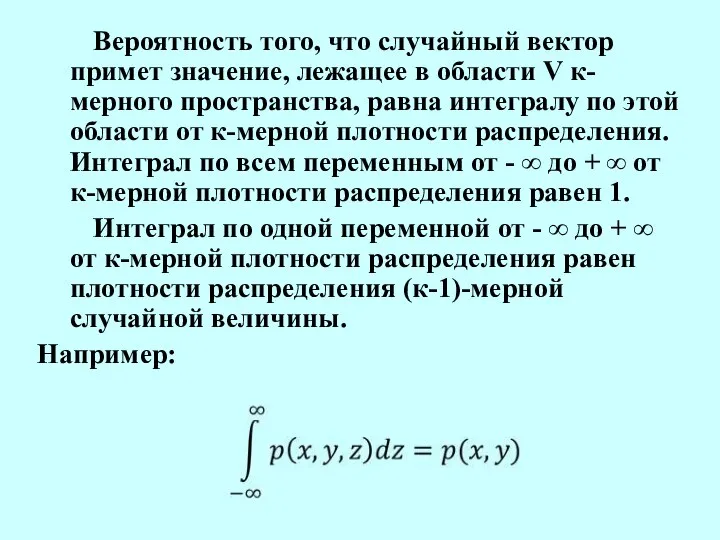

- 8. Вероятность того, что случайный вектор примет значение, лежащее в области V к-мерного пространства, равна интегралу по

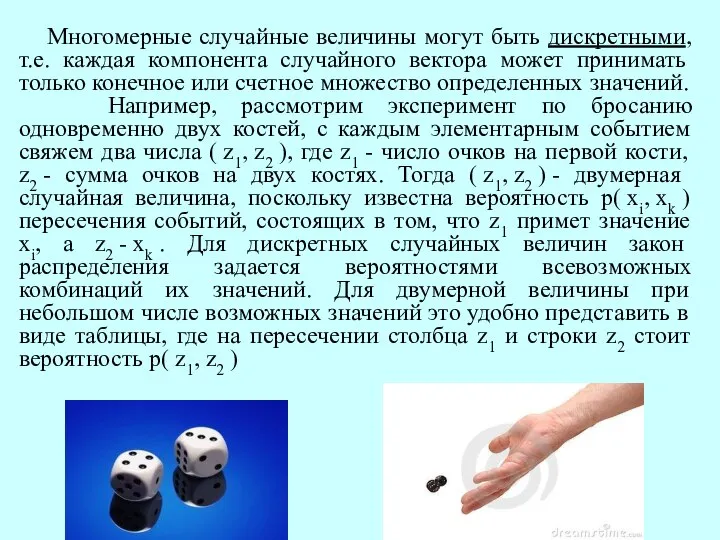

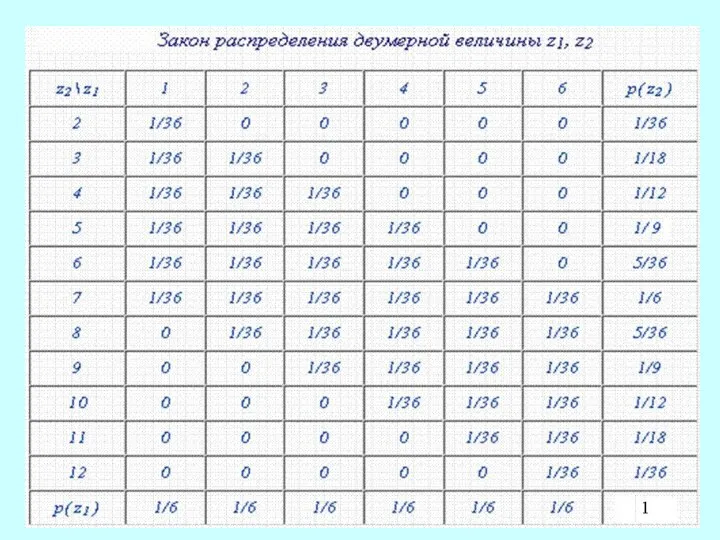

- 9. Многомерные случайные величины могут быть дискретными, т.е. каждая компонента случайного вектора может принимать только конечное или

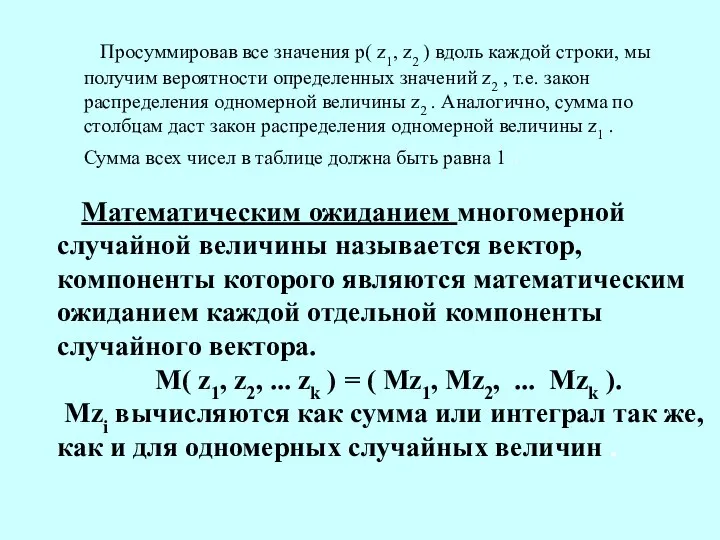

- 11. Просуммировав все значения р( z1, z2 ) вдоль каждой строки, мы получим вероятности определенных значений z2

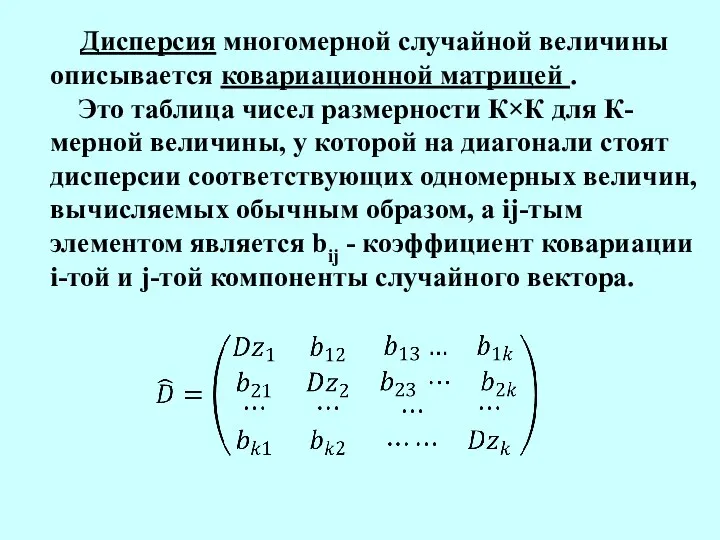

- 12. Дисперсия многомерной случайной величины описывается ковариационной матрицей . Это таблица чисел размерности К×К для К-мерной величины,

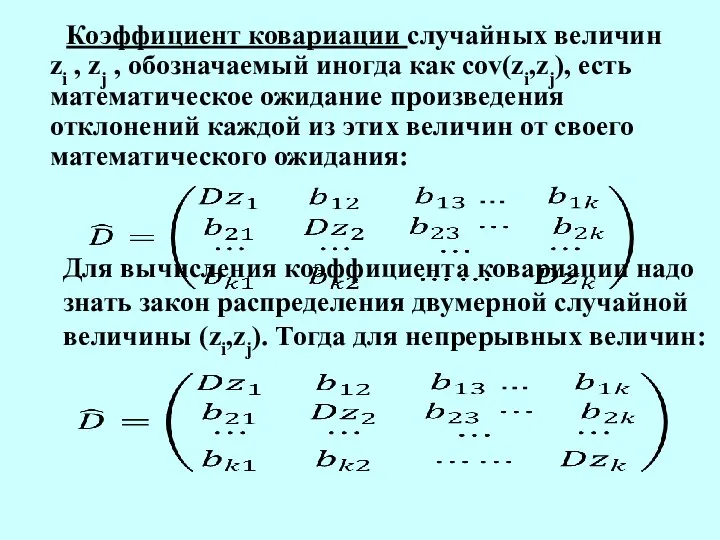

- 13. Коэффициент ковариации случайных величин zi , zj , обозначаемый иногда как cov(zi,zj), есть математическое ожидание произведения

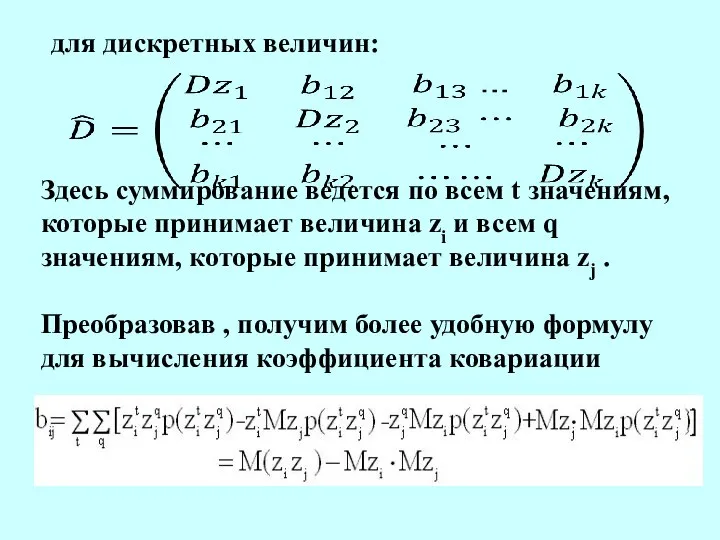

- 14. для дискретных величин: Здесь суммирование ведется по всем t значениям, которые принимает величина zi и всем

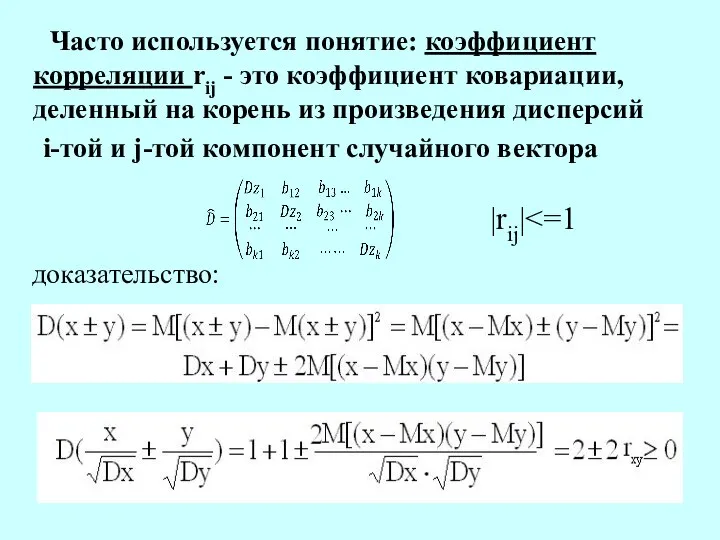

- 15. Часто используется понятие: коэффициент корреляции rij - это коэффициент ковариации, деленный на корень из произведения дисперсий

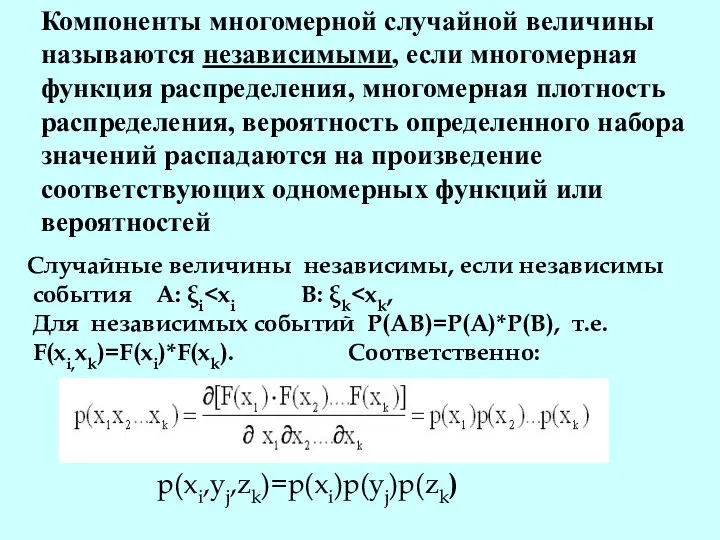

- 16. Компоненты многомерной случайной величины называются независимыми, если многомерная функция распределения, многомерная плотность распределения, вероятность определенного набора

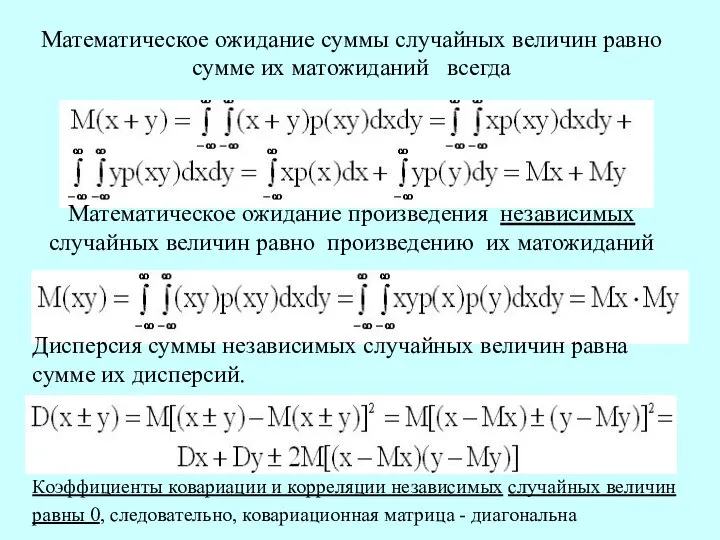

- 17. Математическое ожидание суммы случайных величин равно сумме их матожиданий всегда Математическое ожидание произведения независимых случайных величин

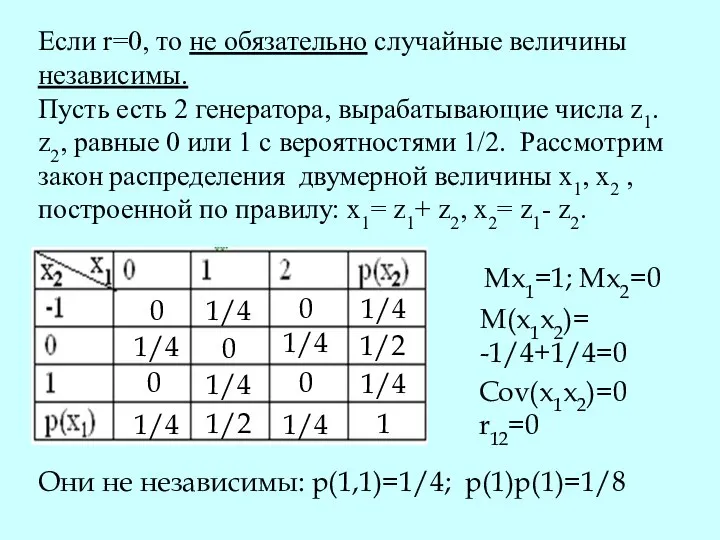

- 18. Если r=0, то не обязательно случайные величины независимы. Пусть есть 2 генератора, вырабатывающие числа z1. z2,

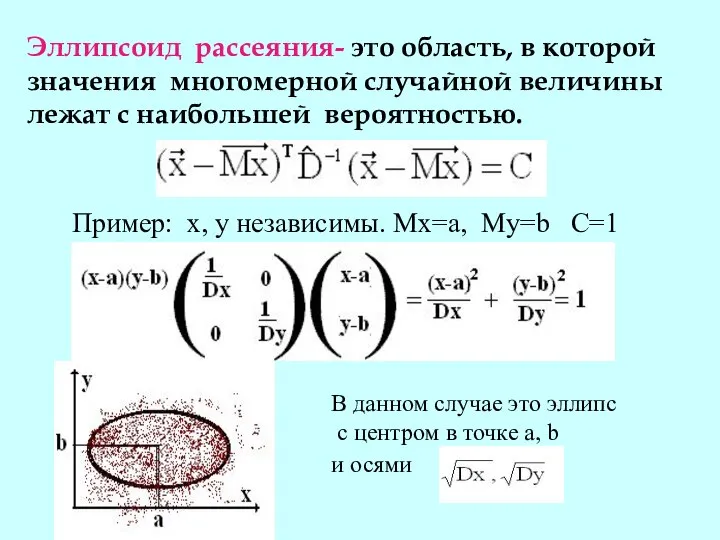

- 19. Эллипсоид рассеяния- это область, в которой значения многомерной случайной величины лежат с наибольшей вероятностью. Пример: х,

- 20. ЗАКОН БОЛЬШИХ ЧИСЕЛ

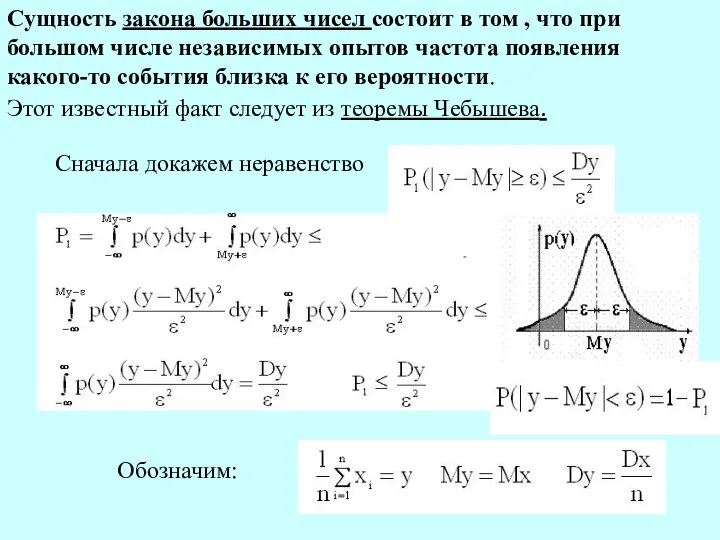

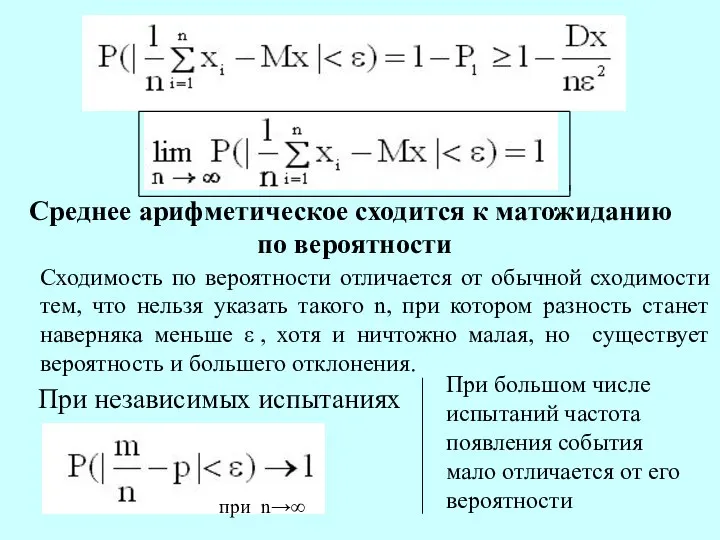

- 21. Сущность закона больших чисел состоит в том , что при большом числе независимых опытов частота появления

- 22. Среднее арифметическое сходится к матожиданию по вероятности Сходимость по вероятности отличается от обычной сходимости тем, что

- 23. ЦЕНТРАЛЬНАЯ ПРЕДЕЛЬНАЯ ТЕОРЕМА И ЕЕ СЛЕДСТВИЯ

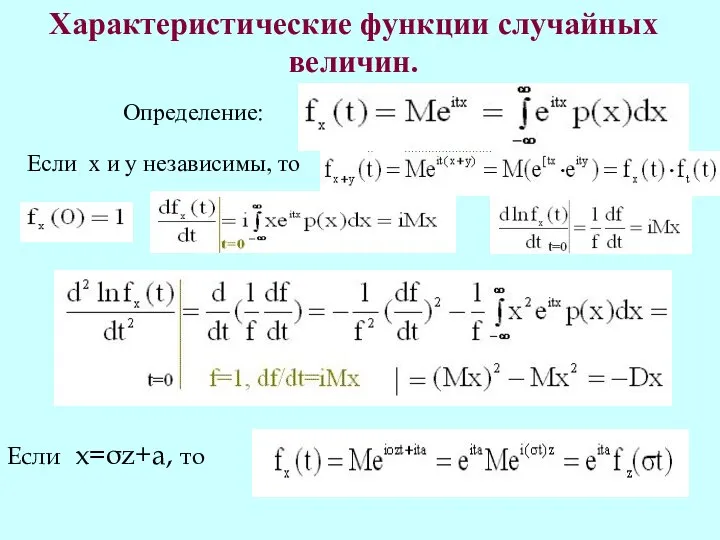

- 24. Характеристические функции случайных величин. Определение: Если х и у независимы, то Если x=σz+a, то

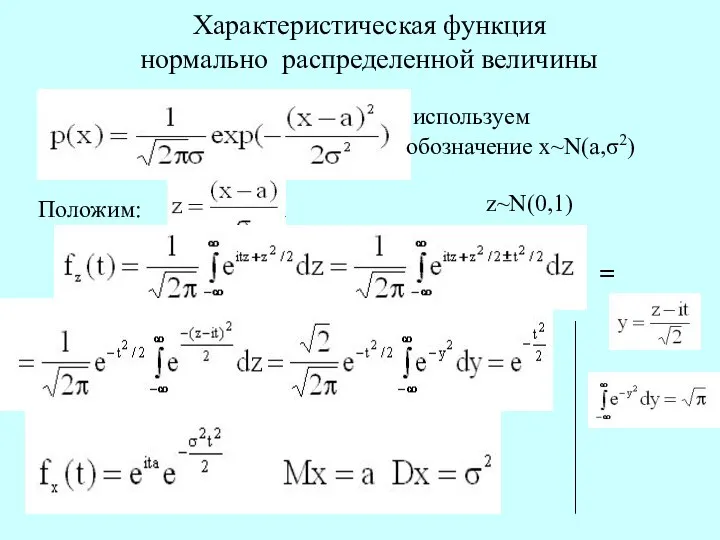

- 25. Характеристическая функция нормально распределенной величины используем обозначение х~N(a,σ2) Положим: = z~N(0,1)

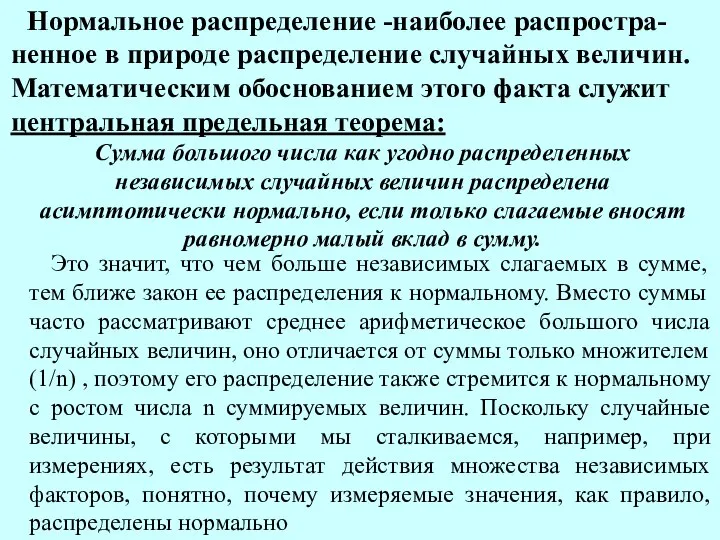

- 26. Нормальное распределение -наиболее распростра-ненное в природе распределение случайных величин. Математическим обоснованием этого факта служит центральная предельная

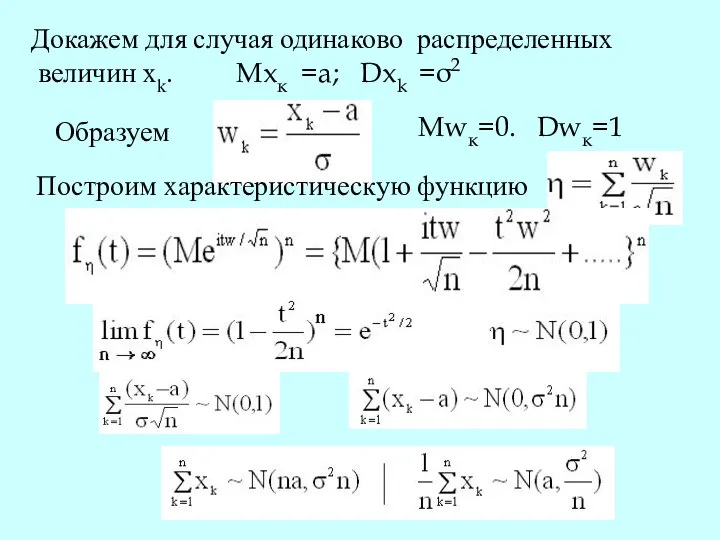

- 27. Докажем для случая одинаково распределенных величин xk. Mxк =a; Dxk =σ2 Образуем Mwк=0. Dwк=1 Построим характеристическую

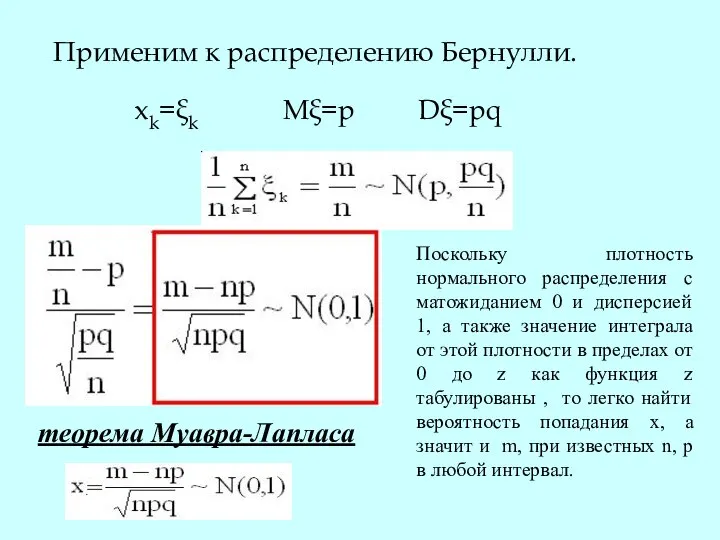

- 28. Применим к распределению Бернулли. xk=ξk Mξ=p Dξ=pq теорема Муавра-Лапласа Поскольку плотность нормального распределения с матожиданием 0

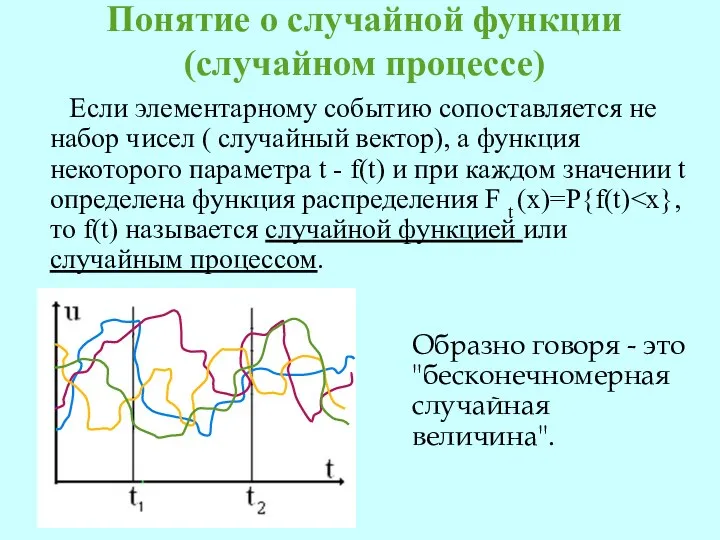

- 29. Понятие о случайной функции (случайном процессе) Если элементарному событию сопоставляется не набор чисел ( случайный вектор),

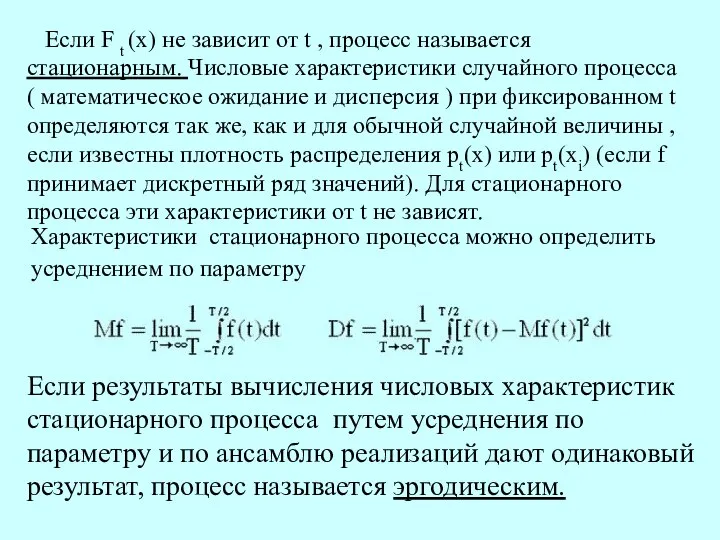

- 30. Если F t (x) не зависит от t , процесс называется стационарным. Числовые характеристики случайного процесса

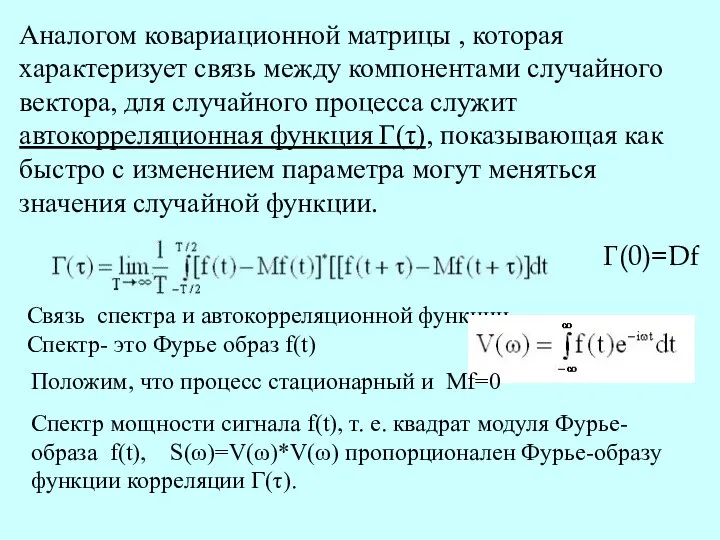

- 31. Аналогом ковариационной матрицы , которая характеризует связь между компонентами случайного вектора, для случайного процесса служит автокорреляционная

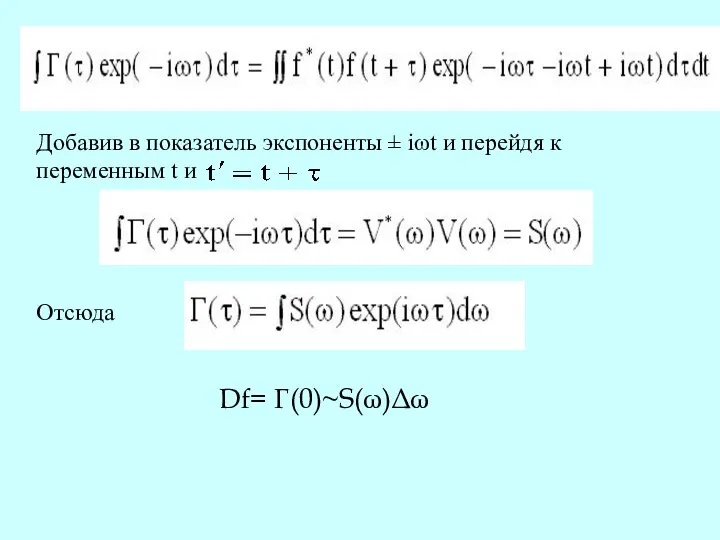

- 32. Добавив в показатель экспоненты ± iωt и перейдя к переменным t и Отсюда Df= Г(0)~S(ω)Δω

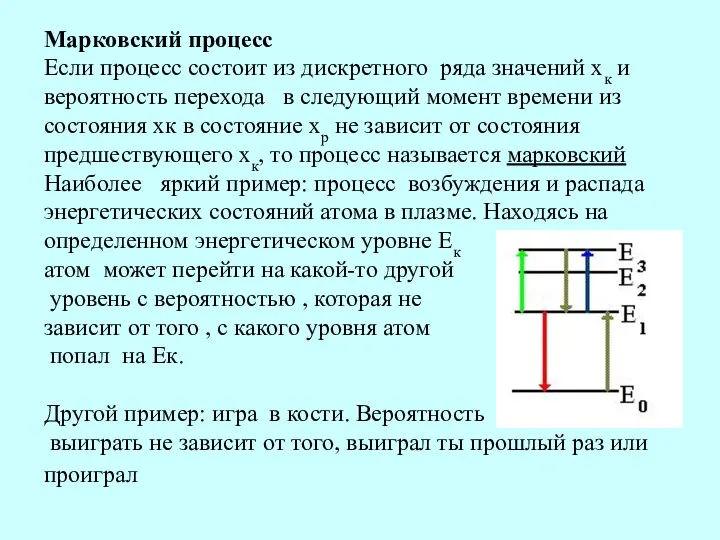

- 33. Марковский процесс Если процесс состоит из дискретного ряда значений хк и вероятность перехода в следующий момент

- 35. Скачать презентацию

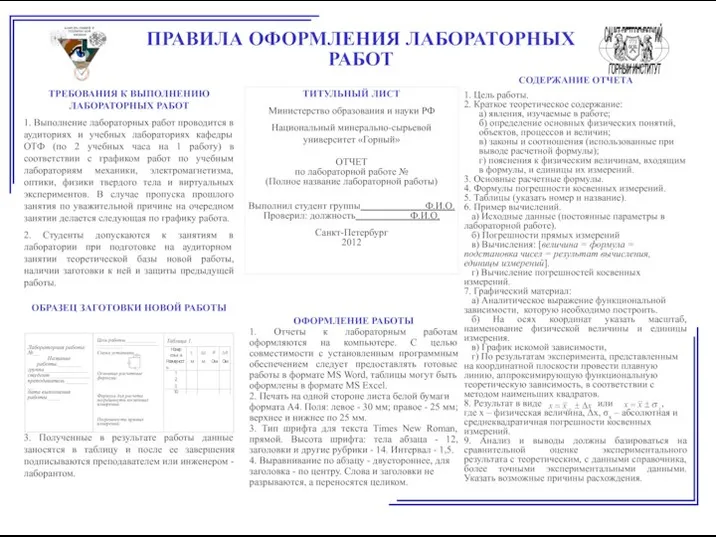

Требования к оформлению заготовки и отчета

Требования к оформлению заготовки и отчета Объемно-планировочный коэффициент

Объемно-планировочный коэффициент Устройства сверхвысоких частот и антенны. Назначение и задачи решаемые с помощью СВЧ устройств и антенн в радиотехнике

Устройства сверхвысоких частот и антенны. Назначение и задачи решаемые с помощью СВЧ устройств и антенн в радиотехнике Действия сотрудников ОВД при обнаружении взрывных устройств

Действия сотрудников ОВД при обнаружении взрывных устройств Практика работы адвоката с задержания подозреваемого до момента рассмотрения судом ходатайства об избрании меры пресечения

Практика работы адвоката с задержания подозреваемого до момента рассмотрения судом ходатайства об избрании меры пресечения Нанесение размеров. Масштабы

Нанесение размеров. Масштабы Метод вторичного квантования

Метод вторичного квантования  Язык С. История и развитие языка С

Язык С. История и развитие языка С Шаблоны параллельного проектирования

Шаблоны параллельного проектирования Основные понятия языка Turbo Pascal

Основные понятия языка Turbo Pascal Идеальное и материальное

Идеальное и материальное Разработка действующей модели регулятора температуры и влажности

Разработка действующей модели регулятора температуры и влажности Разминка по экологическому праву. Подготовила студентку 2 курса юридического факультета группы Ю124Б Тужилова Л.В.

Разминка по экологическому праву. Подготовила студентку 2 курса юридического факультета группы Ю124Б Тужилова Л.В. Культурологія. Магістерська програма

Культурологія. Магістерська програма Все на свете интересно - презентация для начальной школы_

Все на свете интересно - презентация для начальной школы_ Репутация нефтяной отрасли

Репутация нефтяной отрасли Параметры BIOS

Параметры BIOS Экология и Экономика Королев Юрий Юрьевич ICS Group, President

Экология и Экономика Королев Юрий Юрьевич ICS Group, President Аппаратная часть компьютерной системы

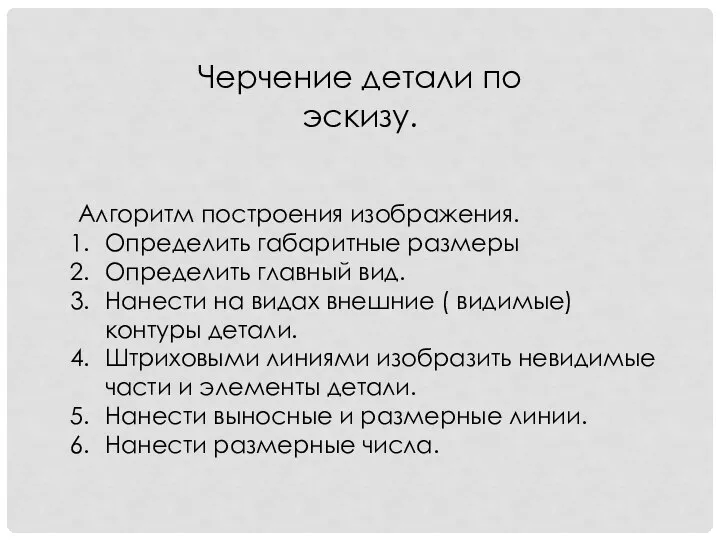

Аппаратная часть компьютерной системы Черчение детали по эскизу. Алгоритм построения изображения

Черчение детали по эскизу. Алгоритм построения изображения Финансовое прогнозирование

Финансовое прогнозирование  Иридодиагностика-5

Иридодиагностика-5 Lektsia_5_Fiziko-khimia_dispersnykh_sistem (1)

Lektsia_5_Fiziko-khimia_dispersnykh_sistem (1) Кадры и оплата труда на предприятии

Кадры и оплата труда на предприятии  История серии видеоигр: Doom, Rage, Left 4 Dead

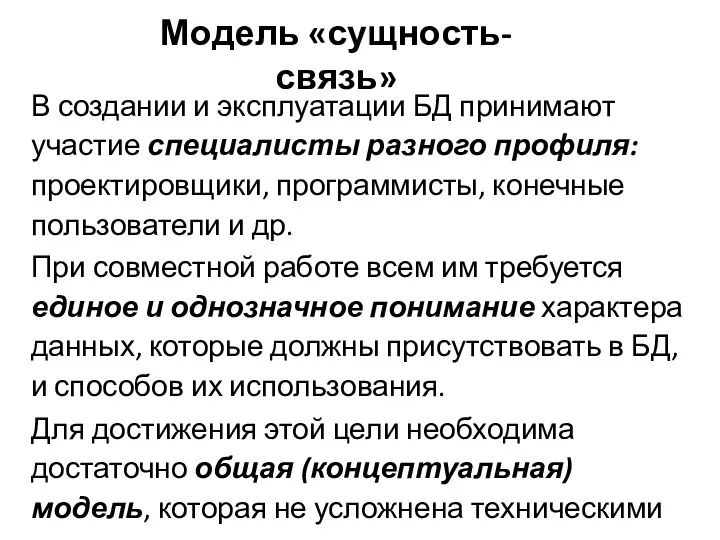

История серии видеоигр: Doom, Rage, Left 4 Dead Модель «сущность-связь»

Модель «сущность-связь» Codecraft HTML

Codecraft HTML Болезнь Лайма

Болезнь Лайма