Содержание

- 2. 1. Нейрон Нейронные сети и нейрокомпьютеры – это одно из направлений компьютерной индустрии, в основе которого

- 3. Нейроны человеческого мозга Аксон Дендриты Синапсы

- 4. простейший нейрон может иметь до 10 000 дендритов человеческий мозг содержит примерно 1011 нейронов каждый нейрон

- 5. 2. Математический нейрон Мак-Каллока – Питтса 1943 г. Уоррен Мак-Каллок и Вальтер Питтс выдвинули гипотезу математического

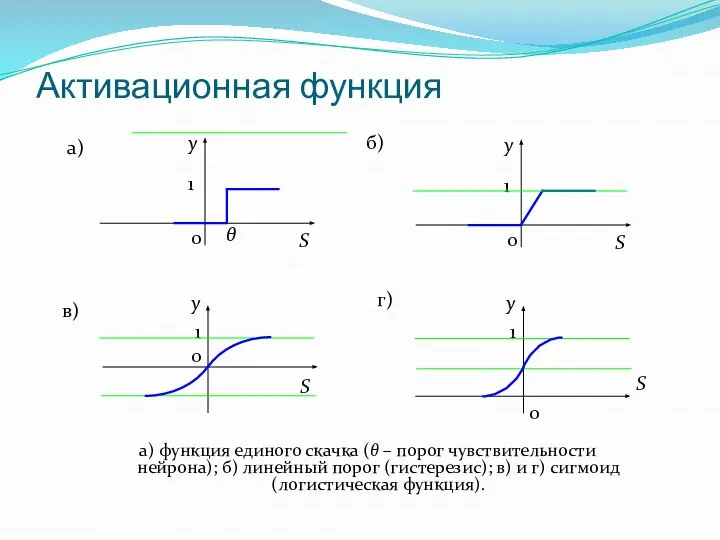

- 6. Активационная функция а) функция единого скачка (θ – порог чувствительности нейрона); б) линейный порог (гистерезис); в)

- 7. Математические нейроны, реализующие логические функции математический нейрон изображают кружочком возбуждающий вход – стрелкой тормозящий вход –

- 8. 3. Персептрон Розенблатта Идея Мак-Каллока – Питтса была реализована Фрэнком Розенблаттом: 1958 г. в виде компьютерной

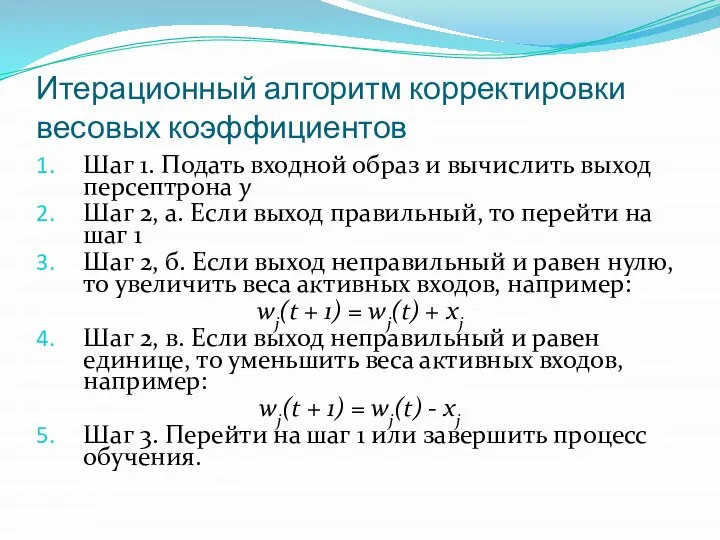

- 10. Итерационный алгоритм корректировки весовых коэффициентов Шаг 1. Подать входной образ и вычислить выход персептрона у Шаг

- 11. 4. Многослойный персептрон М. Минский и С. Пайперт в своей книге "Персептроны" строго математически доказали, что

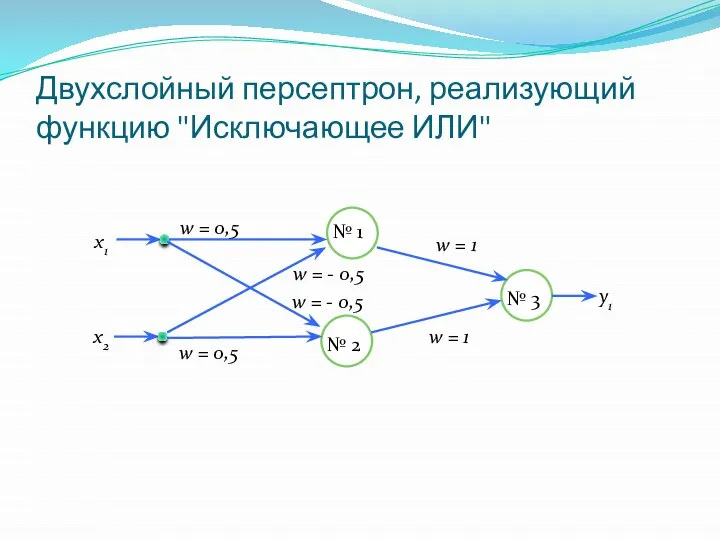

- 12. Двухслойный персептрон, реализующий функцию "Исключающее ИЛИ" № 1 № 2 № 3 w = 0,5 w

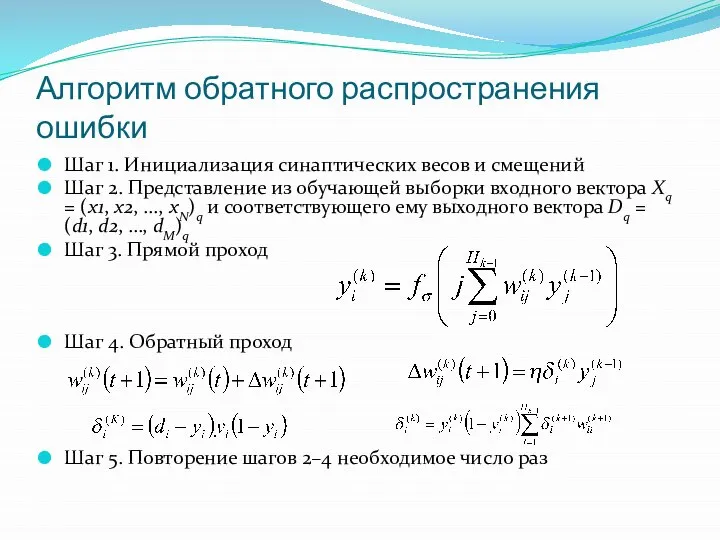

- 14. Алгоритм обратного распространения ошибки Шаг 1. Инициализация синаптических весов и смещений Шаг 2. Представление из обучающей

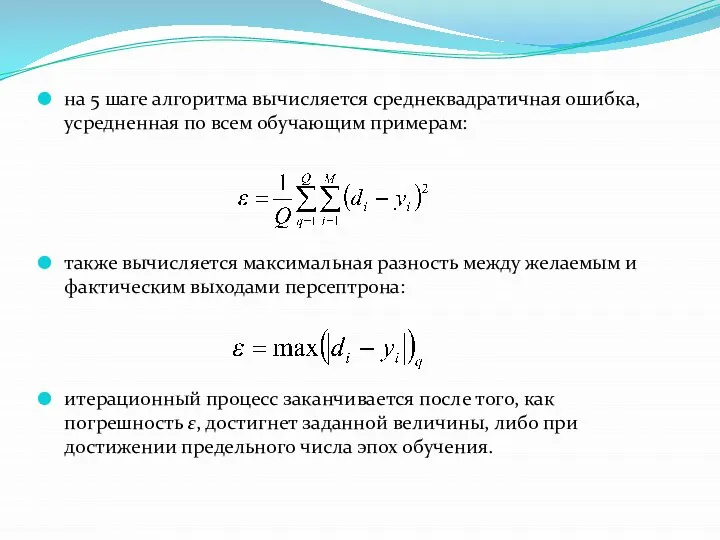

- 15. на 5 шаге алгоритма вычисляется среднеквадратичная ошибка, усредненная по всем обучающим примерам: также вычисляется максимальная разность

- 16. Задачи, решаемые с помощью нейросетей если есть математическая модель какого-то процесса, то изучая влияние входных параметров

- 17. Невербальность и "шестое чувство" нейросетей Как и человеческий мозг, нейросеть способна выводить закономерности, делать догадки, открывать

- 18. Методы обучения нейросетей детерминистские стохастические подстройка весов представляет собой жёсткую последовательность действий подстройка весов производится на

- 19. основная проблема обучения персептронов состоит в том, что поверхность функции ошибок обычно имеет очень сложную форму

- 20. Генетический алгоритм предложен Дж. Холландом в 1970-х годах имитирует природный оптимизационный процесс, происходящий при эволюции живых

- 21. Операция скрещивания, применяемая в генетических алгоритмах a1 a2 Хромосома отца b1 b2 Хромосома матери a1 b2

- 22. Подготовка входных параметров успех создания нейронной сети во многом зависит от удачного подбора обучающих примеров следует

- 23. Определение незначимых параметров анализа значений весовых коэффициентов входных нейронов. Если у какого-либо входного нейрона синаптические веса

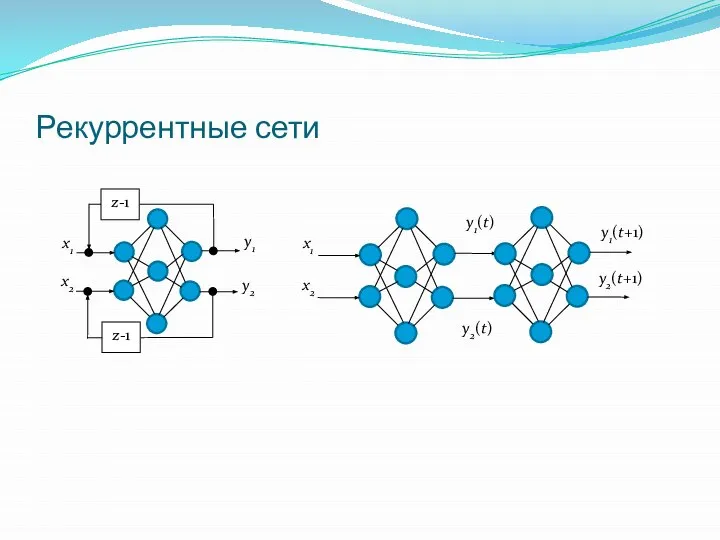

- 24. Рекуррентные сети

- 26. Скачать презентацию

Я і мая сям’я. Мая кватэра. (Тэма 7)

Я і мая сям’я. Мая кватэра. (Тэма 7) Валерий Яковлевич Брюсов 1873-1924 поэт, драматург, прозаик

Валерий Яковлевич Брюсов 1873-1924 поэт, драматург, прозаик Старанний і дружний наш 1-Б клас

Старанний і дружний наш 1-Б клас Презентация на тему "Обмен холестерола" - скачать презентации по Медицине

Презентация на тему "Обмен холестерола" - скачать презентации по Медицине Понятие культуры. Формы и разновидности культуры

Понятие культуры. Формы и разновидности культуры Салық кызметі органдарында тәуекелді басқару

Салық кызметі органдарында тәуекелді басқару Гальванизация

Гальванизация Interaction of the atmosphere with underlying surfaces

Interaction of the atmosphere with underlying surfaces  Разработка проекта системы наземного телевизионного вещания

Разработка проекта системы наземного телевизионного вещания  3D render production - exterior

3D render production - exterior Презентация "ребусы" - скачать презентации по Экономике

Презентация "ребусы" - скачать презентации по Экономике Проект «РАСКРАСЬ ДЕТСТВО»

Проект «РАСКРАСЬ ДЕТСТВО» Здоровый образ жизни

Здоровый образ жизни Структура сайта Ansell

Структура сайта Ansell Архітектурні пам’ятки часів Київської Русі

Архітектурні пам’ятки часів Київської Русі Easter. Пасха

Easter. Пасха Теория игр_10.05.2013.pptx

Теория игр_10.05.2013.pptx listen

listen Технология строительства спортивных площадок и игровых полей

Технология строительства спортивных площадок и игровых полей Диалектика

Диалектика  Организм побеждает болезни УМК «Школа 2100» Урок окружающего мира

Организм побеждает болезни УМК «Школа 2100» Урок окружающего мира Класс "Первопрохождения" клуба "САУК-ПАЙ". Рейтинг альпинистов-первопроходцев (топ-лист 2)

Класс "Первопрохождения" клуба "САУК-ПАЙ". Рейтинг альпинистов-первопроходцев (топ-лист 2) Сущность и виды предпринимательской деятельности

Сущность и виды предпринимательской деятельности Создание стратегии развити компании Слайд-шоу

Создание стратегии развити компании Слайд-шоу  Коррупционные риски

Коррупционные риски Первый Пермский международный марафон 2-3 сентября 2017 года

Первый Пермский международный марафон 2-3 сентября 2017 года Спрос. Предложение. Рыночное равновесие.

Спрос. Предложение. Рыночное равновесие.  М.И.Глинка Опера «Руслан и Людмила» Геймур Виктория Андреевна, учитель русского языка и литературы МОУ « СОШ № 47» г. Оренбурга

М.И.Глинка Опера «Руслан и Людмила» Геймур Виктория Андреевна, учитель русского языка и литературы МОУ « СОШ № 47» г. Оренбурга