Содержание

- 3. Платформы по соревнованиям в анализе данных (DM)

- 4. Преимущества Kaggle Наиболее раскрученная платформа Возможность запускать in-class соревнования Крутые соревнования от топовых IT компаний Красивый,

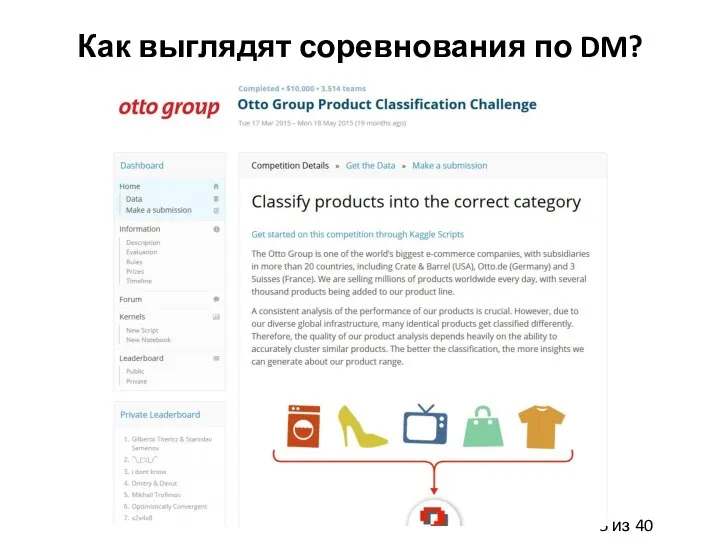

- 5. Как выглядят соревнования по DM?

- 6. Цикл решения задач DM

- 7. Понимание задачи Определение и формулировании бизнес задачи Оценка рисков, затрат, общего профита Постановка DM целей Определение

- 8. Понимание данных: Первый шаг Сбор данных Какие данные есть: сколько примеров, сколько признаков, какие признаки по

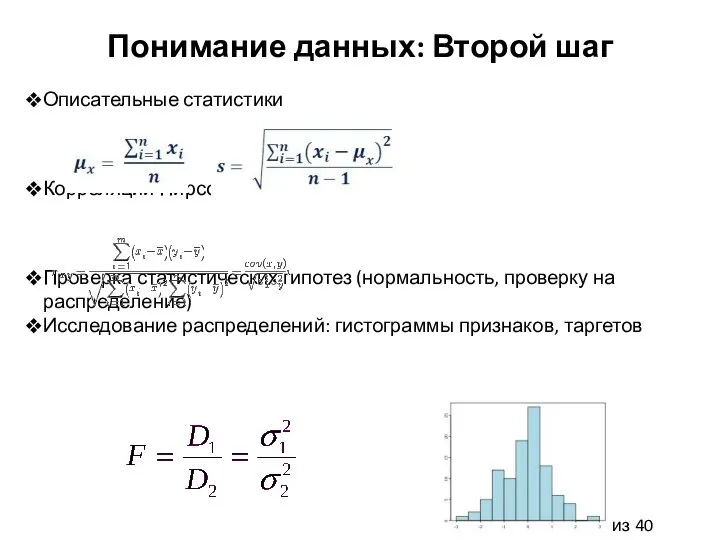

- 9. Понимание данных: Второй шаг Описательные статистики Корреляции Пирсона, Спирмена Проверка статистических гипотез (нормальность, проверку на распределение)

- 10. Подготовка данных Выбор и интеграция данных Форматирование данных Предобработка данных: заполнение пропусков, определение выбросов, нормализация данных,

- 11. Построение моделей Выбор подходящих моделей, соответствующих проверяемым гипотезам Определение дизайна тестирования Обучение моделей с настройкой гиперпараметров

- 12. Оценка качества моделей Анализ эффективности моделей на тестовом множестве: статистические гипотезы, корреляции Вычисление метрик оценки качества

- 13. Развертывание системы Финальный отчет по проекту Выполнены ли все поставленные DM цели? Удовлетворяют ли результаты критерия

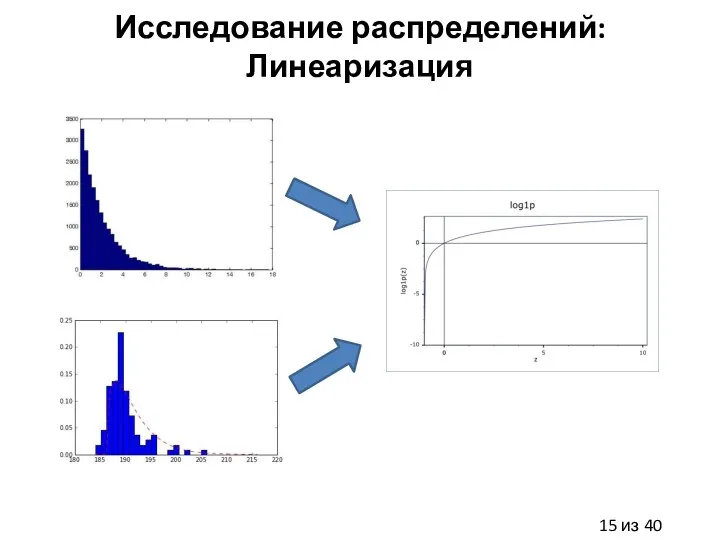

- 15. Исследование распределений: Линеаризация

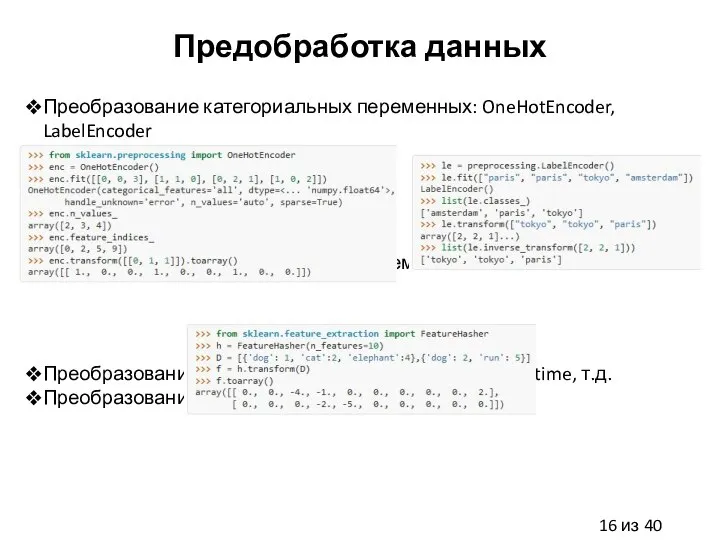

- 16. Предобработка данных Преобразование категориальных переменных: OneHotEncoder, LabelEncoder Преобразование категориальных переменных: hashing trick Преобразование дат: pandas.TimeStamp, pandas.to_datetime,

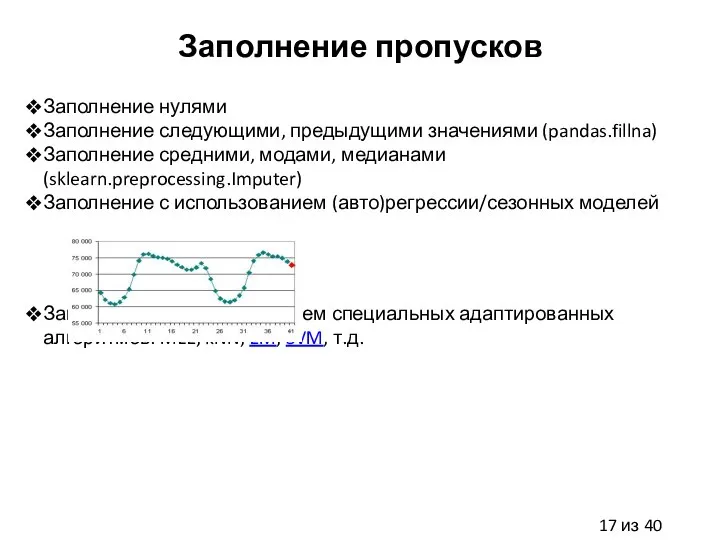

- 17. Заполнение пропусков Заполнение нулями Заполнение следующими, предыдущими значениями (pandas.fillna) Заполнение средними, модами, медианами (sklearn.preprocessing.Imputer) Заполнение с

- 18. Определение выбросов Определение через распределения: по квантилям, перцентилям, по другим правилам пальца Определение через визуализацию, использую

- 19. Нормализация данных Стандартная нормализация Нормализация в 0-1 или в -1, 1(для нейроных сетей) Стемминг, лемматизация, TF-IDF

- 20. Выбор признаков Выбор через model-free методы: scikit-feature Статистики (sklearn.feature_selection.SelectKBest) Корреляции Пирсона, Спирмена Выбор через model-based методы:

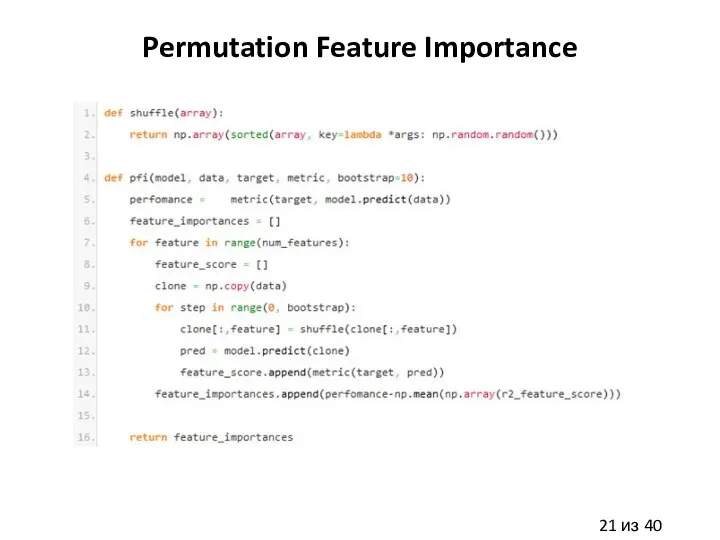

- 21. Permutation Feature Importance

- 22. Deep Feature Selection Li, Yifeng, Chih-Yu Chen, and Wyeth W. Wasserman. "Deep Feature Selection: Theory and

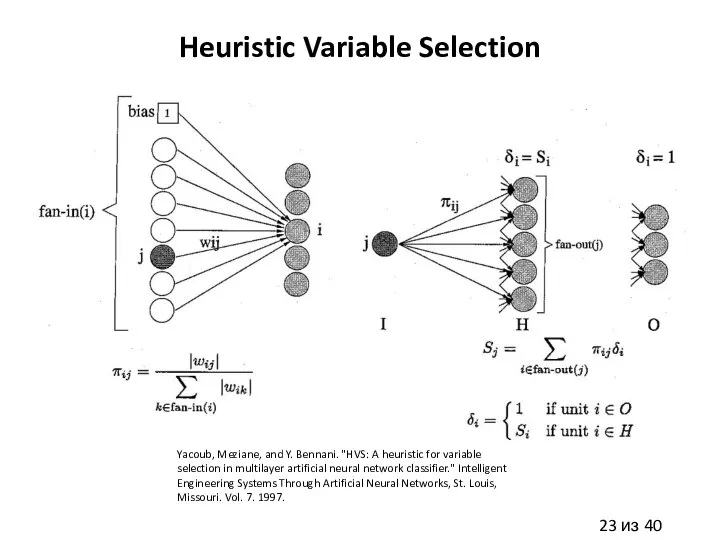

- 23. Heuristic Variable Selection Yacoub, Meziane, and Y. Bennani. "HVS: A heuristic for variable selection in multilayer

- 24. Экстракция признаков Экстракция через визуальный анализ (handcrafted признаки) Экстракция через model-based методы (NN, RandomForest, т.д.) Экстракция

- 25. Инженерия признаков Простейшие handcrafted признаки: среднее, дисперсия и т.п. по примеру Исследование взаимодействия признаков между собой

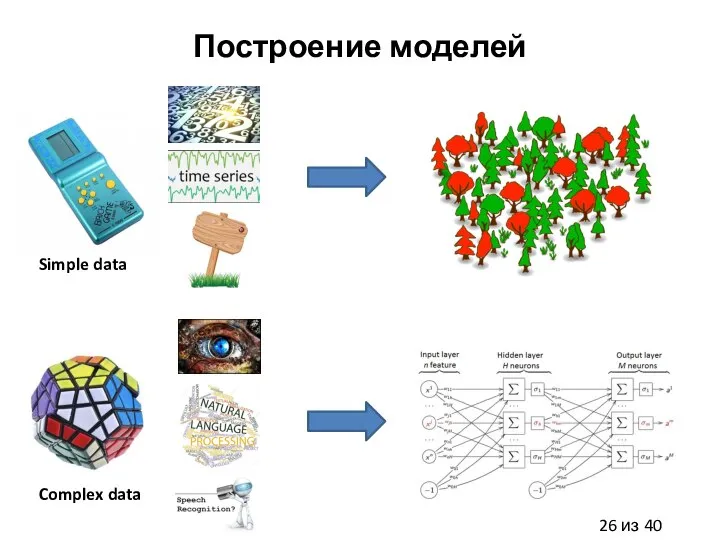

- 26. Построение моделей Simple data Complex data

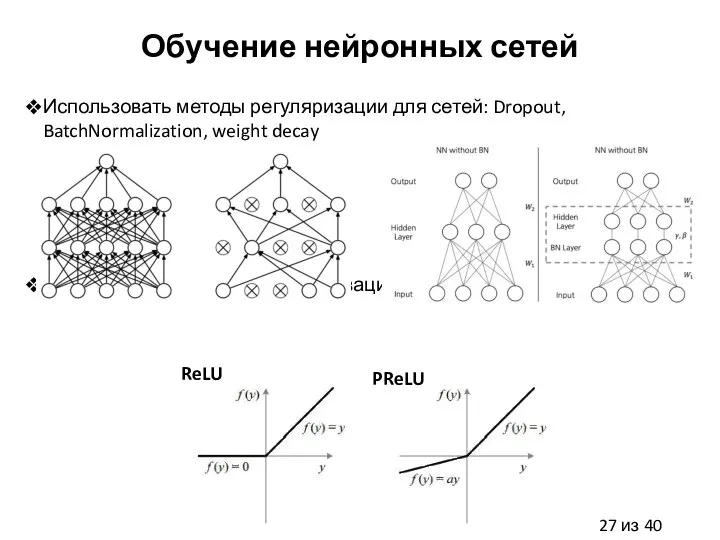

- 27. Обучение нейронных сетей Использовать методы регуляризации для сетей: Dropout, BatchNormalization, weight decay Использовать продвинутые активационные функции

- 28. Обучение нейронных сетей

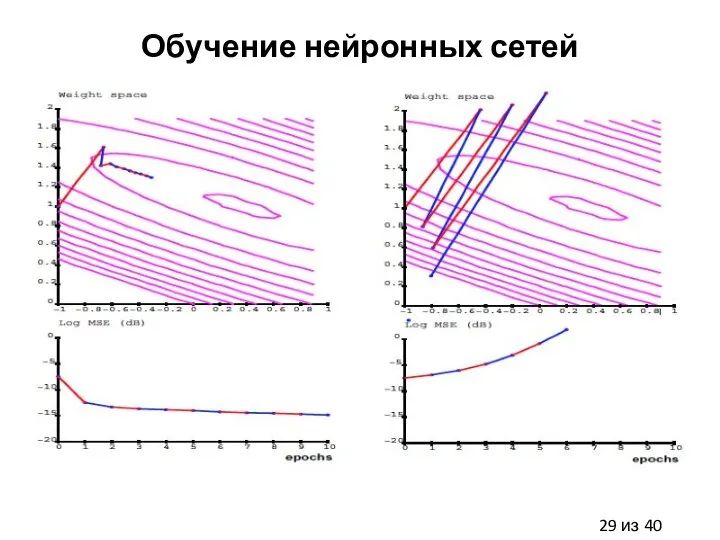

- 29. Обучение нейронных сетей

- 31. Модели победители на Kaggle соревнованиях Использовать GBM из xgboost, random forest, regularized greedy forest Использовать NN

- 32. Технические Tips & Tricks Делать верную предобработку данных Правильно работать с нормализацией/выбросами/пропусками Проводить визуальный анализ данных,

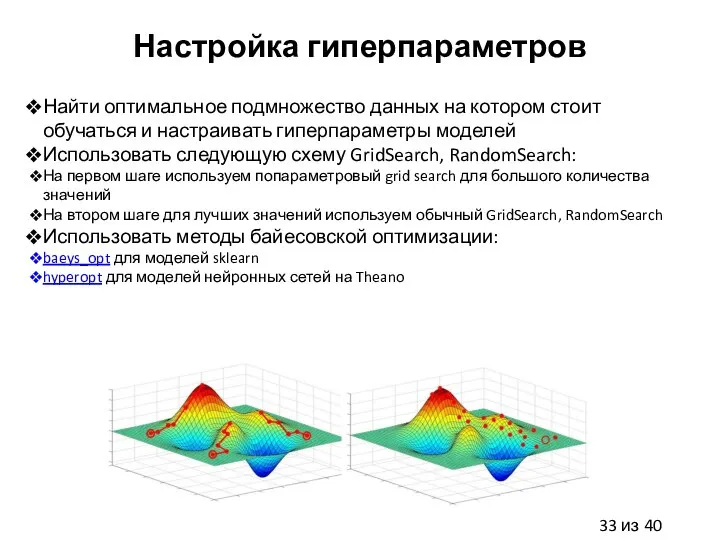

- 33. Настройка гиперпараметров Найти оптимальное подмножество данных на котором стоит обучаться и настраивать гиперпараметры моделей Использовать следующую

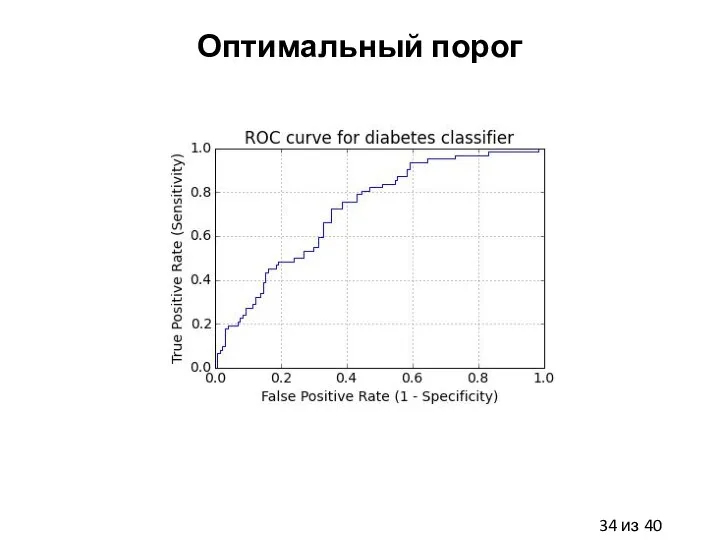

- 34. Оптимальный порог

- 35. Калибровка вероятностей sklearn.calibration.CalibratedClassifierCV

- 36. Несбалансированные данные Использовать методы балансировки данных: imbalanced-learn Undersampling (SVM, kNN, NN) Oversampling (SVM, kNN, NN) Использовать

- 37. Спасибо за внимание! Вопросы? Евгений Путин Университет ИТМО putin.evgeny@gmail.com 25 мая 2017 Санкт-Петербург

- 39. Скачать презентацию

Бюджет моей семьи

Бюджет моей семьи Внешенэкономическая деятельность: право и управление

Внешенэкономическая деятельность: право и управление Исследование рынка гостиничных услуг и делового туризма в Санкт-Петербурге

Исследование рынка гостиничных услуг и делового туризма в Санкт-Петербурге Классовая (марксистская) теория

Классовая (марксистская) теория Экономика дарения

Экономика дарения Налоги и налогообложение. Налог на добавленную стоимость. (Тема 3)

Налоги и налогообложение. Налог на добавленную стоимость. (Тема 3) Человеческий потенциал Выполнил : Евлоев И. Т-114

Человеческий потенциал Выполнил : Евлоев И. Т-114  Участие России в интеграционных процессах

Участие России в интеграционных процессах Закон попиту і пропозиції, та їх еластичність

Закон попиту і пропозиції, та їх еластичність Реализация государственной молодежной политики в Пермском Крае

Реализация государственной молодежной политики в Пермском Крае Постиндустриальное (информационное) общество

Постиндустриальное (информационное) общество Презентация Воображение

Презентация Воображение Государственный центр землепользования Республики Крым

Государственный центр землепользования Республики Крым Глобализация. Глобальные проблемы современного мира

Глобализация. Глобальные проблемы современного мира Конкурентные преимущества

Конкурентные преимущества Экономика здравоохранения

Экономика здравоохранения Введение в макроэкономический анализ (предмет макроэкономики)

Введение в макроэкономический анализ (предмет макроэкономики) Вертикальная интеграция и вертикальные ограничения

Вертикальная интеграция и вертикальные ограничения Поняття робочого місця на підприємстві. Раціональні умови праці та поняття паспорту робочого місця

Поняття робочого місця на підприємстві. Раціональні умови праці та поняття паспорту робочого місця Структура мировой экономики и проблема экономической отсталости

Структура мировой экономики и проблема экономической отсталости Основы теории потребительского выбора

Основы теории потребительского выбора Североамериканская интеграция (НАФТА)

Североамериканская интеграция (НАФТА) Проект «Гражданин России»

Проект «Гражданин России» Мировая экономика

Мировая экономика Задание для контрольной работы. Мировая экономика

Задание для контрольной работы. Мировая экономика Государство и бизнес в регионе: стратегии взаимодействия

Государство и бизнес в регионе: стратегии взаимодействия Презентация Финансы экономических субъектов

Презентация Финансы экономических субъектов Financial Evaluation of an IT Project

Financial Evaluation of an IT Project