Содержание

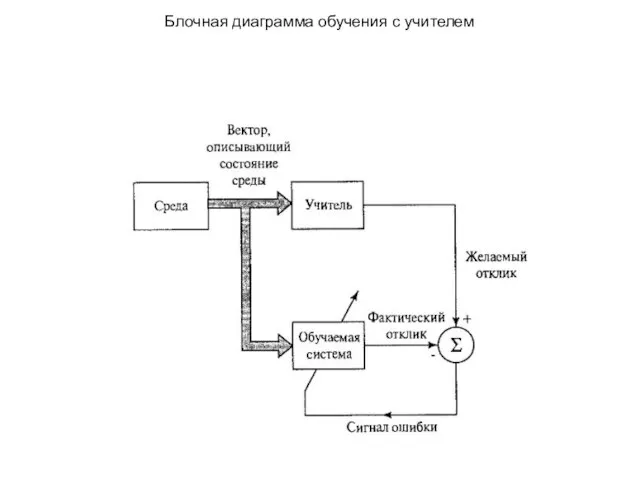

- 3. Блочная диаграмма обучения с учителем

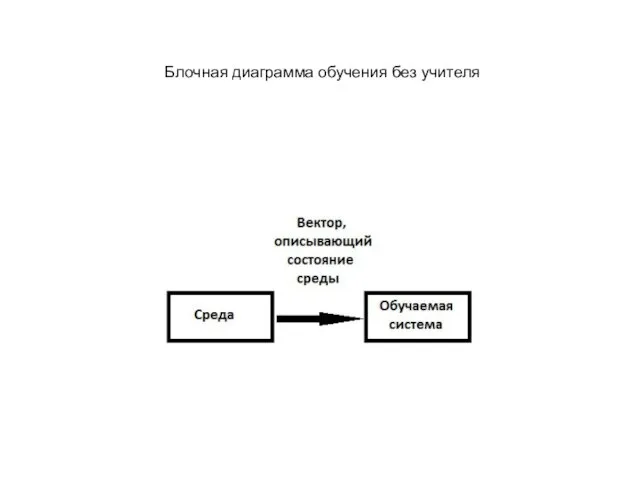

- 4. Блочная диаграмма обучения без учителя

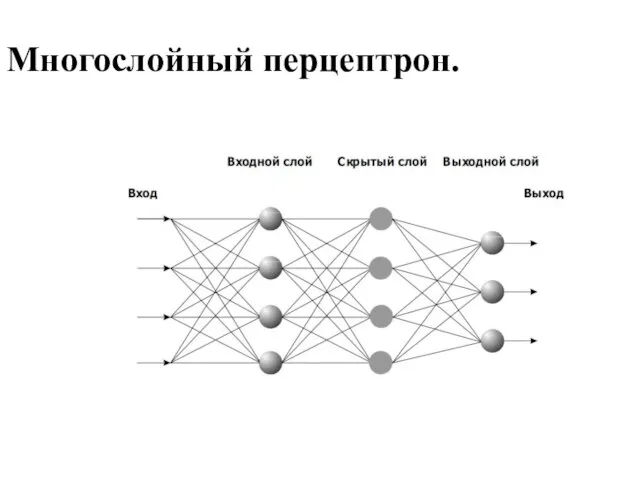

- 8. Многослойный перцептрон.

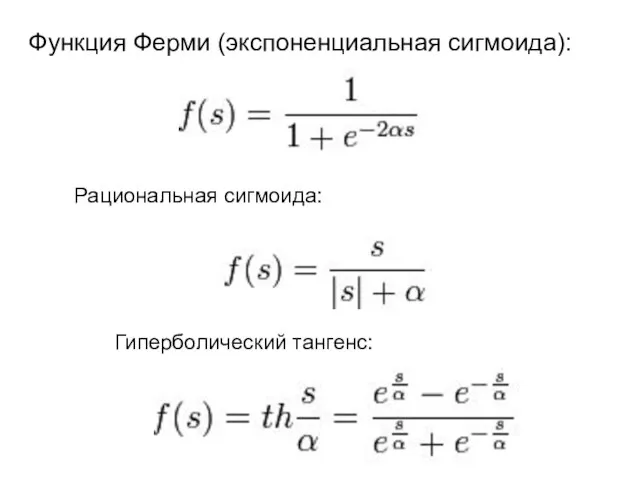

- 9. Функция Ферми (экспоненциальная сигмоида): Рациональная сигмоида: Гиперболический тангенс:

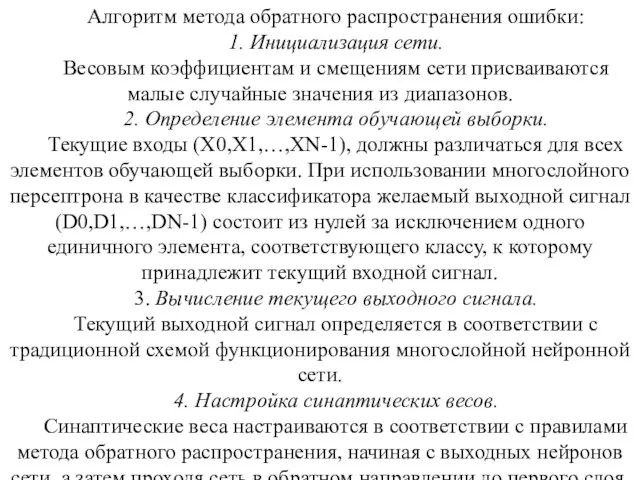

- 10. Алгоритм метода обратного распространения ошибки: 1. Инициализация сети. Весовым коэффициентам и смещениям сети присваиваются малые случайные

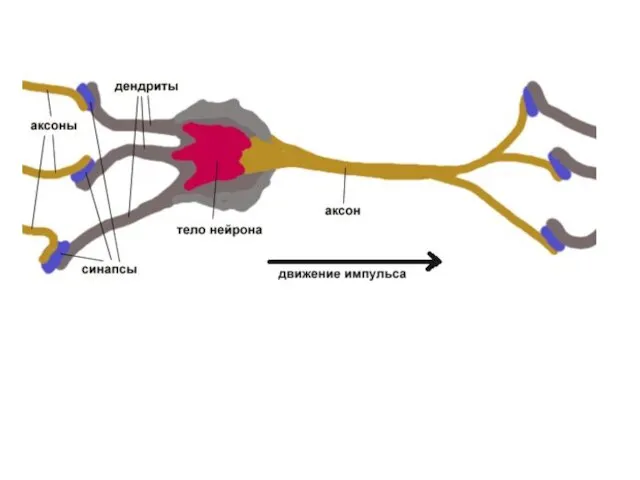

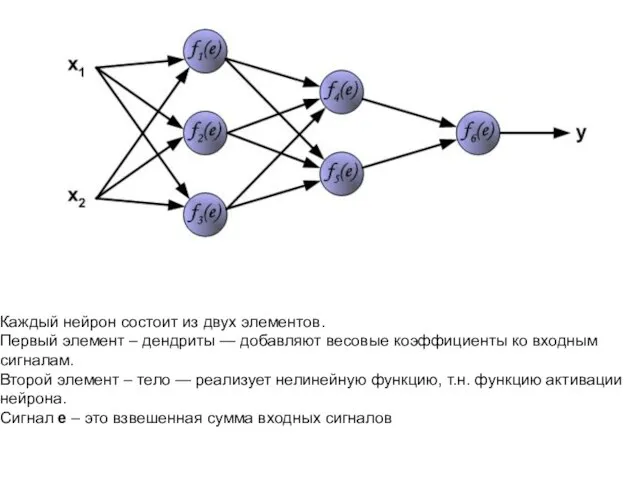

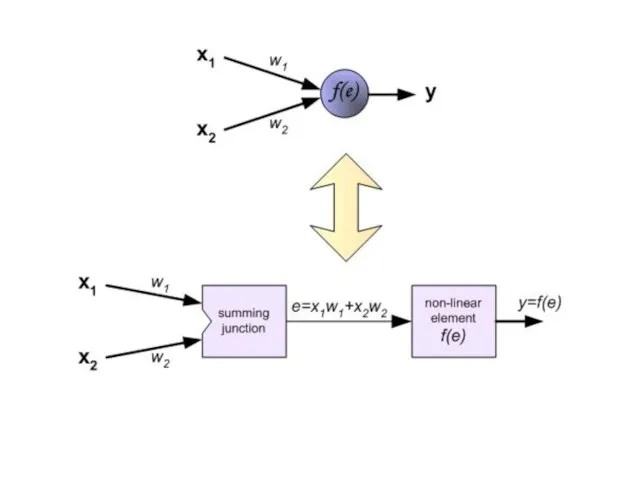

- 11. Каждый нейрон состоит из двух элементов. Первый элемент – дендриты — добавляют весовые коэффициенты ко входным

- 13. Чтобы обучить нейронную сеть мы должны подготовить обучающие данные(примеры). В нашем случае, тренировочные данные состоят из

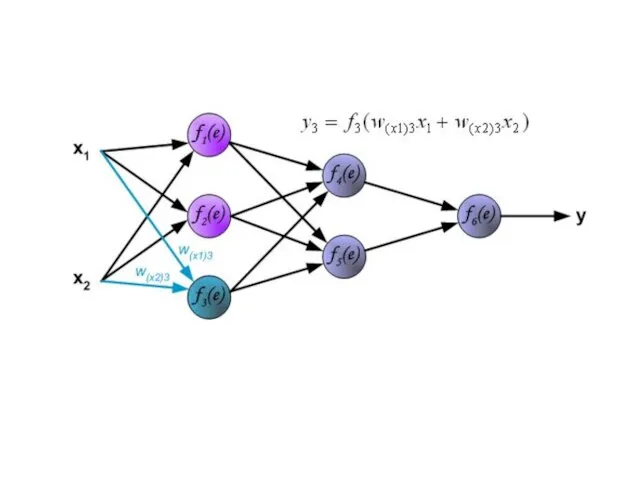

- 14. Каждый шаг обучения начинается с воздействия входных сигналов из тренировочных примеров. После этого мы можем определить

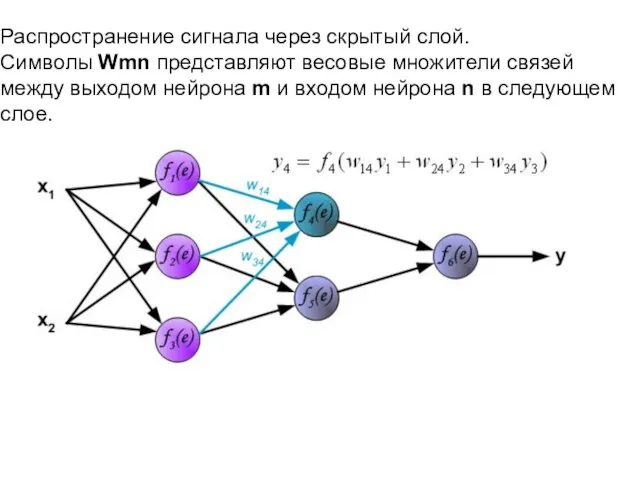

- 18. Распространение сигнала через скрытый слой. Символы Wmn представляют весовые множители связей между выходом нейрона m и

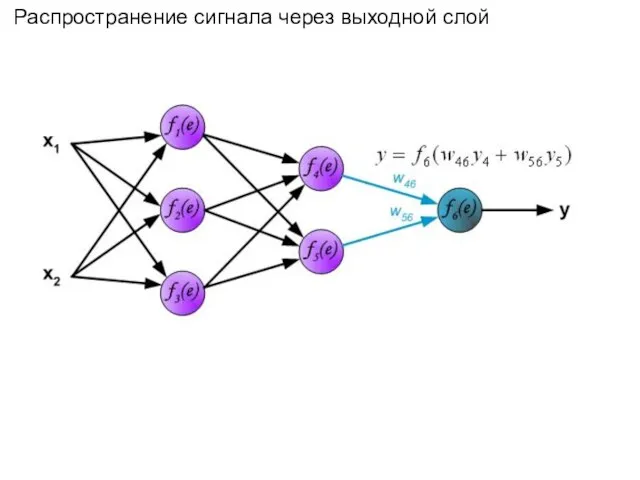

- 20. Распространение сигнала через выходной слой

- 21. На следующем шаге алгоритма, выходной сигнала сети y сравнивается с желаемым выходным сигналом z, который хранится

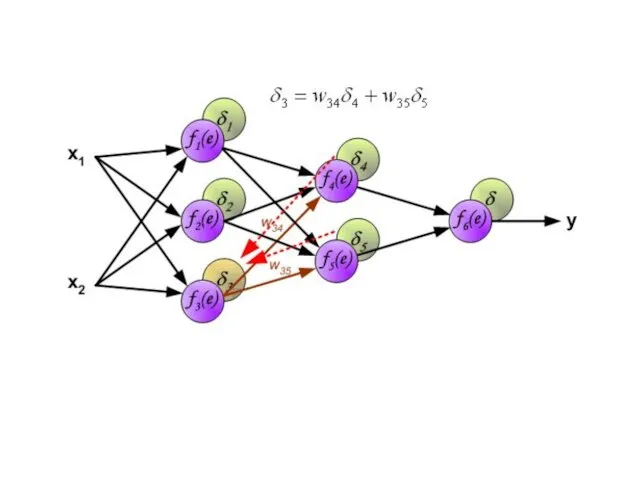

- 23. В середине восьмидесятых годов был разработан алгоритм обратного распространения ошибки. Идея заключается в распространении сигнала ошибки

- 26. Весовые коэффициенты Wmn, используемые для обратного распространения ошибки, равны тем же коэффициентам, что использовались во время

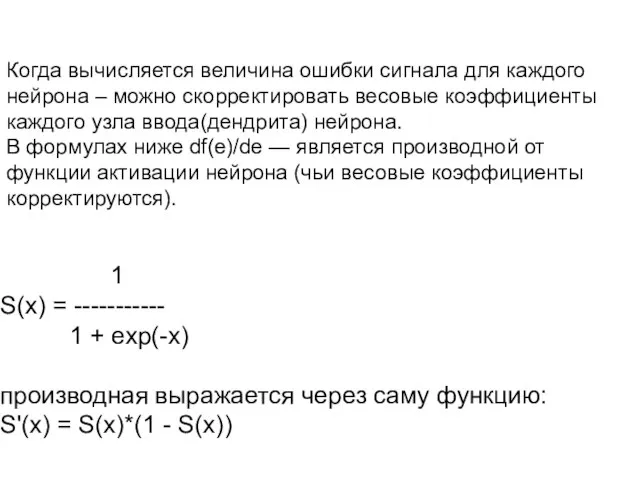

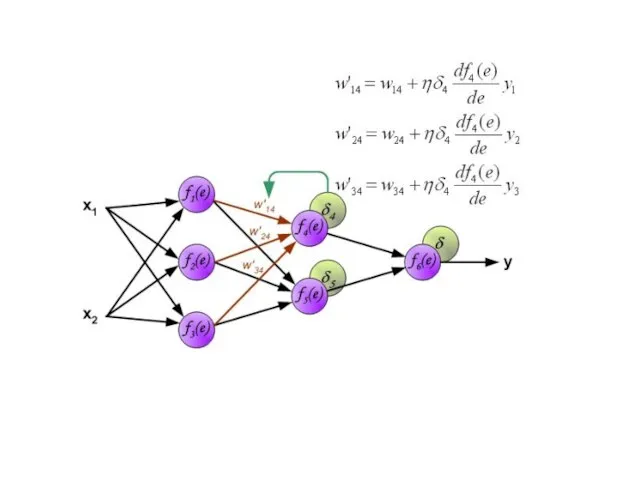

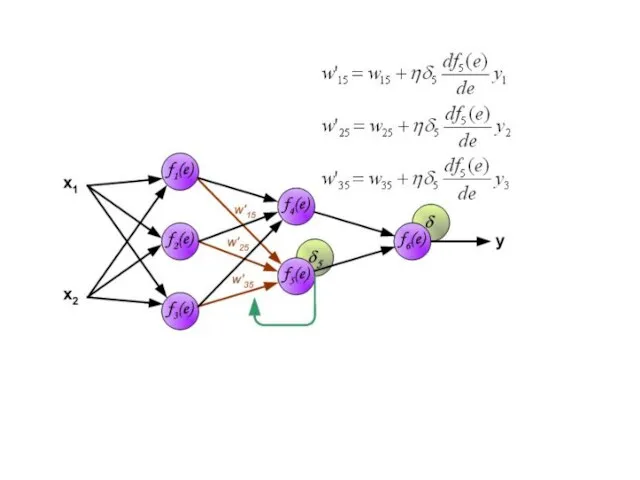

- 30. Когда вычисляется величина ошибки сигнала для каждого нейрона – можно скорректировать весовые коэффициенты каждого узла ввода(дендрита)

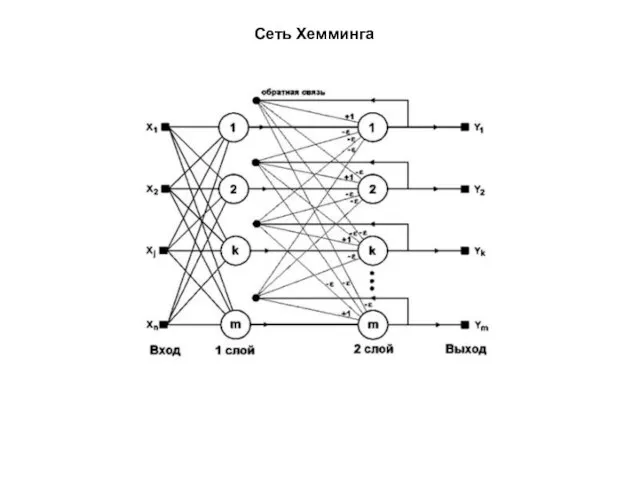

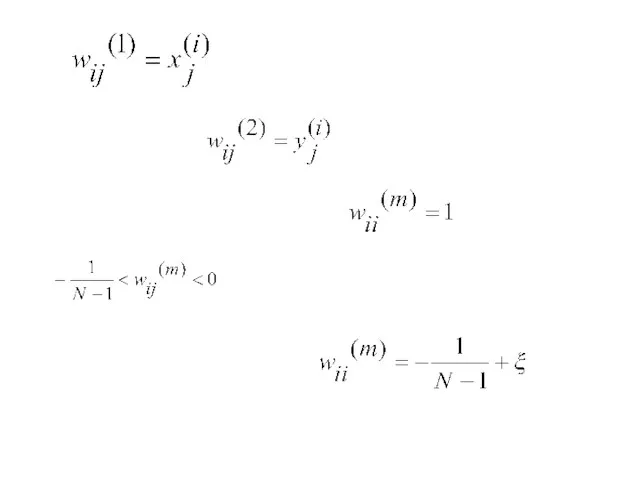

- 37. Сеть Хемминга

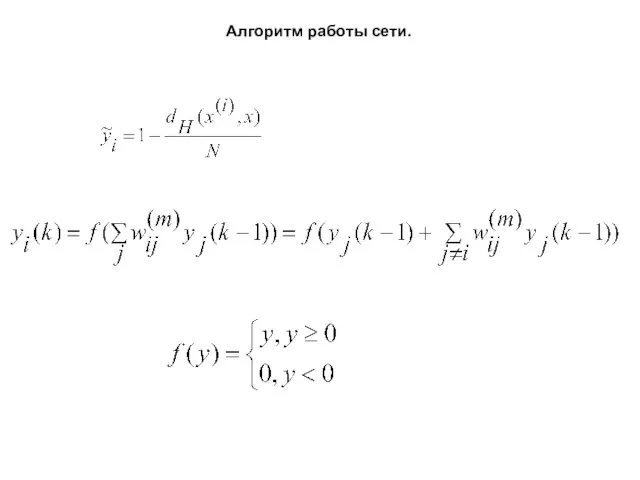

- 39. Алгоритм работы сети.

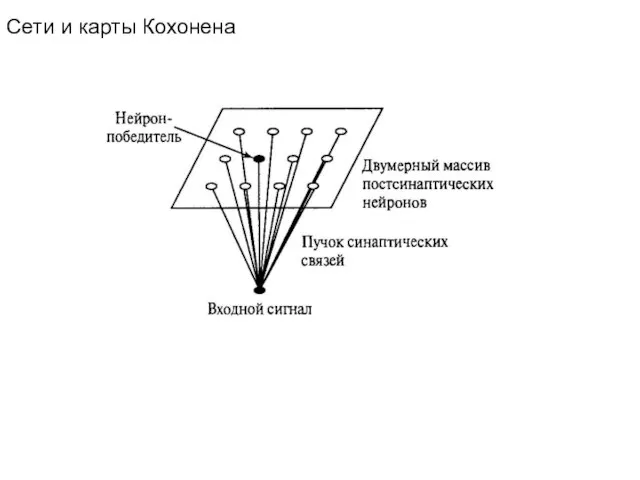

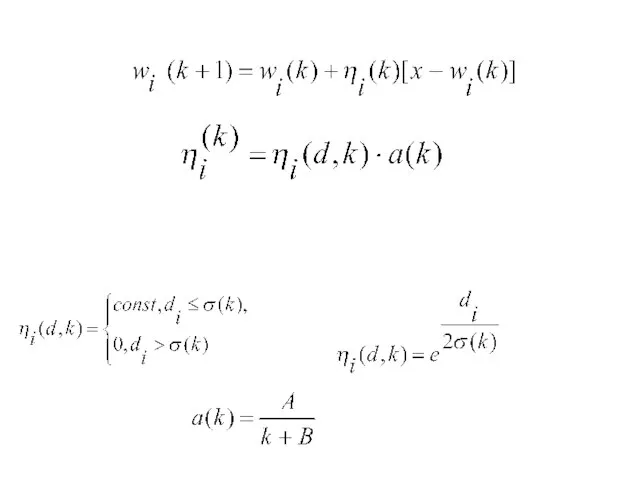

- 40. Сети и карты Кохонена

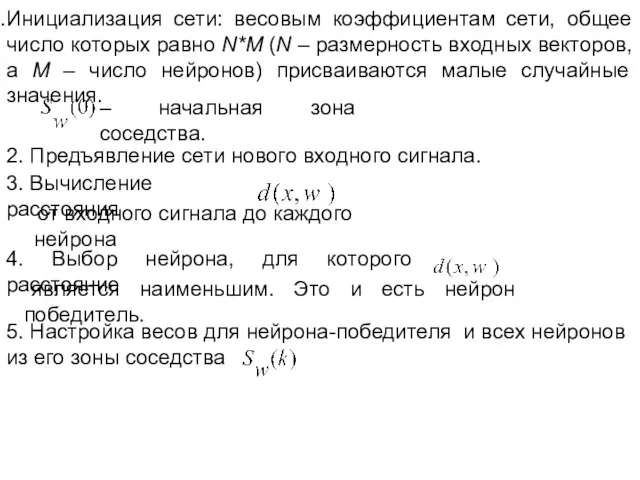

- 43. Инициализация сети: весовым коэффициентам сети, общее число которых равно N*M (N – размерность входных векторов, а

- 45. Скачать презентацию

Презентация "MSC.Mvision - 09-1" - скачать презентации по Информатике

Презентация "MSC.Mvision - 09-1" - скачать презентации по Информатике Представление об организации баз данных и системах управления базами данных

Представление об организации баз данных и системах управления базами данных Расширенная модель TAKE-GRANT

Расширенная модель TAKE-GRANT If операторы. Ішкі If операторы, If else, If switch операторлары,ішкі switch

If операторы. Ішкі If операторы, If else, If switch операторлары,ішкі switch Графическая модель издания. Часть 2

Графическая модель издания. Часть 2 Функциональные объекты. Работа с последовательностями. (Лекцция 4)

Функциональные объекты. Работа с последовательностями. (Лекцция 4) Действия с информацией. Тест

Действия с информацией. Тест Лендинг (англ. Landing page, лендинг пейдж)

Лендинг (англ. Landing page, лендинг пейдж) Современные облачные технологии

Современные облачные технологии Ақпаратты сақтау заңдары

Ақпаратты сақтау заңдары Определить и записать физическую топологию сетей

Определить и записать физическую топологию сетей Дополненная реальность

Дополненная реальность Файловая система компьютера. Как хранится информация в компьютере

Файловая система компьютера. Как хранится информация в компьютере Котомка 10. Семейная квест-игра

Котомка 10. Семейная квест-игра История счета и систем счисления

История счета и систем счисления Сетевой архив проектно-сметной документации

Сетевой архив проектно-сметной документации Презентация по информатике на тему: «Хранение информации»

Презентация по информатике на тему: «Хранение информации»  Сайт для учителя. Пояснения и рекомендации в помощь учителю

Сайт для учителя. Пояснения и рекомендации в помощь учителю Основная идея

Основная идея Урок по информатике 9 класс Глава: Кодирование и обработка графической и мультимедийной информации Тема: Кодирование и обработка

Урок по информатике 9 класс Глава: Кодирование и обработка графической и мультимедийной информации Тема: Кодирование и обработка 7 воров твоего времени и сил

7 воров твоего времени и сил Программирование на языке Паскаль Урок Сортировка массивов

Программирование на языке Паскаль Урок Сортировка массивов Особенности психологического он-лайн консультирования родителей и педагогов в условиях дистанционного обучения

Особенности психологического он-лайн консультирования родителей и педагогов в условиях дистанционного обучения Презентация "Моделирование. Информационные модели" - скачать презентации по Информатике

Презентация "Моделирование. Информационные модели" - скачать презентации по Информатике Виды компьютеров

Виды компьютеров Теоретико-графовые модели данных. Иерархическая, сетевая, реляционная и постреляционная модели

Теоретико-графовые модели данных. Иерархическая, сетевая, реляционная и постреляционная модели Цифровой дневник Проект Жилой дом

Цифровой дневник Проект Жилой дом Логические основы устройства компьютера. Базовые логические элементы

Логические основы устройства компьютера. Базовые логические элементы