Содержание

- 2. Центры обработки данных (ЦОД)

- 3. Виртуализaция — предоставление набора вычислительных ресурсов или их логического объединения, абстрагированное от аппаратной реализации, и обеспечивающее

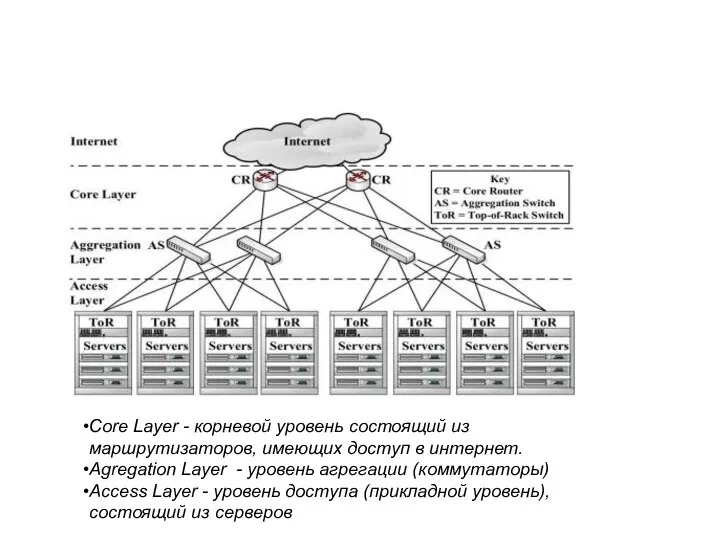

- 4. Сore Layer - корневой уровень состоящий из маршрутизаторов, имеющих доступ в интернет. Agregation Layer - уровень

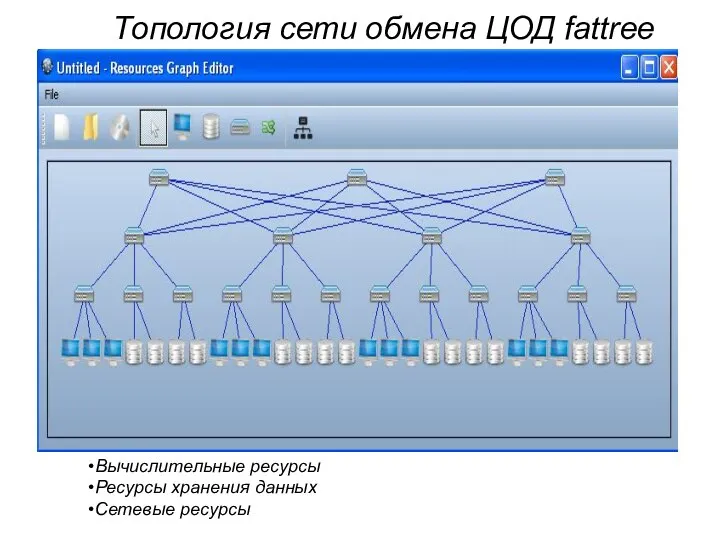

- 5. Топология сети обмена ЦОД fattree Вычислительные ресурсы Ресурсы хранения данных Сетевые ресурсы

- 6. Характеристики физических ресурсов Вычислительные узлы: , , , ; Хранилища данных: , ; Коммутационные элементы и

- 7. Типы виртуальных ресурсов Виртуальная машина (сервер). Виртуальная система хранения данных. Виртуальная не администрируемая сеть. Виртуальная администрируемая

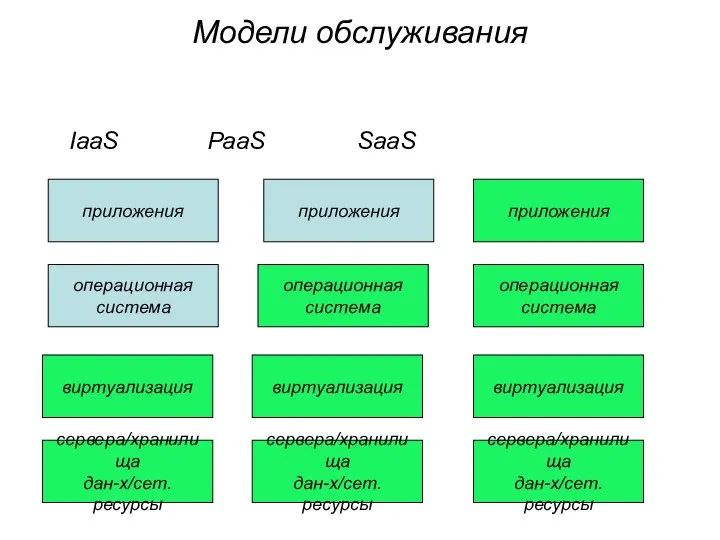

- 8. Модели обслуживания SaaS (Software-as-a-Service) – программное обеспечение как услуга. PaaS (Platform-as-a-Service) – платформа как услуга. IaaS

- 9. Модель SaaS Преимущества: с точки зрения потребителя отсутствует необходимости установки ПО на рабочих местах пользователей —

- 10. Модель PaaS Премущества: У поставщика нет необходимости приобретать оборудование и программное обеспечение для разработки. Весь перечень

- 11. Модель IaaS Данная модель обладает наибольшей гибкостью. Потребителю предоставляется свобода в пользовании системы, поставщиком определяется только

- 12. Модели обслуживания IaaS PaaS SaaS приложения приложения приложения операционная система операционная система операционная система виртуализация виртуализация

- 13. Модели обслуживания SaaS (Software-as-a-Service) – программное обеспечение как услуга. PaaS (Platform-as-a-Service) – платформа как услуга. IaaS

- 14. Функционирование ЦОД Облачная платформа –совокупность программ, которые управляют ресурсами центра обработки данных Менеджер виртуальной инфраструктуры Планировщик

- 15. Жизненный цикл виртуального ресурса Создание запроса на выделение ресурсов ЦОД (пользователь). Построение отображения запросов на физические

- 16. Соглашения об уровне обслуживания (Service Level Agreement (SLA)) Гарантированные SLA – выполнение соглашений о качестве сервиса

- 17. Методы повышения эффективности использования ресурсов ЦОД . Аппаратные решения. Программные решения: Повышение качества работы планировщиков ресурсов.

- 18. Алгоритмы отображения запросов на физические ресурсы ЦОД Алгоритмы используются в планировщиках облачных платформ.

- 19. Планировщик ресурсов для облачных платформ Планировщик определяет, какие элементы запроса на получение ресурсов на каких физических

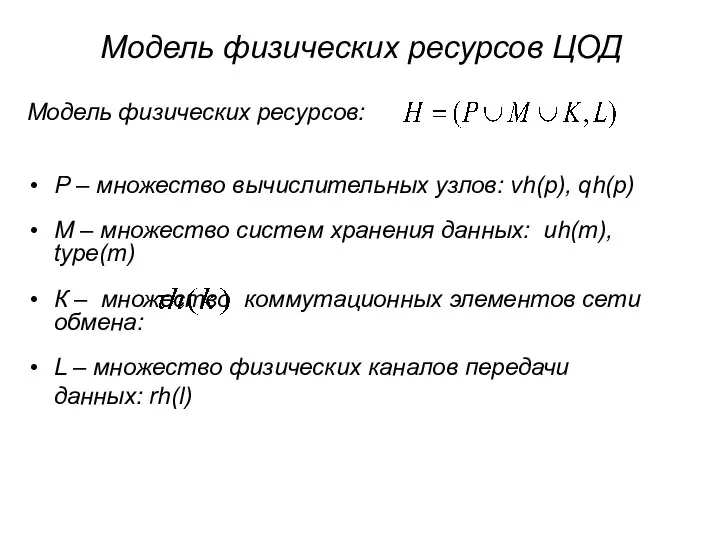

- 20. Модель физических ресурсов ЦОД Модель физических ресурсов: Р – множество вычислительных узлов: vh(p), qh(p) М –

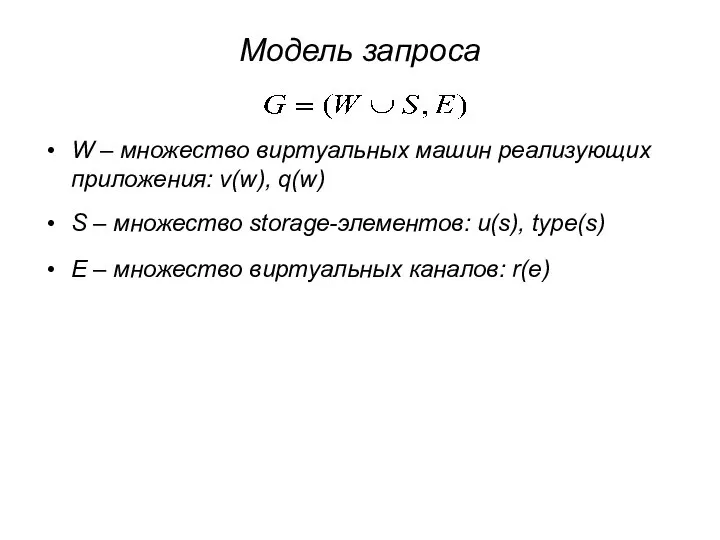

- 21. Модель запроса W – множество виртуальных машин реализующих приложения: v(w), q(w) S – множество storage-элементов: u(s),

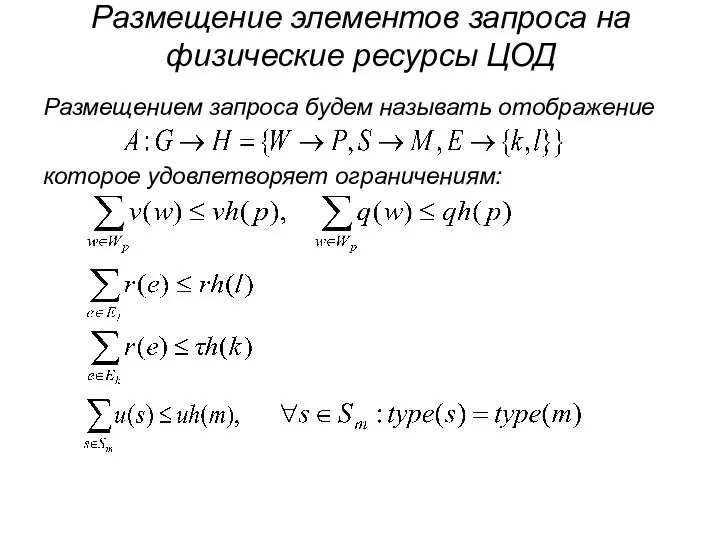

- 22. Размещение элементов запроса на физические ресурсы ЦОД Размещением запроса будем называть отображение которое удовлетворяет ограничениям:

- 23. Политики размещения Две виртуальных машины должны быть размещены на разных серверах . Это может потребоваться для

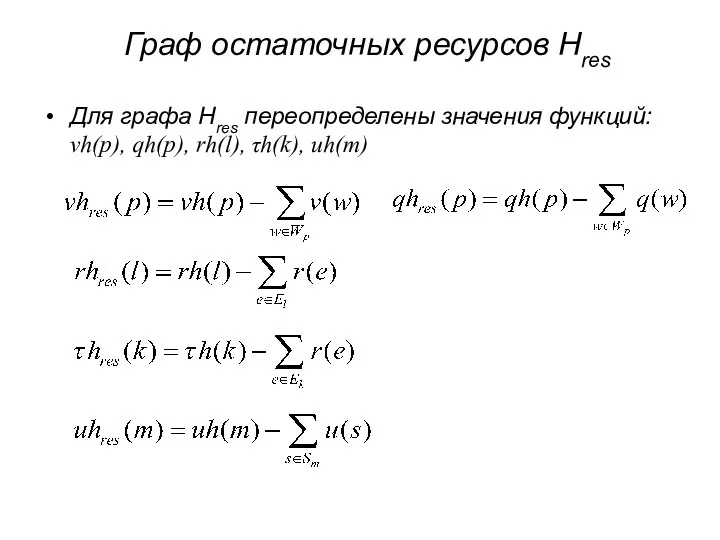

- 24. Граф остаточных ресурсов Hres Для графа Hres переопределены значения функций: vh(p), qh(p), rh(l), τh(k), uh(m)

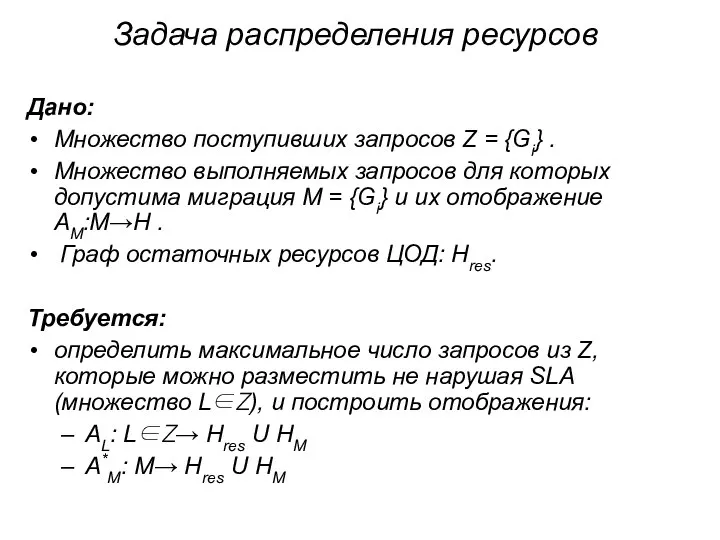

- 25. Задача распределения ресурсов Дано: Множество поступивших запросов Z = {Gi} . Множество выполняемых запросов для которых

- 26. Эффективность эксплуатации ЦОД Загрузка физических ресурсов. Процент размещенных запросов на создание виртуальных сетей из исходно поступивших.

- 27. Производительность виртуальных машин. Коэффициенты вариации: Производительность CPU (утилита Ubench) — 24 %. Скорость оперативной памяти (утилита

- 28. Производительность виртуальных машин. Причины: Гетерогенная инфраструктура физических ресурсов ЦОД. Виртуальные машины могут размещаться на серверах с

- 29. Фрагментация ресурсов ЦОД 4 3 5 2 3 5 2 4 4 1 1 R1 R2

- 30. Миграция ВМ Основные критерии, по которым сравнивают различные схемы миграции: Промежуток времени, после которого сервер-источник освободится

- 31. Миграция ВМ Приостановленная виртуальная машина (suspended): состояние всех работающих приложений сохраняется, ВМ переходит в «приостановленное» состояние

- 32. Миграция ВМ Этапы «живой» миграции: Передача состояния процессора. Передача состояния оперативной памяти. Передача содержимого внешнего диска

- 33. Миграция ВМ Схема организации «живой» миграциии Pre-Copy. Оперативная память копируется с сервера-источника на сервер-получатель итерациями. ВМ

- 34. Миграция ВМ Схема организации «живой» миграции Post-Copy. Копируется состояние процессора на сервер-получатель. Далее ВМ в процессе

- 35. Миграция ВМ Scatter-Gather «живая» миграция. Основана на Post-Copy схеме. В схеме Scatter-Gather используются посредники. Сначала ВМ

- 36. АРХИТЕКТУРЫ ВС РВ

- 37. ИУС самолета F-22

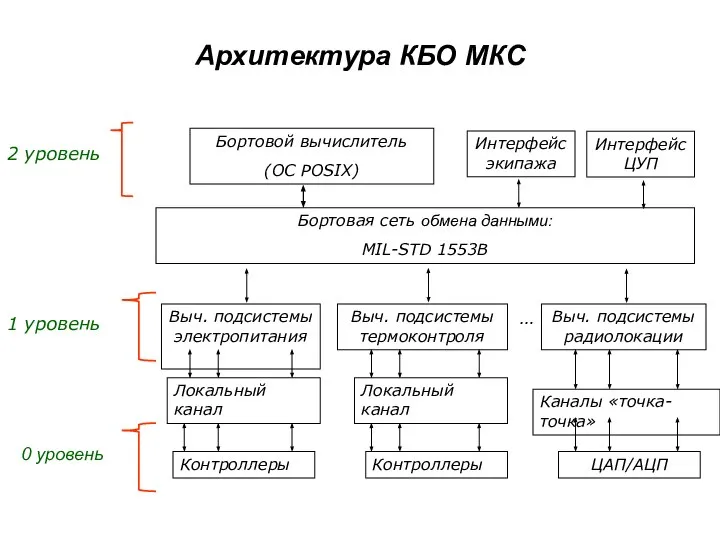

- 39. Архитектура КБО МКС Бортовой вычислитель (ОС POSIX) Интерфейс экипажа Интерфейс ЦУП Бортовая сеть обмена данными: MIL-STD

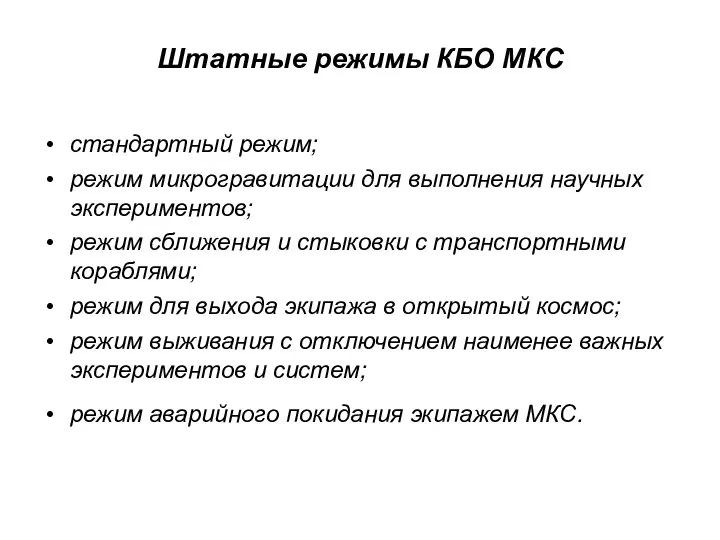

- 40. Штатные режимы КБО МКС стандартный режим; режим микрогравитации для выполнения научных экспериментов; режим сближения и стыковки

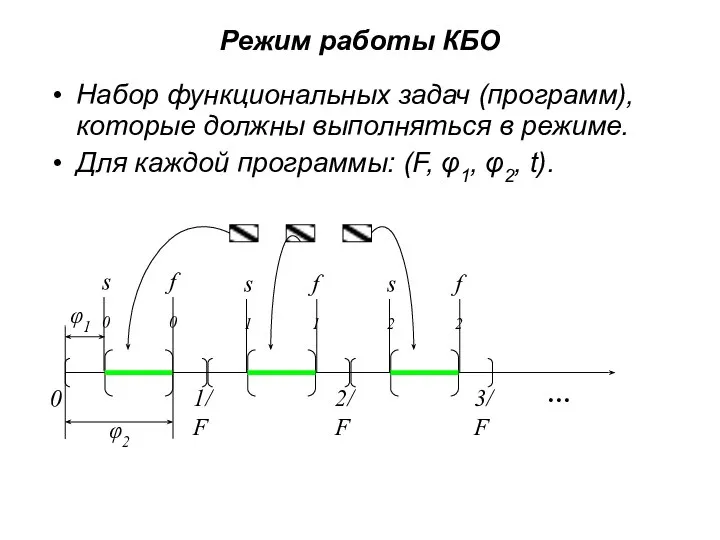

- 41. Режим работы КБО Набор функциональных задач (программ), которые должны выполняться в режиме. Для каждой программы: (F,

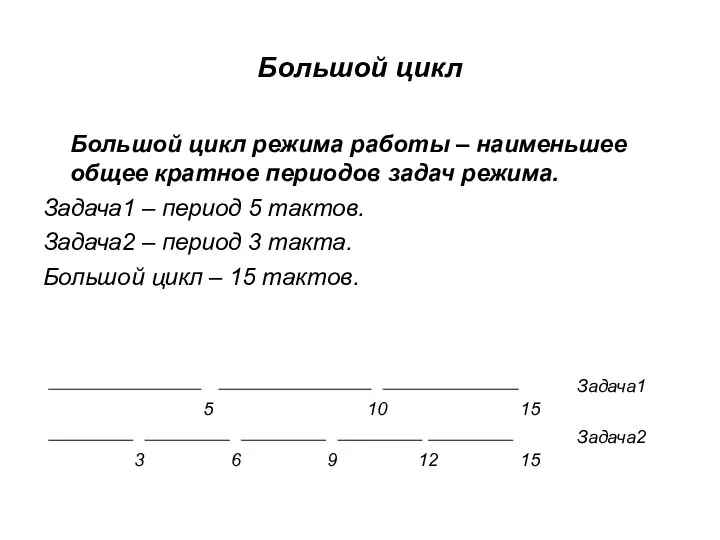

- 42. Большой цикл Большой цикл режима работы – наименьшее общее кратное периодов задач режима. Задача1 – период

- 43. Цель разработки новых архитектур и технологий построения КБО Сокращения сроков и стоимости проектирования. Уменьшение аппаратных затрат

- 44. ИМА (подходы к достижению целей) Унификация аппаратных и программных компонентов комплекса. Перенос программ первичной обработки информации

- 45. Стандарты ИМА ARINC 651 – основные принципы построения систем на основе ИМА. ARINC 653 – спецификация

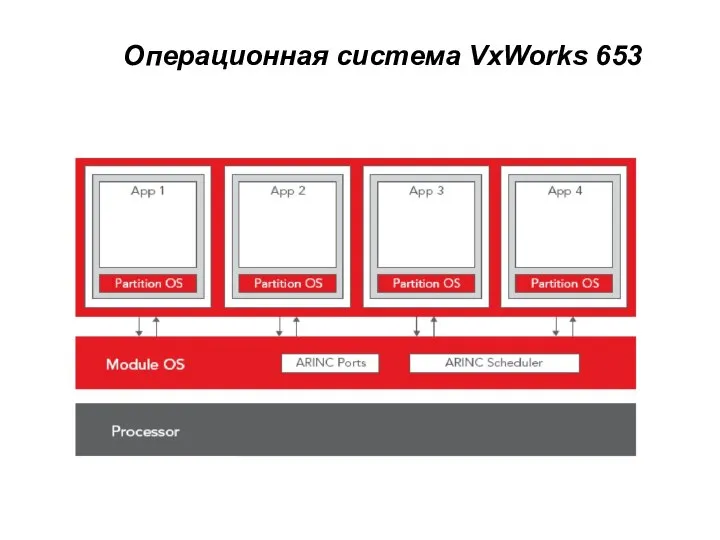

- 46. Операционная система VxWorks 653

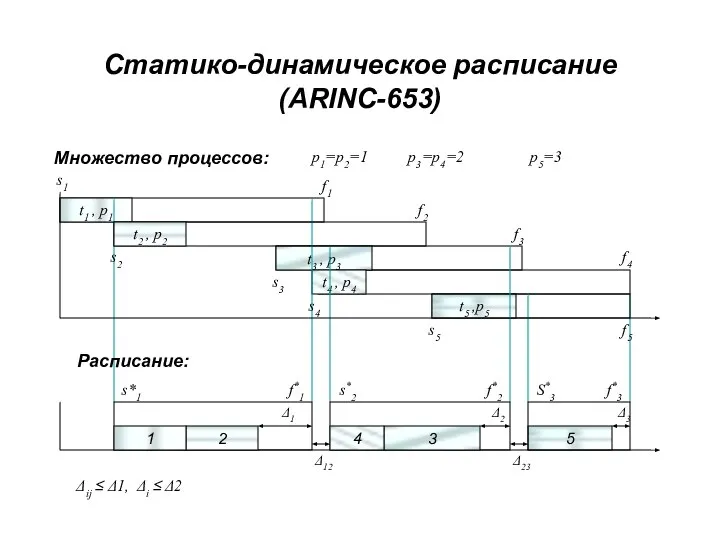

- 47. t1 , p1 t5 ,p5 t3 , p3 t4 , p4 Статико-динамическое расписание (ARINC-653) t2 ,

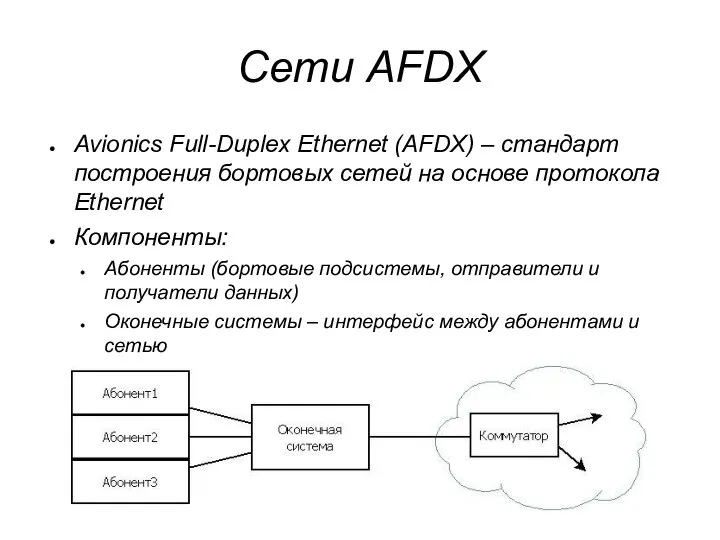

- 48. Сети AFDX Avionics Full-Duplex Ethernet (AFDX) – стандарт построения бортовых сетей на основе протокола Ethernet Компоненты:

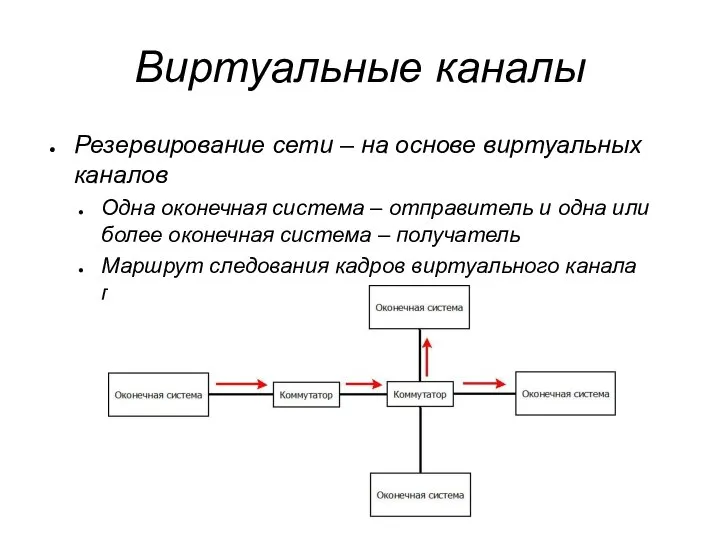

- 49. Виртуальные каналы Резервирование сети – на основе виртуальных каналов Одна оконечная система – отправитель и одна

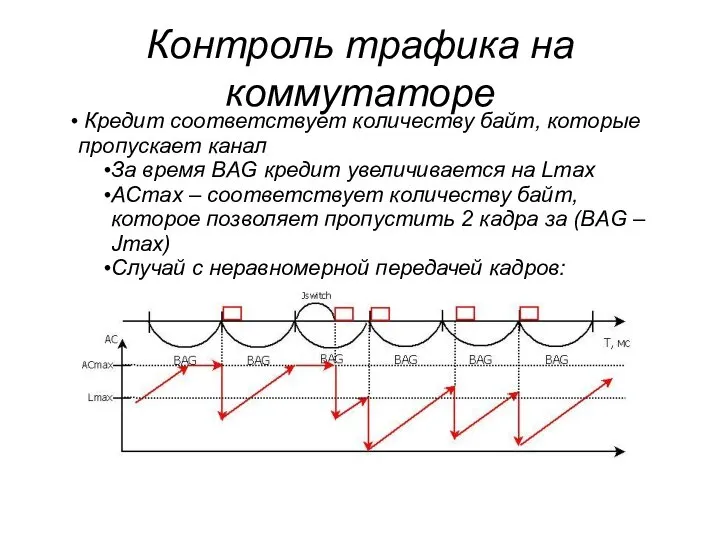

- 50. Контроль трафика на коммутаторе Контроль прихода кадров на соответствие BAG и Jmax: Производится на входном порту

- 51. Контроль трафика на коммутаторе Кредит соответствует количеству байт, которые пропускает канал За время BAG кредит увеличивается

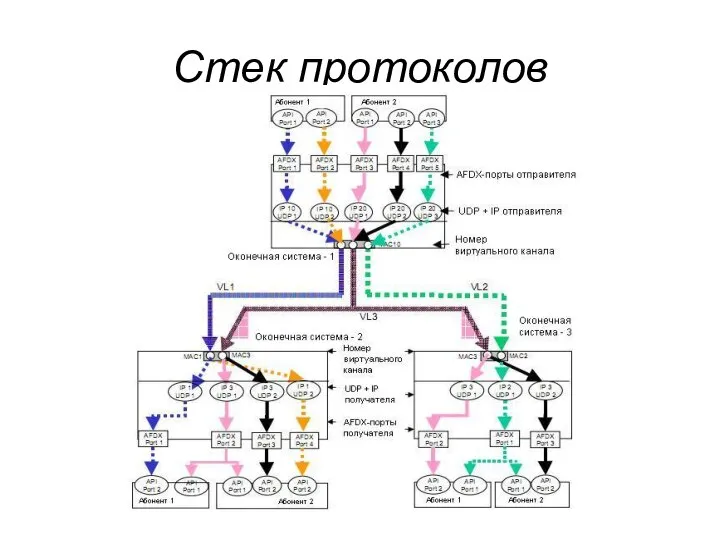

- 52. Стек протоколов

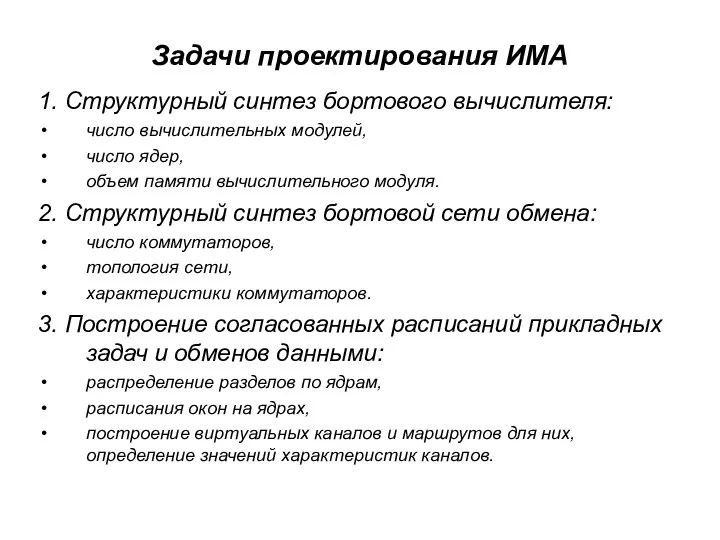

- 53. Задачи проектирования ИМА 1. Структурный синтез бортового вычислителя: число вычислительных модулей, число ядер, объем памяти вычислительного

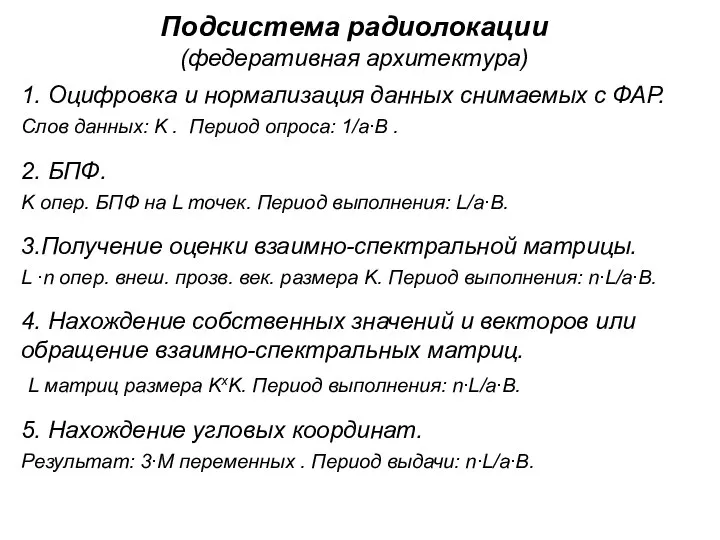

- 54. Подсистема радиолокации (федеративная архитектура) 1. Оцифровка и нормализация данных снимаемых с ФАР. Слов данных: K .

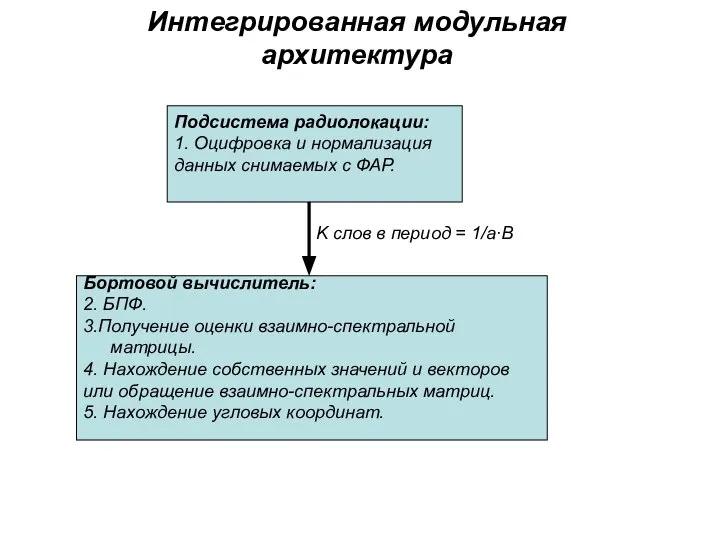

- 55. Интегрированная модульная архитектура Подсистема радиолокации: 1. Оцифровка и нормализация данных снимаемых с ФАР. Бортовой вычислитель: 2.

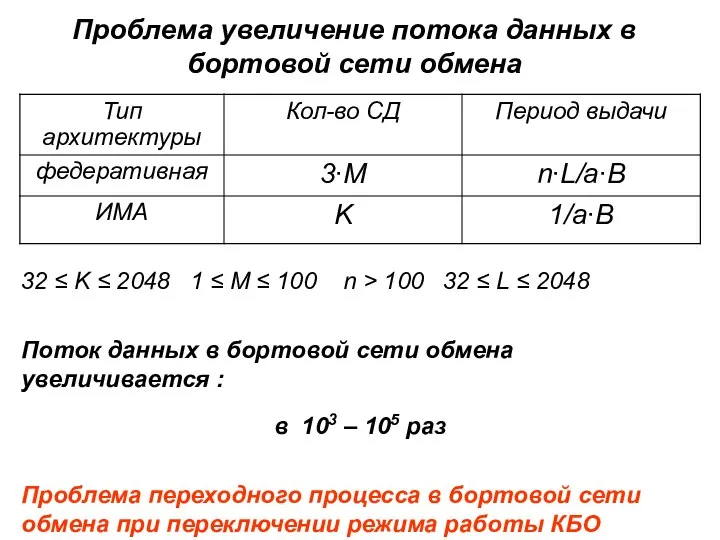

- 56. Проблема увеличение потока данных в бортовой сети обмена 32 ≤ K ≤ 2048 1 ≤ M

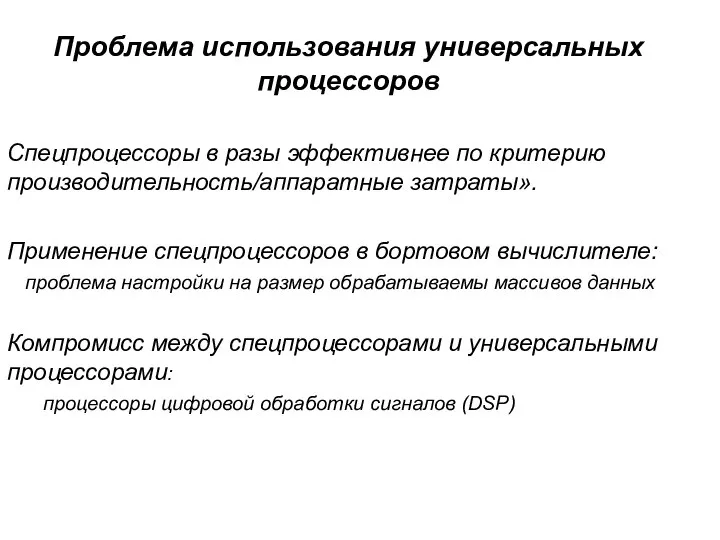

- 57. Проблема использования универсальных процессоров Спецпроцессоры в разы эффективнее по критерию производительность/аппаратные затраты». Применение спецпроцессоров в бортовом

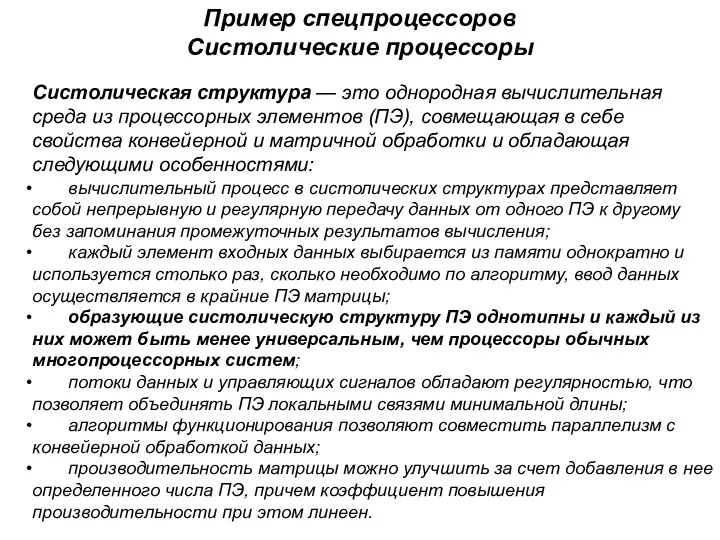

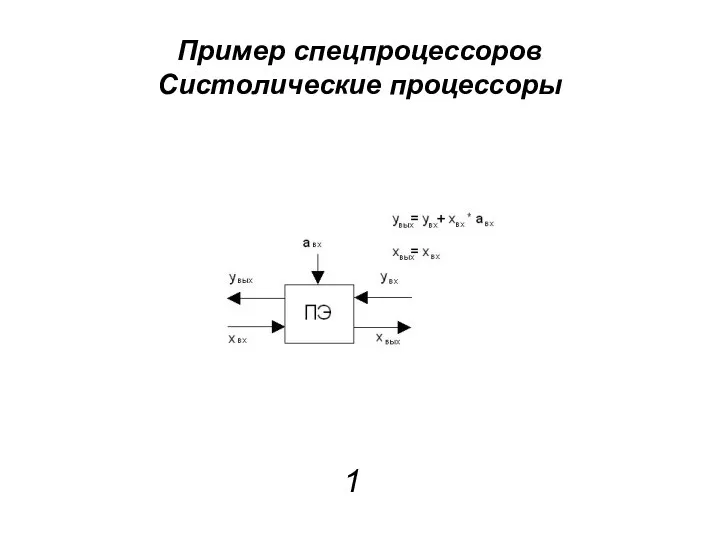

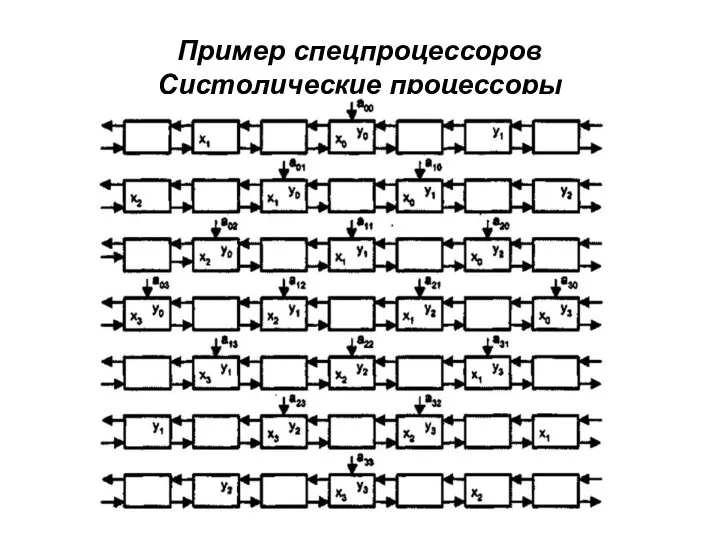

- 58. Пример спецпроцессоров Систолические процессоры Систолическая структура — это однородная вычислительная среда из процессорных элементов (ПЭ), совмещающая

- 59. Пример спецпроцессоров Систолические процессоры 1

- 60. Пример спецпроцессоров Систолические процессоры 1

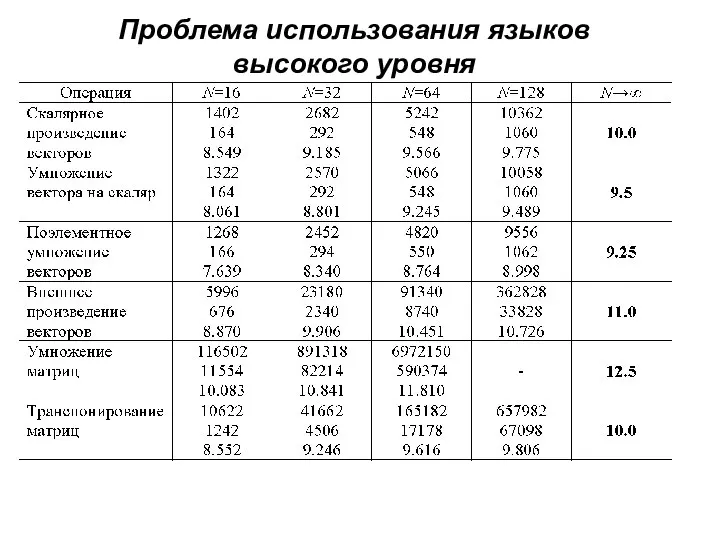

- 61. Проблема использования языков высокого уровня

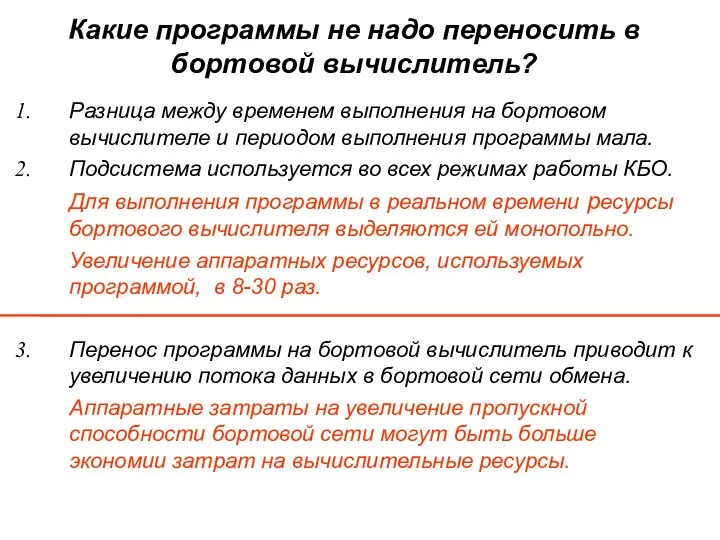

- 62. Какие программы не надо переносить в бортовой вычислитель? Разница между временем выполнения на бортовом вычислителе и

- 63. Развитие концепции ИМА Разработка аппаратно и программно масштабируемых спецпроцессоров работающих под ОС удовлетворяющей ARINC 653. Повышение

- 65. Скачать презентацию

Личный кабинет Platon Agent

Личный кабинет Platon Agent Информационные процессы

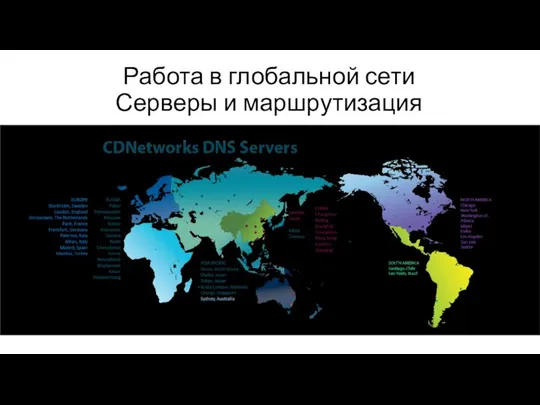

Информационные процессы Работа в глобальной сети. Серверы и маршрутизация

Работа в глобальной сети. Серверы и маршрутизация Презентация "Устройство ввода и вывода информации" - скачать презентации по Информатике

Презентация "Устройство ввода и вывода информации" - скачать презентации по Информатике Модели. Тема урока: Табличные модели.

Модели. Тема урока: Табличные модели. Тема 4. Виды информационных технологий По дисциплине: «Информационные технологии в коммерческой деятельности»

Тема 4. Виды информационных технологий По дисциплине: «Информационные технологии в коммерческой деятельности» Массивы

Массивы  Системы счисления. Перевод чисел из одной системы счисления в другую

Системы счисления. Перевод чисел из одной системы счисления в другую Основы машинного обучения. Лекция 1

Основы машинного обучения. Лекция 1 Курс seo-копирайтинга Бамбук для панды

Курс seo-копирайтинга Бамбук для панды Методические особенности использования мобильных технологий при изучении математики

Методические особенности использования мобильных технологий при изучении математики Встраивание музыкальных файлов в презентацию

Встраивание музыкальных файлов в презентацию Программирование в компьютерных системах. Профессиональный модуль ПМ.02 Разработка и администрирование баз данных

Программирование в компьютерных системах. Профессиональный модуль ПМ.02 Разработка и администрирование баз данных Презентация "MSC.Dytran - 08" - скачать презентации по Информатике

Презентация "MSC.Dytran - 08" - скачать презентации по Информатике Структура дисциплины Информатика. Лекции. Лабораторные работы. Экзамен

Структура дисциплины Информатика. Лекции. Лабораторные работы. Экзамен Инструменты веб-разработчика

Инструменты веб-разработчика Основные сведения о программе MathCad

Основные сведения о программе MathCad Java GUI (AWT, Swing)

Java GUI (AWT, Swing) Базовые понятия Internet. Лекция 2

Базовые понятия Internet. Лекция 2 Наибольшая единица измерения количества информации

Наибольшая единица измерения количества информации Общие сведения. Назначение и применение JavaScript

Общие сведения. Назначение и применение JavaScript Электронные презентации

Электронные презентации Базы и банки данных. Раздел 1. Введение. Понятия и определения

Базы и банки данных. Раздел 1. Введение. Понятия и определения Задачи информатизации образования

Задачи информатизации образования Троянские программы и защита от них

Троянские программы и защита от них Геометрическое моделирование в графических редакторах на примере редактора Paint

Геометрическое моделирование в графических редакторах на примере редактора Paint Информация и ее свойства

Информация и ее свойства Как устроен компьютер

Как устроен компьютер