Содержание

- 2. Мера неопределенности является функцией числа исходов f(n). Свойства этой функции: f(1) = 0, поскольку при п

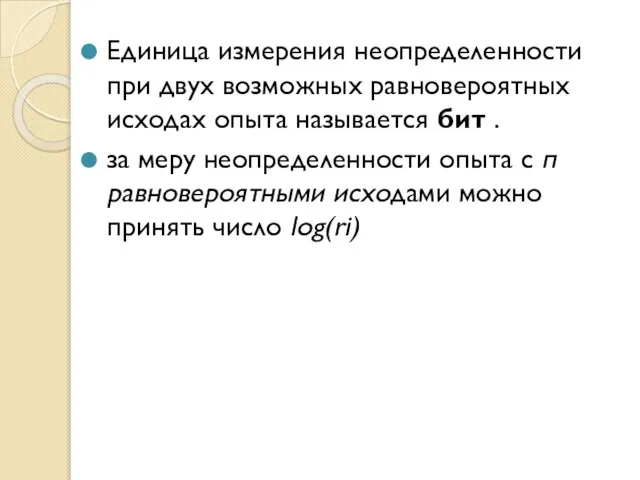

- 3. Единица измерения неопределенности при двух возможных равновероятных исходах опыта называется бит . за меру неопределенности опыта

- 4. Энтропия является мерой неопределенности опыта, в котором проявляются случайные события, и равна сред- ней неопределенности всех

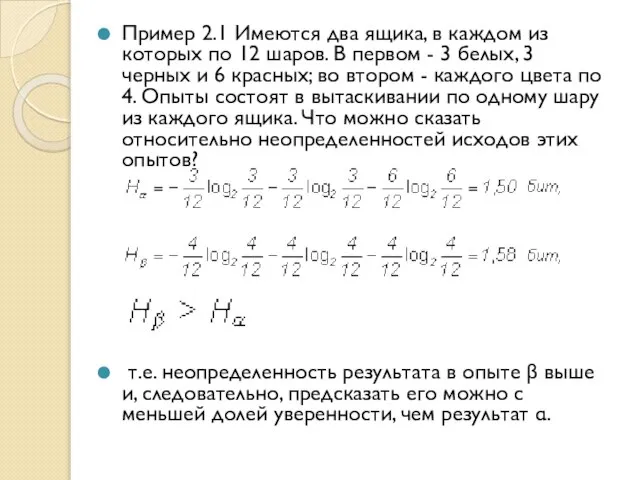

- 5. Пример 2.1 Имеются два ящика, в каждом из которых по 12 шаров. В первом - 3

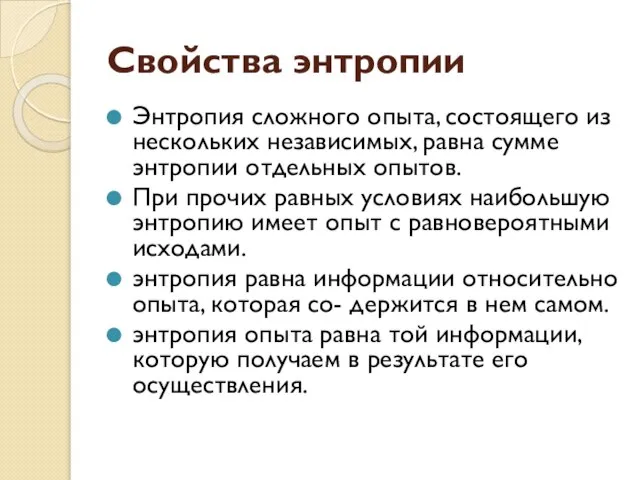

- 6. Свойства энтропии Энтропия сложного опыта, состоящего из нескольких независимых, равна сумме энтропии отдельных опытов. При прочих

- 7. Энтропия сложного опыта: Условная энтропия является величиной неотрицательной. =0 только в том случае, если любой исход

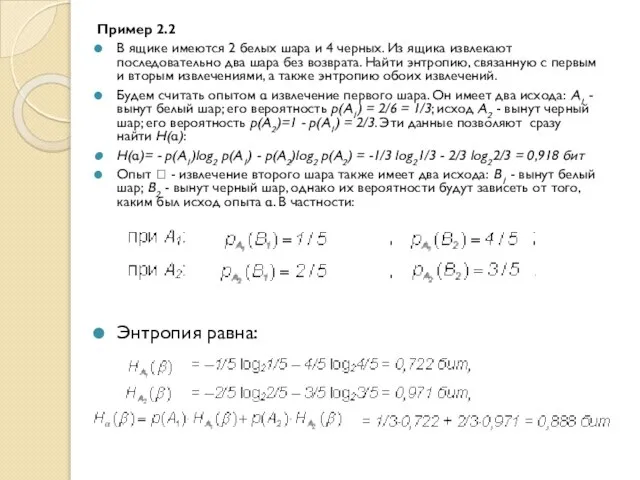

- 8. Пример 2.2 В ящике имеются 2 белых шара и 4 черных. Из ящика извлекают последовательно два

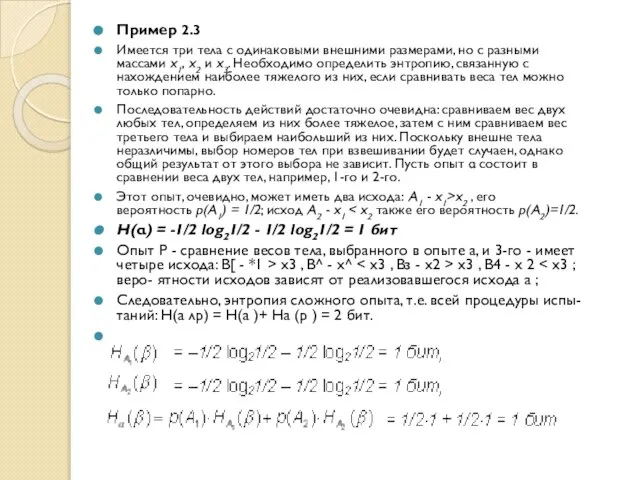

- 9. Пример 2.3 Имеется три тела с одинаковыми внешними размерами, но с разными массами x1, x2 и

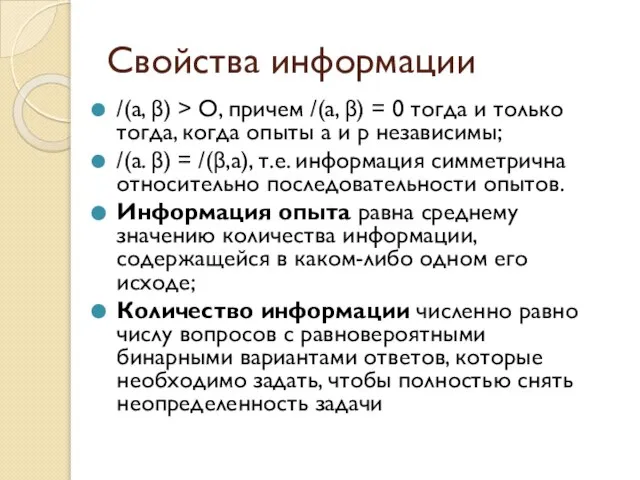

- 10. Свойства информации /(а, β) > О, причем /(а, β) = 0 тогда и только тогда, когда

- 11. Информация - это содержание сообщения, понижающего неопределенность некоторого опыта с неоднозначным исходом; убыль связанной с ним

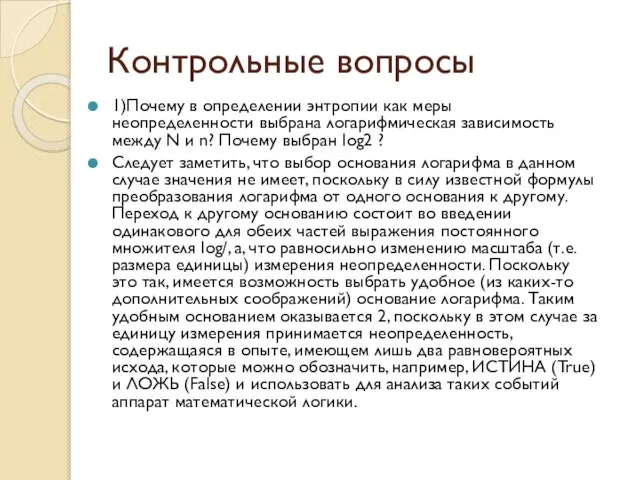

- 12. Контрольные вопросы 1)Почему в определении энтропии как меры неопределенности выбрана логарифмическая зависимость между N и n?

- 14. Скачать презентацию

Компоненты компьютера и периферийные устройства

Компоненты компьютера и периферийные устройства Символьные строки. Можно ли рассматривать строку как массив?

Символьные строки. Можно ли рассматривать строку как массив? Презентация "Системы счисления 9 класс" - скачать презентации по Информатике

Презентация "Системы счисления 9 класс" - скачать презентации по Информатике ТЕХНОЛОГИЧЕСКИЙ ПРОЦЕСС НАСТРОЙКИ ИНТЕРФЕЙСА ОПЕРАЦИОННОЙ СИСТЕМЫ ВЫПОЛНИЛ : УЧАЩИЙСЯ ГРУППЫ № 6 ЮШКОВ ВИТАЛИЙ

ТЕХНОЛОГИЧЕСКИЙ ПРОЦЕСС НАСТРОЙКИ ИНТЕРФЕЙСА ОПЕРАЦИОННОЙ СИСТЕМЫ ВЫПОЛНИЛ : УЧАЩИЙСЯ ГРУППЫ № 6 ЮШКОВ ВИТАЛИЙ Презентация к теме 15 лит-ра для 78,79 групп

Презентация к теме 15 лит-ра для 78,79 групп Информатика в станкостроении. Основы проектирования

Информатика в станкостроении. Основы проектирования Алгоритм работы с научной электронной библиотекой elibrary.ru и информационно-аналитической системой РИНЦ

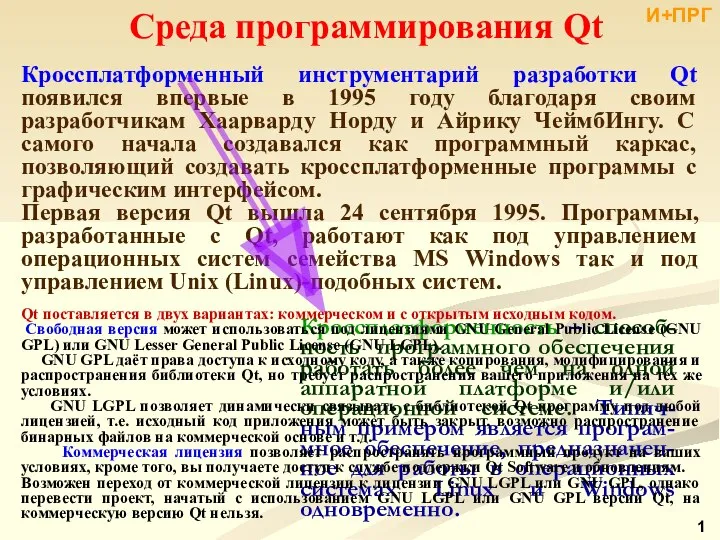

Алгоритм работы с научной электронной библиотекой elibrary.ru и информационно-аналитической системой РИНЦ Среда программирования Qt

Среда программирования Qt Модели развития глобального информационного общества

Модели развития глобального информационного общества Алгоритмические структуры

Алгоритмические структуры Презентация "Интернет" - скачать презентации по Информатике

Презентация "Интернет" - скачать презентации по Информатике Информатика и ИКТ. Урок 29

Информатика и ИКТ. Урок 29 Операционные среды, системы и оболочки. Операционные системы

Операционные среды, системы и оболочки. Операционные системы Текстовый редактор. Тестирование

Текстовый редактор. Тестирование Инструкция по заполнению временной формы электронного журнала

Инструкция по заполнению временной формы электронного журнала Формализация и Моделирование

Формализация и Моделирование Web-программирование Лекция 7. Django

Web-программирование Лекция 7. Django Медиа – конструкторы реальности

Медиа – конструкторы реальности Внеклассное мероприятие по информатике

Внеклассное мероприятие по информатике Памятка студенту по работе в портале Электронный ЮУрГУ

Памятка студенту по работе в портале Электронный ЮУрГУ Ассиметричное шифрование

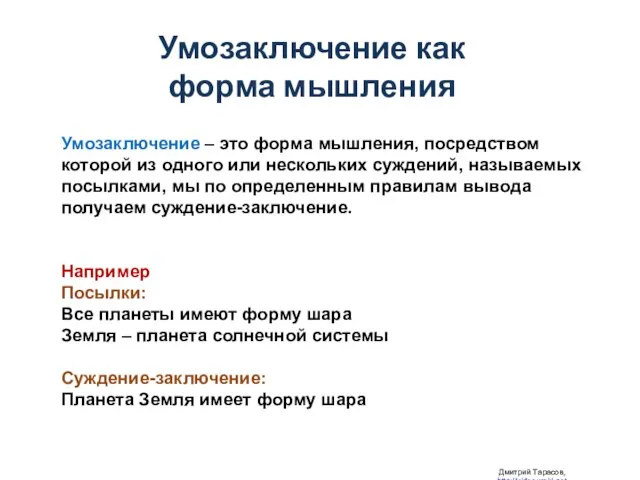

Ассиметричное шифрование Презентация "Умозаключение как форма мышления" - скачать презентации по Информатике

Презентация "Умозаключение как форма мышления" - скачать презентации по Информатике Сборка отряда в игре Genshin Impact

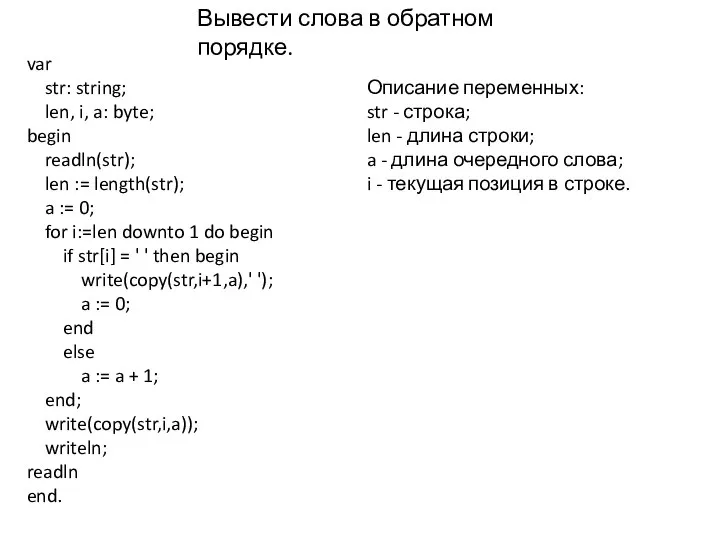

Сборка отряда в игре Genshin Impact Вывести слова в обратном порядке

Вывести слова в обратном порядке Болашақтағы ГАЖ бағдарламасы

Болашақтағы ГАЖ бағдарламасы Управление с обратной связью

Управление с обратной связью Информационный ликбез

Информационный ликбез Память компьютера

Память компьютера