- Главная

- Информатика

- Задача классификации. Метод деревьев решений

Содержание

- 2. Основные положения метода Метод деревьев решений (decision tree) для задачи классификации состоит в том, чтобы осуществлять

- 3. Дерево решений – это модель, представляющая собой совокупность правил для принятия решений. Графически её можно представить

- 4. Метод деревьев решений реализует принцип так называемого «рекурсивного деления» (recursive partitioning). Эта стратегия также называется «Разделяй

- 5. Пример В кинокомпании стол редактора завален сценариями кинофильмов, нужно разложить их по трём ящикам: Популярные («mainstream

- 6. 1) Количество снимавшихся в фильме звёзд как первый из признаков, по которому производится разбиение данных Пример

- 7. Продолжать процесс разделения данных можно и дальше, пока не получим очень «мелкое» разделение (может оказаться, что

- 8. Пример Дерево решений для классификации киносценариев Классификация сценариев лишь по 2-м факторам (количество занятых звёзд и

- 9. Численные алгоритмы метода деревьев решений, допускающие компьютерную реализацию Существуют различные численные алгоритмы построения деревьев решений: CART,

- 10. Функция оценки качества разбиения, которая используется для выбора оптимального правила, - индекс Gini . Данная оценочная

- 11. Механизм отсечения - minimal cost-complexity tree pruning, алгоритм CART принципиально отличается от других алгоритмов конструирования деревьев

- 12. Алгоритм C4.5 Алгоритм C4.5 строит дерево решений с неограниченным количеством ветвей у узла. Данный алгоритм может

- 13. Алгоритм (С5.0) автоматизированного построения дерева решений Фактически алгоритм C5.0 представляет собой стандарт процедуры построения деревьев решений.

- 14. Энтропия как мера чистоты групп Если у системы всего 2 возможных состояния, то её энтропия –

- 15. Алгоритм может выбрать тот признак, разбиение по которому даст самую чистую группу (т.е. группу, имеющую наименьшую

- 16. Может возникнуть ситуация, когда группы окажутся слишком мелкими, а точек ветвления будет слишком много – в

- 18. ЗАДАЧА КЛАССИФИКАЦИИ. ДИСКРИМИНАНТНЫЙ АНАЛИЗ Анализ данных

- 19. Дискриминантный анализ Дискриминантный анализ является разделом многомерного статистического анализа, который включает в себя методы классификации многомерных

- 20. Дискриминантный анализ – это общий термин, относящийся к нескольким тесно связанным статистическим процедурам. Эти процедуры можно

- 21. Дискриминация Основной целью дискриминации является нахождение такой линейной комбинации переменных (в дальнейшем эти переменные будем называть

- 23. Скачать презентацию

Основные положения метода

Метод деревьев решений (decision tree) для задачи классификации

Основные положения метода

Метод деревьев решений (decision tree) для задачи классификации

Примеры практических задач классификации:

• скоринговые модели кредитования;

• маркетинговые исследования, направленные на выявление предпочтений клиента или степени его удовлетворённости;

• диагностика (медицинская или техническая).

Метод деревьев решений применим для решения задач классификации, возникающих в самых разных областях, и считается одним из самых эффективных.

Дерево решений – это модель, представляющая собой совокупность правил для

Дерево решений – это модель, представляющая собой совокупность правил для

Графически её можно представить в виде древовидной структуры, где моменты принятия решений соответствуют так называемым узлам (decision nodes).

В узлах происходит ветвление процесса (branching), т.е. деление его на так называемые ветви (branches) в зависимости от сделанного выбора.

Конечные (или, терминальные) узлы называют листьями (leafs, leaf nodes), каждый лист – это конечный результат последовательного принятия решений.

Данные, подлежащие классификации, находятся в так называемом «корне» дерева (root).

В зависимости от решения, принимаемого в узлах, процесс в конце концов останавливается в одном из листьев, где переменной отклика (искомому номеру класса) присваивается то или иное значение.

Основные понятия

Метод деревьев решений реализует принцип так называемого «рекурсивного деления» (recursive

Метод деревьев решений реализует принцип так называемого «рекурсивного деления» (recursive

Эта стратегия также называется «Разделяй и властвуй» («Divide and conquer»).

В узлах, начиная с корневого, выбирается признак, значение которого используется для разбиения всех данных на 2 класса.

Процесс продолжается до тех пор, пока не выполнится критерий остановки:

Все (или почти все) данные данного узла принадлежат одному и тому же классу;

Не осталось признаков, по которым можно построить новое разбиение;

Дерево превысило заранее заданный «лимит роста» (если таковой был заранее установлен).

Идея метода

Пример

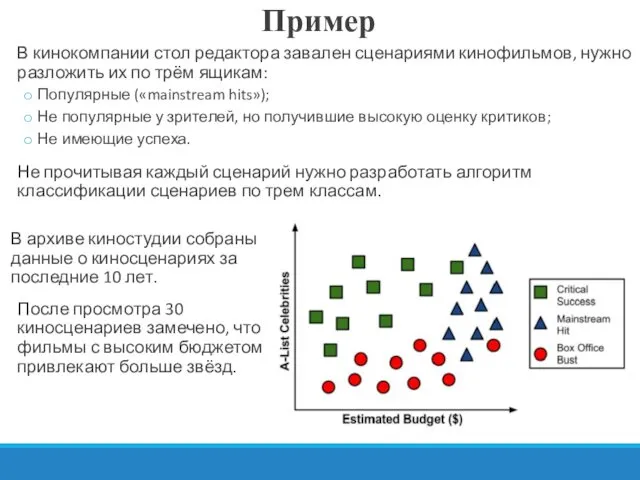

В кинокомпании стол редактора завален сценариями кинофильмов, нужно разложить их по

Пример

В кинокомпании стол редактора завален сценариями кинофильмов, нужно разложить их по

Популярные («mainstream hits»);

Не популярные у зрителей, но получившие высокую оценку критиков;

Не имеющие успеха.

Не прочитывая каждый сценарий нужно разработать алгоритм классификации сценариев по трем классам.

В архиве киностудии собраны данные о киносценариях за последние 10 лет.

После просмотра 30 киносценариев замечено, что фильмы с высоким бюджетом привлекают больше звёзд.

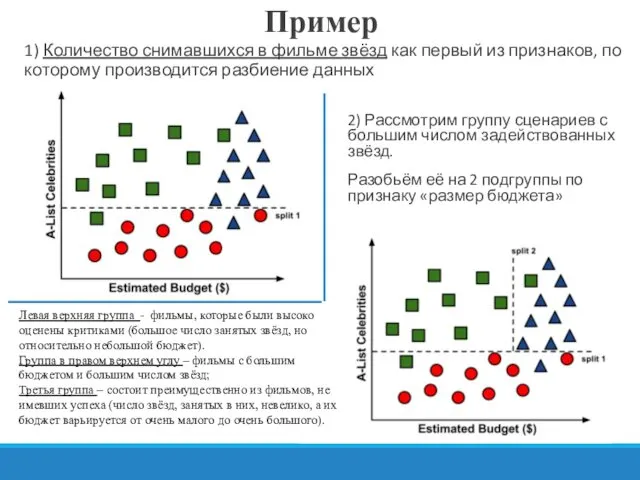

1) Количество снимавшихся в фильме звёзд как первый из признаков, по

1) Количество снимавшихся в фильме звёзд как первый из признаков, по

Пример

2) Рассмотрим группу сценариев с большим числом задействованных звёзд.

Разобьём её на 2 подгруппы по признаку «размер бюджета»

Левая верхняя группа - фильмы, которые были высоко оценены критиками (большое число занятых звёзд, но относительно небольшой бюджет).

Группа в правом верхнем углу – фильмы с большим бюджетом и большим числом звёзд;

Третья группа – состоит преимущественно из фильмов, не имевших успеха (число звёзд, занятых в них, невелико, а их бюджет варьируется от очень малого до очень большого).

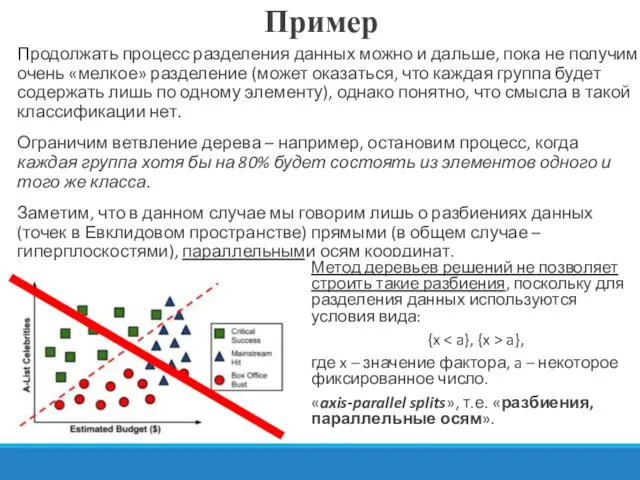

Продолжать процесс разделения данных можно и дальше, пока не получим очень

Продолжать процесс разделения данных можно и дальше, пока не получим очень

Ограничим ветвление дерева – например, остановим процесс, когда каждая группа хотя бы на 80% будет состоять из элементов одного и того же класса.

Заметим, что в данном случае мы говорим лишь о разбиениях данных (точек в Евклидовом пространстве) прямыми (в общем случае – гиперплоскостями), параллельными осям координат.

Пример

Метод деревьев решений не позволяет строить такие разбиения, поскольку для разделения данных используются условия вида:

{x < a}, {x > a},

где x – значение фактора, a – некоторое фиксированное число.

«axis-parallel splits», т.е. «разбиения, параллельные осям».

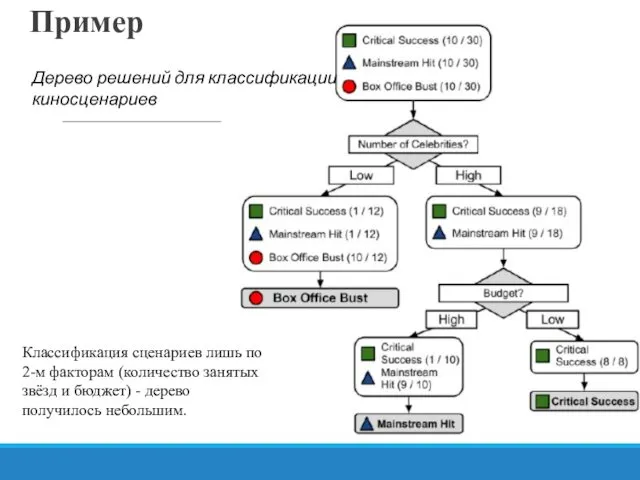

Пример

Дерево решений для классификации киносценариев

Классификация сценариев лишь по 2-м факторам

Пример

Дерево решений для классификации киносценариев

Классификация сценариев лишь по 2-м факторам

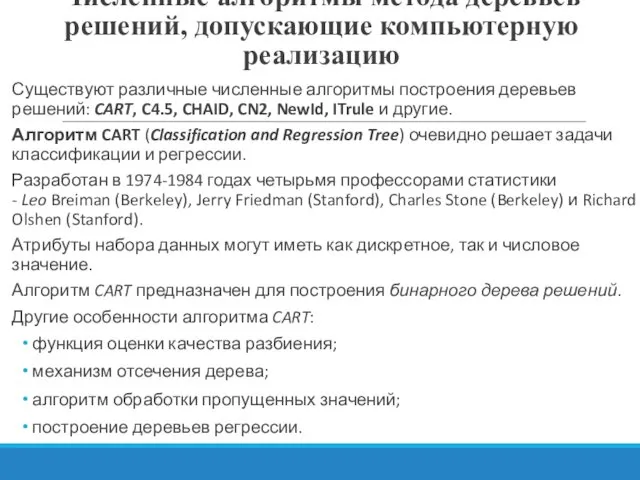

Численные алгоритмы метода деревьев решений, допускающие компьютерную реализацию

Существуют различные численные алгоритмы

Численные алгоритмы метода деревьев решений, допускающие компьютерную реализацию

Существуют различные численные алгоритмы

Алгоритм CART (Classification and Regression Tree) очевидно решает задачи классификации и регрессии.

Разработан в 1974-1984 годах четырьмя профессорами статистики - Leo Breiman (Berkeley), Jerry Friedman (Stanford), Charles Stone (Berkeley) и Richard Olshen (Stanford).

Атрибуты набора данных могут иметь как дискретное, так и числовое значение.

Алгоритм CART предназначен для построения бинарного дерева решений.

Другие особенности алгоритма CART:

функция оценки качества разбиения;

механизм отсечения дерева;

алгоритм обработки пропущенных значений;

построение деревьев регрессии.

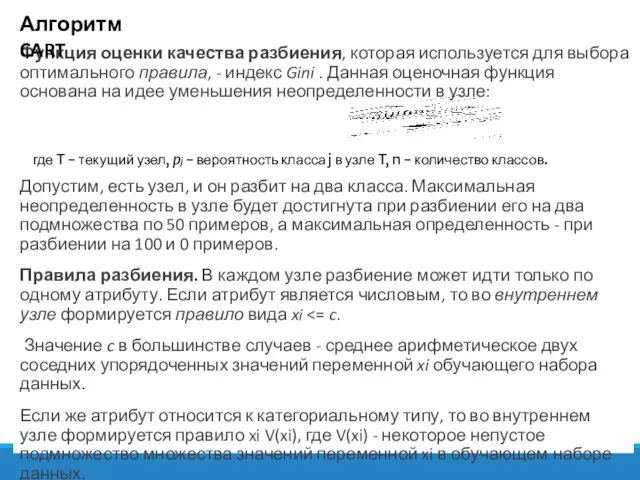

Функция оценки качества разбиения, которая используется для выбора оптимального правила, - индекс

Функция оценки качества разбиения, которая используется для выбора оптимального правила, - индекс

Допустим, есть узел, и он разбит на два класса. Максимальная неопределенность в узле будет достигнута при разбиении его на два подмножества по 50 примеров, а максимальная определенность - при разбиении на 100 и 0 примеров.

Правила разбиения. В каждом узле разбиение может идти только по одному атрибуту. Если атрибут является числовым, то во внутреннем узле формируется правило вида xi <= c.

Значение c в большинстве случаев - среднее арифметическое двух соседних упорядоченных значений переменной xi обучающего набора данных.

Если же атрибут относится к категориальному типу, то во внутреннем узле формируется правило xi V(xi), где V(xi) - некоторое непустое подмножество множества значений переменной xi в обучающем наборе данных.

Алгоритм CART

где T - текущий узел, pj - вероятность класса j в узле T, n - количество классов.

Механизм отсечения - minimal cost-complexity tree pruning, алгоритм CART принципиально отличается от других алгоритмов конструирования

Механизм отсечения - minimal cost-complexity tree pruning, алгоритм CART принципиально отличается от других алгоритмов конструирования

В рассматриваемом алгоритме отсечение - это компромисс между получением дерева "подходящего размера" и получением наиболее точной оценки классификации.

Метод заключается в получении последовательности уменьшающихся деревьев, но деревья рассматриваются не все, а только "лучшие представители".

Перекрестная проверка (V-fold cross-validation) является наиболее сложной и одновременно оригинальной частью алгоритма CART - путь выбора окончательного дерева, при условии, что набор данных имеет небольшой объем или же записи набора данных настолько специфические, что разделить набор на обучающую и тестовую выборку не представляется возможным.

Алгоритм CART

Алгоритм C4.5

Алгоритм C4.5 строит дерево решений с неограниченным количеством ветвей у узла. Данный

Алгоритм C4.5

Алгоритм C4.5 строит дерево решений с неограниченным количеством ветвей у узла. Данный

C4.5 считается одним из самых известных и широко используемых алгоритмов построения деревьев классификации.

Для работы алгоритма C4.5 необходимо соблюдение следующих требований:

Каждая запись набора данных должна быть ассоциирована с одним из предопределенных классов, т.е. один из атрибутов набора данных должен являться меткой класса.

Классы должны быть дискретными. Каждый пример должен однозначно относиться к одному из классов.

Количество классов должно быть значительно меньше количества записей в исследуемом наборе данных.

Версия алгоритма - алгоритм C4.8 - реализована в инструменте Weka как J4.8 (Java). Коммерческая реализация метода: C5.0, разработчик RuleQuest, Австралия.

Алгоритм C4.5 медленно работает на сверхбольших и зашумленных наборах данных.

разработан Джоном Квинланом (John Ross Quinlan).

C4.5 является усовершенствованной версией алгоритма ID3 того же автора.

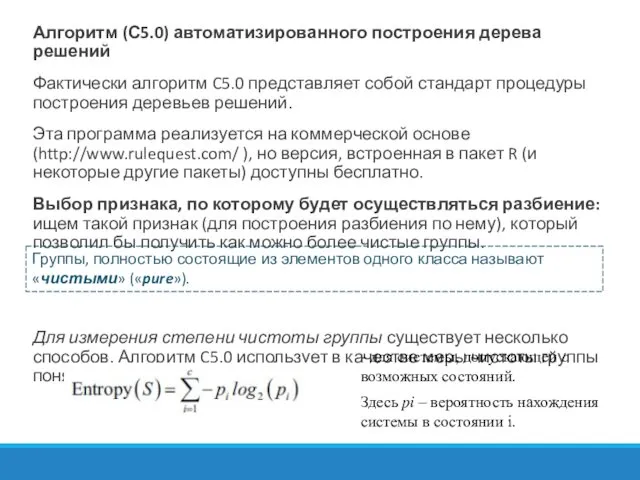

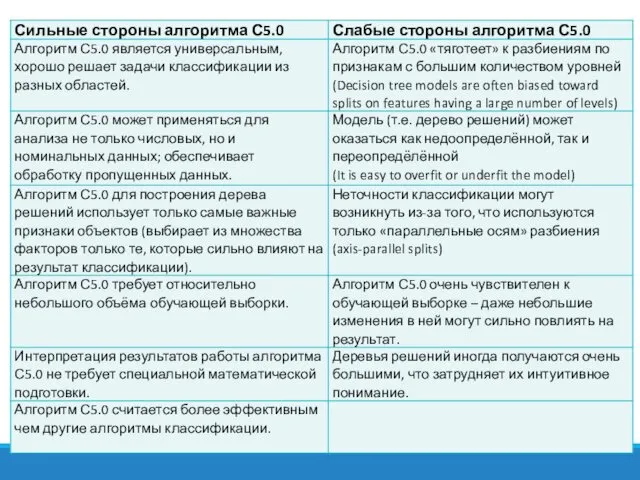

Алгоритм (С5.0) автоматизированного построения дерева решений

Фактически алгоритм C5.0 представляет собой

Алгоритм (С5.0) автоматизированного построения дерева решений

Фактически алгоритм C5.0 представляет собой

Эта программа реализуется на коммерческой основе (http://www.rulequest.com/ ), но версия, встроенная в пакет R (и некоторые другие пакеты) доступны бесплатно.

Выбор признака, по которому будет осуществляться разбиение: ищем такой признак (для построения разбиения по нему), который позволил бы получить как можно более чистые группы.

Для измерения степени чистоты группы существует несколько способов. Алгоритм C5.0 использует в качестве меры чистоты группы понятие энтропии:

- для системы, допускающей с возможных состояний.

Группы, полностью состоящие из элементов одного класса называют «чистыми» («pure»).

Здесь ?? – вероятность нахождения системы в состоянии i.

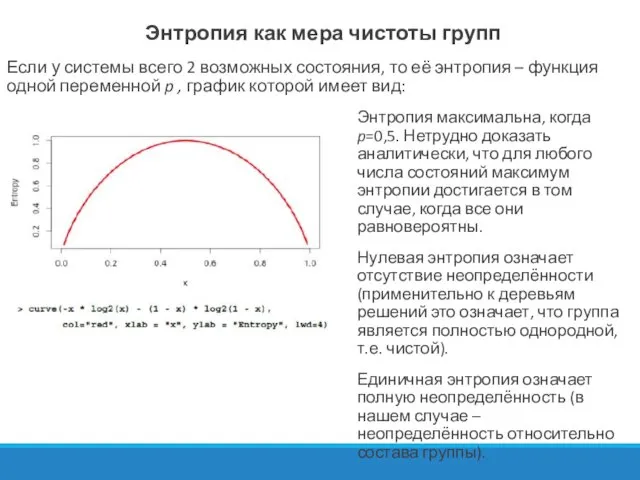

Энтропия как мера чистоты групп

Если у системы всего 2 возможных состояния,

Энтропия как мера чистоты групп

Если у системы всего 2 возможных состояния,

Энтропия максимальна, когда p=0,5. Нетрудно доказать аналитически, что для любого числа состояний максимум энтропии достигается в том случае, когда все они равновероятны.

Нулевая энтропия означает отсутствие неопределённости (применительно к деревьям решений это означает, что группа является полностью однородной, т.е. чистой).

Единичная энтропия означает полную неопределённость (в нашем случае – неопределённость относительно состава группы).

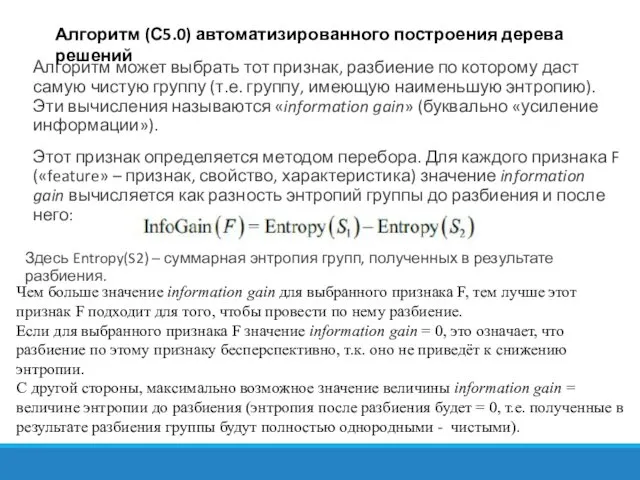

Алгоритм может выбрать тот признак, разбиение по которому даст самую чистую

Алгоритм может выбрать тот признак, разбиение по которому даст самую чистую

Этот признак определяется методом перебора. Для каждого признака F («feature» – признак, свойство, характеристика) значение information gain вычисляется как разность энтропий группы до разбиения и после него:

Алгоритм (С5.0) автоматизированного построения дерева решений

Чем больше значение information gain для выбранного признака F, тем лучше этот признак F подходит для того, чтобы провести по нему разбиение.

Если для выбранного признака F значение information gain = 0, это означает, что разбиение по этому признаку бесперспективно, т.к. оно не приведёт к снижению энтропии.

С другой стороны, максимально возможное значение величины information gain = величине энтропии до разбиения (энтропия после разбиения будет = 0, т.е. полученные в результате разбиения группы будут полностью однородными - чистыми).

Здесь Entropy(S2) – суммарная энтропия групп, полученных в результате разбиения.

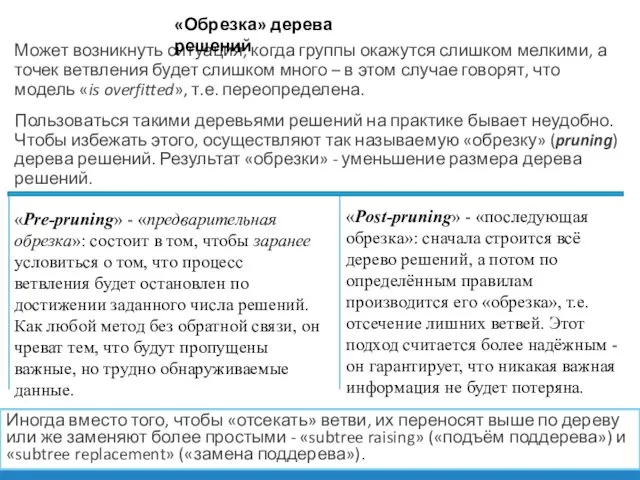

Может возникнуть ситуация, когда группы окажутся слишком мелкими, а точек ветвления

Может возникнуть ситуация, когда группы окажутся слишком мелкими, а точек ветвления

Пользоваться такими деревьями решений на практике бывает неудобно. Чтобы избежать этого, осуществляют так называемую «обрезку» (pruning) дерева решений. Результат «обрезки» - уменьшение размера дерева решений.

«Обрезка» дерева решений

«Pre-pruning» - «предварительная обрезка»: состоит в том, чтобы заранее условиться о том, что процесс ветвления будет остановлен по достижении заданного числа решений. Как любой метод без обратной связи, он чреват тем, что будут пропущены важные, но трудно обнаруживаемые данные.

«Post-pruning» - «последующая обрезка»: сначала строится всё дерево решений, а потом по определённым правилам производится его «обрезка», т.е. отсечение лишних ветвей. Этот подход считается более надёжным - он гарантирует, что никакая важная информация не будет потеряна.

Иногда вместо того, чтобы «отсекать» ветви, их переносят выше по дереву или же заменяют более простыми - «subtree raising» («подъём поддерева») и «subtree replacement» («замена поддерева»).

ЗАДАЧА КЛАССИФИКАЦИИ.

ДИСКРИМИНАНТНЫЙ АНАЛИЗ

Анализ данных

ЗАДАЧА КЛАССИФИКАЦИИ.

ДИСКРИМИНАНТНЫЙ АНАЛИЗ

Анализ данных

Дискриминантный анализ

Дискриминантный анализ является разделом многомерного статистического анализа, который включает в себя

Дискриминантный анализ

Дискриминантный анализ является разделом многомерного статистического анализа, который включает в себя

В кластерном анализе рассматриваются методы многомерной классификации без обучения.

В дискриминантном анализе новые кластеры не образуются, а формулируется правило, по которому объекты подмножества подлежащего классификации относятся к одному из уже существующих (обучающих) подмножеств (классов), на основе сравнения величины дискриминантной функции классифицируемого объекта, рассчитанной по дискриминантным переменным, с некоторой константой дискриминации.

Дискриминантный анализ – это общий термин, относящийся к нескольким тесно связанным

Дискриминантный анализ – это общий термин, относящийся к нескольким тесно связанным

Эти процедуры можно разделить на методы интерпретации межгрупповых различий – дискриминации и методы классификации наблюдений по группам.

Задачи дискриминантного анализа

Задачи первого типа – задачи дискриминации (пример – в медицинской практике).

Дискриминантный анализ

Задачи третьего типа связаны с предсказанием будущих событий на основании имеющихся данных.

Второй тип задачи относится к ситуации, когда признаки принадлежности объекта к той или иной группе потеряны, и их нужно восстановить.

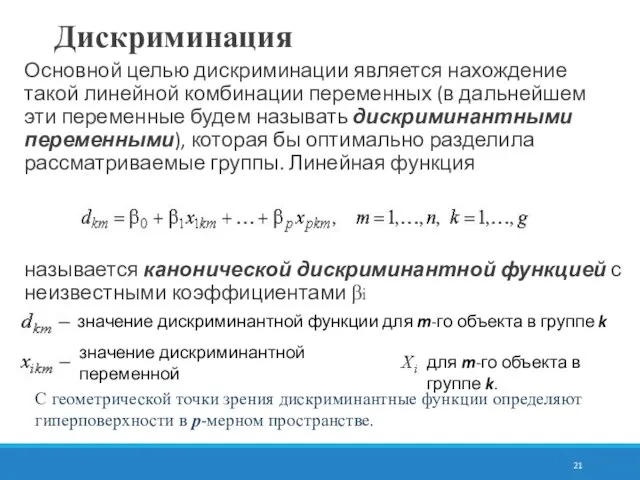

Дискриминация

Основной целью дискриминации является нахождение такой линейной комбинации переменных (в дальнейшем

Дискриминация

Основной целью дискриминации является нахождение такой линейной комбинации переменных (в дальнейшем

называется канонической дискриминантной функцией с неизвестными коэффициентами βi

значение дискриминантной функции для m-го объекта в группе k

значение дискриминантной переменной

для m-го объекта в группе k.

С геометрической точки зрения дискриминантные функции определяют гиперповерхности в p-мерном пространстве.

Истинные и ложные суждения

Истинные и ложные суждения Тест. Комп'ютерні віруси

Тест. Комп'ютерні віруси Библиографический поиск. Источники библиографического поиска

Библиографический поиск. Источники библиографического поиска Система управления базами данных. 9 класс

Система управления базами данных. 9 класс Информационные объекты различных видов. Язык как способ представления информации. Лекция 8

Информационные объекты различных видов. Язык как способ представления информации. Лекция 8 Презентация по информатике Системы Счисления

Презентация по информатике Системы Счисления  Школа глазами домашнего животного. Фотокросс

Школа глазами домашнего животного. Фотокросс WORD простейшие операции с текстом

WORD простейшие операции с текстом Проблемы безопасности детей в интернете

Проблемы безопасности детей в интернете Народная программистская мудрость

Народная программистская мудрость Защита файлов и управление доступом к ним. Борисов В.А. Красноармейский филиал ГОУ ВПО «Академия народного хозяйства при Пр

Защита файлов и управление доступом к ним. Борисов В.А. Красноармейский филиал ГОУ ВПО «Академия народного хозяйства при Пр Идут часы, и мы идем, И в этом наша суть, И каждый с временем вдвоем: Проходит весь свой путь. А. Дольский

Идут часы, и мы идем, И в этом наша суть, И каждый с временем вдвоем: Проходит весь свой путь. А. Дольский Работа в Еxcel

Работа в Еxcel Цикл for

Цикл for Браузеры

Браузеры Регистрация. ИСТИНА. Интеллектуальная система тематического исследования научно-технической информации

Регистрация. ИСТИНА. Интеллектуальная система тематического исследования научно-технической информации Информационные хранилища

Информационные хранилища Педагогические программные средства

Педагогические программные средства CATIA Generative Shape Design Update/ Обновление Модуля Расширенного Проектирования Поверхностей

CATIA Generative Shape Design Update/ Обновление Модуля Расширенного Проектирования Поверхностей Тестирование. Какое бывает тестирование

Тестирование. Какое бывает тестирование Binary Tree. Проблема поиска значений

Binary Tree. Проблема поиска значений Типология БД. Модели представления данных

Типология БД. Модели представления данных Паттерны проектирования: Шаблонный метод

Паттерны проектирования: Шаблонный метод Верстка web-страниц

Верстка web-страниц Шаги подключения к ЕСИА для упрощённой идентификации клиентов

Шаги подключения к ЕСИА для упрощённой идентификации клиентов Какие роботы присутствуют в повседневности

Какие роботы присутствуют в повседневности Инструмент заливка

Инструмент заливка ИНФОРМАТИКА И ИКТ

ИНФОРМАТИКА И ИКТ