Модели каналов передачи информации при наличии помех. Математическое описание канала передачи информации

Содержание

- 2. Модели каналов передачи информации при наличии помех Учебные вопросы Математическое описание канала связи. Взаимная информация. Пропускная

- 3. Литература 1.Вернер М. Основы кодирования − М.: Техносфера, 2004. – 288 с. 2.

- 4. Цели передачи по каналу с шумом 1. Быстрое кодирование информации. 2. Простой способ передачи закодированного сообщения.

- 5. Статистические (стохастические) каналы Переходная вероятность p(y(t)|x(t)), показывает, с какой вероятностью фиксированный входной сигнал x(t) преобразуется каналом

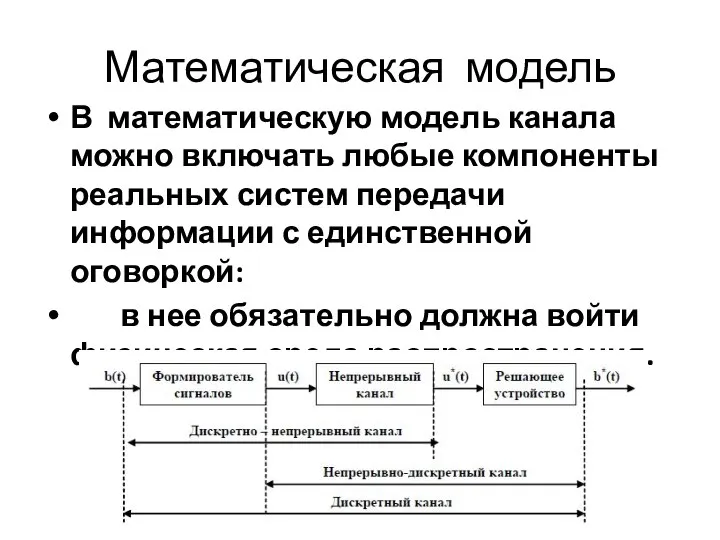

- 6. Математическая модель В математическую модель канала можно включать любые компоненты реальных систем передачи информации с единственной

- 7. Классификация каналов: Дискретные и непрерывные как по времени, так и по состоянию. Непрерывные по времени: -

- 8. Классификация каналов: Канал называется дискретным по состоянию, если входное и выходное колебания принадлежат дискретному (конечному или

- 9. Канал без памяти Отклик на входное воздействие не зависит от значения воздействия в предыдущий момент времени.

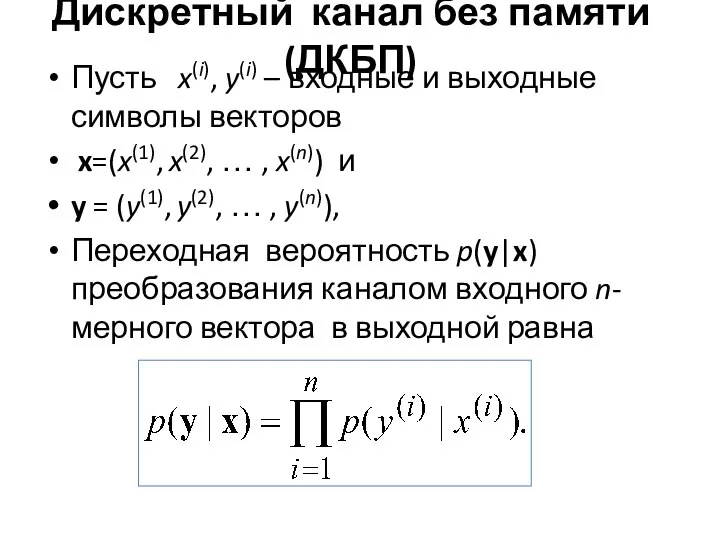

- 10. Дискретный канал без памяти (ДКБП) Пусть x(i), y(i) – входные и выходные символы векторов x=(x(1), x(2),

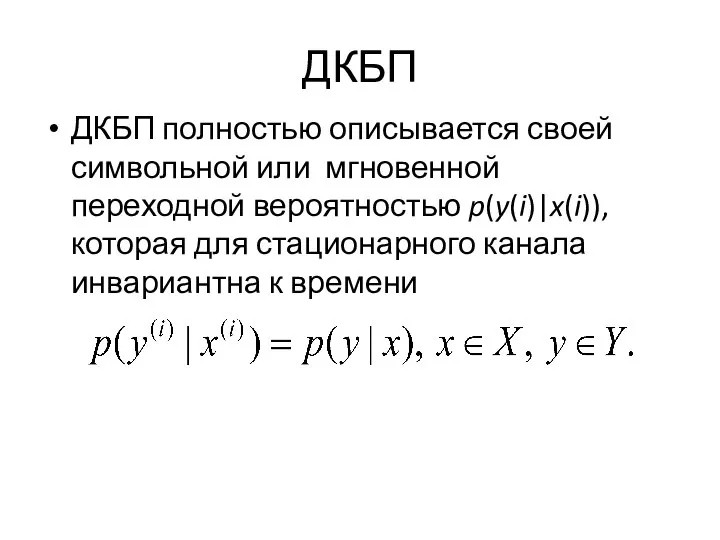

- 11. ДКБП ДКБП полностью описывается своей символьной или мгновенной переходной вероятностью p(y(i)|x(i)), которая для стационарного канала инвариантна

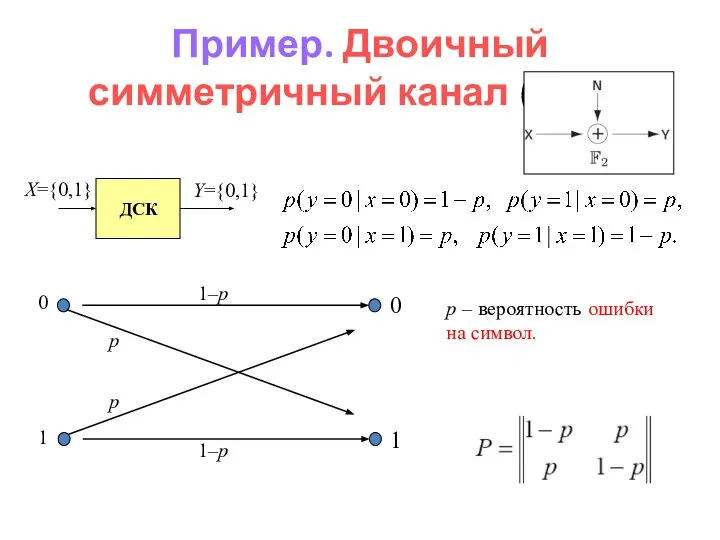

- 12. Пример. Двоичный симметричный канал (ДСК): p – вероятность ошибки на символ.

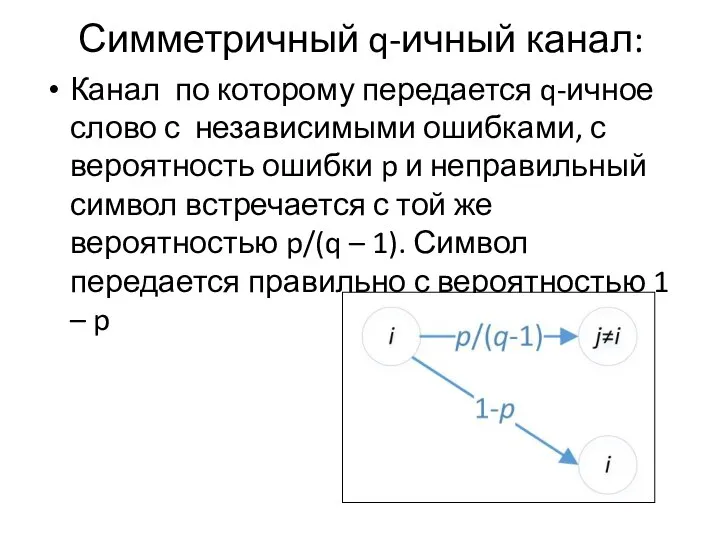

- 13. Симметричный q-ичный канал: Канал по которому передается q-ичное слово с независимыми ошибками, с вероятность ошибки p

- 14. Канал со стираниями (стирающий) Переходная матрица

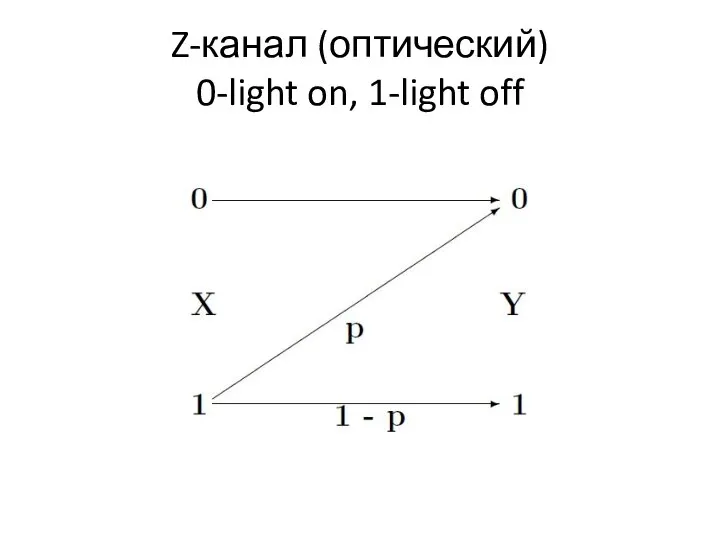

- 15. Z-канал (оптический) 0-light on, 1-light off

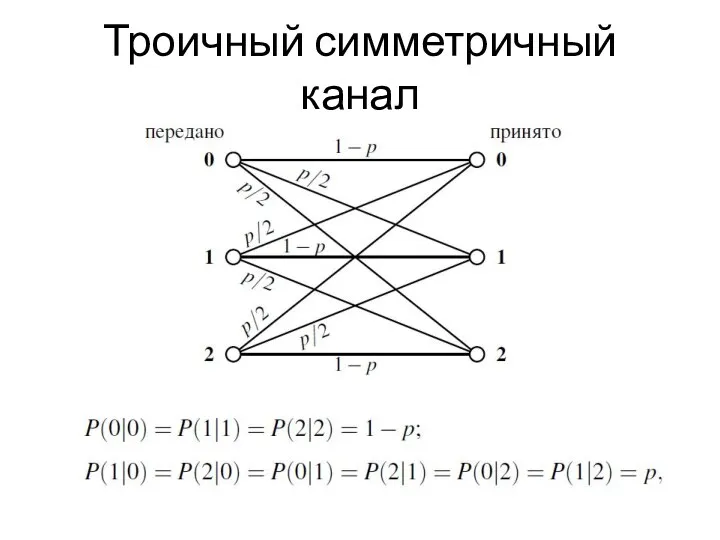

- 16. Троичный симметричный канал

- 17. Двоичные каналы связи Модели Гильберта, Эллиота-Гильберта, Смита-Боуэна-Джойса и Фричмана-Свободы. Первые три модели используют конечные цепи Маркова

- 18. А. А. Марков Математик, академик, внёсший большой вклад в теорию вероятностей математический анализ теорию чисел

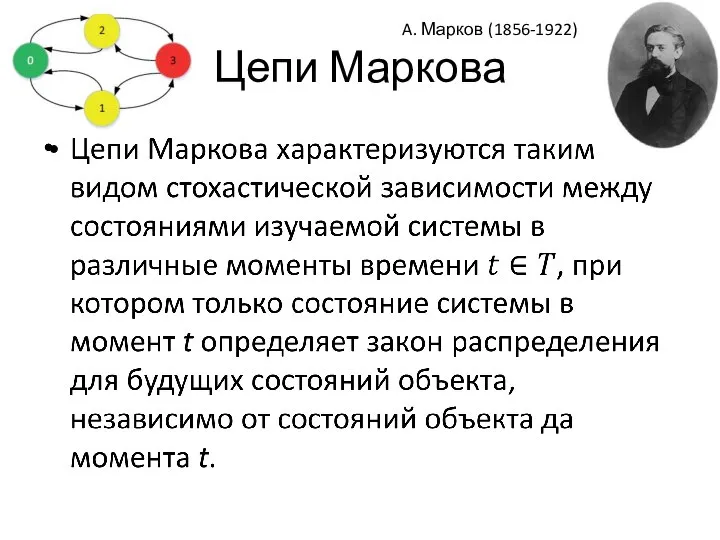

- 19. Цепи Маркова A. Марков (1856-1922)

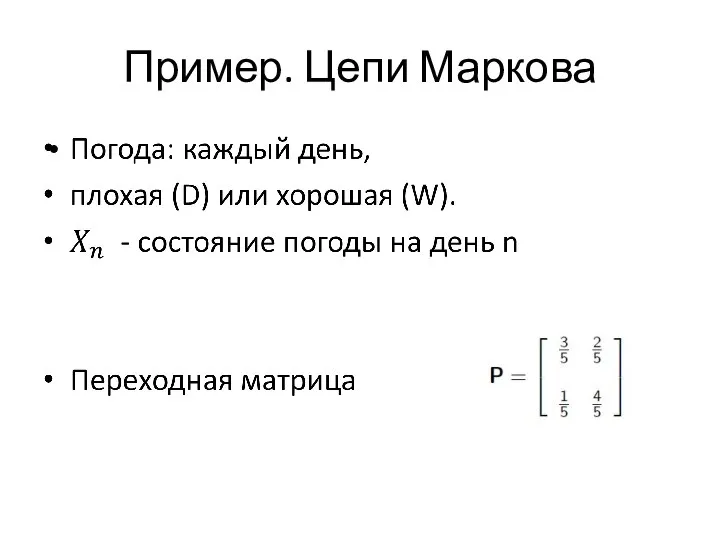

- 20. Пример. Цепи Маркова

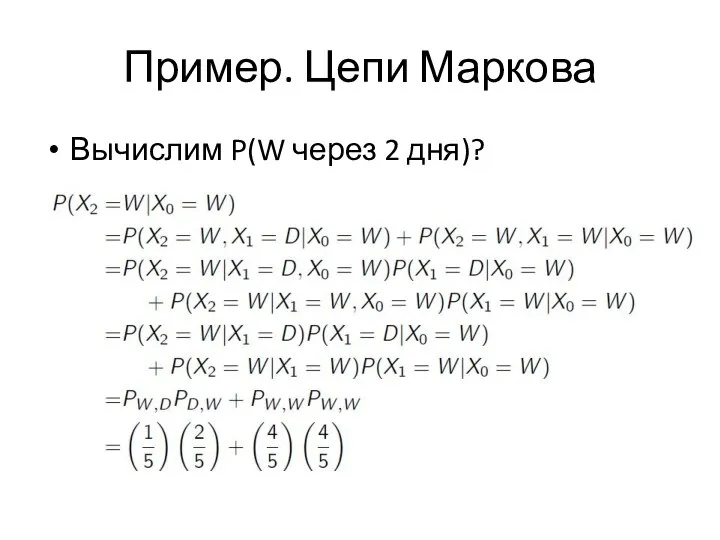

- 21. Пример. Цепи Маркова Вычислим P(W через 2 дня)?

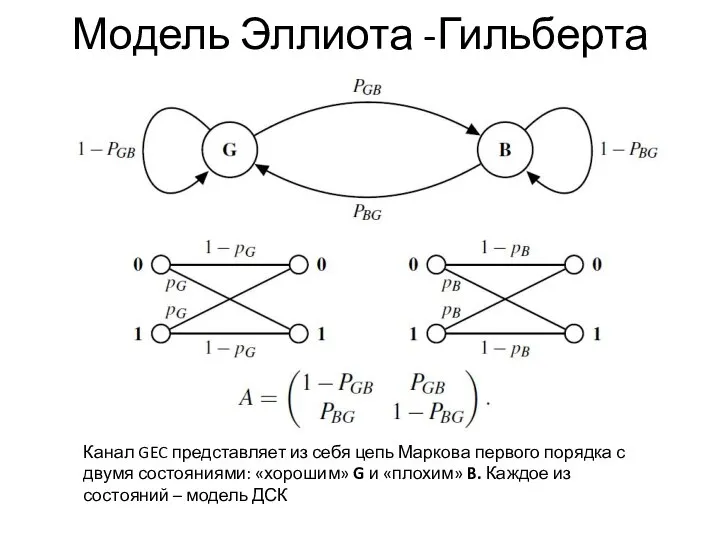

- 22. Модель Эллиота -Гильберта Канал GEC представляет из себя цепь Маркова первого порядка с двумя состояниями: «хорошим»

- 23. Апостериорная вероятность Полная информация, которую можно извлечь из y об x, содержится в апостериорных вероятностях p(x|y)

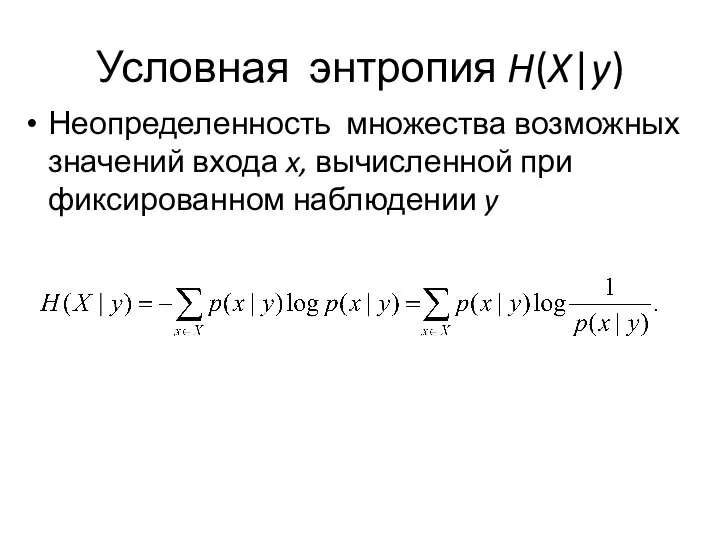

- 24. Условная энтропия H(X|y) Неопределенность множества возможных значений входа x, вычисленной при фиксированном наблюдении y

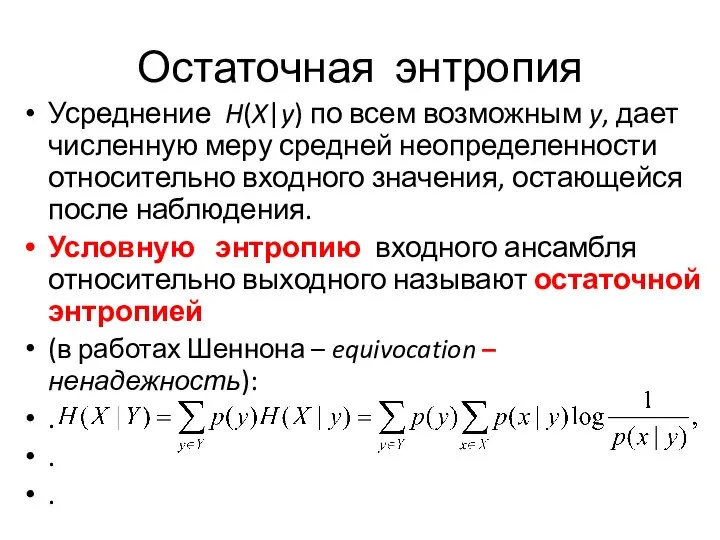

- 25. Остаточная энтропия Усреднение H(X|y) по всем возможным y, дает численную меру средней неопределенности относительно входного значения,

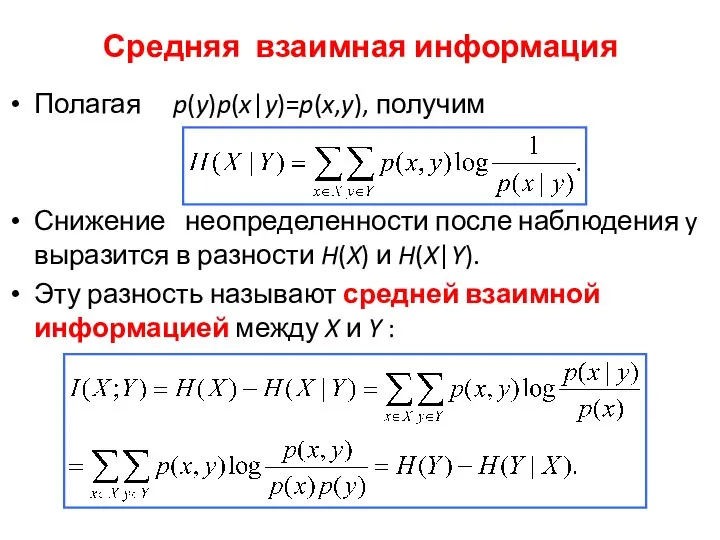

- 26. Средняя взаимная информация Полагая p(y)p(x|y)=p(x,y), получим Снижение неопределенности после наблюдения y выразится в разности H(X) и

- 27. Средняя взаимная информация I(X;Y) показывает число битов информации о входе канала извлекаемое в среднем из выходного

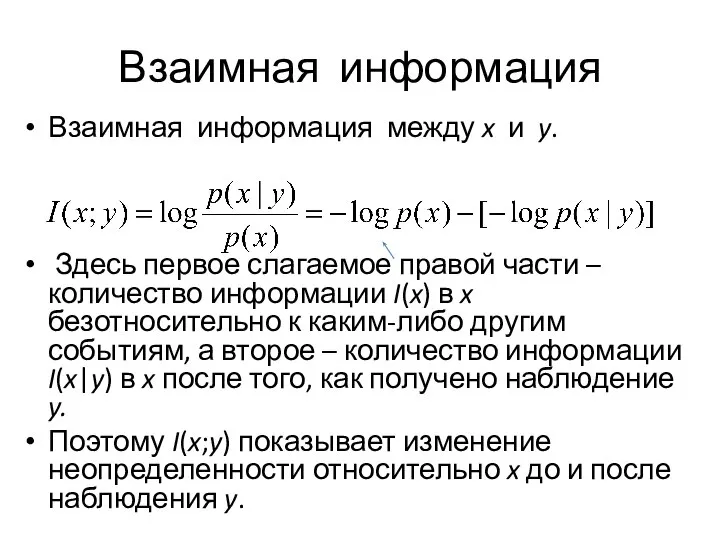

- 28. Взаимная информация Взаимная информация между x и y. Здесь первое слагаемое правой части – количество информации

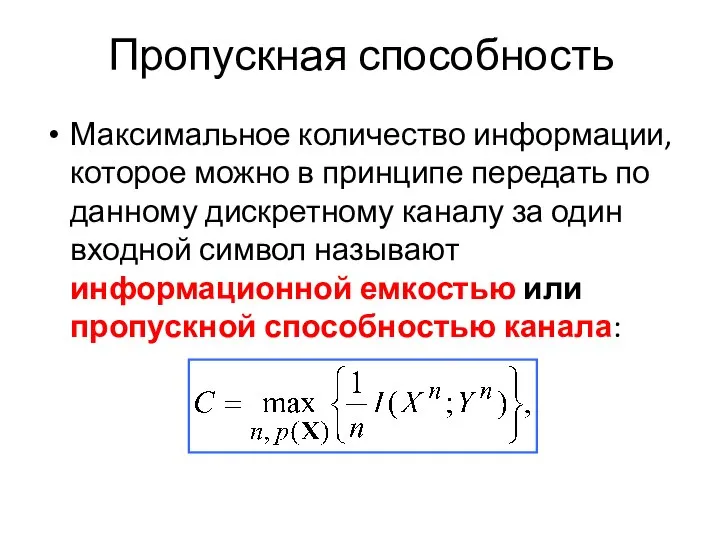

- 29. Пропускная способность Максимальное количество информации, которое можно в принципе передать по данному дискретному каналу за один

- 30. Пропускная способность Пропускная способность – фундаментальный параметр канала, определяющий его потенциальные возможности в части надежной передачи

- 31. Р. Фано Неравенство Фано (лемма), связывающего среднюю потерю информации в канале передачи с шумами с вероятностью

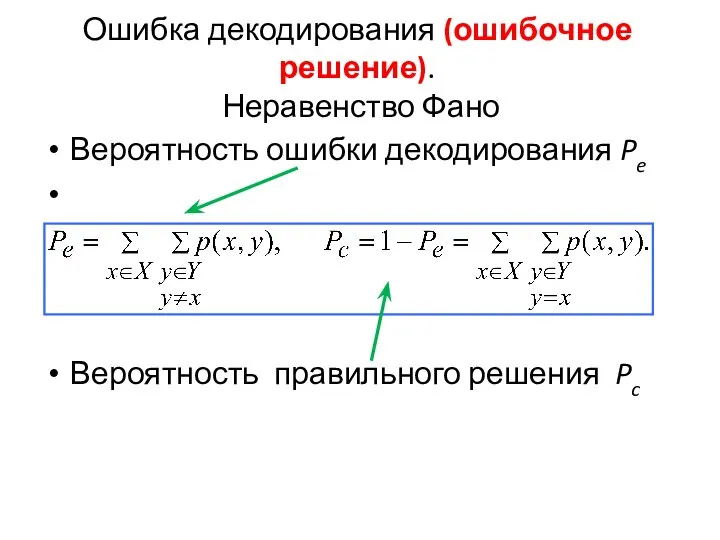

- 32. Ошибка декодирования (ошибочное решение). Неравенство Фано Вероятность ошибки декодирования Pe Вероятность правильного решения Pc

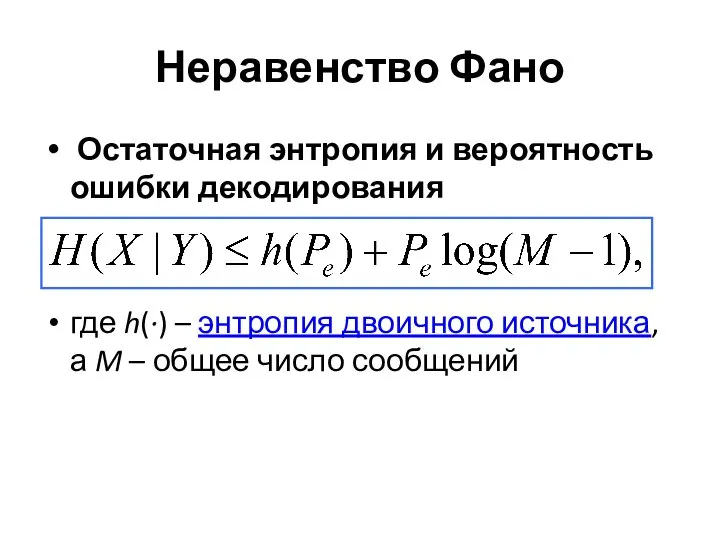

- 33. Неравенство Фано Остаточная энтропия и вероятность ошибки декодирования где h(·) – энтропия двоичного источника, а M

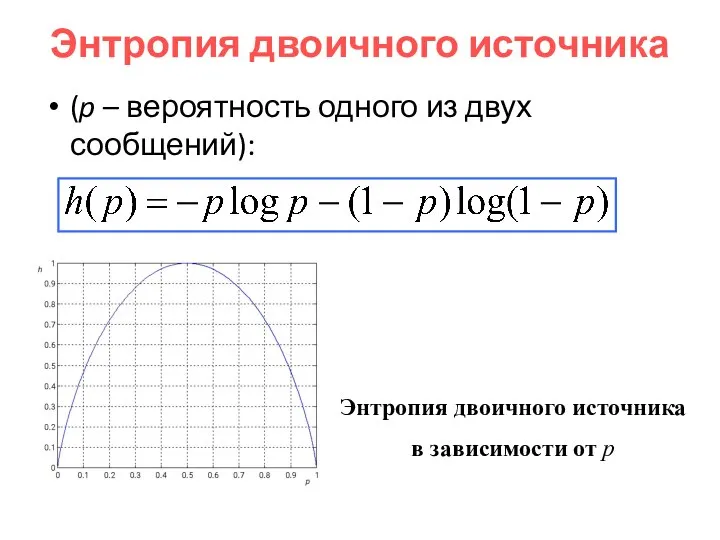

- 34. Энтропия двоичного источника (p – вероятность одного из двух сообщений): Энтропия двоичного источника в зависимости от

- 35. Скорость передачи или скорость кода R Пусть одно из M равновероятных сообщений, закодированное некоторым кодовым словом

- 36. Теоремы Шеннона

- 37. Обратная теорема кодирования При скорости, превышающей пропускную способность канала, R>C, не существует кода, гарантирующего произвольно малую

- 38. Прямая теорема кодирования При скорости, меньшей пропускной способности канала, R Если скорость R меньше емкости канала

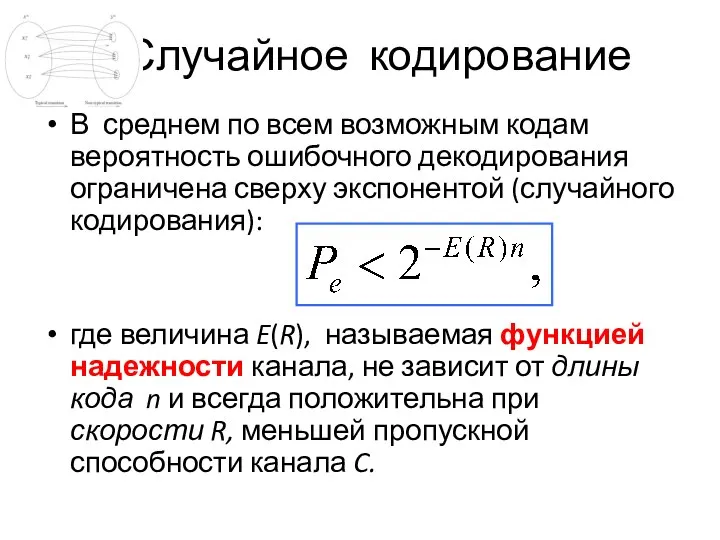

- 39. Случайное кодирование В среднем по всем возможным кодам вероятность ошибочного декодирования ограничена сверху экспонентой (случайного кодирования):

- 40. Случайное кодирование Верхняя граница для Pe (экспонента случайного кодирования) является экспоненциально точной, асимптотически приближаясь для лучших

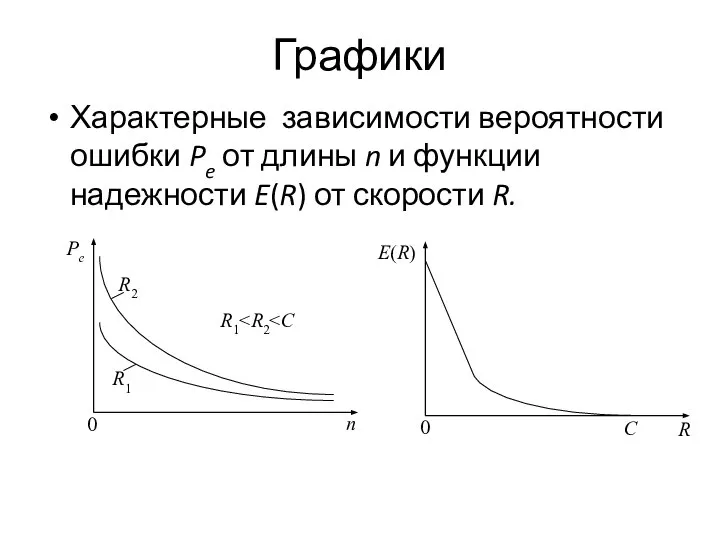

- 41. Графики Характерные зависимости вероятности ошибки Pe от длины n и функции надежности E(R) от скорости R.

- 42. Задача ТК Прямая теорема Шеннона является типичной математической теоремой существования, не давая ни малейшего намека на

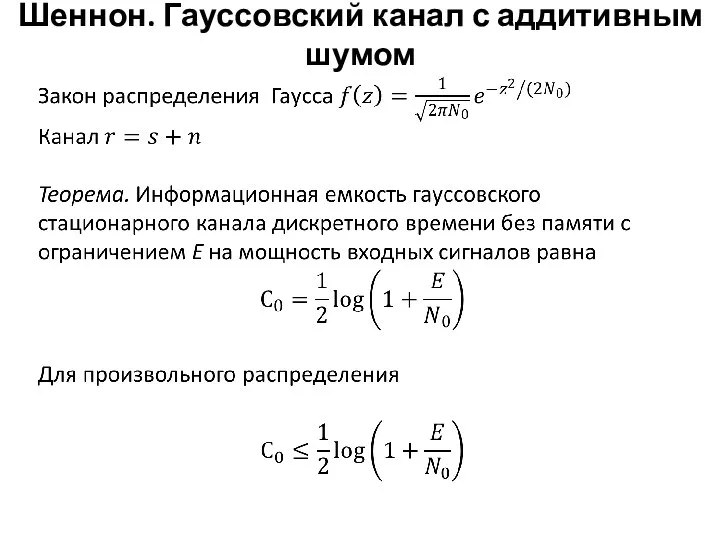

- 43. Шеннон. Гауссовский канал с аддитивным шумом

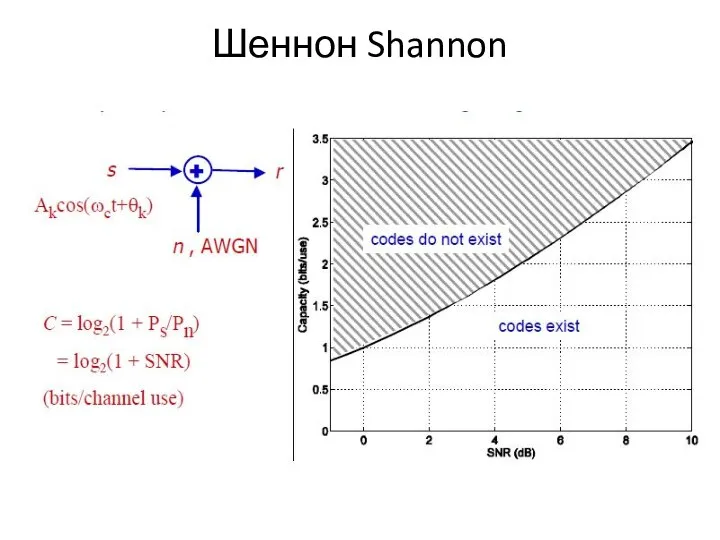

- 44. Шеннон Shannon

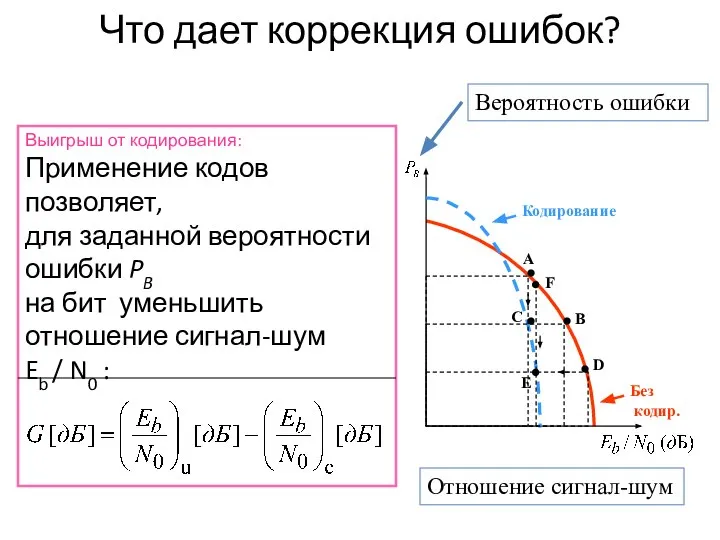

- 45. Что дает коррекция ошибок? Выигрыш от кодирования: Применение кодов позволяет, для заданной вероятности ошибки PB на

- 47. Скачать презентацию

Геометризация качественных показателей Эльгинского месторождения каменного угля

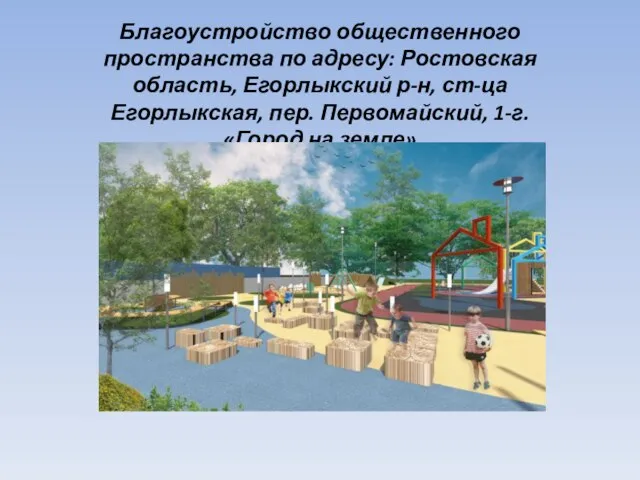

Геометризация качественных показателей Эльгинского месторождения каменного угля Благоустройство общественного пространства по адресу: Ростовская область, станица Егорлыкская. Город на земле

Благоустройство общественного пространства по адресу: Ростовская область, станица Егорлыкская. Город на земле Recherchieren beim Übersetzen

Recherchieren beim Übersetzen Виды транспорта

Виды транспорта Українське гутне скло

Українське гутне скло Светофоры. Входной светофор

Светофоры. Входной светофор Искусство 21 века

Искусство 21 века Холодильные оборудования

Холодильные оборудования 20130116_musorgskiy

20130116_musorgskiy Пори року

Пори року Видео ролик о лаборатории Павлодарского диагностического центра. Павлодар 2015

Видео ролик о лаборатории Павлодарского диагностического центра. Павлодар 2015 7 поводов для счастья

7 поводов для счастья Способы прессования порошков

Способы прессования порошков Прошлое и настоящее села Бахта

Прошлое и настоящее села Бахта Изучение требований профессиональных стандартов к работникам сферы электроэнергетики и электротехники

Изучение требований профессиональных стандартов к работникам сферы электроэнергетики и электротехники 01. Числа 1- 20

01. Числа 1- 20 Ремонт двухкомнатной квартиры по предпочтениям заказчика

Ремонт двухкомнатной квартиры по предпочтениям заказчика Трудовые ресурсы мира

Трудовые ресурсы мира Влияние оконных откосов на теплозащитные свойства стен

Влияние оконных откосов на теплозащитные свойства стен Проблемы малоподвижности

Проблемы малоподвижности Имидж Ксении Собчак

Имидж Ксении Собчак Адаптеры. Функции сетевого адаптера

Адаптеры. Функции сетевого адаптера Вместе в будущее

Вместе в будущее Газовый контур РБМК-1000

Газовый контур РБМК-1000 Обработка информации с помощью электронных таблиц

Обработка информации с помощью электронных таблиц Общие сведения о сварке

Общие сведения о сварке Шитьё для начинающих

Шитьё для начинающих Магнитные методы обогащения

Магнитные методы обогащения