Содержание

- 2. Методы прямого поиска В типичном методе поиска направления минимизации полностью определяются на основании последовательных вычислений целевой

- 3. Методы прямого поиска Методы поиска не требуют регулярности и непрерывности целевой функции и существования производных. Голоморфная

- 4. Методы прямого поиска Вторым обстоятельством, правда, связанным с предыдущей проблемой, является то, что при использовании методов

- 5. Методы прямого поиска Методы поиска простейшего типа заключаются в изменении каждый раз одной переменной, тогда как

- 6. Hooke, R.; Jeeves, T.A. (1961). "'Direct search' solution of numerical and statistical problems". Journal of the

- 7. Алгоритм Хука и Дживса Хук и Дживс предложили логически простую стратегию поиска, использующую априорные сведения и

- 8. Затем в циклическом порядке изменяется каждая переменная (каждый раз только одна) на выбранные величины приращений, пока

- 9. На каждом шаге или сдвиге по независимой переменной значение целевой функции сравнивается с ее значением в

- 10. Длина шага при поиске по образцу в данном координатном направлении приблизительно пропорциональна числу удачных шагов, имевших

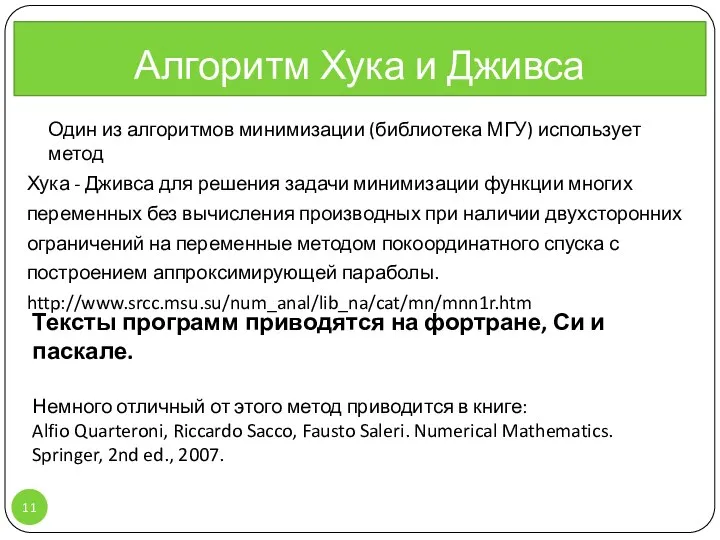

- 11. Алгоритм Хука и Дживса Один из алгоритмов минимизации (библиотека МГУ) использует метод Хука - Дживса для

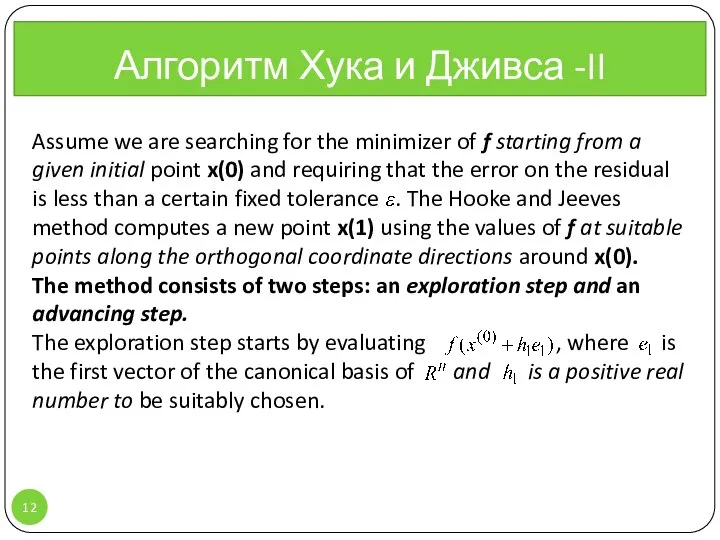

- 12. Assume we are searching for the minimizer of f starting from a given initial point x(0)

- 13. If , then a success is recorded and the starting point is moved in , from

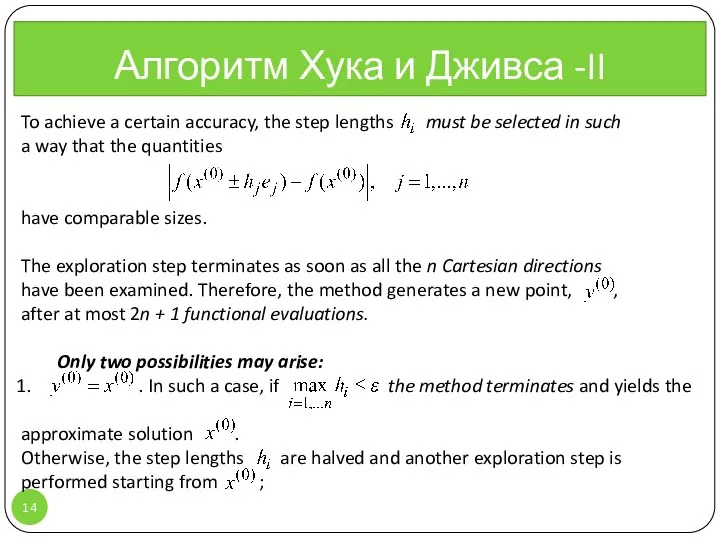

- 14. Алгоритм Хука и Дживса -II , To achieve a certain accuracy, the step lengths must be

- 15. Алгоритм Хука и Дживса -II , 2. . If then the method terminates yielding as an

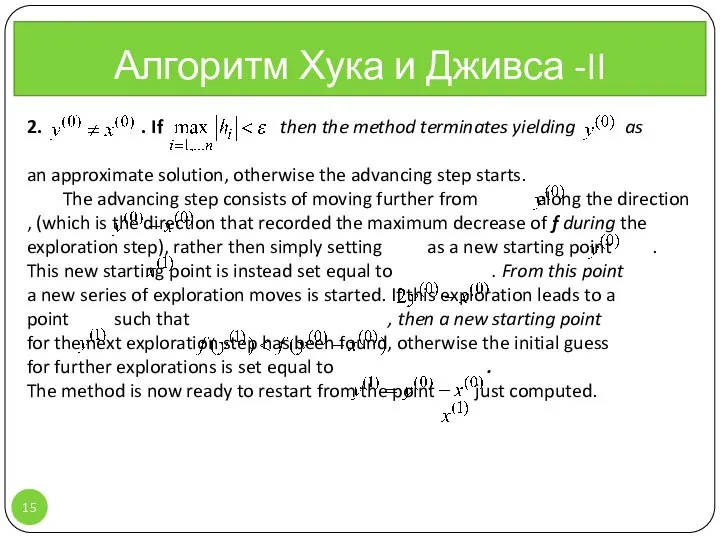

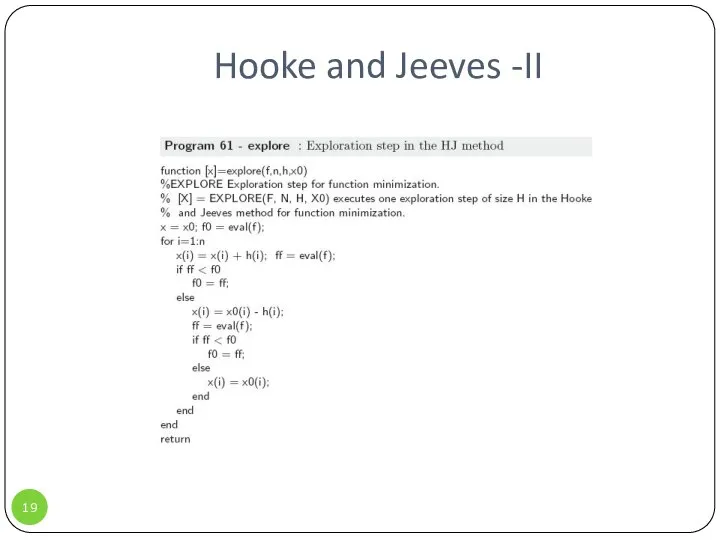

- 16. Алгоритм Хука и Дживса , function [x,minf,iter]=hookejeeves(f,n,h,x0,tol) {HOOKEJEEVES HOOKE and JEEVES method for function minimization. [X,

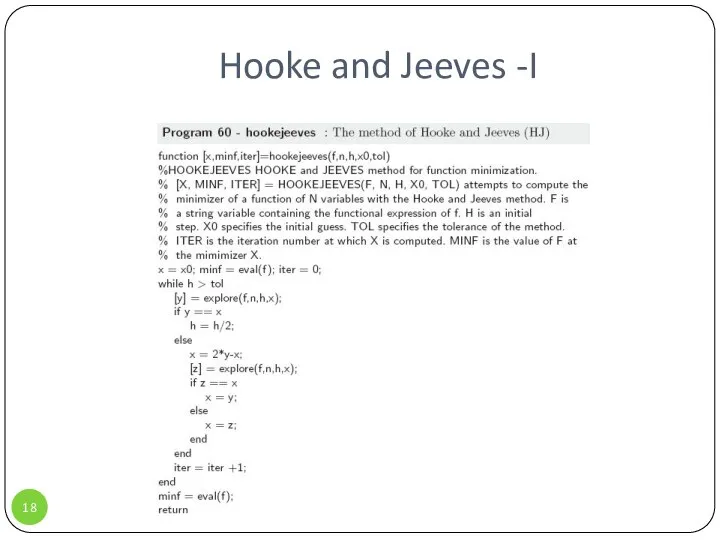

- 17. Алгоритм Хука и Дживса , function [x]=explore(f,n,h,x0) { EXPLORE Exploration step for function minimization. [X] =

- 18. Hooke and Jeeves -I

- 19. Hooke and Jeeves -II

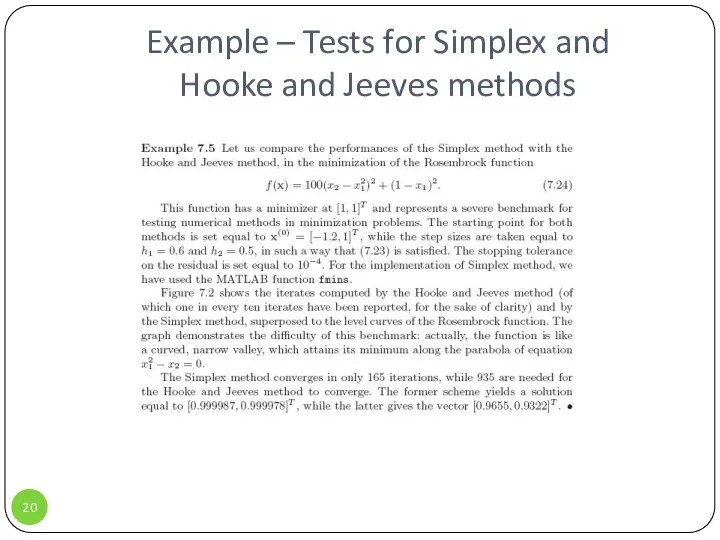

- 20. Example – Tests for Simplex and Hooke and Jeeves methods

- 22. Скачать презентацию

![Алгоритм Хука и Дживса , function [x,minf,iter]=hookejeeves(f,n,h,x0,tol) {HOOKEJEEVES HOOKE and JEEVES](/_ipx/f_webp&q_80&fit_contain&s_1440x1080/imagesDir/jpg/1306729/slide-15.jpg)

![Алгоритм Хука и Дживса , function [x]=explore(f,n,h,x0) { EXPLORE Exploration step](/_ipx/f_webp&q_80&fit_contain&s_1440x1080/imagesDir/jpg/1306729/slide-16.jpg)

МИРОВОЙ ЭКОНОМИЧЕСКИЙ КРИЗИС

МИРОВОЙ ЭКОНОМИЧЕСКИЙ КРИЗИС Развитие вычислительной техники

Развитие вычислительной техники Проектирование классов и взаимодействия

Проектирование классов и взаимодействия Теория пассионарности Л.Н. Гумилева

Теория пассионарности Л.Н. Гумилева Патология белкового и липидного обменов

Патология белкового и липидного обменов ЖИВОТНЫЕ ТРОПИЧЕСКОГО ЛЕСА

ЖИВОТНЫЕ ТРОПИЧЕСКОГО ЛЕСА  Презентация на тему "Роль правового воспитания в профилактике правонарушений школьников" - скачать презентации по Педагогик

Презентация на тему "Роль правового воспитания в профилактике правонарушений школьников" - скачать презентации по Педагогик Создание сети платежных терминалов для Банка Предложение компании «Предпроцессинг» (Predprocessing)

Создание сети платежных терминалов для Банка Предложение компании «Предпроцессинг» (Predprocessing) Особенности судебного разбирательства в суде с участием присяжных заседателей. (Тема 3.3)

Особенности судебного разбирательства в суде с участием присяжных заседателей. (Тема 3.3) Аминокислоты

Аминокислоты Поглощения буровых и тампонажных растворов. Лекция 2

Поглощения буровых и тампонажных растворов. Лекция 2 Открытие нового легкоатлетического манежа в МГСУ

Открытие нового легкоатлетического манежа в МГСУ Аттестация в вопросах и ответах Из Письма Минобрнауки "Разъяснения по применению Порядка аттестации педагогических работ

Аттестация в вопросах и ответах Из Письма Минобрнауки "Разъяснения по применению Порядка аттестации педагогических работ Презентация____

Презентация____ Условия кристаллизации магмы

Условия кристаллизации магмы Модель COSO ERM через призму внутреннего контроля и аудита

Модель COSO ERM через призму внутреннего контроля и аудита L700 download user guide. Flash loader v0.x Lite 7.0.2

L700 download user guide. Flash loader v0.x Lite 7.0.2 Апаратна складова ПК

Апаратна складова ПК Функциональная электроника

Функциональная электроника Словники у професійному мовленні

Словники у професійному мовленні Икона новомучеников и исповедников Российских

Икона новомучеников и исповедников Российских Волинські Вконтакте

Волинські Вконтакте Производство сыра

Производство сыра Презентация на тему "Формы работы классного руководителя с родителями" - скачать презентации по Педагогике

Презентация на тему "Формы работы классного руководителя с родителями" - скачать презентации по Педагогике Общение с миромПрезентация1

Общение с миромПрезентация1 Строительная химия BASF

Строительная химия BASF Политические и правовые взгляды Древнего Китая Работу выполнили Пустовая Анастасия, Мятлик Елена, группа Ю-103

Политические и правовые взгляды Древнего Китая Работу выполнили Пустовая Анастасия, Мятлик Елена, группа Ю-103 Арабский халифат

Арабский халифат