Содержание

- 2. Введение Кластер — группа компьютеров, объединённых высокоскоростными каналами связи и представляющая с точки зрения пользователя единый

- 3. Обычно различают следующие основные виды кластеров: отказоустойчивые кластеры (High-availability clusters, HA, кластеры высокой доступности) кластеры с

- 4. История создания кластеров неразрывно связана с ранними разработками в области компьютерных сетей. Одной из причин для

- 5. История создания кластеров из обыкновенных персональных компьютеров во многом обязана проекту Parallel Virtual Machine. В 1989

- 6. Beowulf Beowulf (Beowolf) — кластер, который состоит из широко распространённого аппаратного обеспечения, работающий под управлением операционной

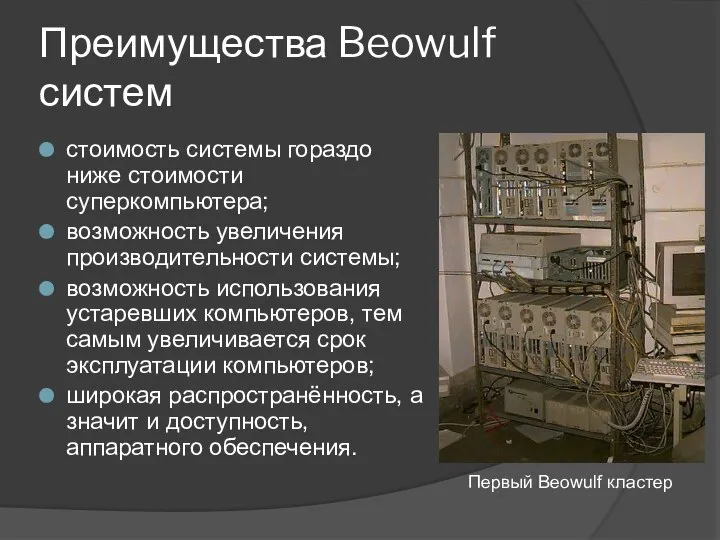

- 7. Преимущества Beowulf систем стоимость системы гораздо ниже стоимости суперкомпьютера; возможность увеличения производительности системы; возможность использования устаревших

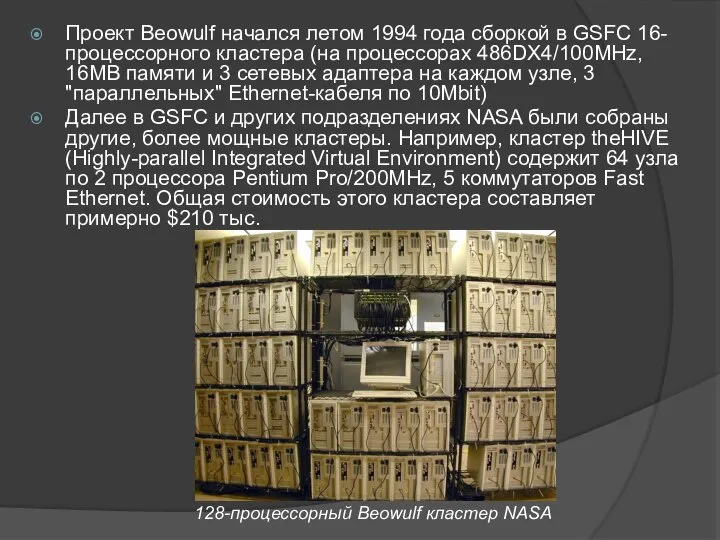

- 8. Проект Beowulf начался летом 1994 года сборкой в GSFC 16-процессорного кластера (на процессорах 486DX4/100MHz, 16MB памяти

- 9. Современный Beowulf кластер

- 10. Классификация кластеров.

- 11. Кластеры высокой доступности Создаются для обеспечения высокой доступности сервиса, предоставляемого кластером. Избыточное число узлов, входящих в

- 12. Кластеры распределения нагрузки Принцип их действия строится на распределении запросов через один или несколько входных узлов,

- 13. Вычислительные кластеры Для вычислительных кластеров существенными показателями являются высокая производительность процессора в операциях над числами с

- 14. Системы распределённых вычислений (grid) Такие системы не принято считать кластерами, но их принципы в значительной степени

- 15. Масштабируемая архитектура класса Кластеры должны создаваться таким образом, чтобы объем операций управления доступом к ресурсам и

- 16. Самые производительные Дважды в год организацией TOP500 публикуется список пятисот самых производительных вычислительных систем в мире,

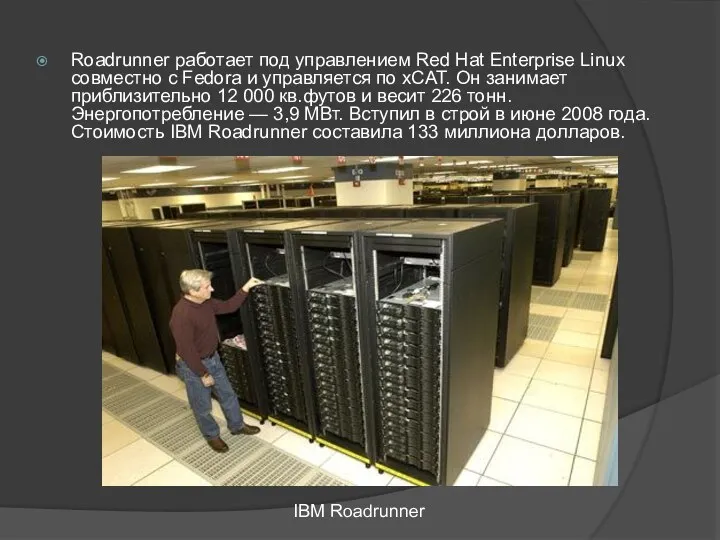

- 17. Roadrunner работает под управлением Red Hat Enterprise Linux совместно с Fedora и управляется по xCAT. Он

- 18. Министерство энергетики планирует использовать RoadRunner для расчёта старения ядерных материалов и анализа безопасности и надёжности ядерного

- 19. Отечественные кластеры Кластер "СКИФ К-500", созданный в рамках совместной российско-белорусской программы "СКИФ" стал второй из созданных

- 21. Скачать презентацию

Многозональные вытяжные вентиляторы

Многозональные вытяжные вентиляторы 11 класс

11 класс  Формы государства. Политика

Формы государства. Политика Богослужения суббот Великого поста

Богослужения суббот Великого поста Аполлон и Дафна

Аполлон и Дафна Культура и информатизация

Культура и информатизация  Бетон

Бетон Декоративно – прикладное искусство в жизни человека. Лоскутное шитье. (5 класс) Учитель – технологии Лисичкина Зинаида Алекс

Декоративно – прикладное искусство в жизни человека. Лоскутное шитье. (5 класс) Учитель – технологии Лисичкина Зинаида Алекс Деловая культура Кореи

Деловая культура Кореи (з†бвм-ѓа®ЂЃ¶•≠®•)-КРУГИ ЭЙЛЕРА

(з†бвм-ѓа®ЂЃ¶•≠®•)-КРУГИ ЭЙЛЕРА Презентация на тему "Семинар Методы и формы организации контроля усвоения учащимися учебного материала" - скачать презентаци

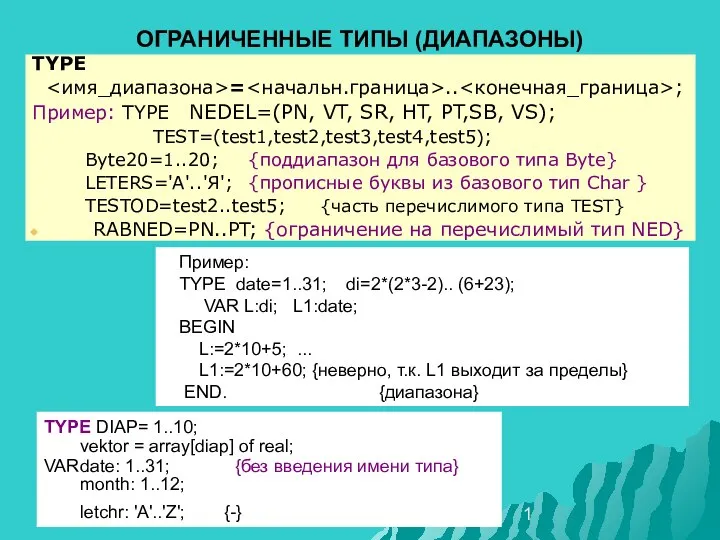

Презентация на тему "Семинар Методы и формы организации контроля усвоения учащимися учебного материала" - скачать презентаци лек9структур05прогр

лек9структур05прогр  Международные отношения на современном этапе

Международные отношения на современном этапе Зона комфорта

Зона комфорта  Виктор Михайлович Васнецов

Виктор Михайлович Васнецов Формирование современной городской среды. Город Глазов 2018-2022 годы. Общественная территория «Сквер у музыкальной школы»

Формирование современной городской среды. Город Глазов 2018-2022 годы. Общественная территория «Сквер у музыкальной школы» Теория культур Эдварда Холла

Теория культур Эдварда Холла Parallel programming technologies on hybrid architectures

Parallel programming technologies on hybrid architectures Марченко Мария, 8 «В»

Марченко Мария, 8 «В»  Презентация на тему "Технология проблемного обучения. Метапредметный подход" - скачать презентации по Педагогике

Презентация на тему "Технология проблемного обучения. Метапредметный подход" - скачать презентации по Педагогике Психические познавательные процессы

Психические познавательные процессы Жостовская роспись

Жостовская роспись О маркетинге. О книгах. О принципах. Игорь Манн

О маркетинге. О книгах. О принципах. Игорь Манн Теория и практика решения кейсов по корпоративному праву

Теория и практика решения кейсов по корпоративному праву Политическое сознание

Политическое сознание Государственные и заказы на муниципальном уровне

Государственные и заказы на муниципальном уровне Первый день творения

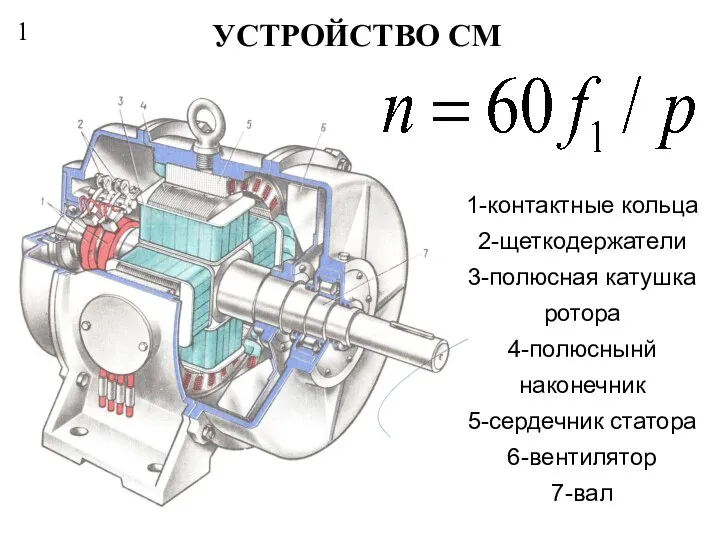

Первый день творения Устройство СМ

Устройство СМ