Содержание

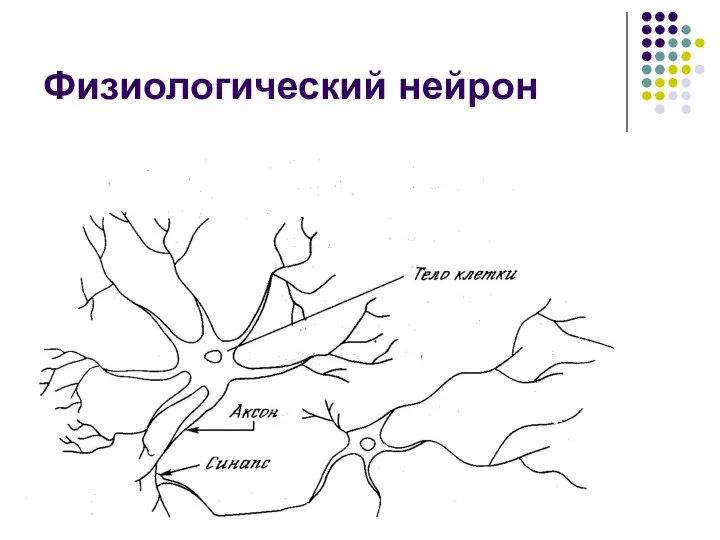

- 2. Физиологический нейрон

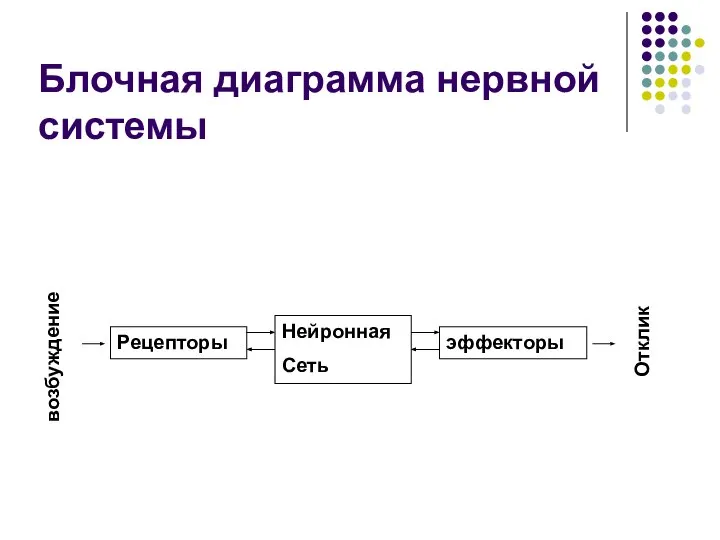

- 3. Блочная диаграмма нервной системы возбуждение Рецепторы Нейронная Сеть эффекторы Отклик

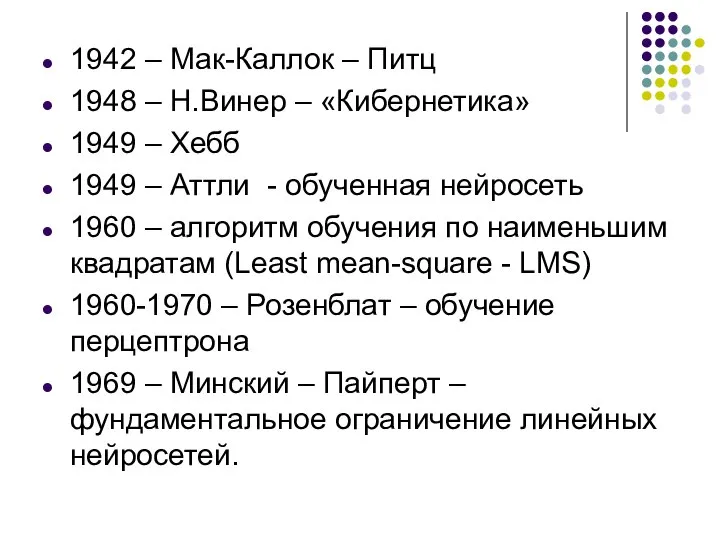

- 4. 1942 – Мак-Каллок – Питц 1948 – Н.Винер – «Кибернетика» 1949 – Хебб 1949 – Аттли

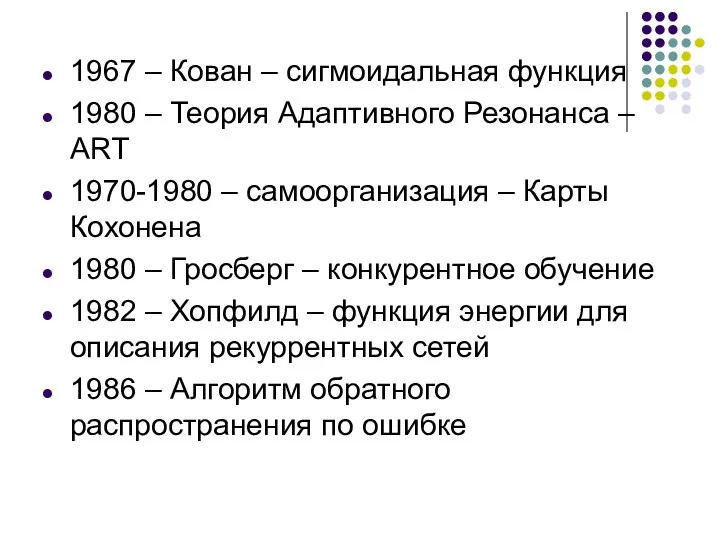

- 5. 1967 – Кован – сигмоидальная функция 1980 – Теория Адаптивного Резонанса – АRТ 1970-1980 – самоорганизация

- 6. Нейроны Хебба Маккалока – Питца Сигмоидный Гросберга Радиальный WTA

- 7. Формальная модель нейрона S f(s) b w1 wn Σ

- 8. Формальная модель нейрона Σ

- 9. Активационные функции Линейные. Нелинейные.

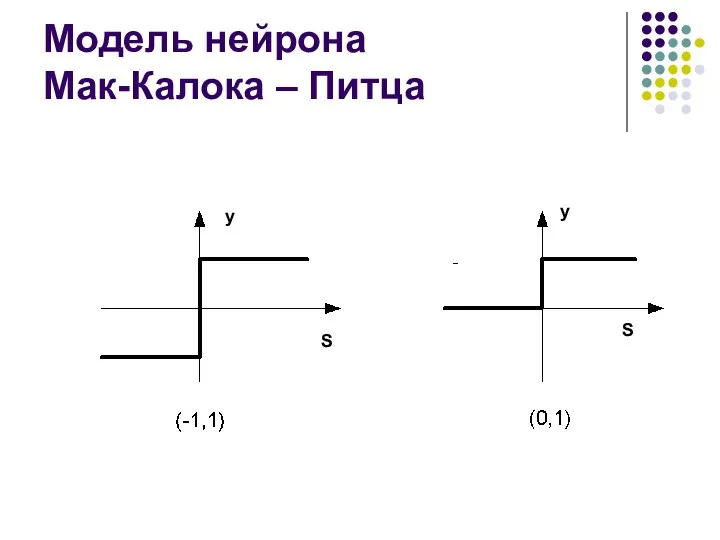

- 10. Модель нейрона Мак-Калока – Питца y y S S

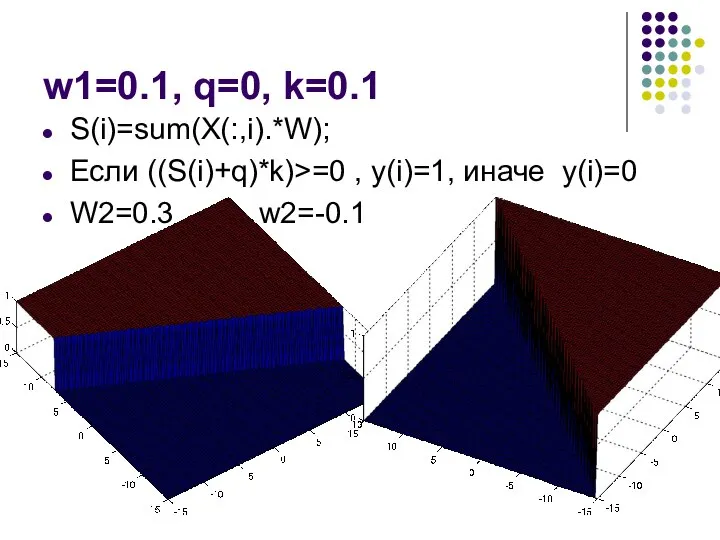

- 11. w1=0.1, q=0, k=0.1 S(i)=sum(X(:,i).*W); Если ((S(i)+q)*k)>=0 , y(i)=1, иначе y(i)=0 W2=0.3 w2=-0.1

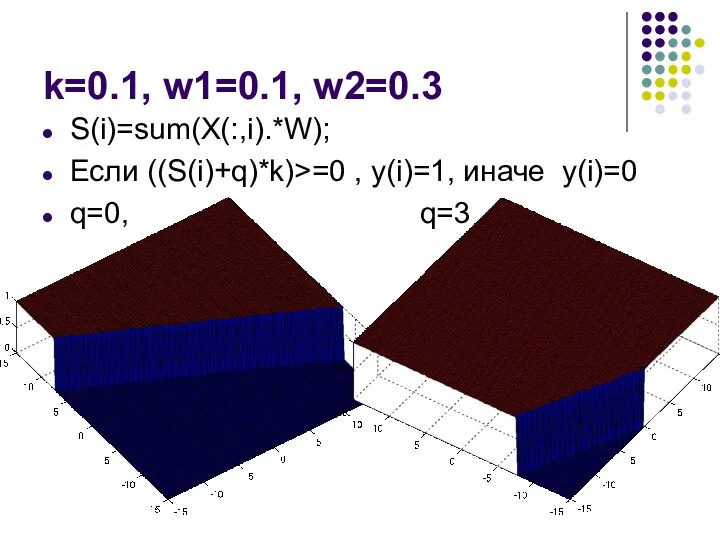

- 12. k=0.1, w1=0.1, w2=0.3 S(i)=sum(X(:,i).*W); Если ((S(i)+q)*k)>=0 , y(i)=1, иначе y(i)=0 q=0, q=3

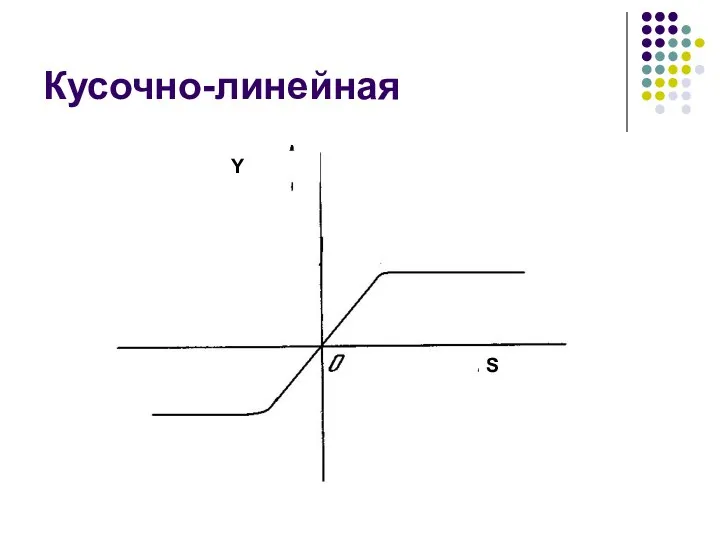

- 13. Кусочно-линейная Y S

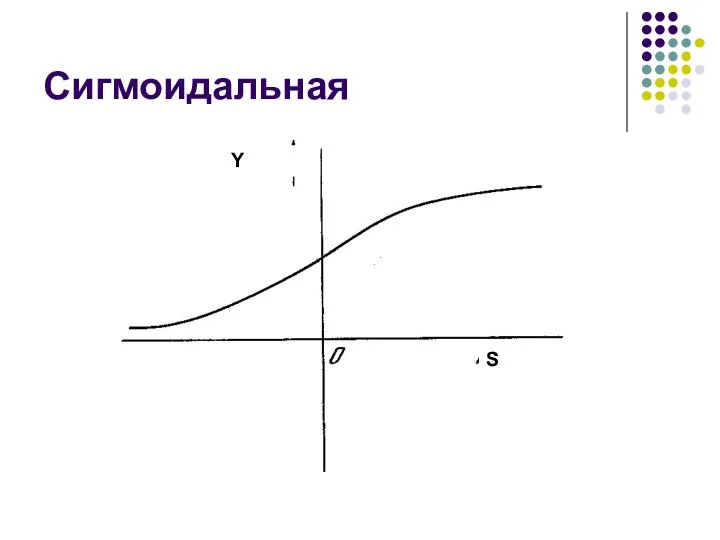

- 14. Сигмоидальная Y S

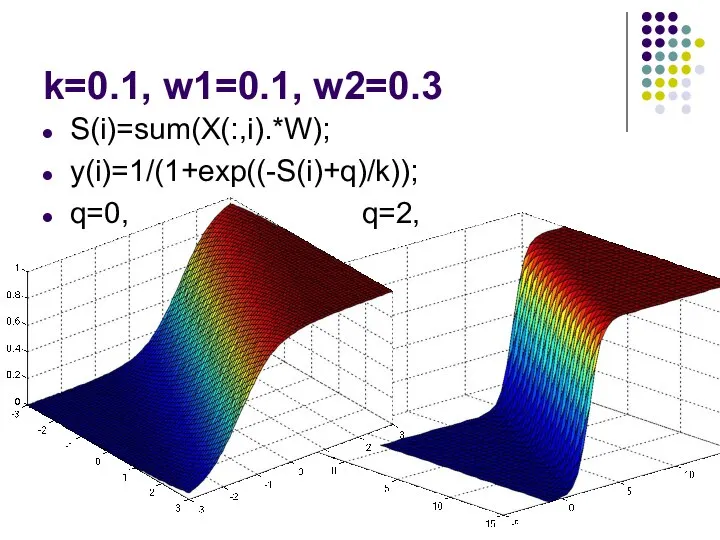

- 15. k=0.1, w1=0.1, w2=0.3 S(i)=sum(X(:,i).*W); y(i)=1/(1+exp((-S(i)+q)/k)); q=0, q=2,

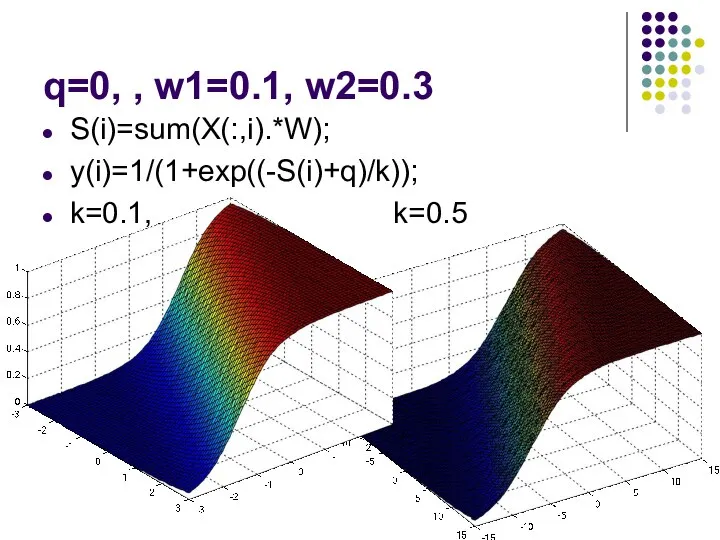

- 16. q=0, , w1=0.1, w2=0.3 S(i)=sum(X(:,i).*W); y(i)=1/(1+exp((-S(i)+q)/k)); k=0.1, k=0.5

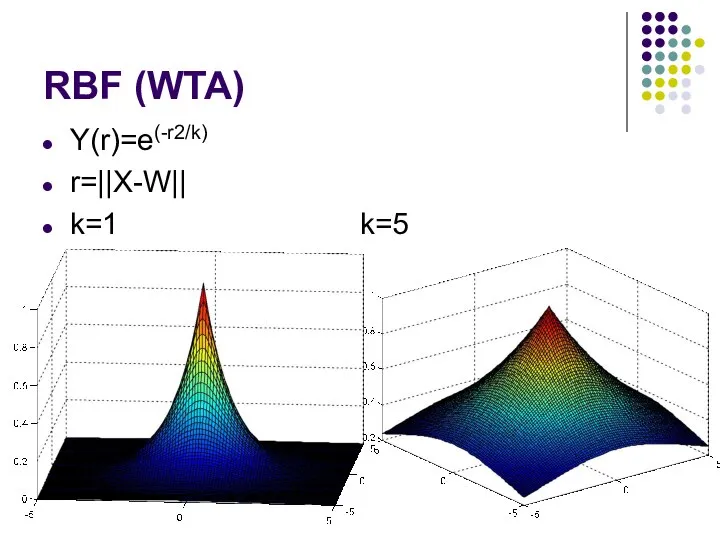

- 17. RBF (WTA) Y(r)=e(-r2/k) r=||X-W|| k=1 k=5

- 18. Нейронная сеть Число слоев/число нейронов по слоям Обратные связи Активационные функции Число входов Число выходов Алгоритм

- 19. Слой нейросети Группа нейронов сети: Общие функции (задачи) Общие внешние связи Общие входы Зачем выделять слой?

- 20. Режимы функционирования нейросетей Обучение Работа

- 21. Формальная модель сети f(X)=Net(X)

- 22. Архитектуры НС (классификация) Тип обучения С учителем Без учителя Класс алгоритмов оучения Число слоев: Однослойные многослойные.

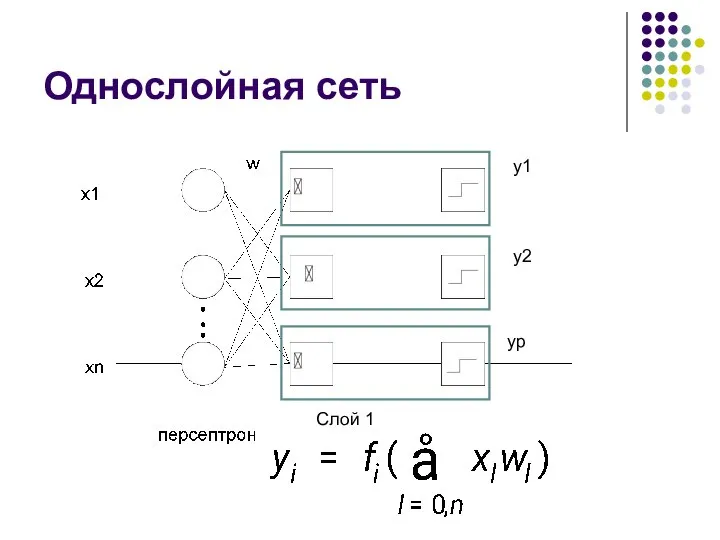

- 23. Однослойная сеть y1 y2 yp Слой 1

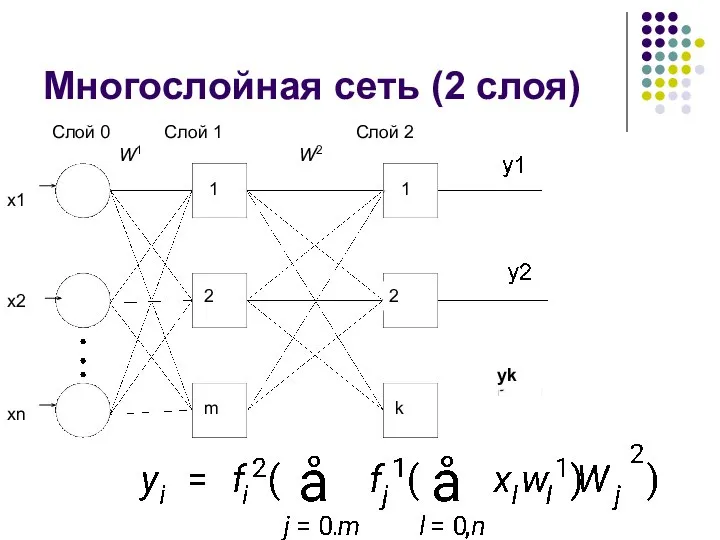

- 24. Многослойная сеть (2 слоя) yk Слой 1 Слой 2 Слой 0 W1 W2 1 2 m

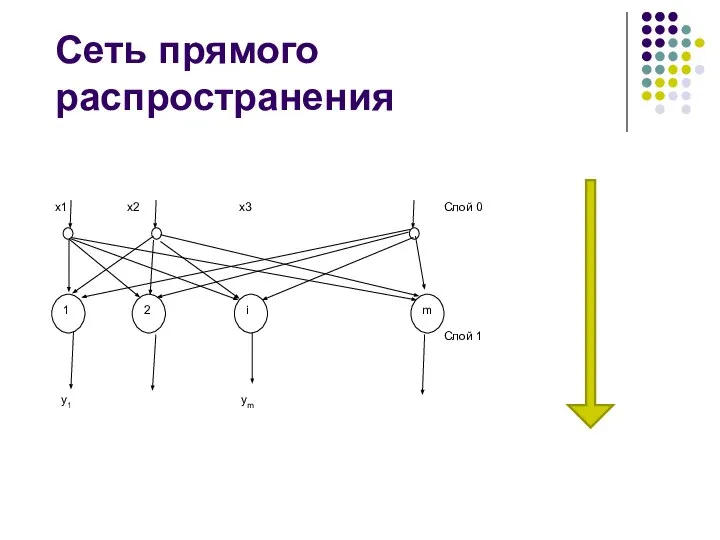

- 25. Сеть прямого распространения 1 2 i m x1 x2 x3 y1 ym Слой 0 Слой 1

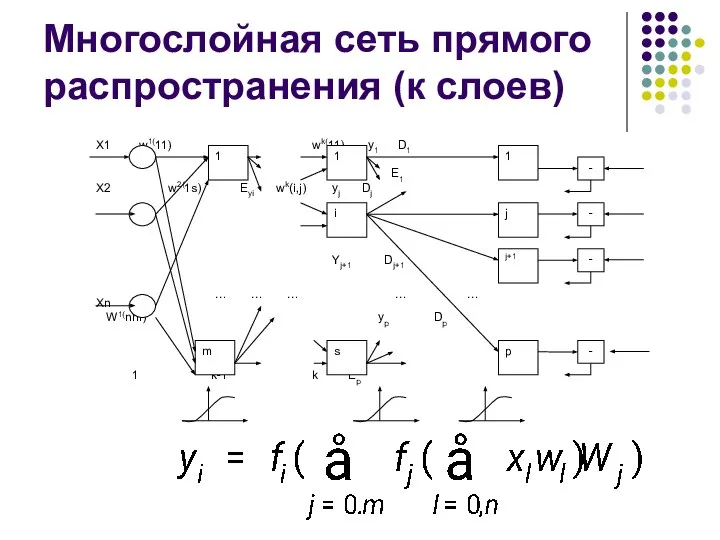

- 26. Многослойная сеть прямого распространения (к слоев)

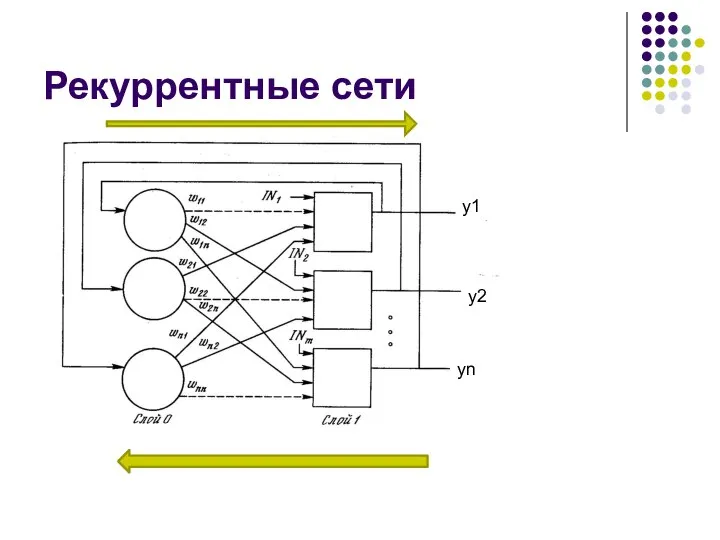

- 27. Рекуррентные сети y1 y2 yn

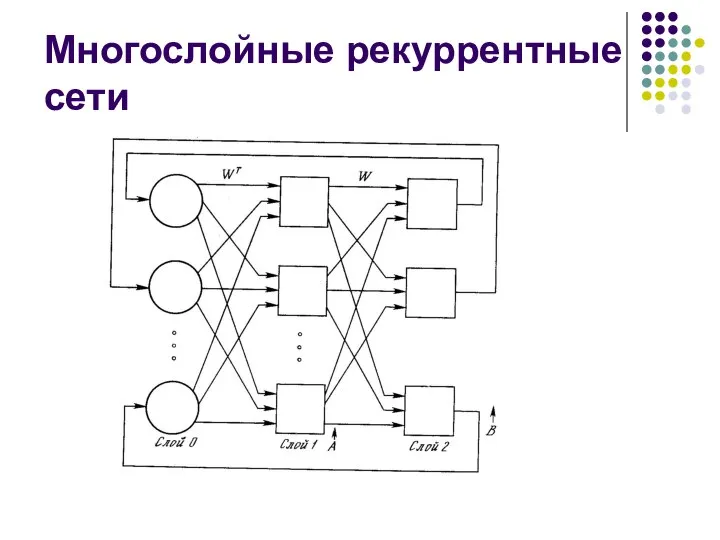

- 28. Многослойные рекуррентные сети

- 29. Виды обучения С учителем T={(Xi,di)}, i=1,N Xi- входной вектор di – выходной вектор Без учителя T={Xi},

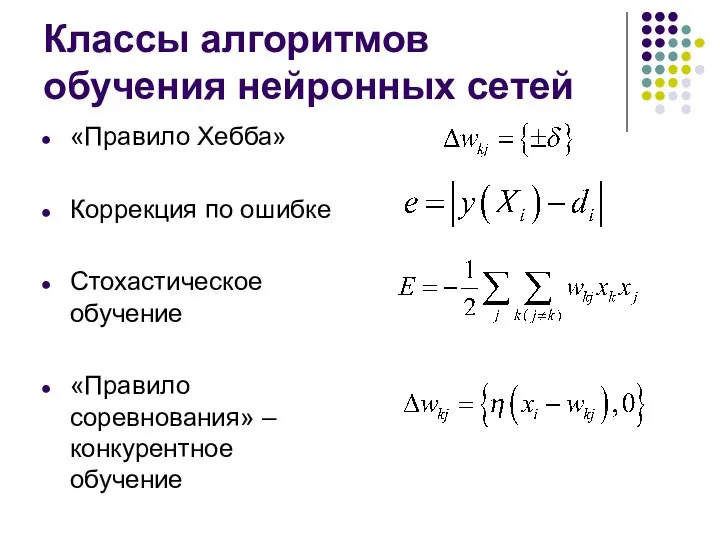

- 30. Классы алгоритмов обучения нейронных сетей «Правило Хебба» Коррекция по ошибке Стохастическое обучение «Правило соревнования» – конкурентное

- 31. Вселенский разум

- 32. Вопрос Вариант 1 Вычислить реакцию порогового нейрона с W=[ 1 ,-1] на входное воздействие Х=[0 ,1]

- 33. литература Комарцова Л.Г. Максимов А.В. Нейрокомпьютеры – М.:Из-во МГТУ - 2004.

- 35. Скачать презентацию

![Вопрос Вариант 1 Вычислить реакцию порогового нейрона с W=[ 1 ,-1]](/_ipx/f_webp&q_80&fit_contain&s_1440x1080/imagesDir/jpg/1317553/slide-31.jpg)

Аттестационная работа. Методическая разработка урока по теме Энергосбережение. (8 класс)

Аттестационная работа. Методическая разработка урока по теме Энергосбережение. (8 класс) Образование гидридов

Образование гидридов Презентация по физике Тепловые явления Выполнила: ученица 8 «А» класса ГОУ СОШ №1973 Прохорчик Светлана

Презентация по физике Тепловые явления Выполнила: ученица 8 «А» класса ГОУ СОШ №1973 Прохорчик Светлана Физико-технические основы рентгенологии

Физико-технические основы рентгенологии Фрикционные передачи

Фрикционные передачи Закон сохранения импульса. Реактивное движение в природе и технике

Закон сохранения импульса. Реактивное движение в природе и технике Презентация по физике "Собирающие линзы" - скачать

Презентация по физике "Собирающие линзы" - скачать  Механика твердого тела. (Лекция 4)

Механика твердого тела. (Лекция 4) Применения технологии развивающего обучения в 5 классе

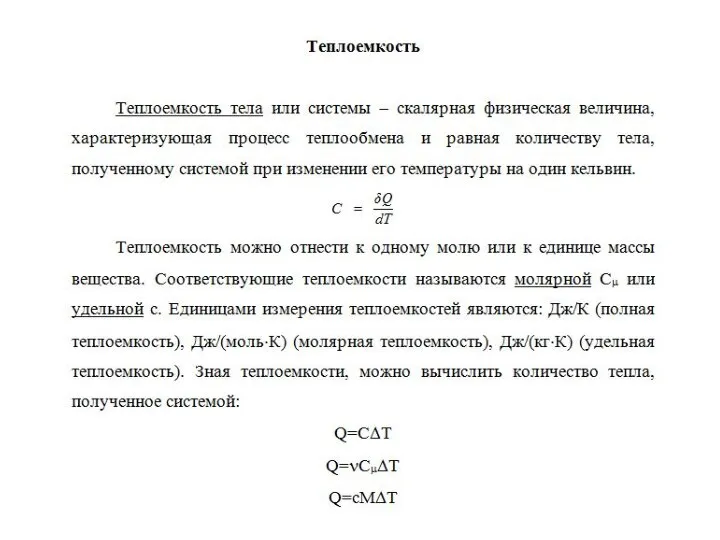

Применения технологии развивающего обучения в 5 классе Теплоёмкость

Теплоёмкость Электромагнитные волны

Электромагнитные волны Резонанс у медицині Підготувала Учениця 11 класу Герасименко Анастасія

Резонанс у медицині Підготувала Учениця 11 класу Герасименко Анастасія  Внутренний мир светового луча

Внутренний мир светового луча Почему же проводники нагреваются

Почему же проводники нагреваются Презентация по физике Статика

Презентация по физике Статика  МИНИСТЕРСТВО ОБРАЗОВАНИЯ И НАУКИ РОССИЙСКОЙ ФЕДЕРАЦИИ ФЕДЕРАЛЬНОЕ ГОСУДАРСТВЕННОЕ БЮДЖЕТНОЕ О

МИНИСТЕРСТВО ОБРАЗОВАНИЯ И НАУКИ РОССИЙСКОЙ ФЕДЕРАЦИИ ФЕДЕРАЛЬНОЕ ГОСУДАРСТВЕННОЕ БЮДЖЕТНОЕ О Сила упругости. Закон Гука

Сила упругости. Закон Гука Биофизика, как наука. История и методология биофизики. Кинетика биологических процессов. Термодинамика биологических процессов

Биофизика, как наука. История и методология биофизики. Кинетика биологических процессов. Термодинамика биологических процессов Закон всемирного тяготения

Закон всемирного тяготения Спектроскопические методы анализа

Спектроскопические методы анализа Структура и спектральнолюминесцентные свойства микрокристаллических трубок на основе ZrO2

Структура и спектральнолюминесцентные свойства микрокристаллических трубок на основе ZrO2 Биполярные транзисторы

Биполярные транзисторы Физика и детская игрушка (урок – выставка) Гриневич Л.А., учитель физики МОУ СОШ № 1 г. Богданович

Физика и детская игрушка (урок – выставка) Гриневич Л.А., учитель физики МОУ СОШ № 1 г. Богданович Планы ускорений плоских механизмов

Планы ускорений плоских механизмов Программа для решения физических задач

Программа для решения физических задач Квантовые статистики

Квантовые статистики The Electric Field

The Electric Field Элементарные частицы

Элементарные частицы