Содержание

- 2. Информатика Термин "информатика" (франц. informatique) происходит от французских слов information (информация) и automatique (автоматика) и дословно

- 3. В 1978 году международный научный конгресс официально закрепил за понятием "информатика" области, связанные с разработкой, созданием,

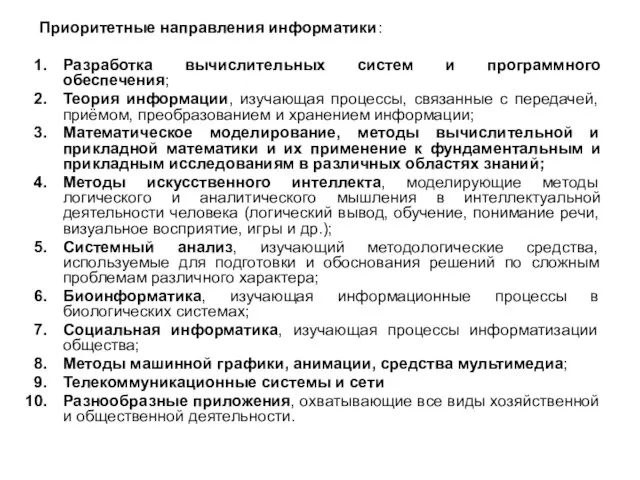

- 4. Приоритетные направления информатики: Разpаботка вычислительных систем и пpогpаммного обеспечения; Теоpия инфоpмации, изучающая процессы, связанные с передачей,

- 5. Информация (informatio, лат.) – разъяснение, изложение для конкретного человека – интересующие его сведения об окружающем мире;

- 6. в теории связи – сообщения в форме знаков или сигналов, которые хранятся, обрабатываются и передаются с

- 7. Измерение информации 4 подхода к измерению информации: 1. Объемный подход 2. Алфавитный подход 3. Содержательный подход

- 8. 1. Объемный подход. Это измерение информации с точки зрения объема, который она занимает в памяти ЭВМ.

- 9. Пример 1. Получено сообщение, объём которого равен 45 битам. Определить, чему равен объём сообщения в Кбайтах.

- 10. Пример 2. Какую часть диска емкостью 210 Мб занимают два файла объемом 250 байт и 120

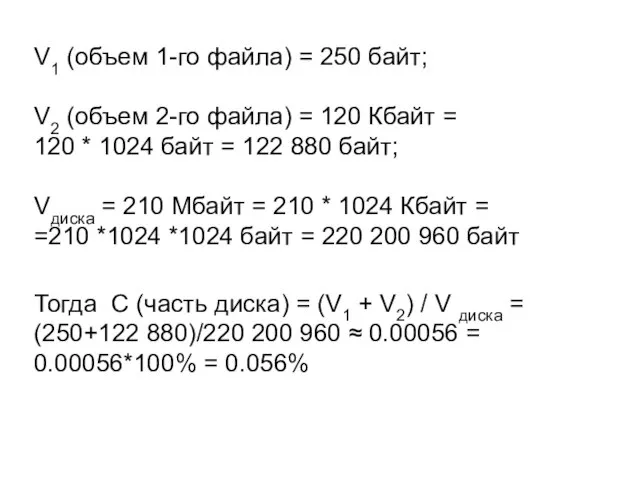

- 11. V1 (объем 1-го файла) = 250 байт; V2 (объем 2-го файла) = 120 Кбайт = 120

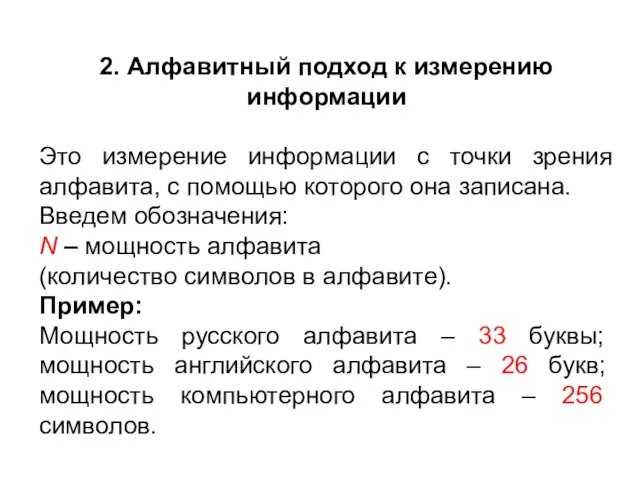

- 12. 2. Алфавитный подход к измерению информации Это измерение информации с точки зрения алфавита, с помощью которого

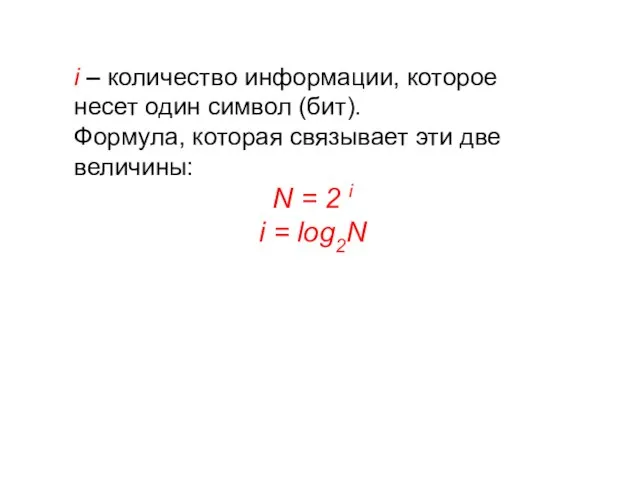

- 13. i – количество информации, которое несет один символ (бит). Формула, которая связывает эти две величины: N

- 14. K – количество символов в сообщении. V – объем информации во всем сообщении, записанном с использованием

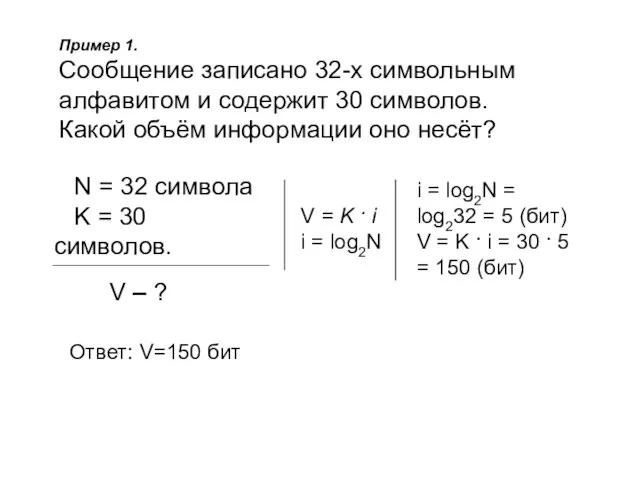

- 15. Пример 1. Сообщение записано 32-х символьным алфавитом и содержит 30 символов. Какой объём информации оно несёт?

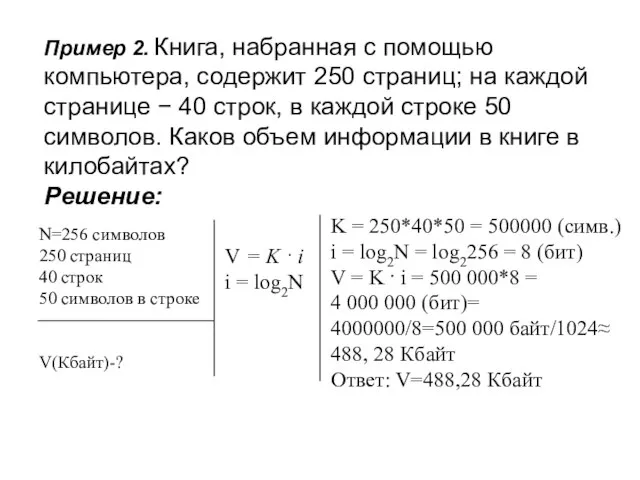

- 16. Пример 2. Книга, набранная с помощью компьютера, содержит 250 страниц; на каждой странице − 40 строк,

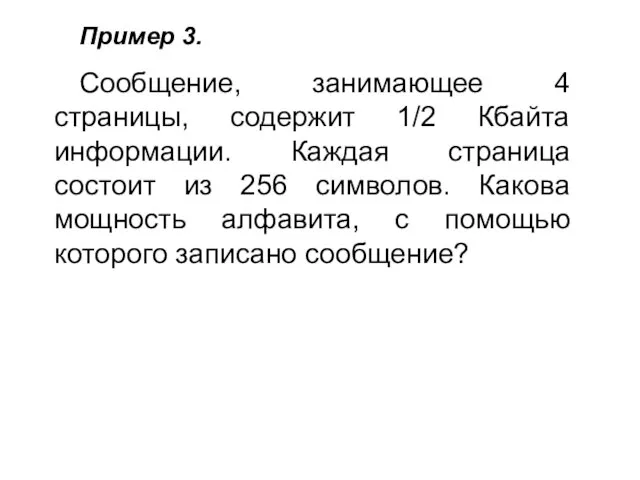

- 17. Пример 3. Сообщение, занимающее 4 страницы, содержит 1/2 Кбайта информации. Каждая страница состоит из 256 символов.

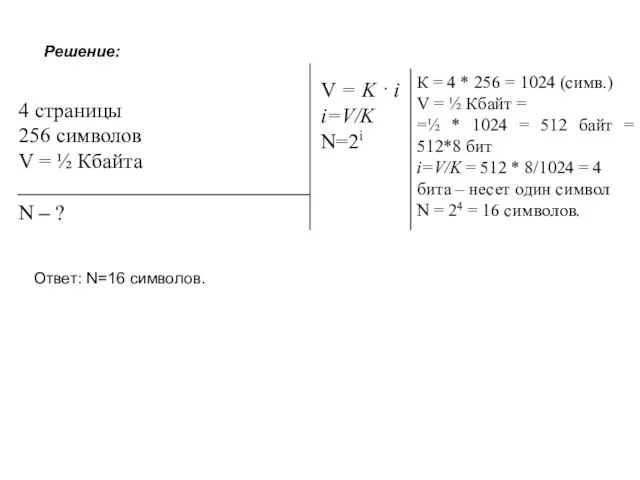

- 18. 4 страницы 256 символов V = ½ Кбайта N – ? Решение: V = K ·

- 19. 3. Содержательный подход к измерению информации Это измерение информации с точки зрения качественной оценки информации: нужности,

- 20. Введем обозначения: N – количество равновероятных событий (т.е. ни одно событие не имеет преимуществ перед другим).

- 21. Пример 1. В коробке 16 CD-дисков. Сколько информации несет сообщение о том, что нужный файл нашелся

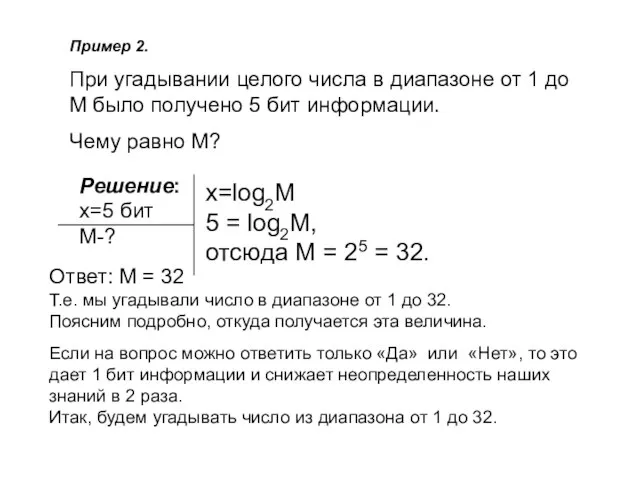

- 22. Пример 2. При угадывании целого числа в диапазоне от 1 до M было получено 5 бит

- 23. Допустим, мы загадали число 6 1 Вопрос: В диапазоне чисел от 1 до 32 ровно 32

- 24. 4 Вопрос: Аналогично предыдущему случаю: в первой половине (от 5 до 6) 2 числа и во

- 25. Пример 3. Сколько информации содержится в сообщении о том, что из колоды карт достали случайным образом

- 26. 4. Вероятностный подход к измерению информации Это измерение информации с точки зрения вероятности наступления какого-либо события.

- 27. Пример 1. Бросается игральный кубик. Какова вероятность выпадения четного числа очков? P=m/n n=6 m=3 p-? P=3/6=1/2

- 28. Пример 2. В гараже 15 автомобилей КАМАЗ, 12 автомобилей МАЗ и 3 автомобиля MAN. Найдите вероятности

- 29. Вероятностный подход Введем обозначения: pi – вероятность того, что наступило i-ое событие. ki – количество информации

- 30. Пример 3. В группе 24 студента. Какое количество информации несет сообщение о том, что Сергей Иванов

- 31. Пример 4. Студенты в группе за экзамен по информатике получили 10 пятерок, 5 четверок, 3 тройки

- 32. Энтропия Основоположник теории информации Клод Шеннон определил информацию, как снятую неопределенность. Точнее сказать, получение информации -

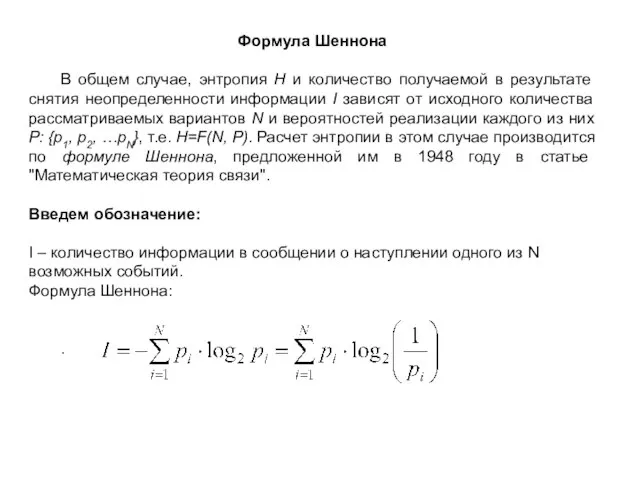

- 33. Формула Шеннона В общем случае, энтропия H и количество получаемой в результате снятия неопределенности информации I

- 35. Скачать презентацию

Требования к оформлению презентации

Требования к оформлению презентации Информационные технологии

Информационные технологии Базовая конфигурация компьютера Устройство компьютера

Базовая конфигурация компьютера Устройство компьютера Использование голосового помощника на уроках русского языка и литературы

Использование голосового помощника на уроках русского языка и литературы Графические редакторы

Графические редакторы Электронные таблицы Microsoft Excel

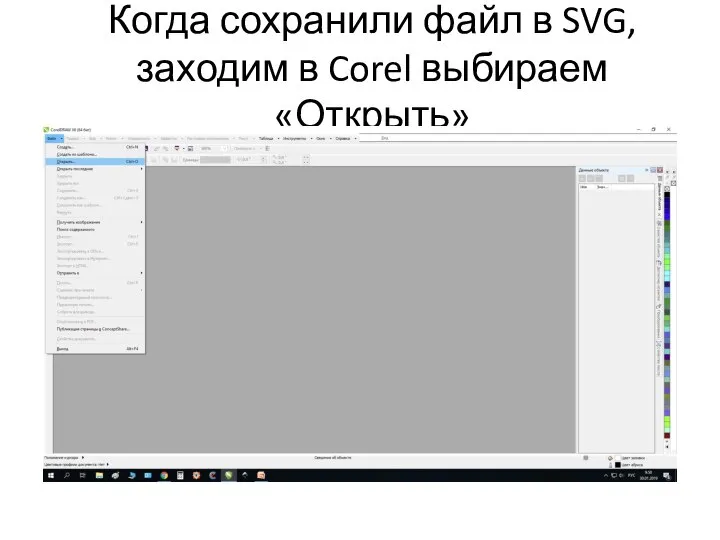

Электронные таблицы Microsoft Excel Инструкция по работе с веб-сайтом программного обеспечения Corel

Инструкция по работе с веб-сайтом программного обеспечения Corel Компьютерные вирусы и антивирусные программы

Компьютерные вирусы и антивирусные программы Основные элементы системы управления базами данных Access

Основные элементы системы управления базами данных Access Tree Sort Сортировка двоичным деревом

Tree Sort Сортировка двоичным деревом Site Integration Unit (SIU). Quick Start Guide

Site Integration Unit (SIU). Quick Start Guide Лекция 1-(03-09-2022)

Лекция 1-(03-09-2022) Определение и свойства алгоритма

Определение и свойства алгоритма Использование подзапросов для решения запросов

Использование подзапросов для решения запросов Компьютерная игра Скайрим

Компьютерная игра Скайрим Организация экономической информации

Организация экономической информации ПЯВУ. Основы программирования. Лекция 1. Переменные. Целочисленное деление. Двоичная система счисления

ПЯВУ. Основы программирования. Лекция 1. Переменные. Целочисленное деление. Двоичная система счисления Алгоритм RC4

Алгоритм RC4 Мем - смешная картинка

Мем - смешная картинка WEB-форматы

WEB-форматы История создания электроной почты и знака@

История создания электроной почты и знака@ Представление об организации баз данных и системах управления базами данных

Представление об организации баз данных и системах управления базами данных Разработка программ с использованием классов. C#

Разработка программ с использованием классов. C# Информационные технологии в муниципальном управлении

Информационные технологии в муниципальном управлении Решение задач по информатике. (9 класс)

Решение задач по информатике. (9 класс) Министерство образования и науки Республики Башкортостан Государственное бюджетное

Министерство образования и науки Республики Башкортостан Государственное бюджетное Чудесные животные

Чудесные животные Глубинное интервью в библиотечных исследованиях

Глубинное интервью в библиотечных исследованиях