Содержание

- 2. Разнообразие, большой объем и противоречивость различной диагностической информации выводят на передний план проблему поиска физических систем,

- 3. Нейросетевой подход: основные положения Процессы познания - результат взаимодействия большого числа простых перерабатывающих элементов, связанных друг

- 4. На сегодняшний день развитие в области теории и приложений нейронных сетей идет в самых разных направлениях:

- 5. Одна из наиболее привлекательных для пользователя сторон нейросетевой технологии, обеспечившая ей нынешнюю всеобщую популярность - отсутствие

- 6. Главное достоинство нейросетей в том, что они предоставляют в руки пользователю некий универсальный нелинейный элемент с

- 7. Набор нелинейных адаптивных элементов позволяет моделировать любое нелинейное преобразование и настраивать его на различные задачи автоматически

- 8. Место нейронных сетей в системах обработки информации можно указать по аналогии со структурой человеческой психики: оно

- 9. В общем случае в поведении нейросети следует различать три задачи: обучение и запоминание поведенческих образцов (эталонов),

- 10. В настоящее время широко распространено использование нейросетей в различных задачах, таких как распознавание ситуаций, выделение сигнала

- 11. Биологический нейрон и его кибернетическая модель Основная цель нейроинформатики - исследование методов и кибернетических систем, имитирующих

- 12. Метод нейробиологии Предмет нейробиологии - изучение нервной системы и ее главного органа - мозга. Принципиальный вопрос

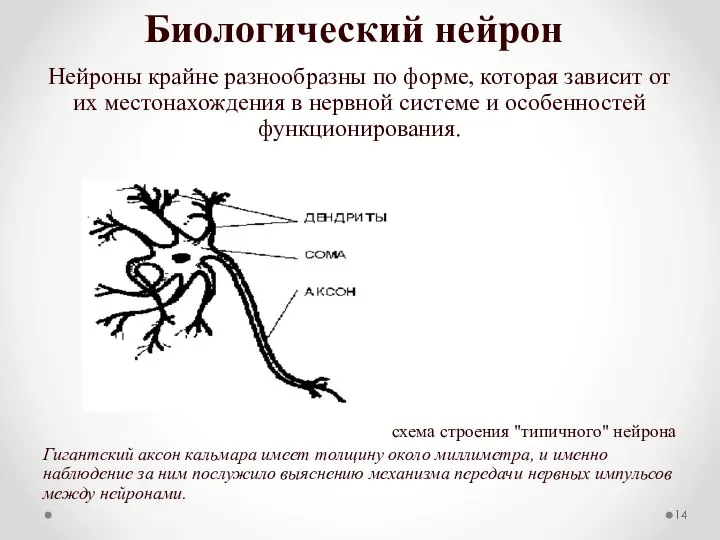

- 13. Биологический нейрон Элементом клеточной структуры мозга является нервная клетка - нейрон. Нейрон в своем строении имеет

- 14. Биологический нейрон Нейроны крайне разнообразны по форме, которая зависит от их местонахождения в нервной системе и

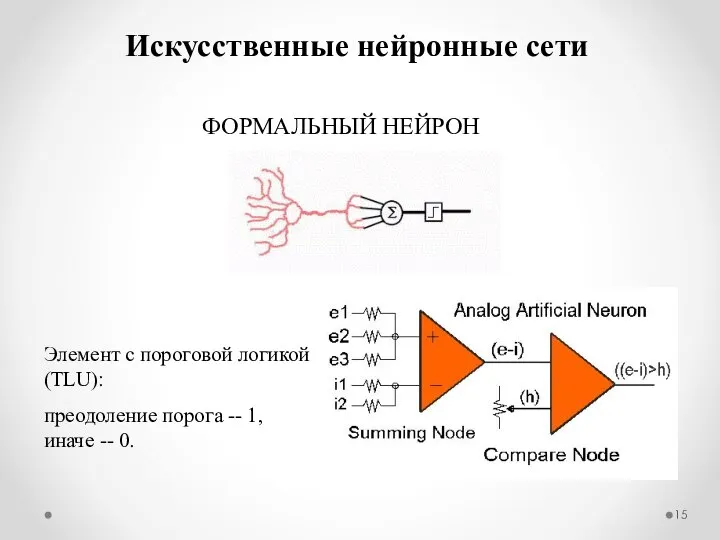

- 15. Искусственные нейронные сети ФОРМАЛЬНЫЙ НЕЙРОН Элемент с пороговой логикой (TLU): преодоление порога -- 1, иначе --

- 16. Механизмы синаптической передачи достаточно сложны и разнообразны. Они могут иметь химическую и электрическую природу. В химическом

- 17. Биологические нейронные сети Взаимодействующие между собой посредством передачи через отростки возбуждений нейроны формируют нейронные сети. Переход

- 18. Выделяют несколько основных типов биологических нейронных сетей, отличающихся структурой и назначением. Один из них - иерархические

- 19. Нейроны образуют два характерных типа соединений: конвергентные, когда большое число нейронов одного уровня контактирует с меньшим

- 20. Ко второму типу нейронных сетей относятся локальные сети, формируемые нейронами с ограниченными сферами влияния. Нейроны локальных

- 21. Важную роль также играют так называемые дивергентные сети с одним входом. Командный нейрон, находящийся в основании

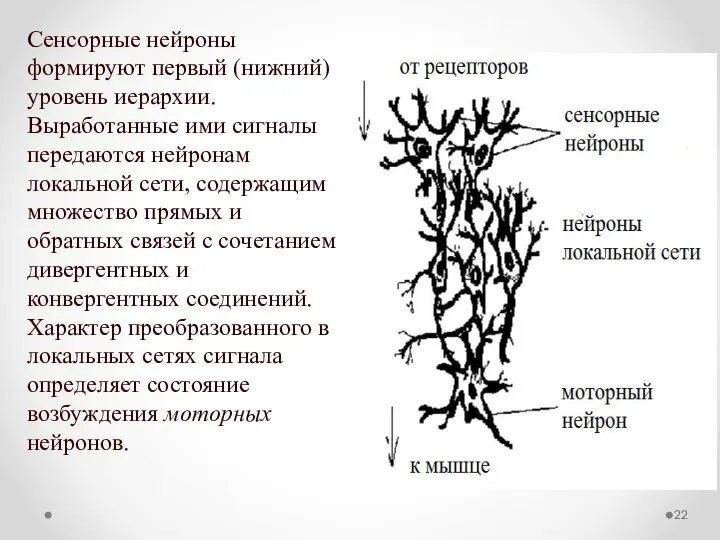

- 22. Сенсорные нейроны формируют первый (нижний) уровень иерархии. Выработанные ими сигналы передаются нейронам локальной сети, содержащим множество

- 23. Биологическая изменчивость и обучение нейронных сетей Структура основных типов биологических нейронных сетей генетически предопределена. При этом

- 24. Генетическая предопределенность имеет место также и в отношении свойств отдельных нейронов, таких, например, как тип используемого

- 25. Изменчивость на уровне сети связана со спецификой нейронов. Нервная ткань практически лишена характерной для других типов

- 26. Специфическая изменчивость нейронных сетей и свойств отдельных нейронов лежит в основе их способности к обучению -

- 27. Математический аппарат нейросетей Традиционно используемым для описания нейронных сетей математическим языком является аппарат векторной и матричной

- 28. Математический аппарат нейросетей Основным структурным элементом в описании способов обработки информации нейронной сетью является вектор -

- 29. Математический аппарат нейросетей Компоненты вектора x = ( x1, x2, ... xn ) можно рассматривать, как

- 30. Математический аппарат нейросетей Множество векторов с действительными компонентами является частным случаем более общего понятия, называемого линейным

- 31. Математический аппарат нейросетей Для двух элементов векторного пространства может быть определено их скалярное (внутреннее) произведение :

- 32. Математический аппарат нейросетей Два различных образа (или вектора) могут быть в той или иной мере похожи

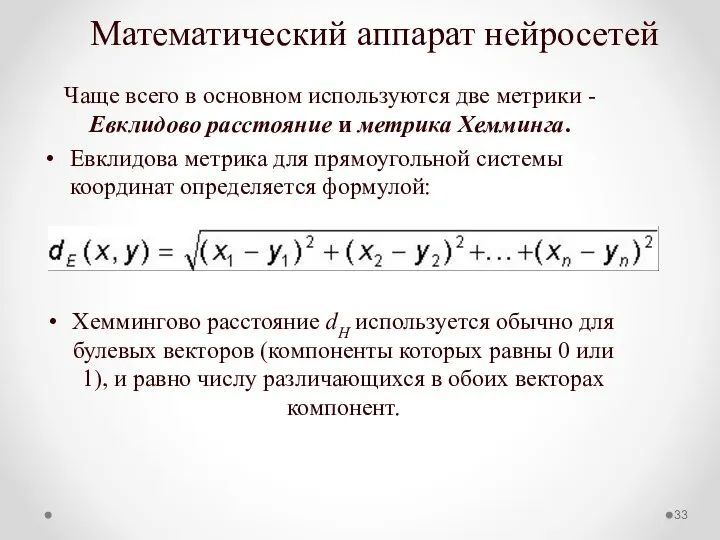

- 33. Математический аппарат нейросетей Чаще всего в основном используются две метрики - Евклидово расстояние и метрика Хемминга.

- 34. Математический аппарат нейросетей Для векторов вводится понятие нормы ||x|| - длины вектора x. Пространство в котором

- 35. Математический аппарат нейросетей Образы, состоящие из действительных признаков, принадлежат Евклидовому пространству. В случае булевых векторов размерности

- 36. Важным для нейросетевых приложений случаем является множество векторов, компоненты которых являются действительными числами, принадлежащими отрезку [0,1].

- 37. Для заданной совокупности признаков, определяющих пространство векторов, может быть сформирован такой минимальный набор векторов, в разной

- 38. Если определена некоторая система линейно независимых векторов x1, x2, ..., xm, где m Выбранная базовая система

- 39. Гиперплоскость делит пространство на две части. Совокупность гиперплоскостей разбивает пространство на несколько множеств, каждое из которых

- 40. Матрица – еще один способ математического представления данных в нейросетях. Пространство квадратных матриц одинаковой размерности с

- 41. Общие характеристики нейросетей Традиционно нейрон описывается в терминах, заимствованных из нейрофизиологии. Согласно этим представлениям, нейрон имеет:

- 42. С конструктивной точки зрения нейрон, являющийся основным элементом нейросети,- представляет собой устройство для получения нелинейной функции

- 43. Выходная величина уj является некоторой функцией от этой суммы: уj = f (s j) Ее называют

- 44. Функциональная схема формального нейрона: формальный нейрон представляет собой математическую модель простого процессора, имеющего несколько входов и

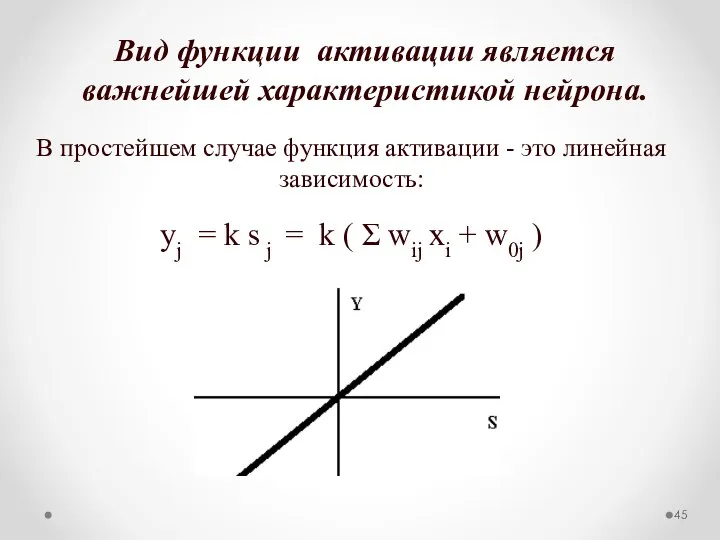

- 45. Вид функции активации является важнейшей характеристикой нейрона. В простейшем случае функция активации - это линейная зависимость:

- 46. Еще в работе У. Мак-Каллока и У. Питтса [1956 г.] использовалась ступенчатая функция активации, формально выражаемая

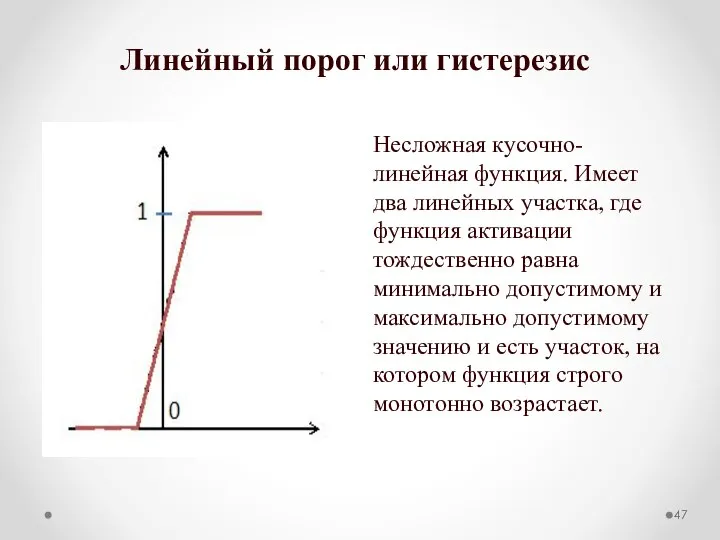

- 47. Линейный порог или гистерезис Несложная кусочно-линейная функция. Имеет два линейных участка, где функция активации тождественно равна

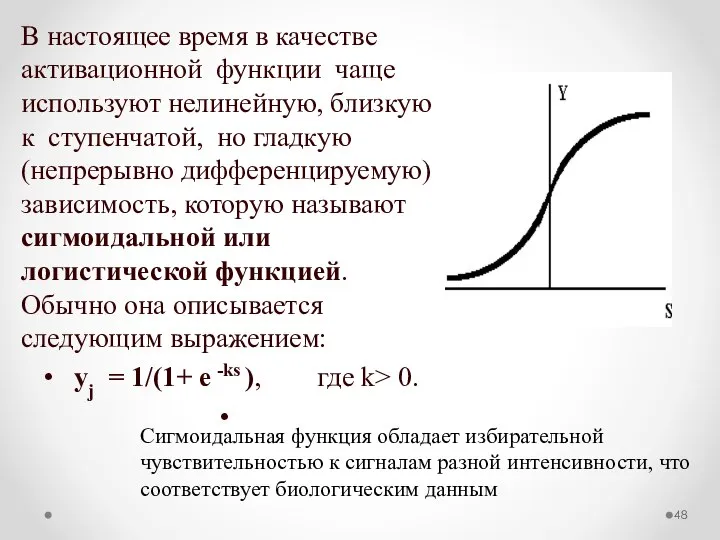

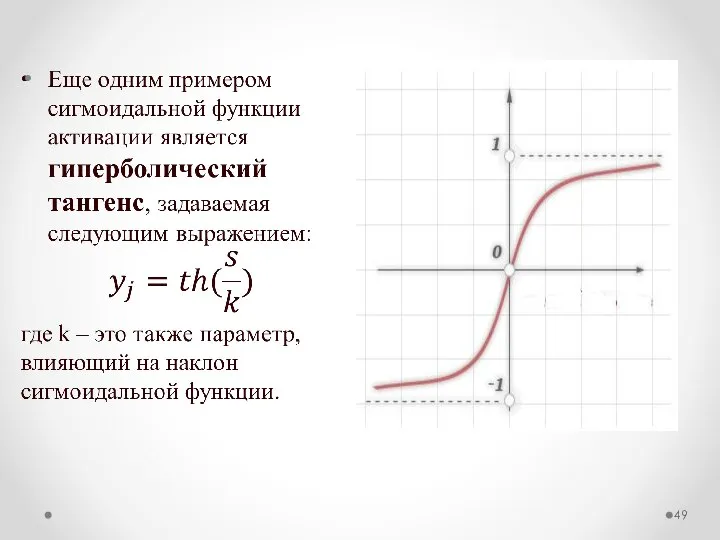

- 48. В настоящее время в качестве активационной функции чаще используют нелинейную, близкую к ступенчатой, но гладкую (непрерывно

- 50. Параметр k задает крутизну зависимости у от s: чем больше k, тем ближе сигмоида к пороговой

- 51. Нейроны организуются в сеть за счет того, что выход i-го нейрона (уi ) соединяется с одним

- 52. Важнейшим свойством нейрона является его пластичность - возможность изменять параметры в процессе обучения. В ранних работах

- 53. В настоящее время пороговую пластичность обычно сводят к синаптической с помощью следующей операции: К числу входов

- 54. Еще в 1949 г. Доналбдом Хеббом было предложено естественное правило модификации весовых коэффициентов: если два нейрона

- 55. Один из самых неожиданных результатов анализа работы искусственного нейрона (М.Минский и С.Пейперт) состоял в том, что

- 56. Одна из тенденций в развитии нейронных моделей состоит в переходе к более гибким и универсальным нелинейным

- 57. В последние годы все чаще появляются нейросети, использующие именно такого рода функции (радиальные базисные функции, ρ-функции

- 58. Итак, в целом архитектура нейросети может быть задана матрицей весовых коэффициентов w ij, характеризующих силу связей

- 59. Наложением условий на значения wij, предопределяется конфигурация сети. При этом из множества возможных конфигураций получили распространение

- 60. Задание 7 Описать структуру и основной алгоритм работы одной из следующих нейронных сетей: Персептрон Розенблатта; Многослойный

- 61. Основные принципы (свойства) нейросетей Согласно общепринятым представлениям наиболее общими принципами, характерными для современных нейросетей являются: коннекционизм

- 62. Принцип коннекционизма Означает, что каждый нейрон нейросети, как правило, связан со всеми нейронами предыдущего слоя обработки

- 63. Нелинейность функции активации Нелинейность функции активации принципиальна. Если бы нейроны были линейными элементами, то любая последовательность

- 64. Локальность обработки информации и параллелизм вычислений Локальность обработки информации и параллелизм вычислений в нейросетях означает, что

- 65. Обучение вместо программирования Режим распространения информации по сети и соответствующей ей адаптации нейронов носит характер обучения.

- 66. Оптимальность обучающих алгоритмов Еще одной чертой процесса обучения нейросетей является его оптимальность - целевая функция, оценивающая

- 67. Целевая функция Под целевой функцией обычно понимают минимум ошибки сети. В общем случае функция ошибки Ε

- 68. Обучение сети Базовой идеей всех алгоритмов обучения является учет локального градиента в пространстве конфигураций для выбора

- 69. Обучение сети Идеальный метод обучения должен находить глобальный оптимум конфигурации сети. Основные типы обучения нейросети: обучение

- 70. Обучение сети Обучение с учителем – это такой вид обучения, когда действительный выход нейросети сравнивается с

- 71. На способе обработки информации решающим образом сказывается наличие или отсутствие в сети петель обратных связей. Если

- 72. Наличие обратных связей может сделать динамику нейросети (называемой в этом случае рекуррентной) непредсказуемой: сеть может зациклиться

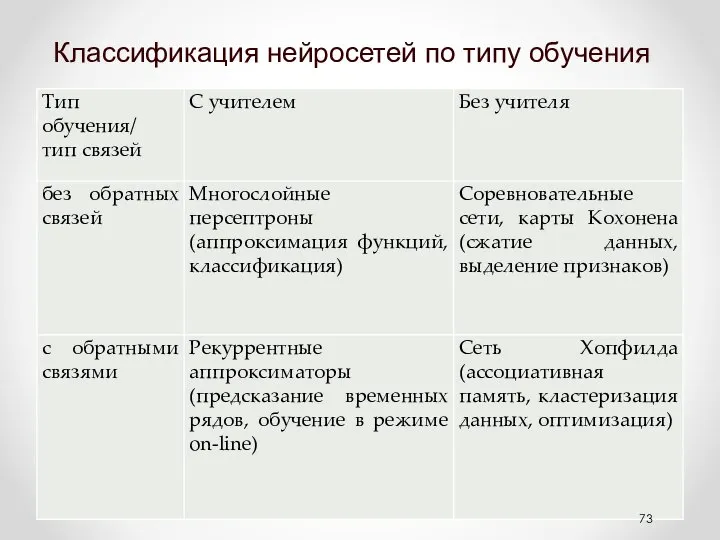

- 73. Классификация нейросетей по типу обучения

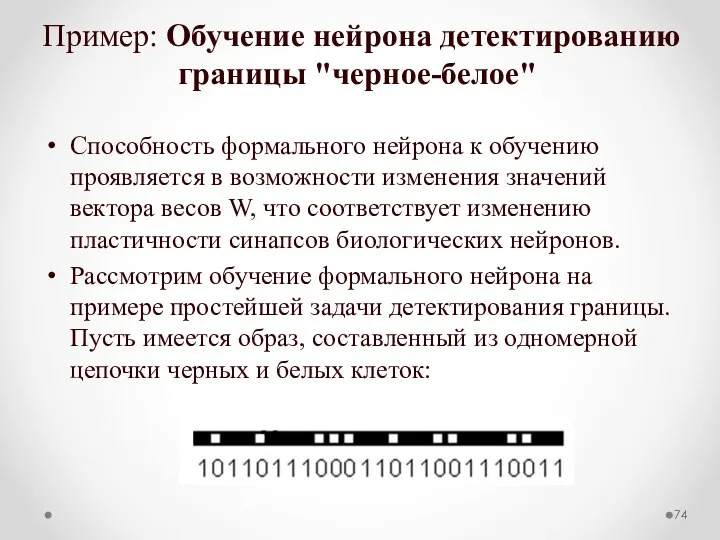

- 74. Пример: Обучение нейрона детектированию границы "черное-белое" Способность формального нейрона к обучению проявляется в возможности изменения значений

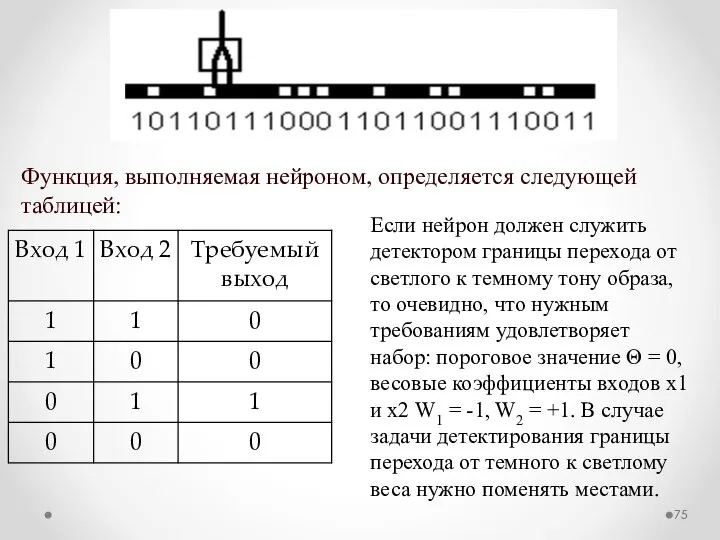

- 75. Функция, выполняемая нейроном, определяется следующей таблицей: Если нейрон должен служить детектором границы перехода от светлого к

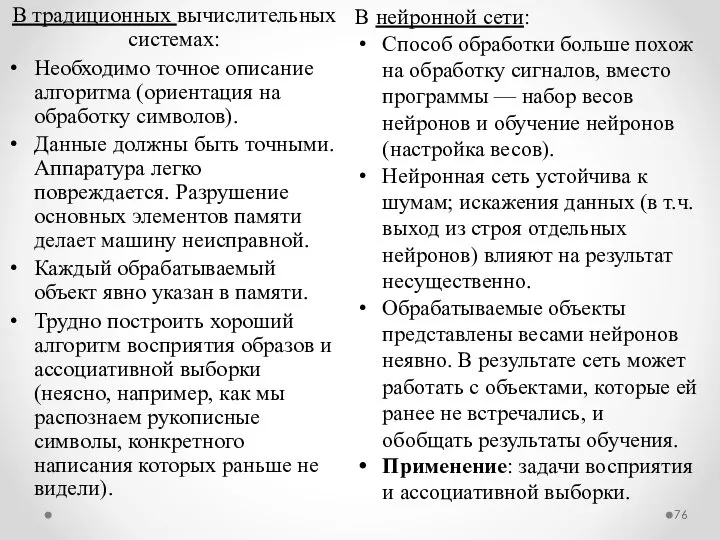

- 76. В традиционных вычислительных системах: Необходимо точное описание алгоритма (ориентация на обработку символов). Данные должны быть точными.

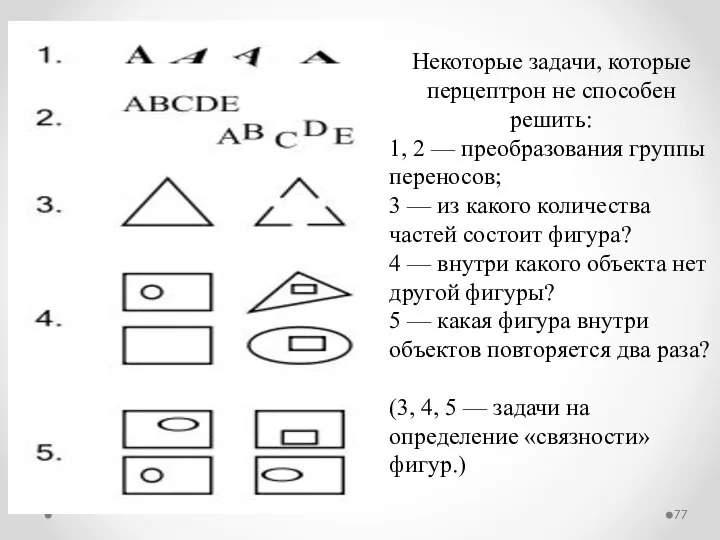

- 77. Некоторые задачи, которые перцептрон не способен решить: 1, 2 — преобразования группы переносов; 3 — из

- 79. Скачать презентацию

![Еще в работе У. Мак-Каллока и У. Питтса [1956 г.] использовалась](/_ipx/f_webp&q_80&fit_contain&s_1440x1080/imagesDir/jpg/1455660/slide-45.jpg)

Презентация Исследование функций и построение графиков

Презентация Исследование функций и построение графиков Основы программирования. Занятие №1

Основы программирования. Занятие №1 ОРГАНИЗАЦИЯ МЕЖДУНАРОДНЫХ ТОРГОВ

ОРГАНИЗАЦИЯ МЕЖДУНАРОДНЫХ ТОРГОВ  Задание-задача. ЕГЭ по обществознанию. (Задание 27)

Задание-задача. ЕГЭ по обществознанию. (Задание 27) Конструктивные особенности высокопроизводительных современных ЭВМ

Конструктивные особенности высокопроизводительных современных ЭВМ Эффективная мотивация персонала Доцент кафедры управления персоналом, сервиса и туризма , к.э.н Докашенко Людмила Владимиро

Эффективная мотивация персонала Доцент кафедры управления персоналом, сервиса и туризма , к.э.н Докашенко Людмила Владимиро Политические партии

Политические партии Дизайн жилья.

Дизайн жилья. Зміна та припинення трудових відносин

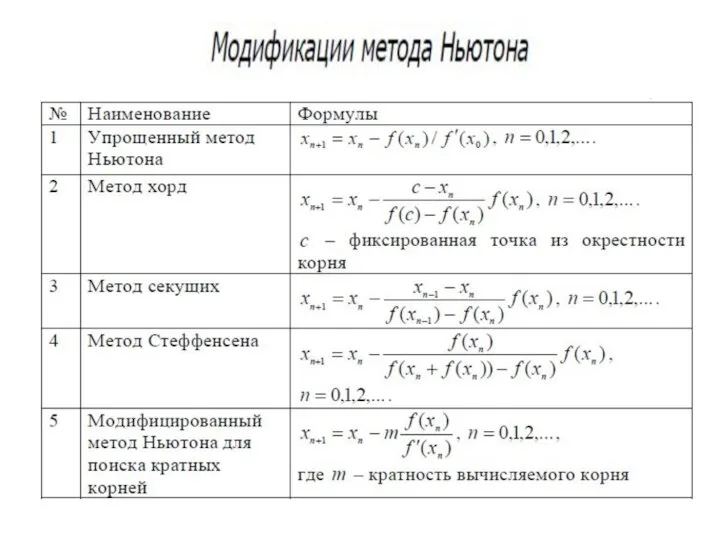

Зміна та припинення трудових відносин Модификация метода Ньютона

Модификация метода Ньютона  Жизнь Ленинградского хореографического училища в годы Великой Отечественной войны

Жизнь Ленинградского хореографического училища в годы Великой Отечественной войны Неразъёмные соединения

Неразъёмные соединения КЛИНИЧЕСКАЯ ФАРМАКОЛОГИЯ РЕНИН-АНГИОТЕНЗИН-АЛЬДОСТЕРОНОВОЙ СИСТЕМЫ (РААС)

КЛИНИЧЕСКАЯ ФАРМАКОЛОГИЯ РЕНИН-АНГИОТЕНЗИН-АЛЬДОСТЕРОНОВОЙ СИСТЕМЫ (РААС) Обзор структурных уровней

Обзор структурных уровней  Многофункциональная платформа для проектирования информационно-управляющих систем

Многофункциональная платформа для проектирования информационно-управляющих систем Фонетична система української мови

Фонетична система української мови Обновленная игра АК стандартный формат_примеры1_2

Обновленная игра АК стандартный формат_примеры1_2 Разработка и реализация стратегии компании

Разработка и реализация стратегии компании  Вера как дар

Вера как дар Понятие и предмет правоведения

Понятие и предмет правоведения  Сетевое сообщество как инструмент эффективного взаимодействия

Сетевое сообщество как инструмент эффективного взаимодействия Числа, которыми измеряется преступность

Числа, которыми измеряется преступность Гельмут Коль (Федеральный канцлер ФРГ 1982-1998 гг)

Гельмут Коль (Федеральный канцлер ФРГ 1982-1998 гг) Станислав Лем Эдем. - презентация

Станислав Лем Эдем. - презентация Реконструкція окремо розташованої нежитлової будівлі

Реконструкція окремо розташованої нежитлової будівлі Закон о банкротстве физических лиц усугубляет увеличение просроченной задолженности - плюсы

Закон о банкротстве физических лиц усугубляет увеличение просроченной задолженности - плюсы Агбис

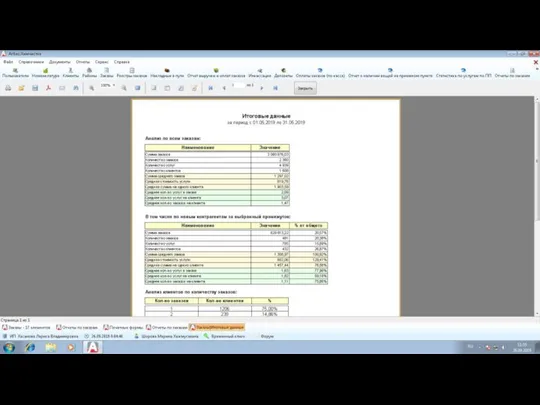

Агбис Регламентация малых закупок в Самарской области

Регламентация малых закупок в Самарской области