Содержание

- 2. Cовременные научные исследования требует совместной работы многих организаций по обработке большого объема данных в относительно короткие

- 3. На семинаре 4 июля 2012 года, посвященном наблюдению бозона Хиггса, директор ЦЕРНа Р.Хойер дал высокую оценку

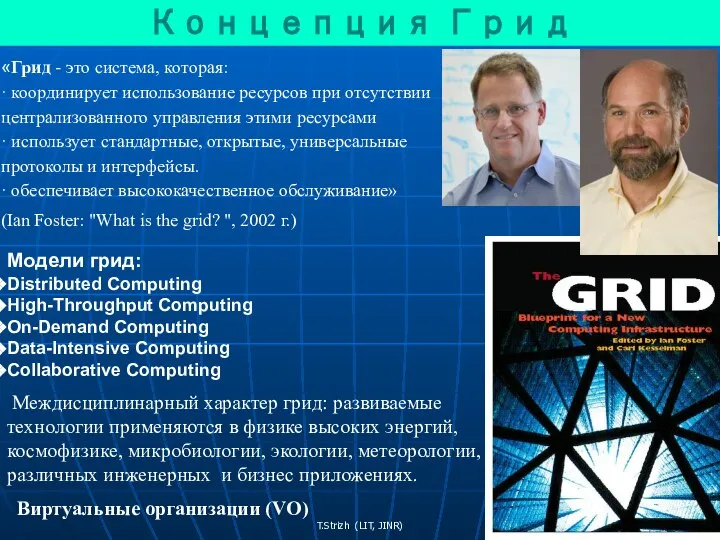

- 4. «Грид - это система, которая: · координирует использование ресурсов при отсутствии централизованного управления этими ресурсами ·

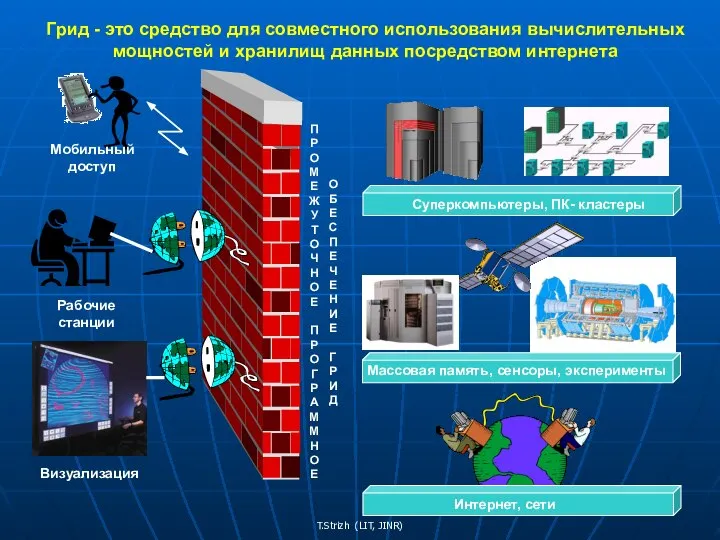

- 5. Грид - это средство для совместного использования вычислительных мощностей и хранилищ данных посредством интернета

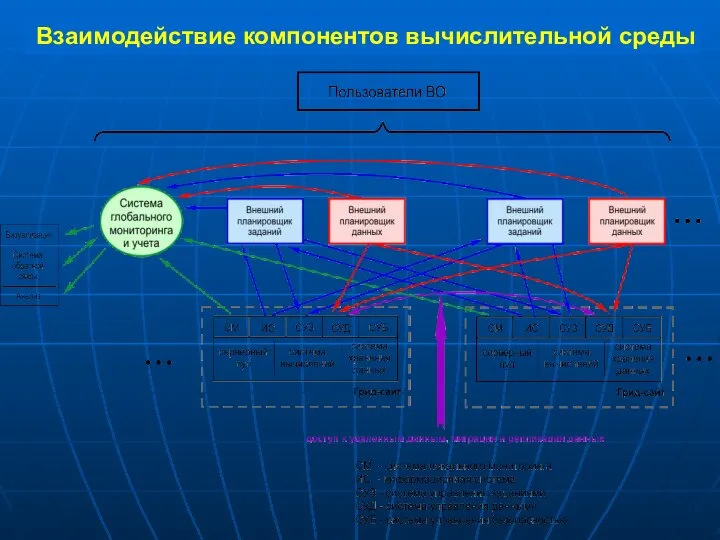

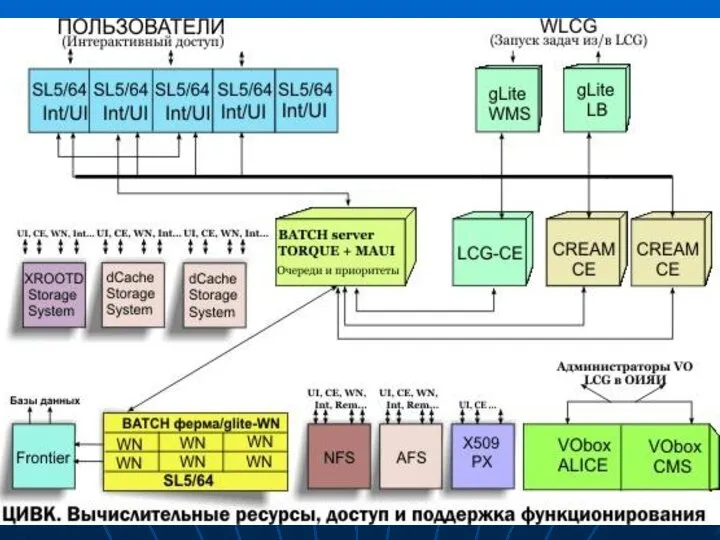

- 6. Взаимодействие компонентов вычислительной среды

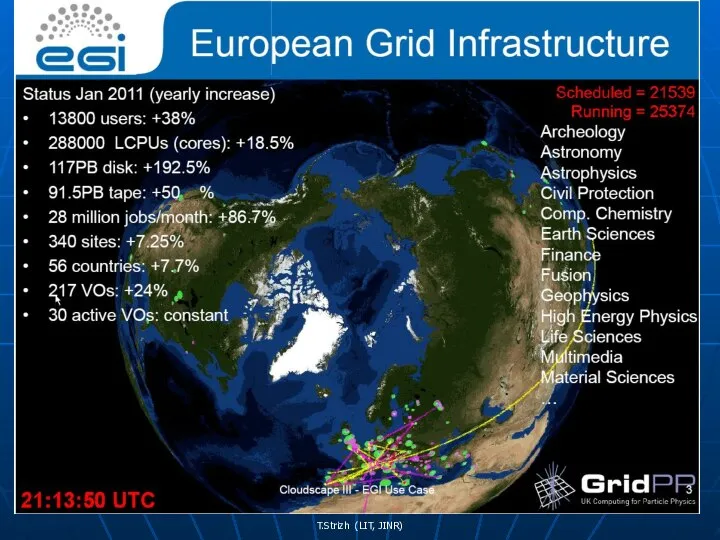

- 7. Этапы развития глобальной грид-инфраструктуры 2001-2003 EU DataGrid (проект европейской DataGrid-инфрастуктуры), С 2002 по наст. время WLCG:

- 8. T. Strizh Acting as the gatekeeper and matchmaker for the Grid, middleware monitors the Grid, decides

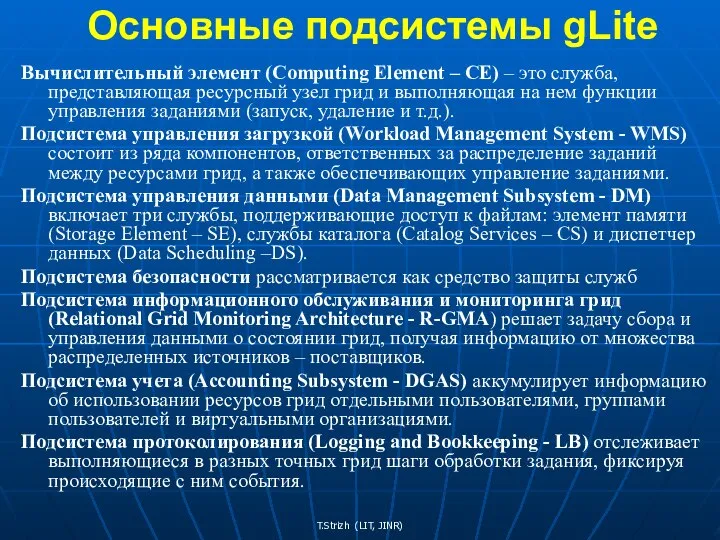

- 9. Основные подсистемы gLite Вычислительный элемент (Computing Element – CE) – это служба, представляющая ресурсный узел грид

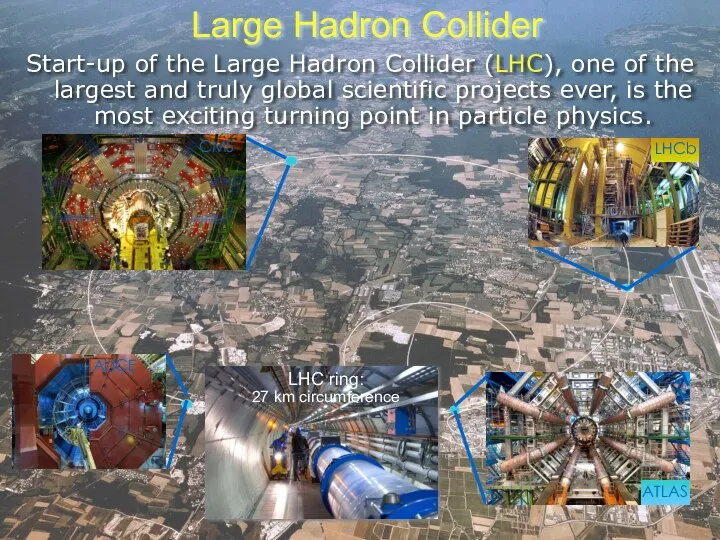

- 10. Large Hadron Collider Start-up of the Large Hadron Collider (LHC), one of the largest and truly

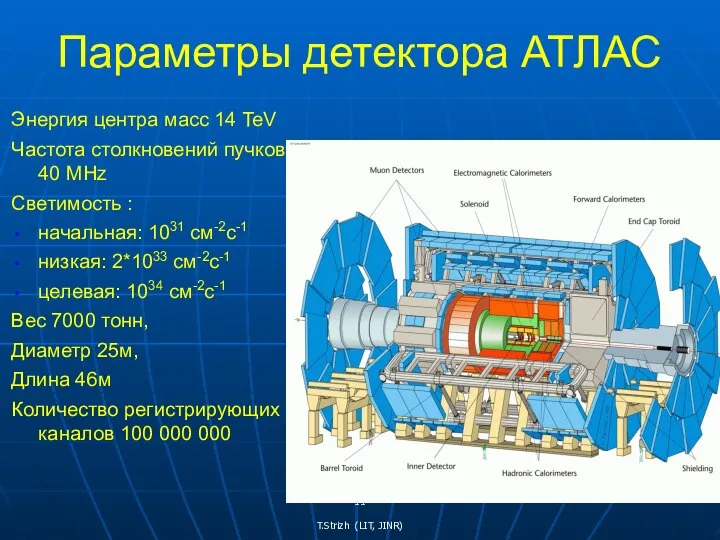

- 11. Параметры детектора АТЛАС Энергия центра масс 14 TeV Частота столкновений пучков 40 MHz Светимость : начальная:

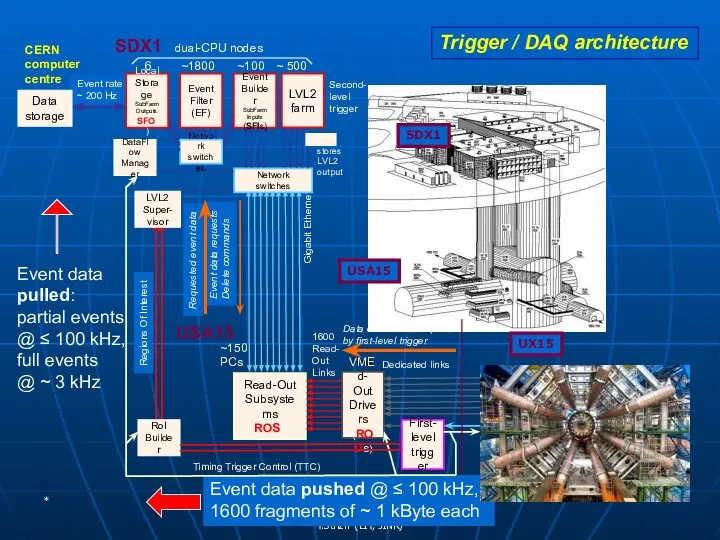

- 12. * Event data pulled: partial events @ ≤ 100 kHz, full events @ ~ 3 kHz

- 13. Ian.Bird@cern.ch 1.25 GB/sec (ions) Потоки данных от физических установок БАК до вычислительного центра ЦЕРН (Tier 0

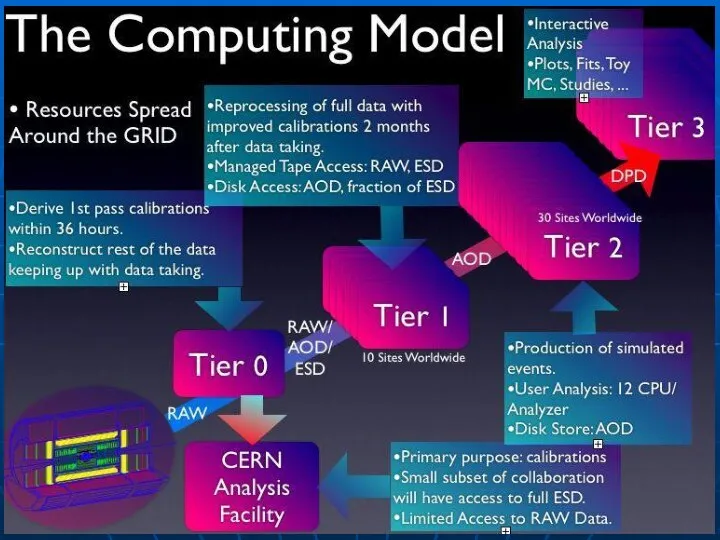

- 14. Взаимодействие уровней Tier 0 – Tier 1 – Tier 2 Tier-0 (CERN): 15% Прием данных Начальная

- 16. T. Strizh

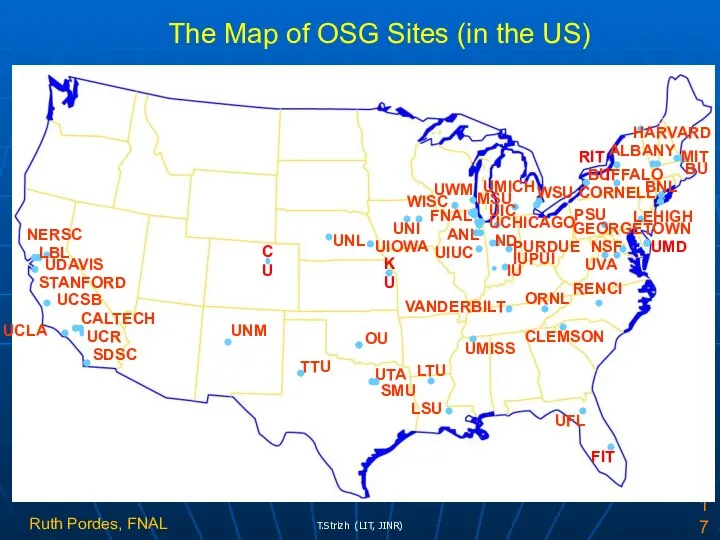

- 17. NERSC BU UNM SDSC UTA OU FNAL ANL WISC BNL VANDERBILT PSU UVA CALTECH PURDUE IU

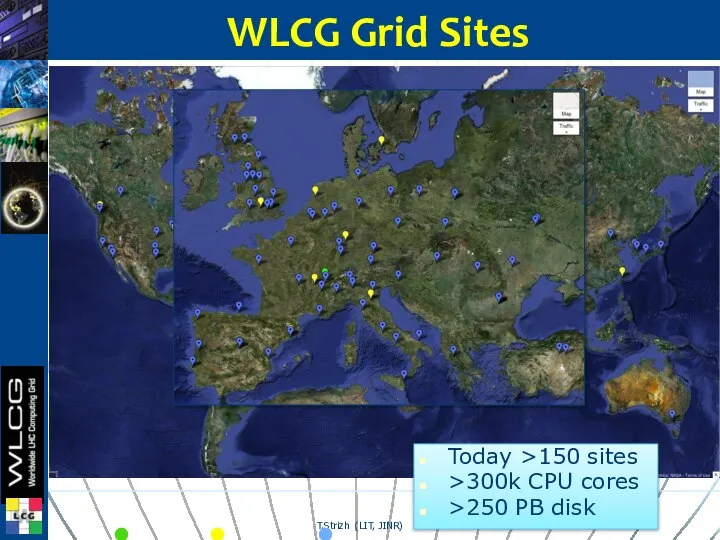

- 18. Tier 0 Tier 1 Tier 2 WLCG Grid Sites Today >150 sites >300k CPU cores >250

- 19. Российский консорциум RDIG (Russian Data Intensive Grid) был создан в 2003 году как национальная грид-федерация в

- 20. Ресурсы: 2582 вычислительных узлов Дисковое хранилище более 2 PB (Петабайт) В 2012 году выполнено более 6

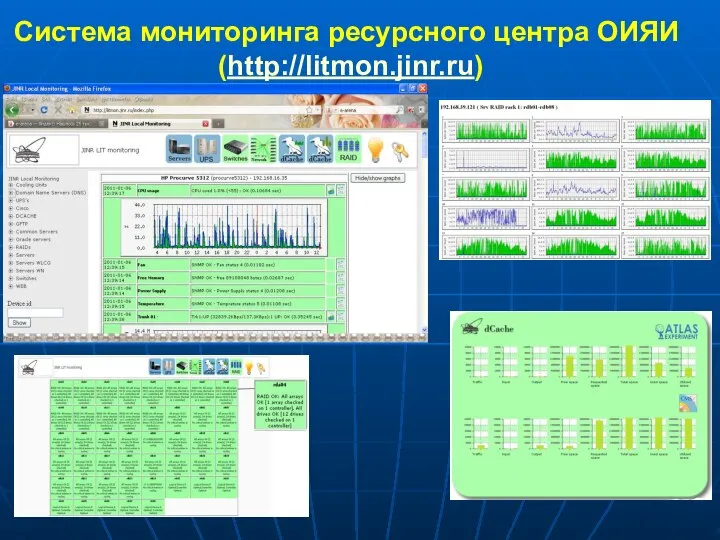

- 22. Система мониторинга ресурсного центра ОИЯИ (http://litmon.jinr.ru)

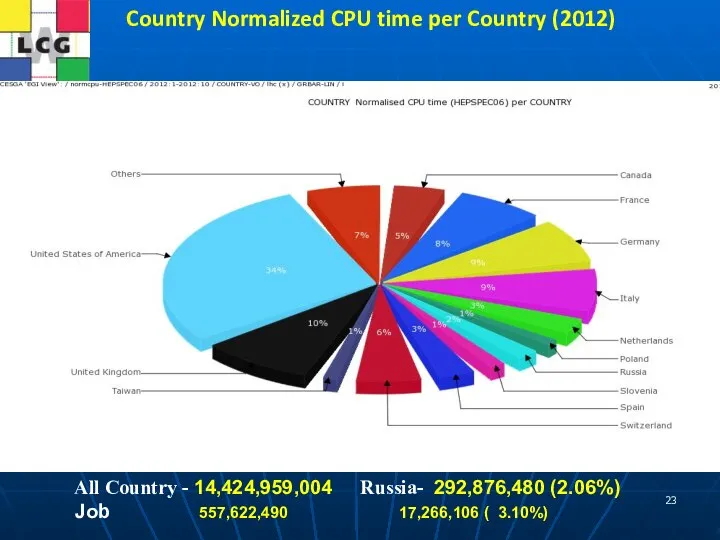

- 23. Country Normalized CPU time per Country (2012) All Country - 14,424,959,004 Russia- 292,876,480 (2.06%) Job 557,622,490

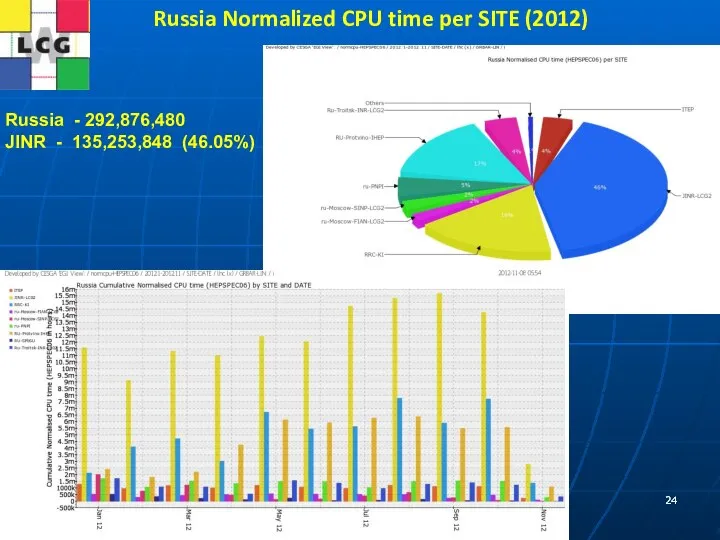

- 24. Russia Normalized CPU time per SITE (2012) Russia - 292,876,480 JINR - 135,253,848 (46.05%)

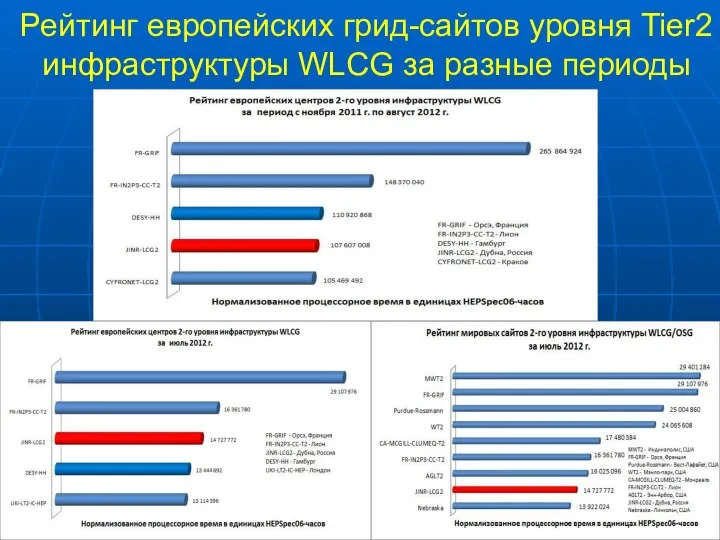

- 25. Рейтинг европейских грид-сайтов уровня Tier2 инфраструктуры WLCG за разные периоды

- 26. Worldwide LHC Computing Grid Project (WLCG) Основной задачей проекта WLCG является создание глобальной инфраструктуры региональных центров

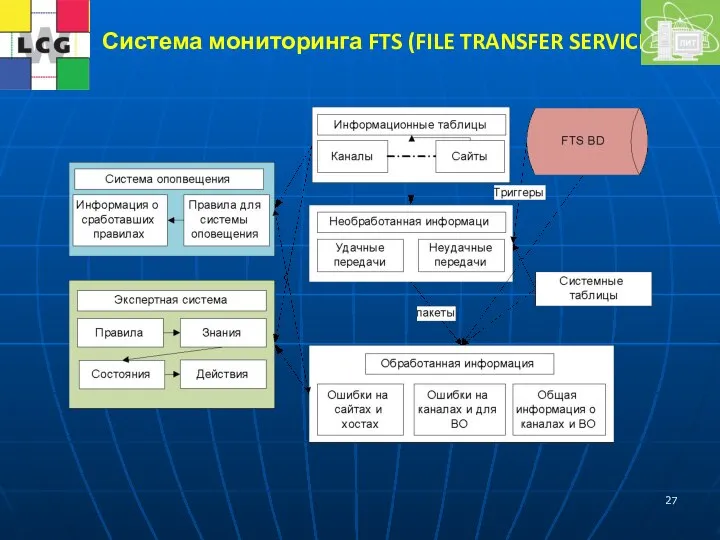

- 27. Система мониторинга FTS (FILE TRANSFER SERVICE)

- 28. WLCG – no stop for computing Activity on 3rd Jan

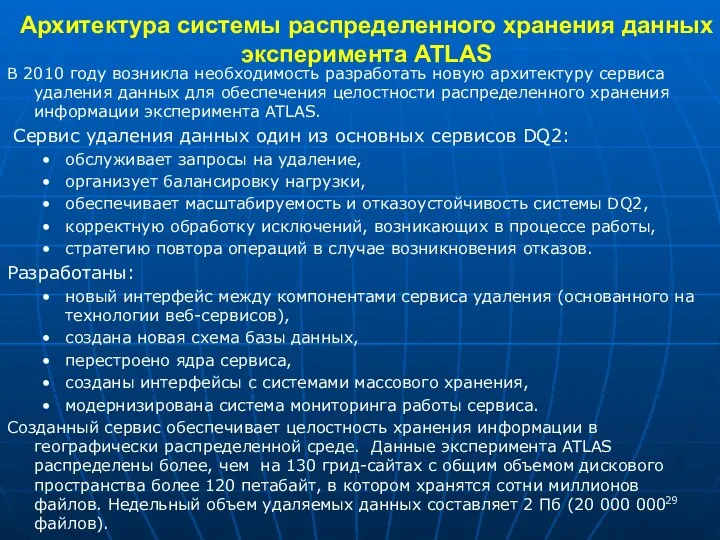

- 29. Архитектура системы распределенного хранения данных эксперимента ATLAS В 2010 году возникла необходимость разработать новую архитектуру сервиса

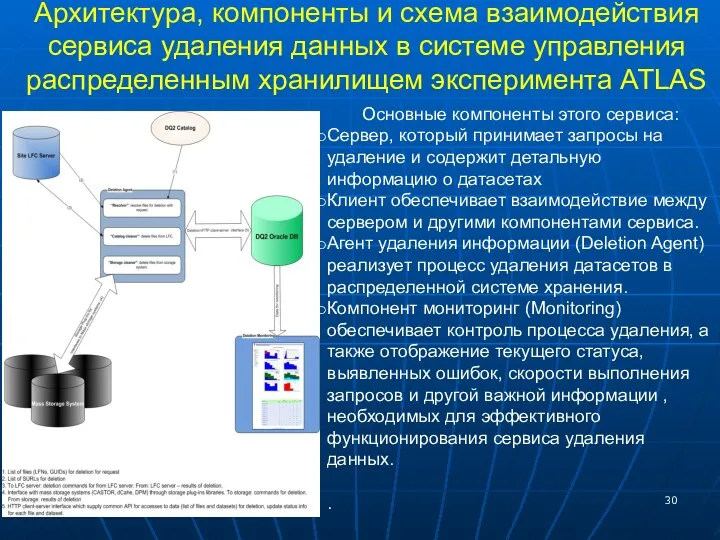

- 30. Архитектура, компоненты и схема взаимодействия сервиса удаления данных в системе управления распределенным хранилищем эксперимента ATLAS Основные

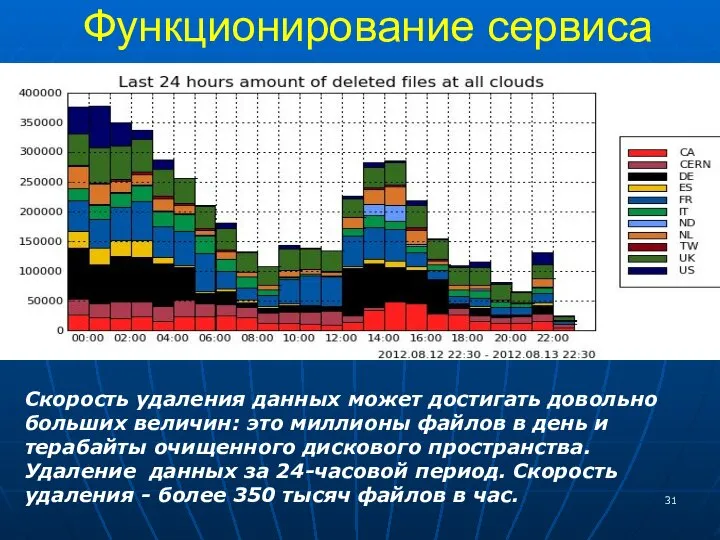

- 31. Функционирование сервиса Скорость удаления данных может достигать довольно больших величин: это миллионы файлов в день и

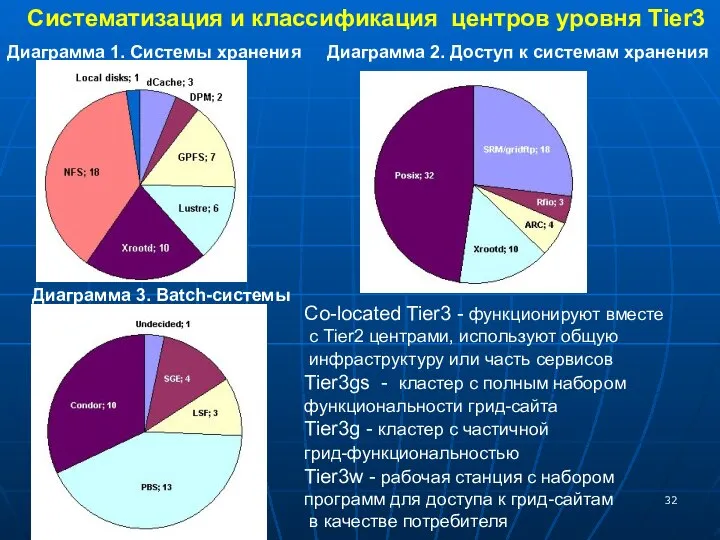

- 32. Систематизация и классификация центров уровня Tier3 Co-located Tier3 - функционируют вместе с Tier2 центрами, используют общую

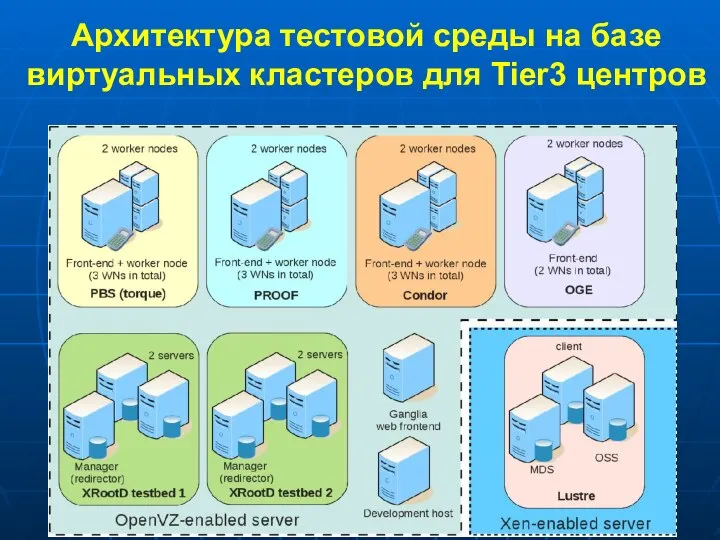

- 33. Архитектура тестовой среды на базе виртуальных кластеров для Tier3 центров

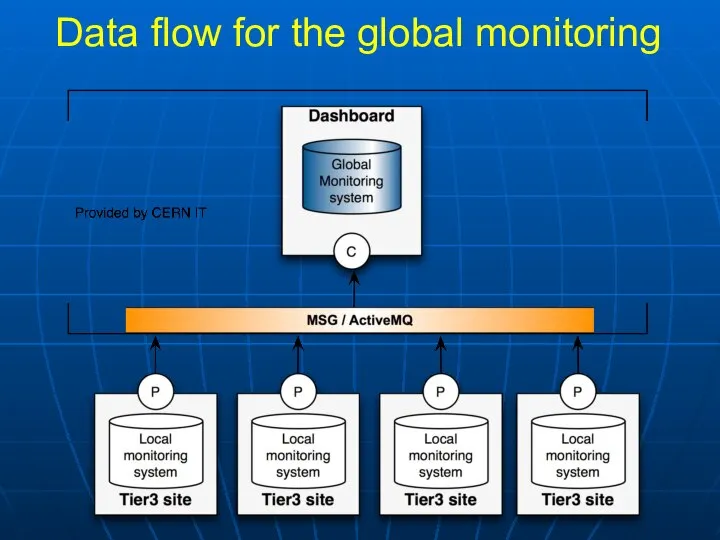

- 34. : . Система мониторинга Tier3-центров для анализа данных экспериментов БАК Реализация системы мониторинга Tier3 – центров

- 35. Data flow for the global monitoring

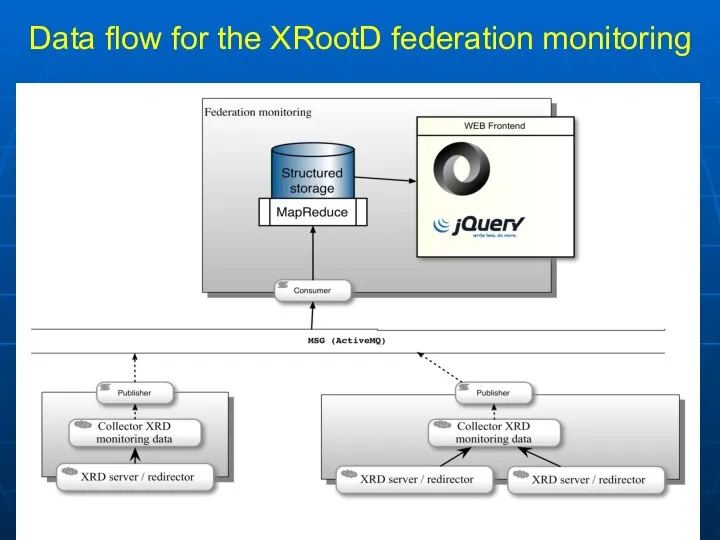

- 36. Data flow for the XRootD federation monitoring

- 37. Глобальная система мониторинга передачи данных в инфраструктуре WLCG Суть проекта состоит в создании универсальной системы мониторинга,

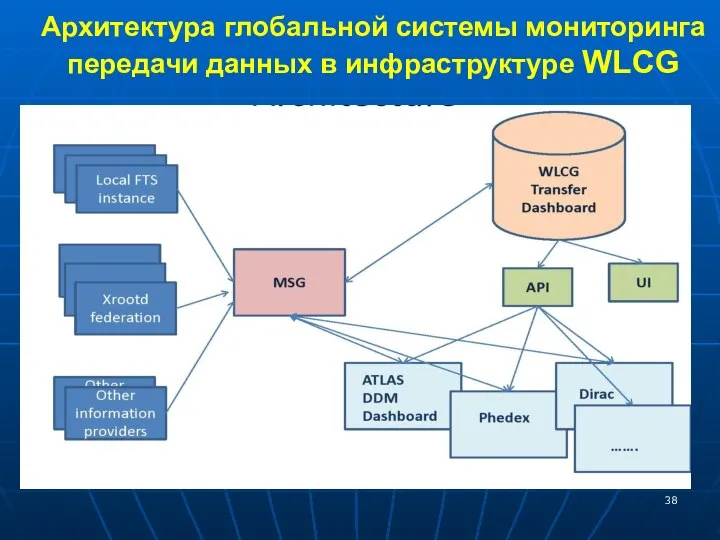

- 38. Архитектура глобальной системы мониторинга передачи данных в инфраструктуре WLCG

- 39. Архитектура учебно-исследовательской и тестовой инфраструктуры стран-участниц ОИЯИ Разработана архитектура учебно-исследовательской и тестовой инфраструктуры на базе технологий

- 40. Архитектура российской национальной нанотехнологической грид-сети (ГридННС) Совместно с другими научными центрами России была разработана архитектура проекта

- 41. Инфраструктура ГридННС 10 ресурсных центров (суперкомпьютеров) разных регионов России включены в инфраструктуру ГридННС

- 42. Российская грид-сеть Программа реализуется при поддержке Минкомсвязи для создания инфраструктуры распределенных вычислений в России, объединяющая суперкомпьютерные

- 43. Ускорительный комплекс НИКА Для проекта НИКА поток данных имеет следующие параметры: высокая скорость набора событий (до

- 44. Моделирование системы обработки экспериментов на ускорительном комплексе НИКА а) Какие вычислительные ресурсы необходимы для обработки данных;

- 45. С 2011 года идут подготовительные работы по созданию центра уровня Tier1 в России для обработки, хранения

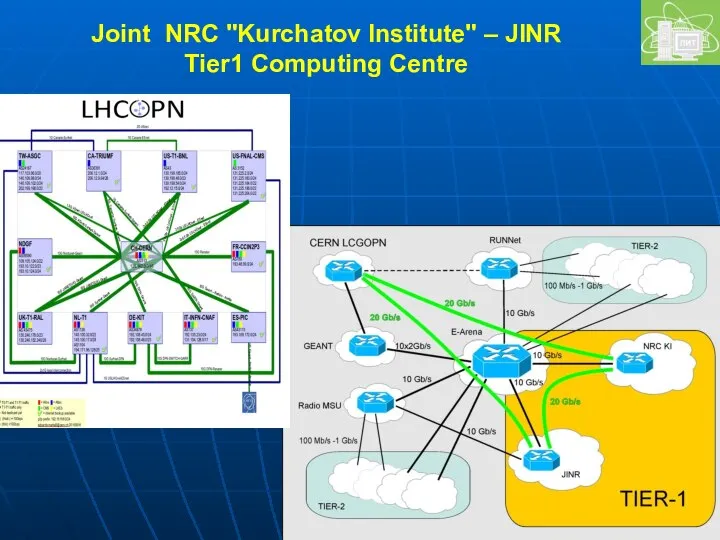

- 46. Joint NRC "Kurchatov Institute" – JINR Tier1 Computing Centre

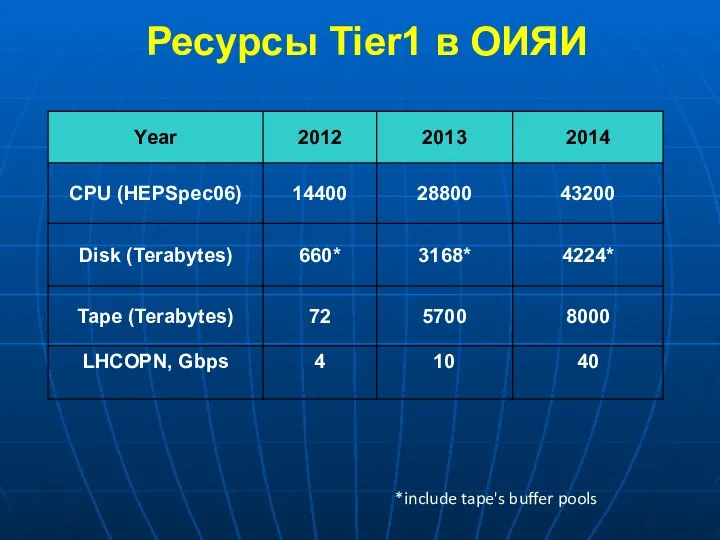

- 47. Ресурсы Tier1 в ОИЯИ *include tape's buffer pools

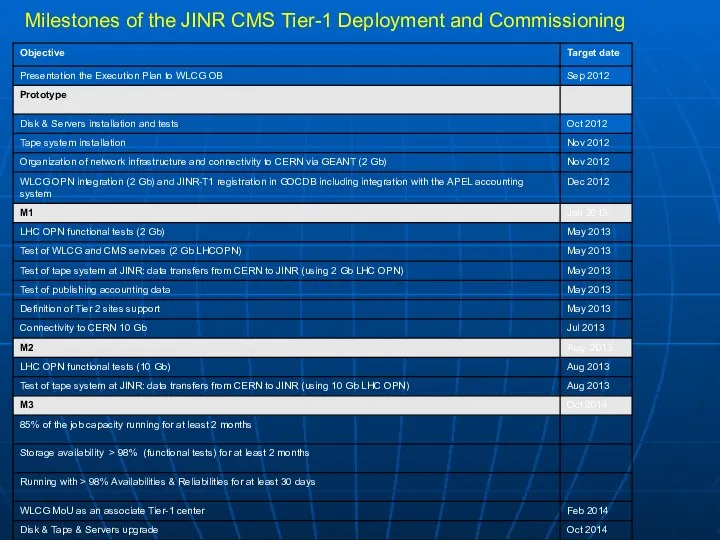

- 48. Milestones of the JINR CMS Tier-1 Deployment and Commissioning

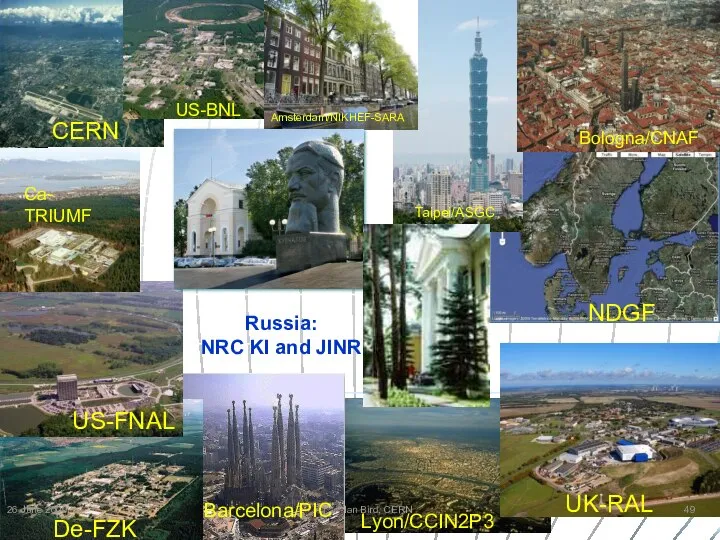

- 49. Barcelona/PIC Ian Bird, CERN 26 June 2009 Russia: NRC KI and JINR

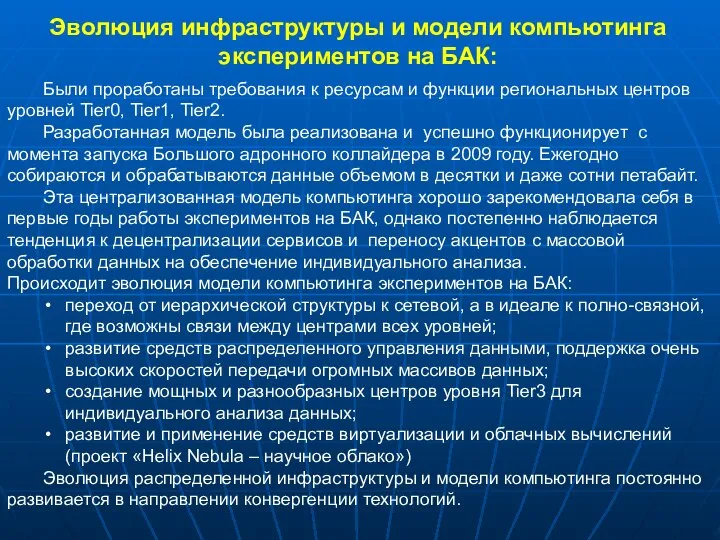

- 50. Были проработаны требования к ресурсам и функции региональных центров уровней Tier0, Tier1, Tier2. Разработанная модель была

- 51. Новые решения и перспективы в обработке «Больших Данных» Постоянно растущие объёмы научных данных ставят новые задачи

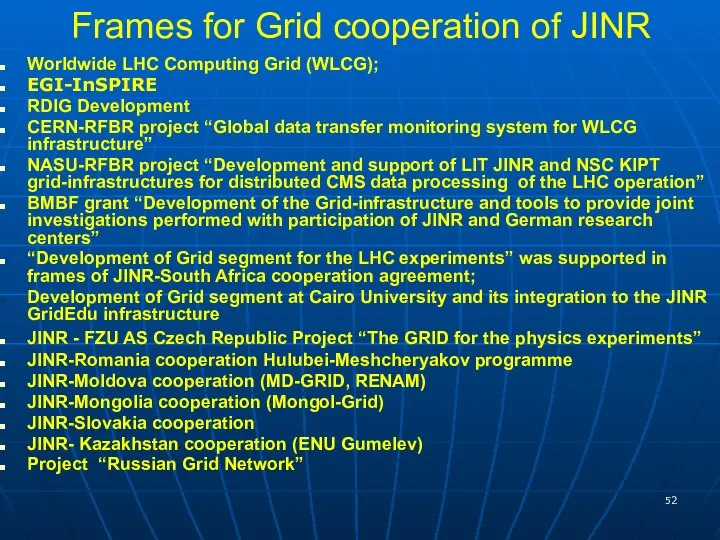

- 52. Frames for Grid cooperation of JINR Worldwide LHC Computing Grid (WLCG); EGI-InSPIRE RDIG Development CERN-RFBR project

- 53. GRID’2012 Conference 22 countries, 256 participants, 40 Universities and Institutes from Russia, 31 Plenary, 89 Section

- 54. http:// nec2011.jinr.ru

- 56. Скачать презентацию

Презентация "Оценка масштабов теневой экономики2" - скачать презентации по Экономике

Презентация "Оценка масштабов теневой экономики2" - скачать презентации по Экономике ВПМ. Математичне програмування та дослідження операцій. Основні аналітичні властивості задач ЛП. Канонічна форма. (Лекція 2)

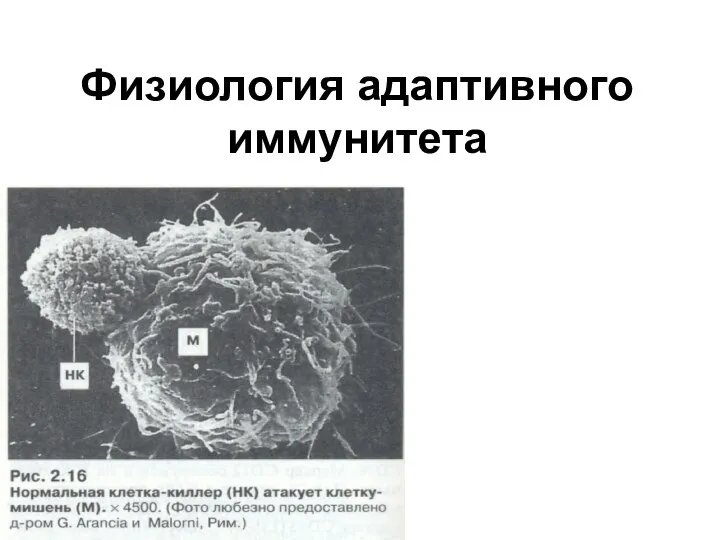

ВПМ. Математичне програмування та дослідження операцій. Основні аналітичні властивості задач ЛП. Канонічна форма. (Лекція 2) Физиология адаптивного иммунитета

Физиология адаптивного иммунитета Ислам. Коран

Ислам. Коран Контроль качества работ по возведению каменных конструкций

Контроль качества работ по возведению каменных конструкций Организация системы внеурочной, внешкольной деятельности по продвижению физической культуры и спорта

Организация системы внеурочной, внешкольной деятельности по продвижению физической культуры и спорта Особенности российского либерализма.Охранительный либерализм Чичерина и его концепция правового государства

Особенности российского либерализма.Охранительный либерализм Чичерина и его концепция правового государства Использование мультимедийных технологий на уроках Обидина М.Б.

Использование мультимедийных технологий на уроках Обидина М.Б. Чехов Антон Павлович биография

Чехов Антон Павлович биография  Состояние и перспективы развития российской химической и нефтехимической промышленности

Состояние и перспективы развития российской химической и нефтехимической промышленности Расположение точек относительно осей координат - презентация по Алгебре

Расположение точек относительно осей координат - презентация по Алгебре . Взаимодействие информационных технологий и бизнеса

. Взаимодействие информационных технологий и бизнеса КАРЛ ПАВЛОВИЧ БРЮЛОВ (1799-1852)

КАРЛ ПАВЛОВИЧ БРЮЛОВ (1799-1852) Презентация Актуальные вопросы и особенности прохождения государственной службы в таможенных органах

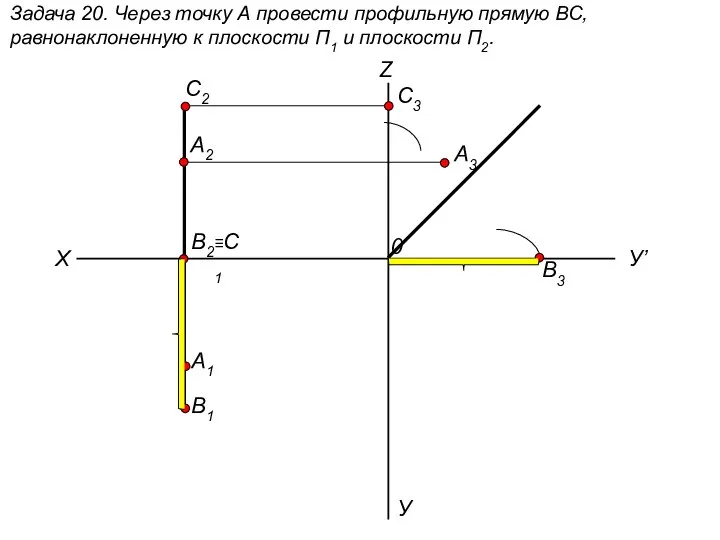

Презентация Актуальные вопросы и особенности прохождения государственной службы в таможенных органах  Через точку А провести профильную прямую ВС, равнонаклоненную к плоскости П1 и плоскости П2. (задача 20)

Через точку А провести профильную прямую ВС, равнонаклоненную к плоскости П1 и плоскости П2. (задача 20) Черные металлы

Черные металлы «Условия применения компьютерных программ в начальной школе» "Скажи мне, и я забуду. Покажи мне, - я см

«Условия применения компьютерных программ в начальной школе» "Скажи мне, и я забуду. Покажи мне, - я см Пасха

Пасха «Слова-паразиты, или экология речи» Исполнитель Пинчугина Алена Руководитель Карпенко Е.В., учитель русского языка

«Слова-паразиты, или экология речи» Исполнитель Пинчугина Алена Руководитель Карпенко Е.В., учитель русского языка Осмотр как следственное действие

Осмотр как следственное действие  Массивы. Заполнение массивов

Массивы. Заполнение массивов Геометрические построения на чертежах

Геометрические построения на чертежах Основы локальных вычислительных сетей

Основы локальных вычислительных сетей  Презентация Показатели динамики рынка зерна в рф

Презентация Показатели динамики рынка зерна в рф  свёртыв сист . группы крови

свёртыв сист . группы крови Кандидозный вульвовагинит

Кандидозный вульвовагинит Всемирный банк

Всемирный банк Виды республик и их признаки

Виды республик и их признаки