Содержание

- 2. Основаны на конкурентном обучении. Отдельные нейроны выходного слоя соревнуются за право активации, в результате активным оказывается

- 3. Характеризуются формированием топографических карт (topographic mар) входных образов, в которых пространственное местоположение (т.е. координаты) нейронов решетки

- 4. Двумерная решетка

- 5. Все нейроны этой решетки связаны со всеми узлами входного слоя. Эта сеть имеет структуру прямого распространения

- 6. Алгоритм, ответственный за формирование самоорганизующихся карт, начинается с инициализации синаптических весов сети. Обычно это происходит с

- 7. Конкуренция (competition). Для каждого входного образа нейроны сети вычисляют относительные значения дискриминантной функции. Эта функция является

- 8. - входной вектор - вектор синаптических весов l – общее количество нейронов сети Для того чтобы

- 9. При этом предполагается, что ко всем нейронам применяется некоторое значение насыщения (threshold). Эта величина равна порогу

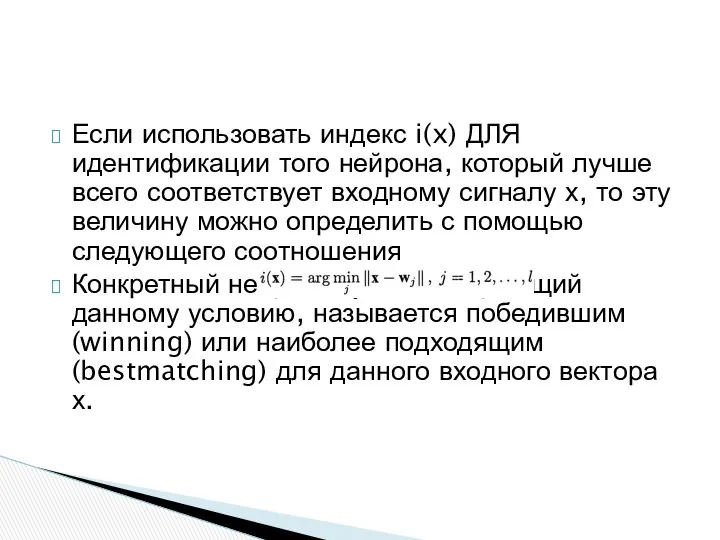

- 10. Если использовать индекс i(x) ДЛЯ идентификации того нейрона, который лучше всего соответствует входному сигналу х, то

- 11. Нейрон-победитель находится в центре топологической окрестности сотрудничающих нейронов. возбужденный нейрон всегда пытается возбудить пространственно близкие к

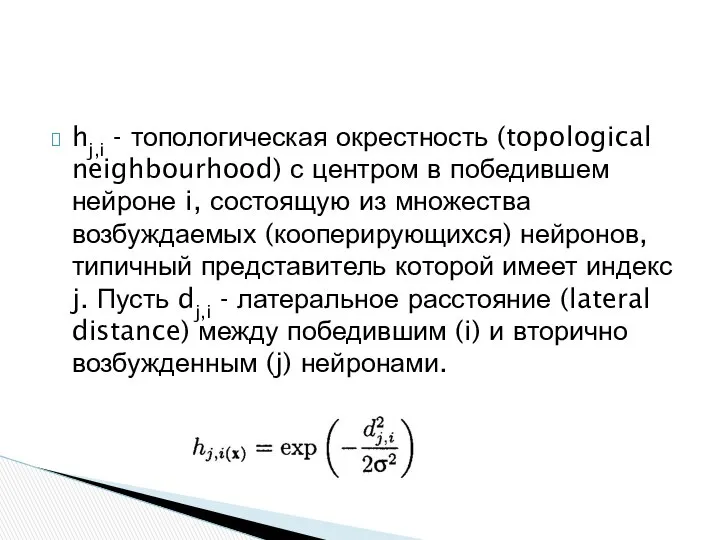

- 12. hj,i - топологическая окрестность (topological neighbourhood) с центром в победившем нейроне i, состоящую из множества возбуждаемых

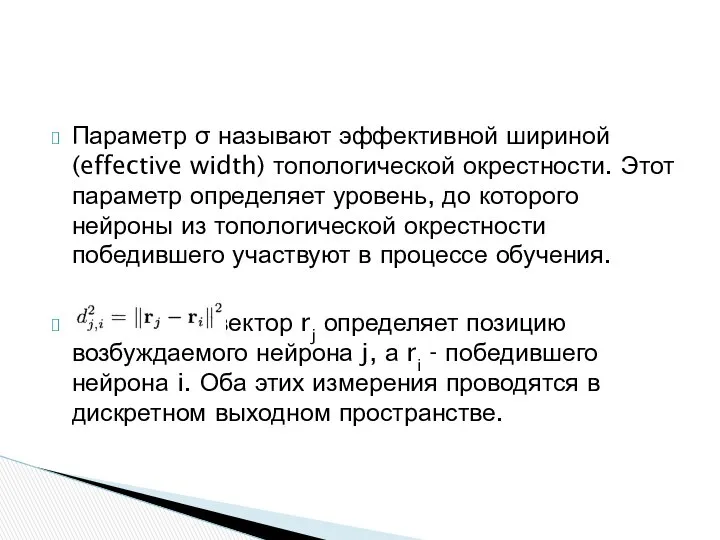

- 13. Параметр σ называют эффективной шириной (effective width) топологической окрестности. Этот параметр определяет уровень, до которого нейроны

- 14. σ0 начальное значение величины σ, τ1 – некоторая временная константа При увеличении количества итераций n ширина

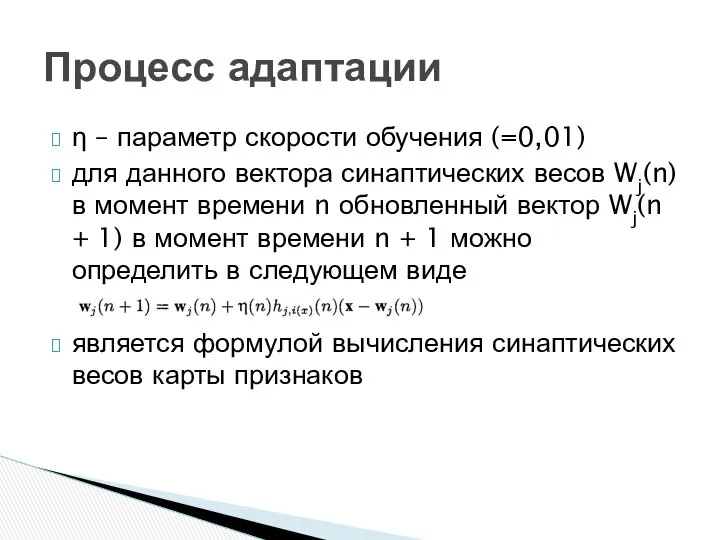

- 15. η – параметр скорости обучения (=0,01) для данного вектора синаптических весов Wj(n) в момент времени n

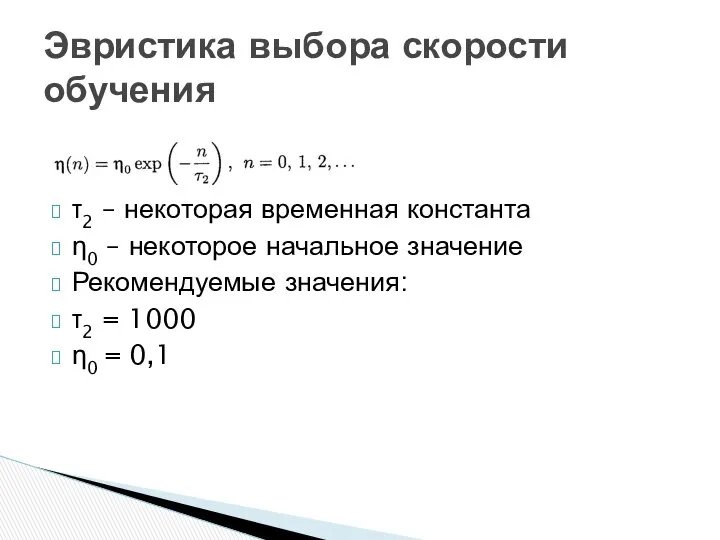

- 16. τ2 – некоторая временная константа η0 – некоторое начальное значение Рекомендуемые значения: τ2 = 1000 η0

- 18. Скачать презентацию

Презентация на тему "Использование ИКТ на занятиях" - скачать презентации по Педагогике

Презентация на тему "Использование ИКТ на занятиях" - скачать презентации по Педагогике Кран автомобильный КС-65740-4

Кран автомобильный КС-65740-4 Кинематика

Кинематика  Powracam do Boga

Powracam do Boga Экономика вокруг нас.

Экономика вокруг нас. Аттестационная работа. Как сделать исследовательскую деятельности интересной

Аттестационная работа. Как сделать исследовательскую деятельности интересной Презентация Факторы, влияющие на рынок недвижимости

Презентация Факторы, влияющие на рынок недвижимости Трансформатор. Устройство трансформатора

Трансформатор. Устройство трансформатора Неоинституциональная экономическая теория К.э.н., ст. препод. Бренделева Елена Алексеевна

Неоинституциональная экономическая теория К.э.н., ст. препод. Бренделева Елена Алексеевна  Плоский прямой изгиб

Плоский прямой изгиб Технология обследования моторных функций и речи Доктор педагогических наук, профессор Архипова Е.Ф.

Технология обследования моторных функций и речи Доктор педагогических наук, профессор Архипова Е.Ф.  Определение объемов и трудоемкости монтажных работ

Определение объемов и трудоемкости монтажных работ Основы сельскохозяйственной потребительской кооперации

Основы сельскохозяйственной потребительской кооперации Презентация "ИНДУСТРИАЛЬНЫЙ ПАРК «ОЗЁРЫ»" - скачать презентации по Экономике

Презентация "ИНДУСТРИАЛЬНЫЙ ПАРК «ОЗЁРЫ»" - скачать презентации по Экономике Портрет Натюрморт Пейзаж Описание

Портрет Натюрморт Пейзаж Описание Разрушающие факторы, непрерывно воздействующие на детали в процессе эксплуатации

Разрушающие факторы, непрерывно воздействующие на детали в процессе эксплуатации Денсаулық сақтаудағы менеджмент

Денсаулық сақтаудағы менеджмент Автомобильные дороги и городские улицы 6

Автомобильные дороги и городские улицы 6 Понятие информативности

Понятие информативности Народное творчество Центрального района России

Народное творчество Центрального района России Вода в природе 4 класс - презентация для начальной школы_

Вода в природе 4 класс - презентация для начальной школы_ Творчество выдающегося художника исторического жанра В.И.Сурикова

Творчество выдающегося художника исторического жанра В.И.Сурикова Буржуазно-демократические реформы 60-70 гг. Развитие уголовного и гражданского права во второй половине XIX в

Буржуазно-демократические реформы 60-70 гг. Развитие уголовного и гражданского права во второй половине XIX в Общая схема последовательности стадий разработки облучательного устройства.

Общая схема последовательности стадий разработки облучательного устройства. Коагуляционный гемостаз

Коагуляционный гемостаз  Основные угрозы энергетической безопасности на уровне РФ

Основные угрозы энергетической безопасности на уровне РФ Електроустаткування підстанції. Високовольтні двигуни

Електроустаткування підстанції. Високовольтні двигуни Один день в детском саду 5 ноября «День здоровья»

Один день в детском саду 5 ноября «День здоровья»