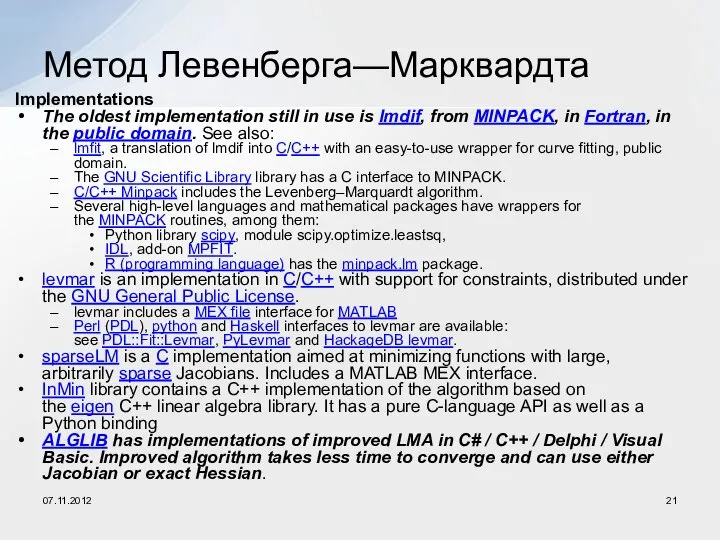

Implementations

The oldest implementation still in use is lmdif, from MINPACK, in Fortran, in the public

domain. See also:

lmfit, a translation of lmdif into C/C++ with an easy-to-use wrapper for curve fitting, public domain.

The GNU Scientific Library library has a C interface to MINPACK.

C/C++ Minpack includes the Levenberg–Marquardt algorithm.

Several high-level languages and mathematical packages have wrappers for the MINPACK routines, among them:

Python library scipy, module scipy.optimize.leastsq,

IDL, add-on MPFIT.

R (programming language) has the minpack.lm package.

levmar is an implementation in C/C++ with support for constraints, distributed under the GNU General Public License.

levmar includes a MEX file interface for MATLAB

Perl (PDL), python and Haskell interfaces to levmar are available: see PDL::Fit::Levmar, PyLevmar and HackageDB levmar.

sparseLM is a C implementation aimed at minimizing functions with large, arbitrarily sparse Jacobians. Includes a MATLAB MEX interface.

InMin library contains a C++ implementation of the algorithm based on the eigen C++ linear algebra library. It has a pure C-language API as well as a Python binding

ALGLIB has implementations of improved LMA in C# / C++ / Delphi / Visual Basic. Improved algorithm takes less time to converge and can use either Jacobian or exact Hessian.

Метод Левенберга—Марквардта

07.11.2012

Что такое культура?

Что такое культура? Презентация "Североамериканское соглашение о свободной торговле (НАФТА) и другие формы реализации международного интеграционн

Презентация "Североамериканское соглашение о свободной торговле (НАФТА) и другие формы реализации международного интеграционн Пасха. Пасхальные традиции

Пасха. Пасхальные традиции 건강. 어휘 사용법. Корейский язык

건강. 어휘 사용법. Корейский язык Правила росписи хохломских изделий

Правила росписи хохломских изделий Экономика и ее роль в жизни общества

Экономика и ее роль в жизни общества  Презентация Предмет, метод и принципы жилищного права

Презентация Предмет, метод и принципы жилищного права Обеспечение и оценка качества образовательного процесса в рамках ФГОС-3 ВПО Проректор по учебной работе Суслова Г.А.

Обеспечение и оценка качества образовательного процесса в рамках ФГОС-3 ВПО Проректор по учебной работе Суслова Г.А. Мои способности «Знание того, какими вещи должны быть, характеризует человека умного; знание того, какие вещи на самом деле, хара

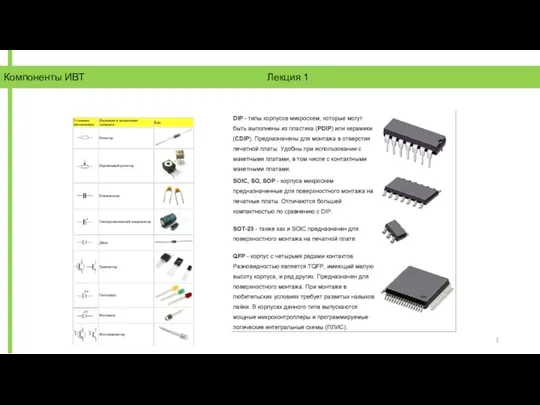

Мои способности «Знание того, какими вещи должны быть, характеризует человека умного; знание того, какие вещи на самом деле, хара Компоненты средств ИВТ

Компоненты средств ИВТ Презентация Международно-правовой механизм охраны окружающей среды. Правовая охрана окружающей среды в зарубежных странах

Презентация Международно-правовой механизм охраны окружающей среды. Правовая охрана окружающей среды в зарубежных странах  Производство кожаной обуви

Производство кожаной обуви Значение трудов Рене Декарта для науки и философии

Значение трудов Рене Декарта для науки и философии Презентация по ОБЖ Наложение повязок

Презентация по ОБЖ Наложение повязок  Презентация "Ян ван Эйк" - скачать презентации по МХК

Презентация "Ян ван Эйк" - скачать презентации по МХК Қазақстан халқына жолдауы

Қазақстан халқына жолдауы Список использованной литературы Синельников Р. Д., Синельников Я. Р. Атлас анатомии человека: Учеб.пособие.— 2-е изд., стереотипное.

Список использованной литературы Синельников Р. Д., Синельников Я. Р. Атлас анатомии человека: Учеб.пособие.— 2-е изд., стереотипное. Создание библиотек компонентов в пакете сапр altium designer

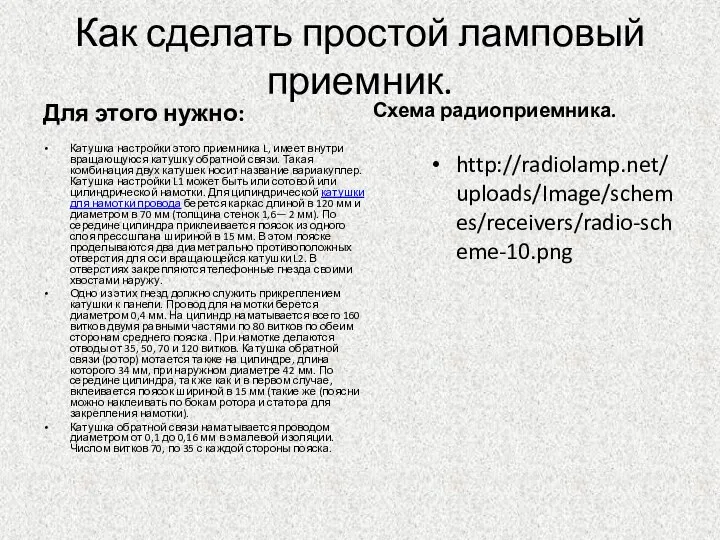

Создание библиотек компонентов в пакете сапр altium designer Как сделать простой ламповый приемник

Как сделать простой ламповый приемник Педагогические lookи

Педагогические lookи Язык HTML

Язык HTML Пабло ПИКАССО

Пабло ПИКАССО В могилі Він лежав. Ф.В. Теппоне, Р. Лоурі

В могилі Він лежав. Ф.В. Теппоне, Р. Лоурі Проблемно – тематический день как интеграция приемов и средств формирования УУД сельских школьников 17 сентября 2014 года

Проблемно – тематический день как интеграция приемов и средств формирования УУД сельских школьников 17 сентября 2014 года Съёмочные системы

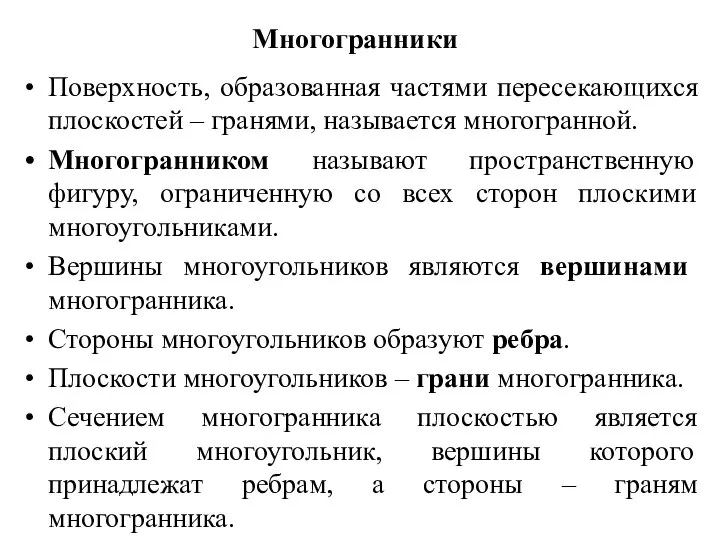

Съёмочные системы Призма

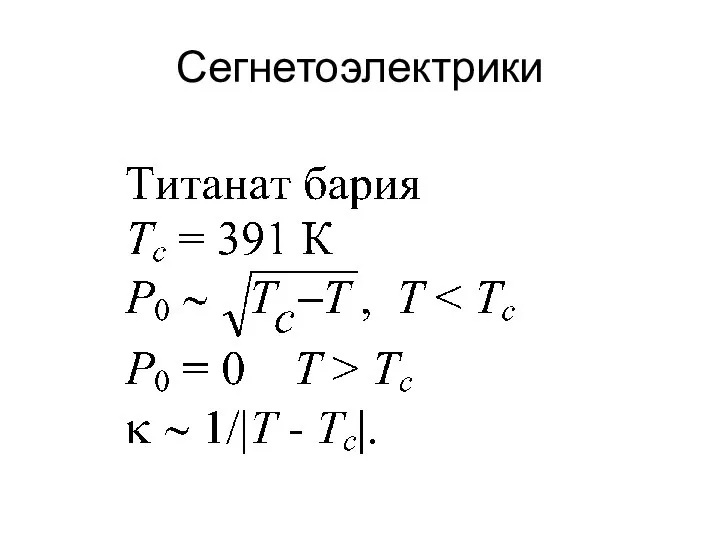

Призма Сегнетоэлектрики

Сегнетоэлектрики Основные даты семейства UNIX

Основные даты семейства UNIX