Содержание

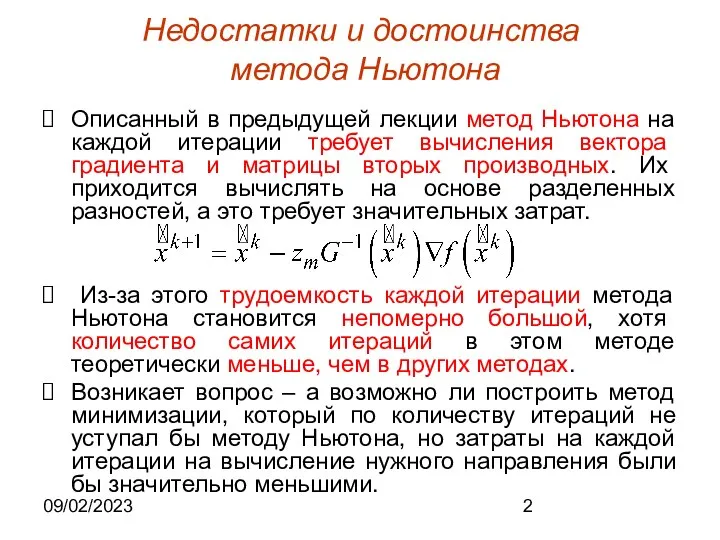

- 2. 09/02/2023 Недостатки и достоинства метода Ньютона Описанный в предыдущей лекции метод Ньютона на каждой итерации требует

- 3. 09/02/2023 Основные предпосылки С другой стороны привлекательной является идея адаптивного управления спуском к минимуму. Как известно,

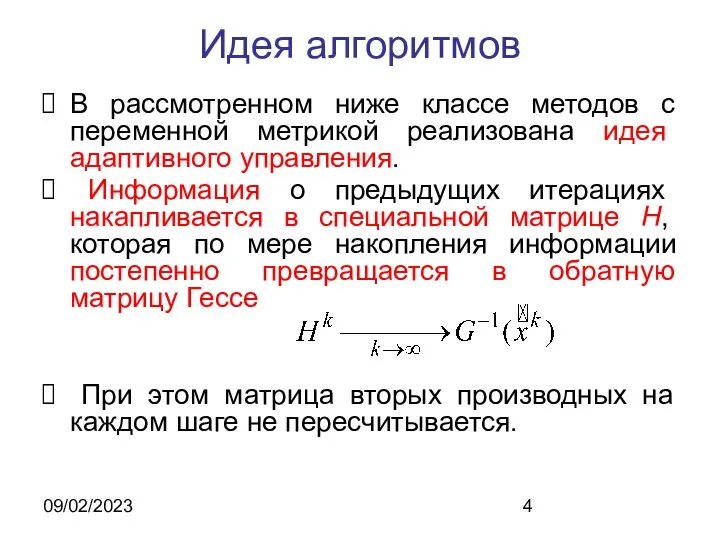

- 4. 09/02/2023 Идея алгоритмов В рассмотренном ниже классе методов с переменной метрикой реализована идея адаптивного управления. Информация

- 5. 09/02/2023 Многообразие и перспективность алгоритмов Процесс обработки и накопления информации, получаемой на каждой новой итерации можно

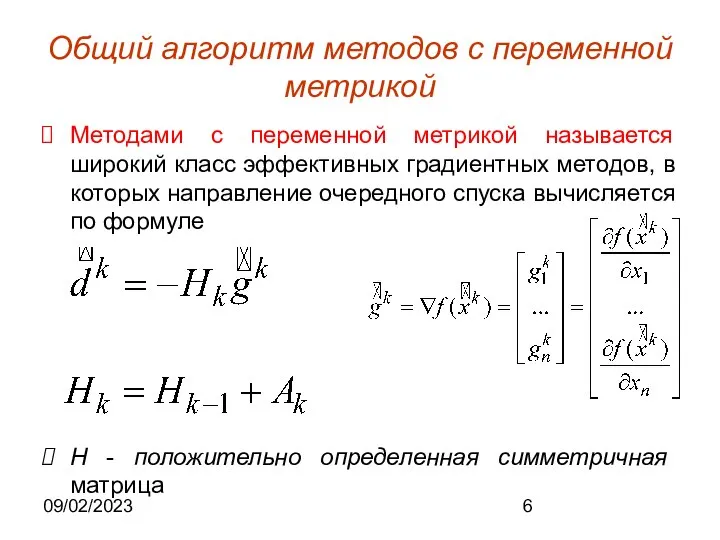

- 6. 09/02/2023 Общий алгоритм методов с переменной метрикой Методами с переменной метрикой называется широкий класс эффективных градиентных

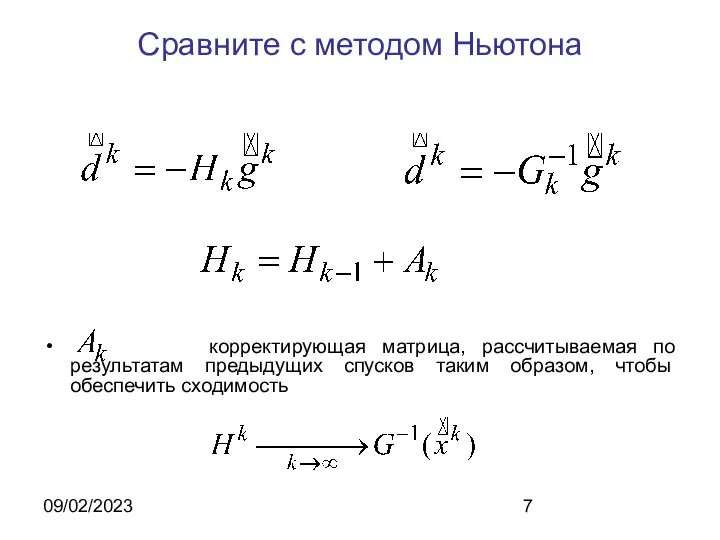

- 7. 09/02/2023 Сравните с методом Ньютона корректирующая матрица, рассчитываемая по результатам предыдущих спусков таким образом, чтобы обеспечить

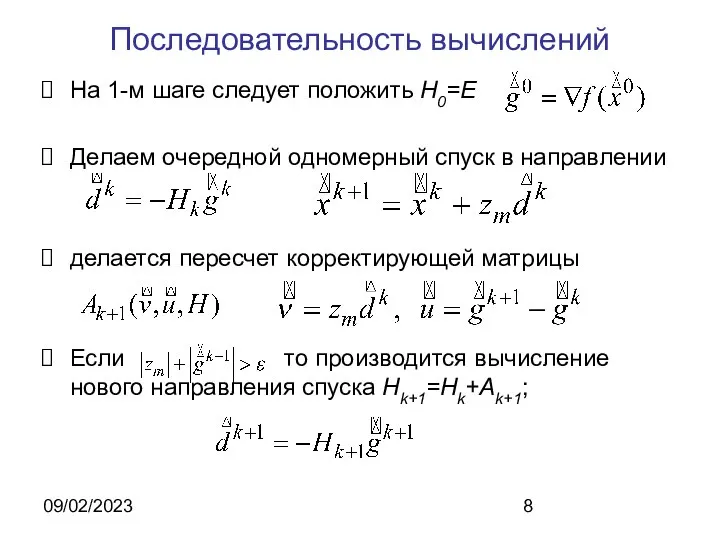

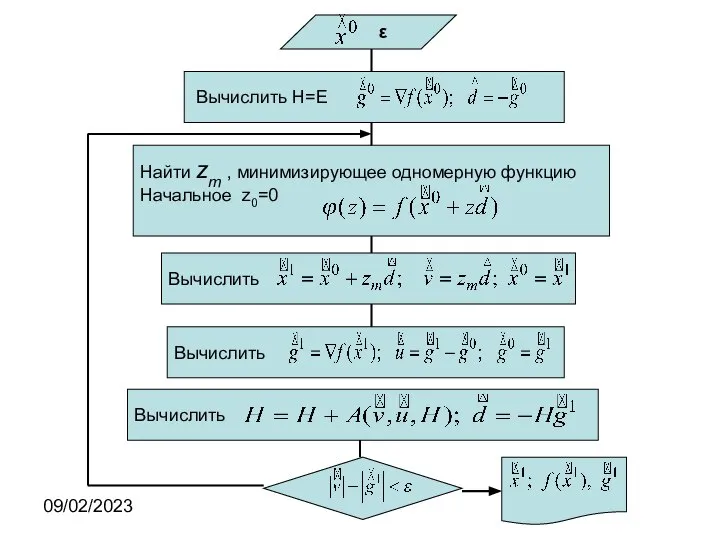

- 8. 09/02/2023 Последовательность вычислений На 1-м шаге следует положить Н0=Е Делаем очередной одномерный спуск в направлении делается

- 9. 09/02/2023

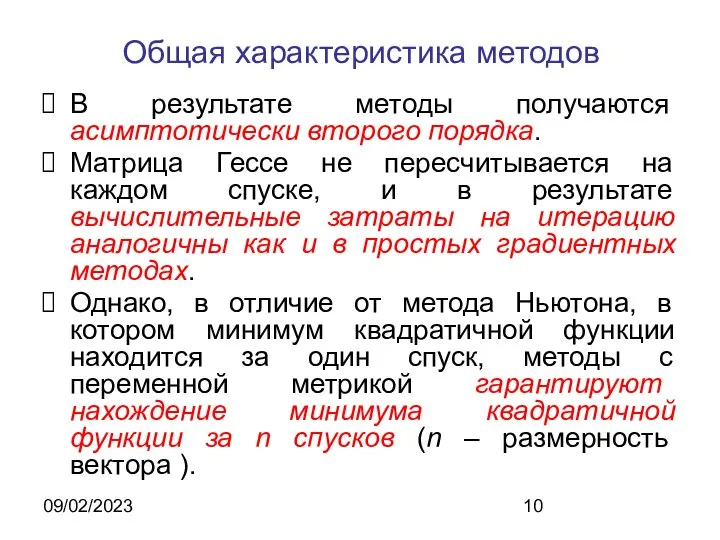

- 10. 09/02/2023 Общая характеристика методов В результате методы получаются асимптотически второго порядка. Матрица Гессе не пересчитывается на

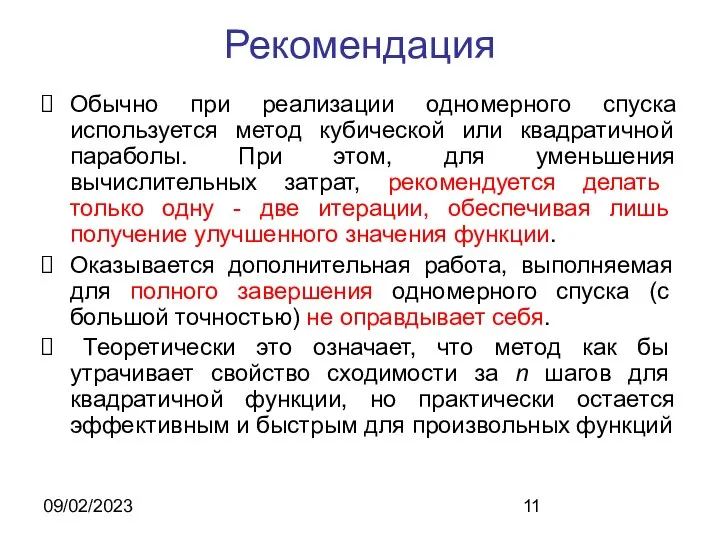

- 11. 09/02/2023 Рекомендация Обычно при реализации одномерного спуска используется метод кубической или квадратичной параболы. При этом, для

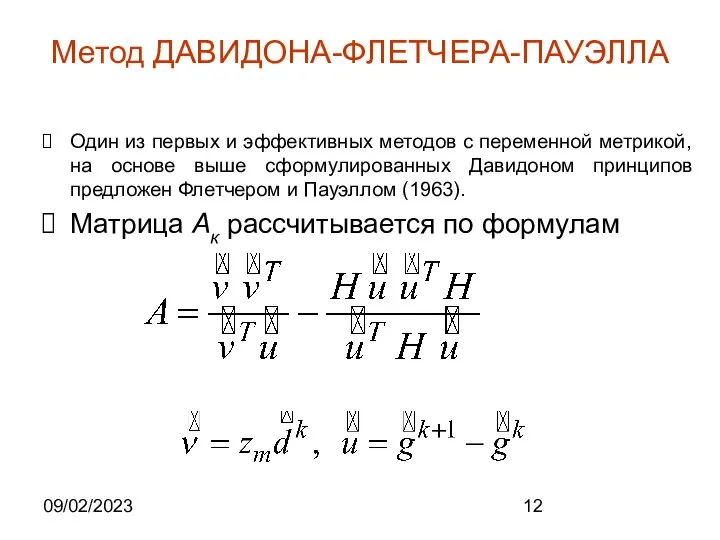

- 12. 09/02/2023 Метод ДАВИДОНА-ФЛЕТЧЕРА-ПАУЭЛЛА Один из первых и эффективных методов с переменной метрикой, на основе выше сформулированных

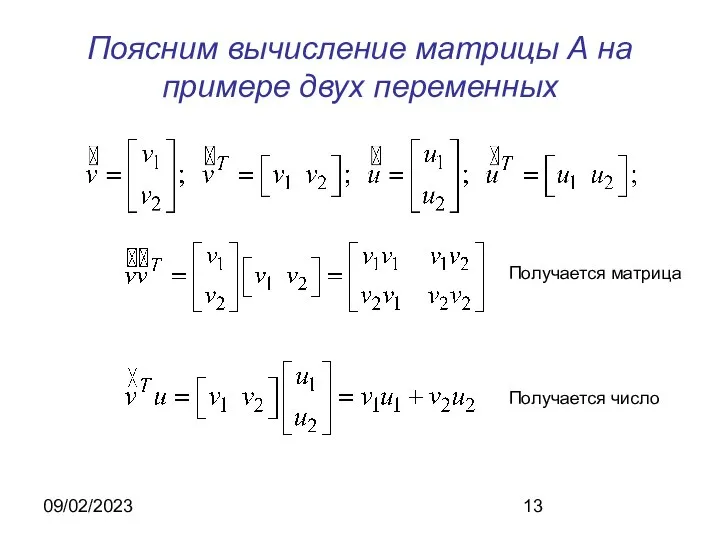

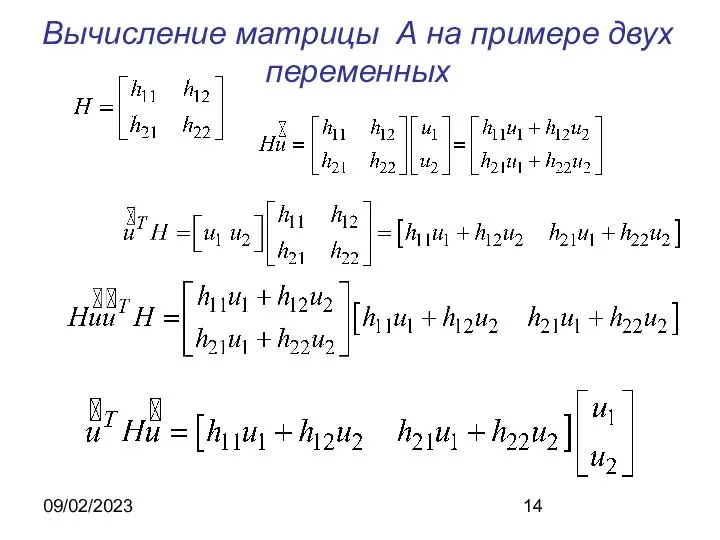

- 13. 09/02/2023 Поясним вычисление матрицы А на примере двух переменных Получается матрица Получается число

- 14. 09/02/2023 Вычисление матрицы А на примере двух переменных

- 15. 09/02/2023 Программная реализация вычисления матриц H+A Procedure PREOBR; var hu,uh,u,v: array[l..n] of real; vu,uhu,uh:real; begin vu:=0;for

- 16. 09/02/2023 Программная реализация (продолжение) for i:=1 to n do begin hu[i]:=0; uh[i]:=o; for k:=1 to n

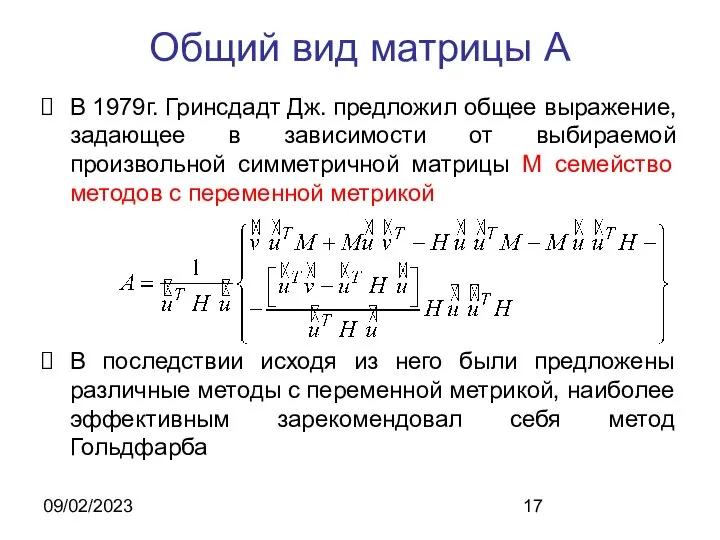

- 17. 09/02/2023 Общий вид матрицы А В 1979г. Гринсдадт Дж. предложил общее выражение, задающее в зависимости от

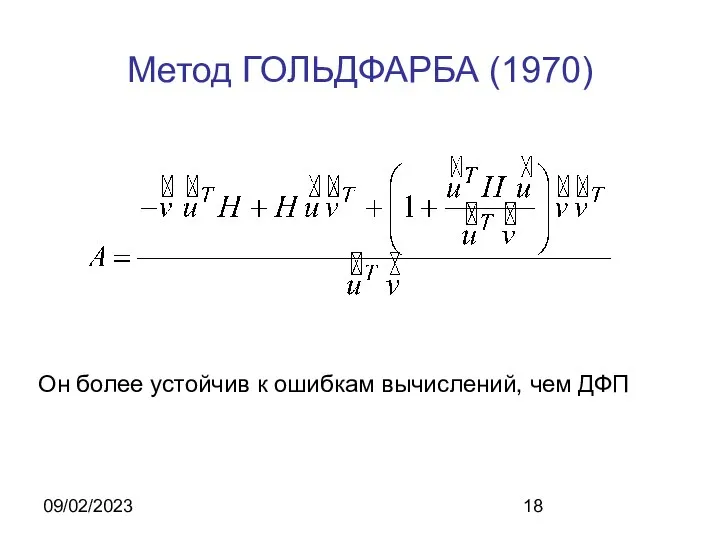

- 18. 09/02/2023 Метод ГОЛЬДФАРБА (1970) Он более устойчив к ошибкам вычислений, чем ДФП

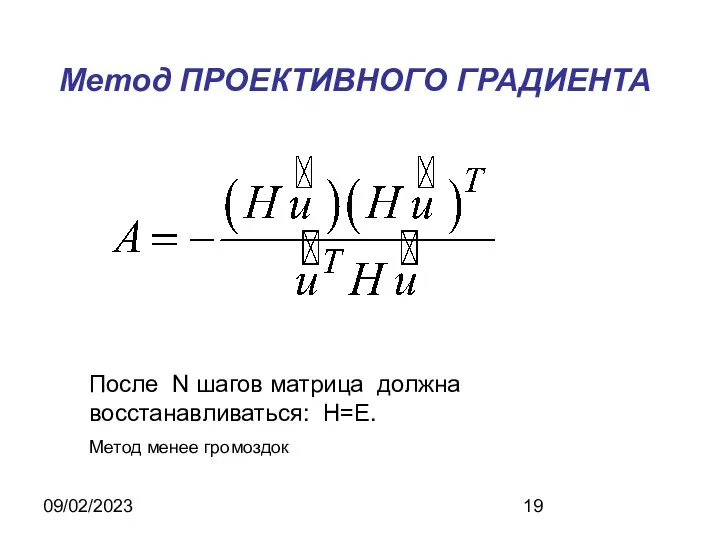

- 19. 09/02/2023 Метод ПРОЕКТИВНОГО ГРАДИЕНТА После N шагов матрица должна восстанавливаться: Н=Е. Метод менее громоздок

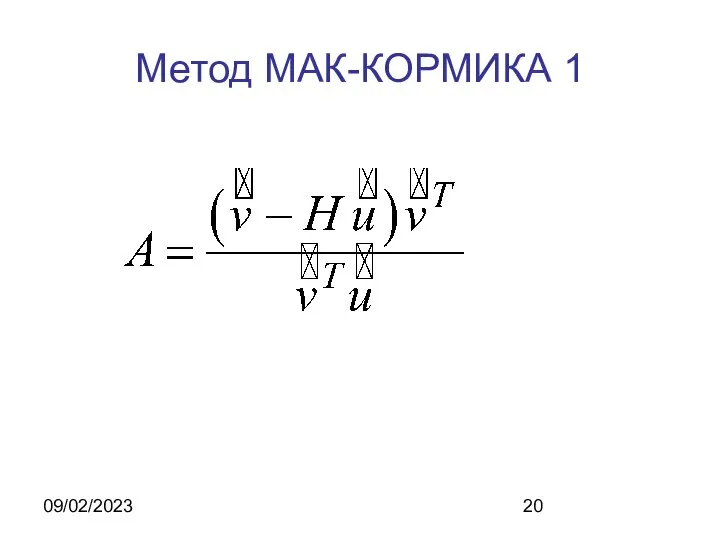

- 20. 09/02/2023 Метод МАК-КОРМИКА 1

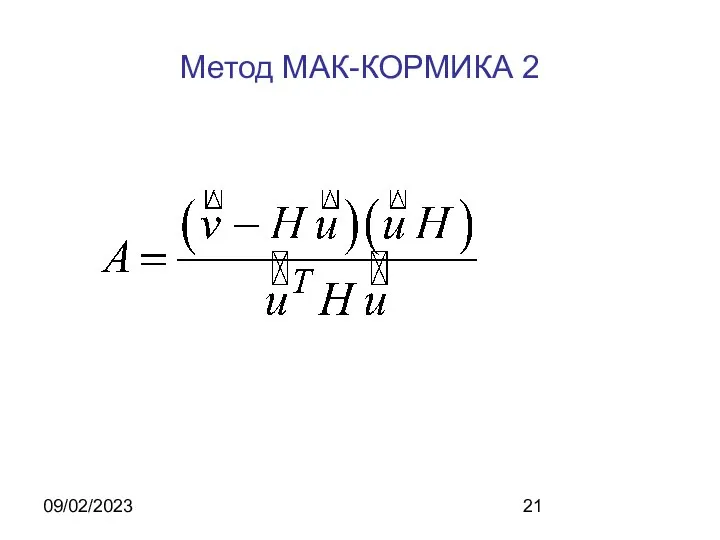

- 21. 09/02/2023 Метод МАК-КОРМИКА 2

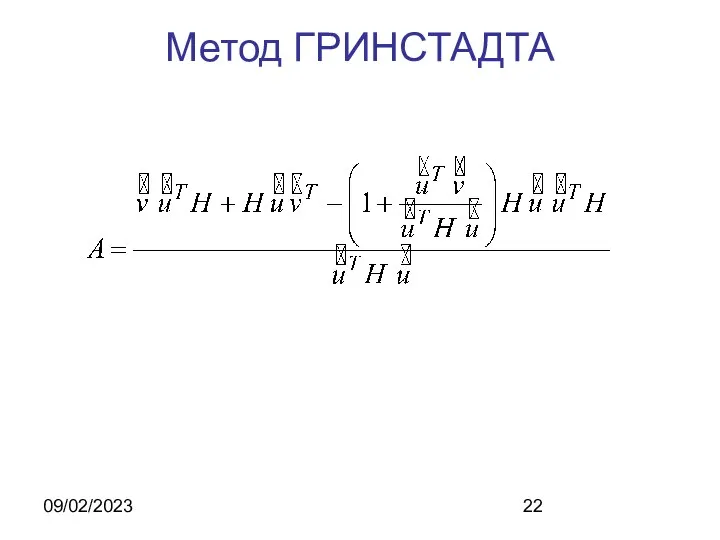

- 22. 09/02/2023 Метод ГРИНСТАДТА

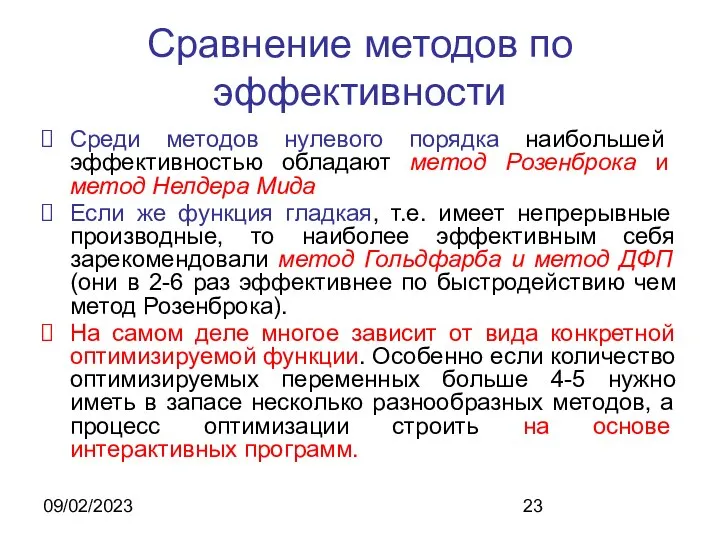

- 23. 09/02/2023 Сравнение методов по эффективности Среди методов нулевого порядка наибольшей эффективностью обладают метод Розенброка и метод

- 25. Скачать презентацию

![09/02/2023 Программная реализация вычисления матриц H+A Procedure PREOBR; var hu,uh,u,v: array[l..n]](/_ipx/f_webp&q_80&fit_contain&s_1440x1080/imagesDir/jpg/1295312/slide-14.jpg)

![09/02/2023 Программная реализация (продолжение) for i:=1 to n do begin hu[i]:=0;](/_ipx/f_webp&q_80&fit_contain&s_1440x1080/imagesDir/jpg/1295312/slide-15.jpg)

Два портрета

Два портрета Пассивное здание. Дом нулевой энергии. Дом плюс энергии или «активный дом

Пассивное здание. Дом нулевой энергии. Дом плюс энергии или «активный дом Изменяющийся контекст и вызовы, стоящие перед системой образования В.А.Болотов

Изменяющийся контекст и вызовы, стоящие перед системой образования В.А.Болотов Девелопер + фактор личности

Девелопер + фактор личности Основные виды транспортных документов

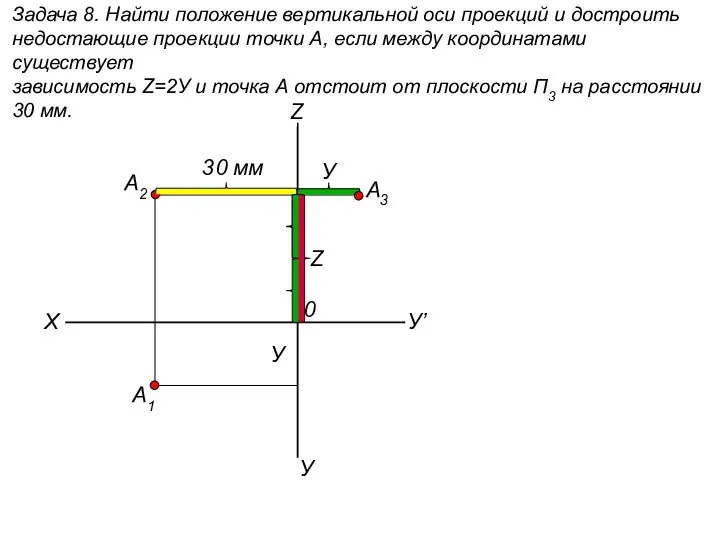

Основные виды транспортных документов  Найти положение вертикальной оси проекций и достроить недостающие проекции точки А. (задача 8)

Найти положение вертикальной оси проекций и достроить недостающие проекции точки А. (задача 8) Административно-хозяйственная деятельность. Безопасность

Административно-хозяйственная деятельность. Безопасность Принципы построения и архитектура ЭВМ

Принципы построения и архитектура ЭВМ Дискурсивные маркеры. Тема IV-14

Дискурсивные маркеры. Тема IV-14 ОСТАНОВКА КРОВООБРАЩЕНИЯ, СЕРДЕЧНО - ЛЕГОЧНАЯ РЕАНИМАЦИЯ

ОСТАНОВКА КРОВООБРАЩЕНИЯ, СЕРДЕЧНО - ЛЕГОЧНАЯ РЕАНИМАЦИЯ Die Wortbildung

Die Wortbildung Обувь туриста

Обувь туриста Классная работа. Противоположные числа. 13.02.

Классная работа. Противоположные числа. 13.02.  Правовые основы местного самоуправления

Правовые основы местного самоуправления Гимнастика. Виды

Гимнастика. Виды История вычислительной техники

История вычислительной техники Производство домиков для котов, когтеточек, комплексов из дерева

Производство домиков для котов, когтеточек, комплексов из дерева Исаак Левитан. 7 класс

Исаак Левитан. 7 класс Правила поведения в театре

Правила поведения в театре Урок по китайскому. 第六课 Урок 6

Урок по китайскому. 第六课 Урок 6 GR (англ. government relations) взаимодействие с органами государственной власти

GR (англ. government relations) взаимодействие с органами государственной власти Как много... и как мало - презентация для начальной школы_

Как много... и как мало - презентация для начальной школы_ «Системно - деятельностный подход в обучении иностранному языку» «Системно - деятельностный подход в обучении иностранному я

«Системно - деятельностный подход в обучении иностранному языку» «Системно - деятельностный подход в обучении иностранному я Презентация "Игрушки Крутца" - скачать презентации по МХК

Презентация "Игрушки Крутца" - скачать презентации по МХК Преобразование графиков функций.

Преобразование графиков функций. Экономика информации и неопределенности

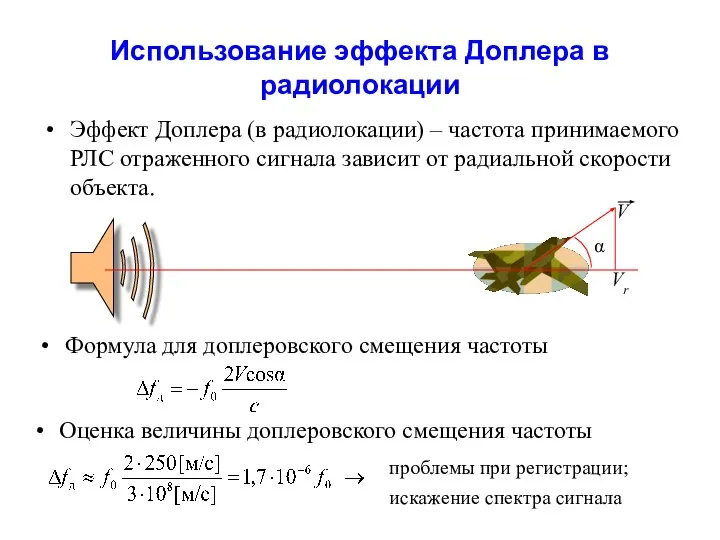

Экономика информации и неопределенности Использование эффекта Доплера в радиолокации

Использование эффекта Доплера в радиолокации Право. Нормы права

Право. Нормы права