Содержание

- 2. раздел кибернетики, развивающий теоретические основы и методы классификации и идентификации предметов, явлений, процессов, сигналов, ситуаций и

- 3. Имеется некоторый способ кодирования объектов, принадлежащих заранее известному конечному множеству классов C={C1 ,...,Cq}, и некоторое конечное

- 4. Распознавание текста Распознавание лиц Распознавание речи и звуков Анализ сцен Распознавание ситуаций Примеры задач

- 5. Типичная система распознавания состоит из трех частей: извлечение признаков, собственно распознавание и принятие решения. Извлечение признаков

- 6. Алгоритм распознавания строит отображение F из пространства признаков Rd в единичный куб в пространстве Rq. Желаемые

- 7. Распознающий алгоритм - это вектор-функция двух векторных переменных Y=F(W,X), где X - d-мерный вектор признаков, Y

- 8. Обучение, в котором про обучающие вектора признаков известно, какому классу они принадлежат - называется обучением с

- 9. Искусственные нейронные сети Комитет рандомизированных решающих деревьев (Random Forest) Машины опорных векторов (SVM) Бустинг (AdaBoost) Скрытые

- 10. Алгоритм применяется для задач классификации, регрессии и кластеризации. Заключается в использовании комитета (ансамбля) решающих деревьев Random

- 11. Пусть обучающая выборка состоит из N примеров, размер пространства признаков равен M, и задан параметр m.

- 12. Классификация объектов проводится путём голосования: каждое дерево комитета относит классифицируемый объект к одному из классов, и

- 13. Высокое качество получаемых моделей, сравнимое с SVM и бустингом, и лучшее, чем у нейронных сетей. Способность

- 14. Алгоритм склонен к переобучению на некоторых задачах, особенно на зашумленных задачах. Большой размер получающихся моделей. Недостатки

- 15. Бустинг

- 16. Усиление простых классификаторов - подход к решению задачи классификации (распознавания), путём комбинирования примитивных классификаторов в один

- 17. Пускай человек, играющий на скачках, решил создать программу, которая бы предсказывала, придёт ли интересующая его лошадь

- 18. Относится к классу статических ассоциативных машин Требуется построить классифицирующую функцию F:X->Y, где X - пространство векторов

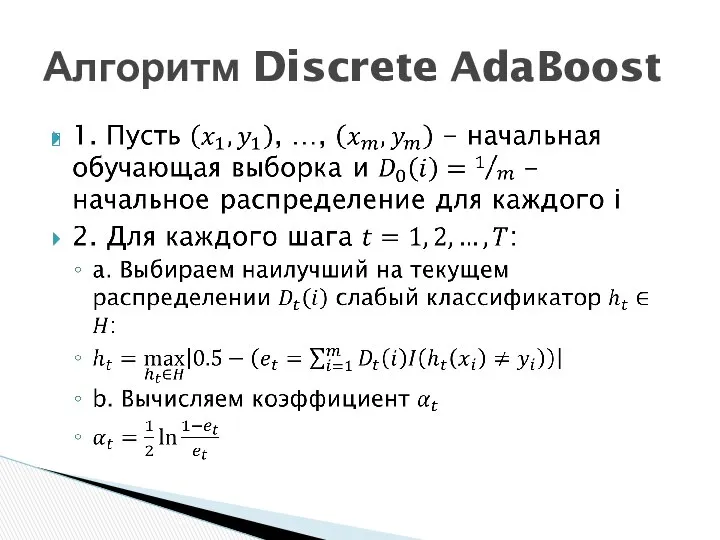

- 19. Алгоритм Discrete AdaBoost

- 22. Скачать презентацию

Я старое ботаническое древо, Я старое ботаническое древо, Не гнущееся в суставах. Я прокладывал дорогу, Чтоб

Я старое ботаническое древо, Я старое ботаническое древо, Не гнущееся в суставах. Я прокладывал дорогу, Чтоб Электрические аппараты защиты трёхфазных асинхронных электродвигателей

Электрические аппараты защиты трёхфазных асинхронных электродвигателей Государственная гражданская служба. (Тема 3)

Государственная гражданская служба. (Тема 3) Оператор присваивания, ввод и вывод данных

Оператор присваивания, ввод и вывод данных Преимущества и трудности управления персоналом в холдинговых компаниях «Дао не делает ничего, однако ничего не остается не сдела

Преимущества и трудности управления персоналом в холдинговых компаниях «Дао не делает ничего, однако ничего не остается не сдела XXIX всемирная зимняя универсиада 2019 года в г. Красноярск

XXIX всемирная зимняя универсиада 2019 года в г. Красноярск Компьютерные сети

Компьютерные сети Нанотехнологии в химии

Нанотехнологии в химии  Стандартные математические функции языка CLIPS

Стандартные математические функции языка CLIPS Презентация по алгебре Числовые последовательности

Презентация по алгебре Числовые последовательности  Аутсорсинг

Аутсорсинг Философия сознания

Философия сознания Маркировка куриных яиц

Маркировка куриных яиц  Формирование информационной культуры учащихся Из опыта работы педагогического коллектива МОУ «Гуманитарно-экономический лицей

Формирование информационной культуры учащихся Из опыта работы педагогического коллектива МОУ «Гуманитарно-экономический лицей История развития рекламы Лекция Автор – СЕЛЕВИЧ Татьяна Семёновна, доцент кафедры маркетинга и антикризисного управления

История развития рекламы Лекция Автор – СЕЛЕВИЧ Татьяна Семёновна, доцент кафедры маркетинга и антикризисного управления Текстовые компоненты Delphi

Текстовые компоненты Delphi Античные цивилизации Средиземноморья

Античные цивилизации Средиземноморья Интересные факты о внутреннем водном транспорте Подготовили: Косолапов, Хабитуева, Псарева, Нефедов

Интересные факты о внутреннем водном транспорте Подготовили: Косолапов, Хабитуева, Псарева, Нефедов Основные положения теории риска

Основные положения теории риска 08. Miscellaneous (java)

08. Miscellaneous (java) Контроль как общая функция менеджмента

Контроль как общая функция менеджмента Подвеска колес автомобиля

Подвеска колес автомобиля Универсальный асинхронный приемопередатчик

Универсальный асинхронный приемопередатчик Соблюдение рекомендаций детского офтальмолога

Соблюдение рекомендаций детского офтальмолога Задачи на части 5 класс

Задачи на части 5 класс Пособия для обучающихся, как конструктор учебных ситуаций

Пособия для обучающихся, как конструктор учебных ситуаций Презентация на тему "Лидер интернет рекрутинга" - скачать презентации по Педагогике

Презентация на тему "Лидер интернет рекрутинга" - скачать презентации по Педагогике Шелленберг Надежда Васильевна учитель начальных классов Муниципальное казённое образовательное учреждение Москаленский лиц

Шелленберг Надежда Васильевна учитель начальных классов Муниципальное казённое образовательное учреждение Москаленский лиц