Содержание

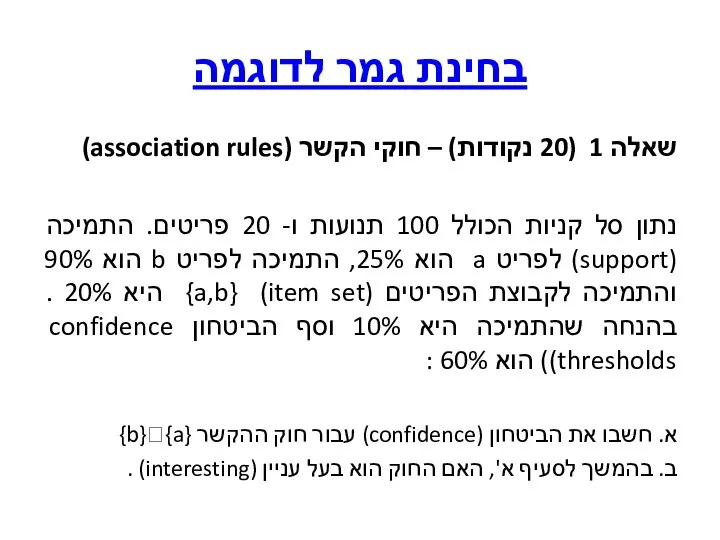

- 2. בחינת גמר לדוגמה שאלה 1 (20 נקודות) – חוקי הקשר (association rules) נתון סל קניות הכולל

- 3. פתרון שאלה 1 support(a) =25% א support(b) =90% support = support({A}U{B}) = 20% For rule A=>B:

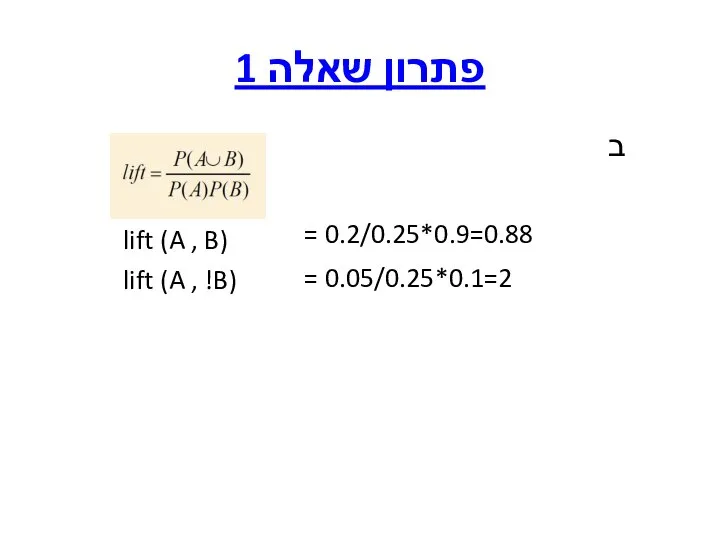

- 4. פתרון שאלה 1 ב = 0.2/0.25*0.9=0.88 = 0.05/0.25*0.1=2 lift (A , !B) lift (A , B)

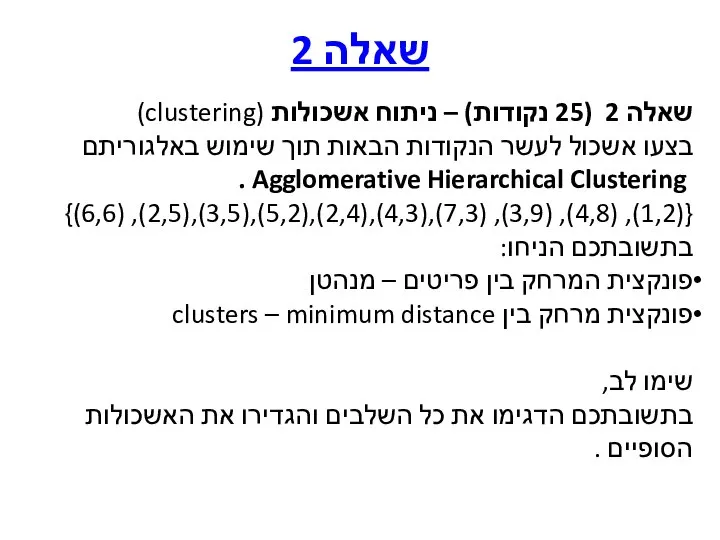

- 5. שאלה 2 שאלה 2 (25 נקודות) – ניתוח אשכולות (clustering) בצעו אשכול לעשר הנקודות הבאות תוך

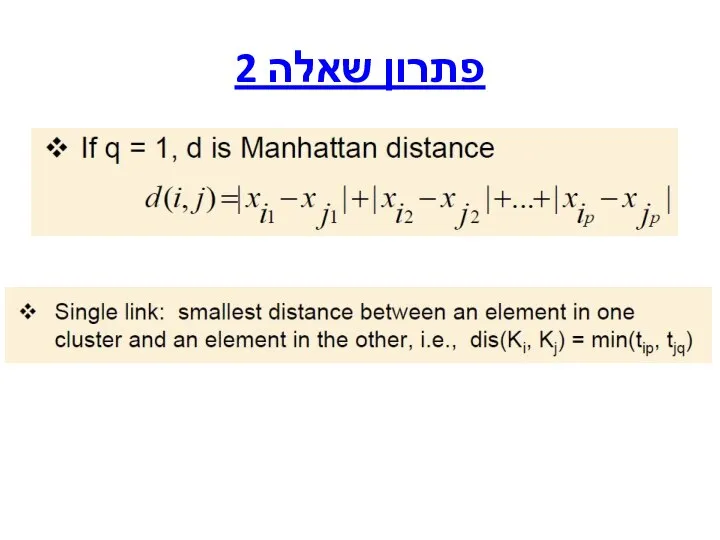

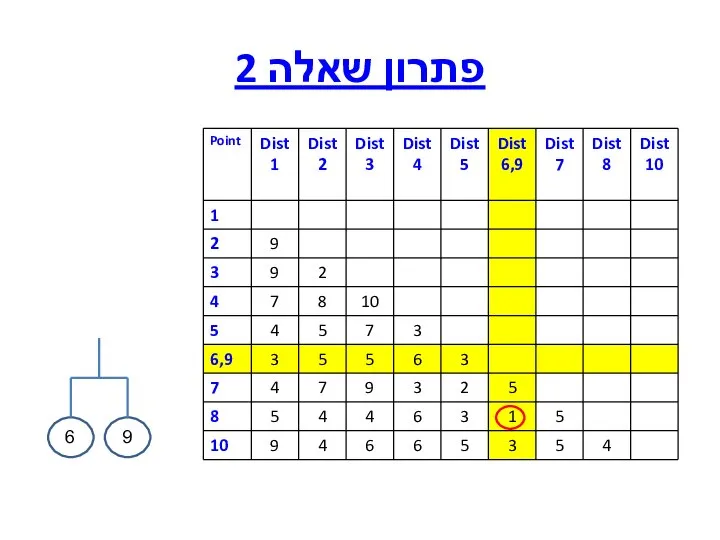

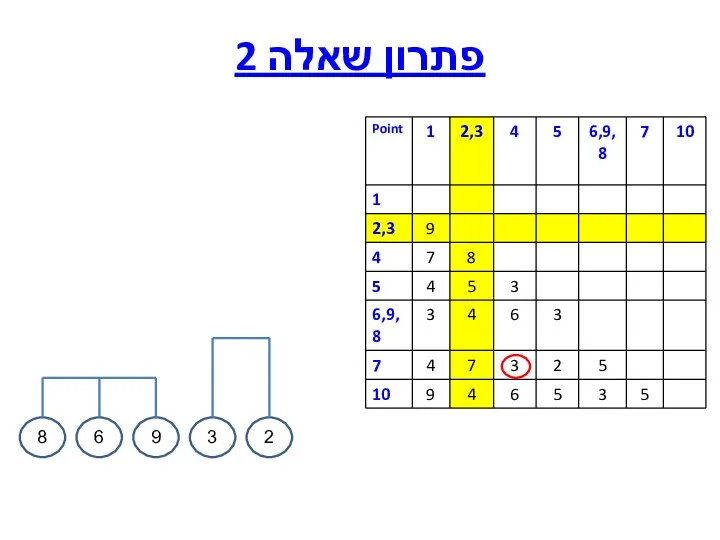

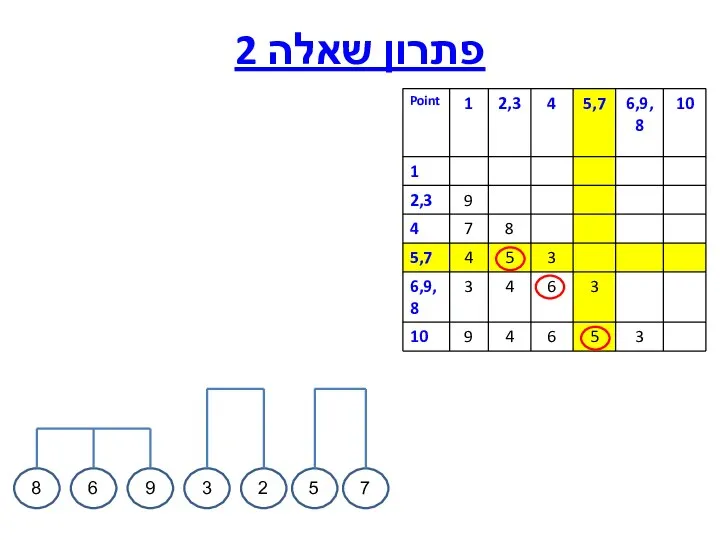

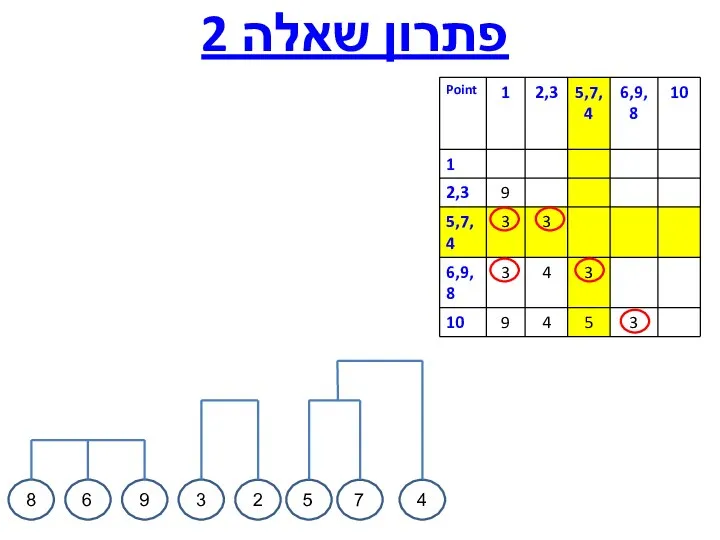

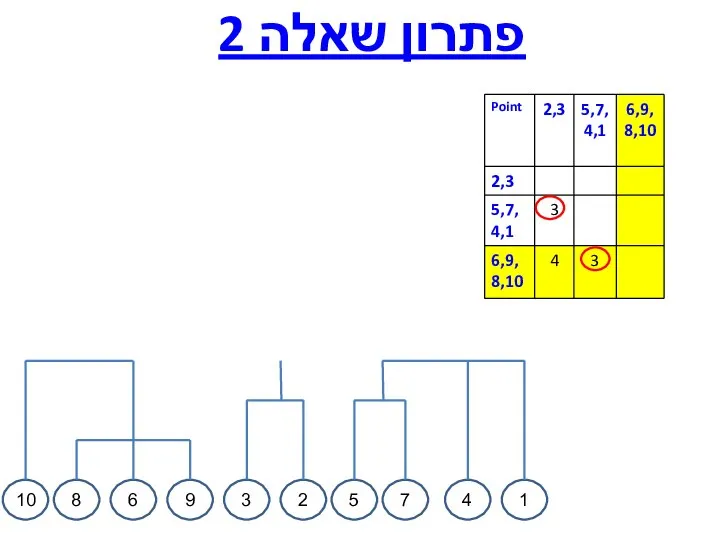

- 6. פתרון שאלה 2

- 7. פתרון שאלה 2

- 8. פתרון שאלה 2 6 9

- 9. פתרון שאלה 2 6 9 8

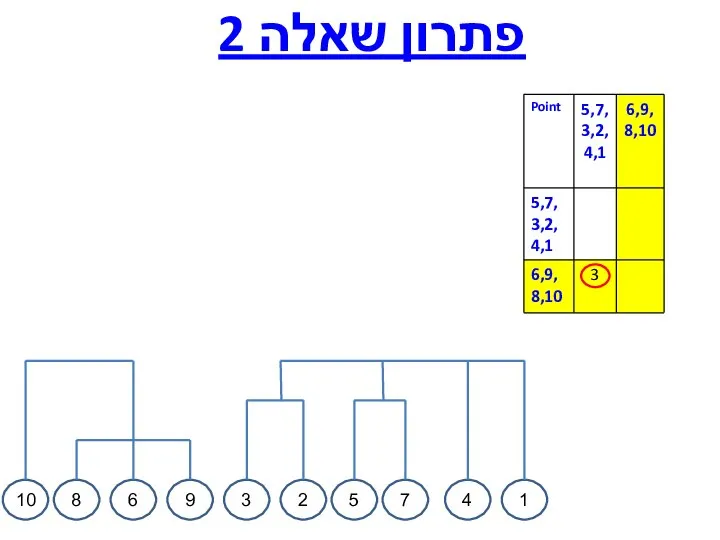

- 10. פתרון שאלה 2

- 11. פתרון שאלה 2

- 12. פתרון שאלה 2 4

- 13. פתרון שאלה 2 4 1

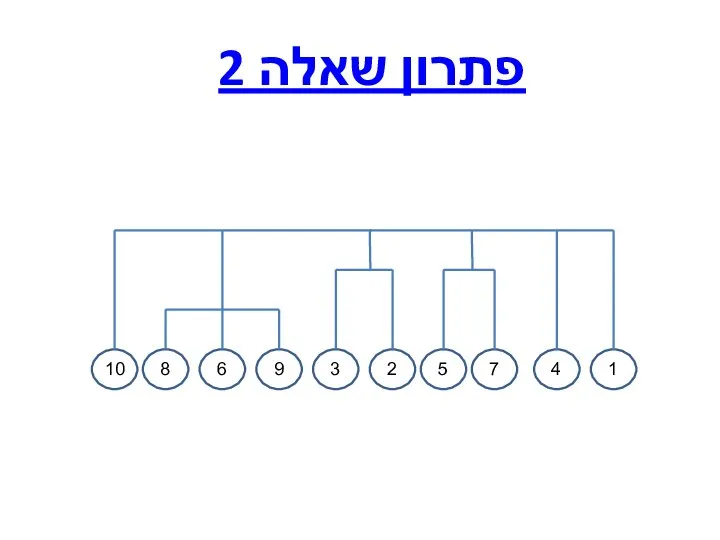

- 14. פתרון שאלה 2 4 1 10

- 15. פתרון שאלה 2 4 1 10

- 16. פתרון שאלה 2 4 1 10

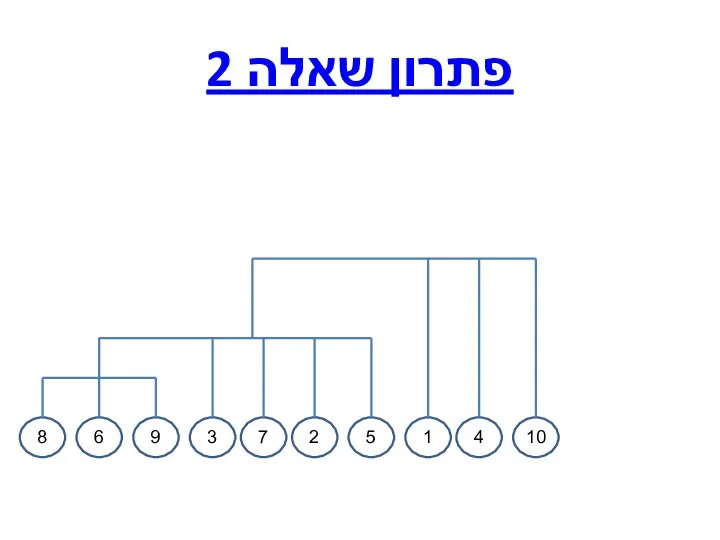

- 17. פתרון שאלה 2 6 9 8 3 7 2 5 1 4 10

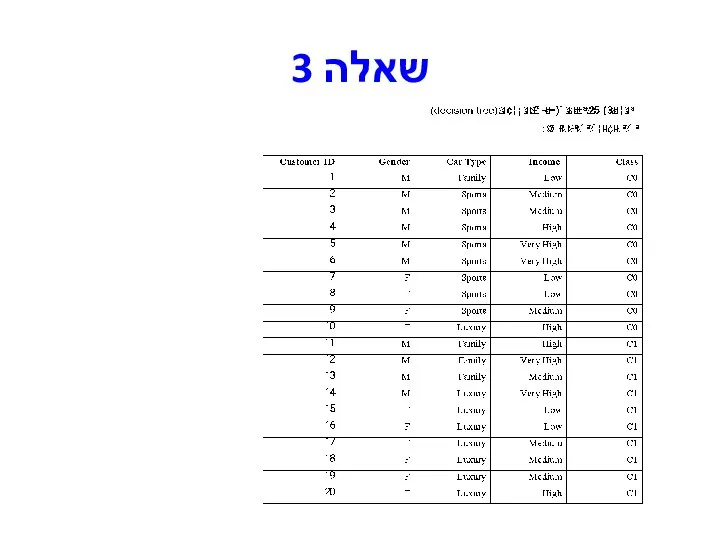

- 18. שאלה 3

- 19. שאלה 3 - המשך א. בנו עץ החלטה עבור נתוני האימון שבטבלה לחיזוי סוג הרכב. בתשובתכם

- 20. פתרון שאלה 3

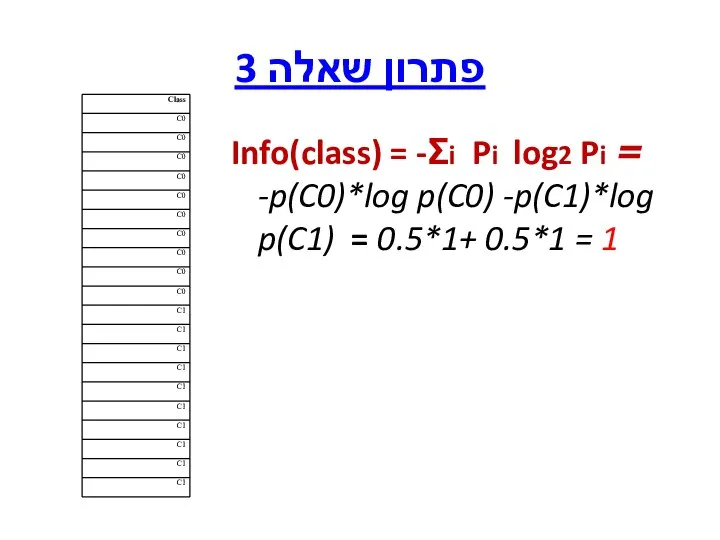

- 21. פתרון שאלה 3 Info(class) = -Σi Pi log2 Pi = -p(C0)*log p(C0) -p(C1)*log p(C1) = 0.5*1+

- 22. פתרון שאלה 3 Gain (Income) = Info(class) - InfoIncome(class) InfoIncome(class)=Info(class|Income)= -Σj P(Income =vj) Info(class|Income =vj) InfoIncome(class)=

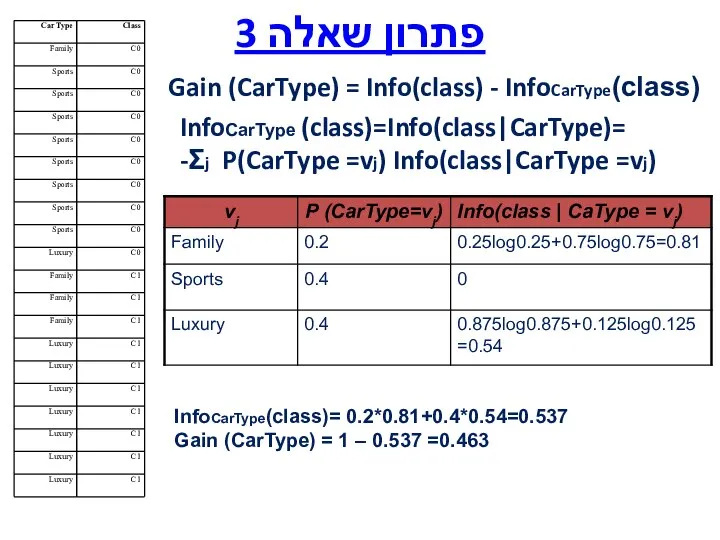

- 23. פתרון שאלה 3 Gain (CarType) = Info(class) - InfoCarType(class) InfoCarType (class)=Info(class|CarType)= -Σj P(CarType =vj) Info(class|CarType =vj)

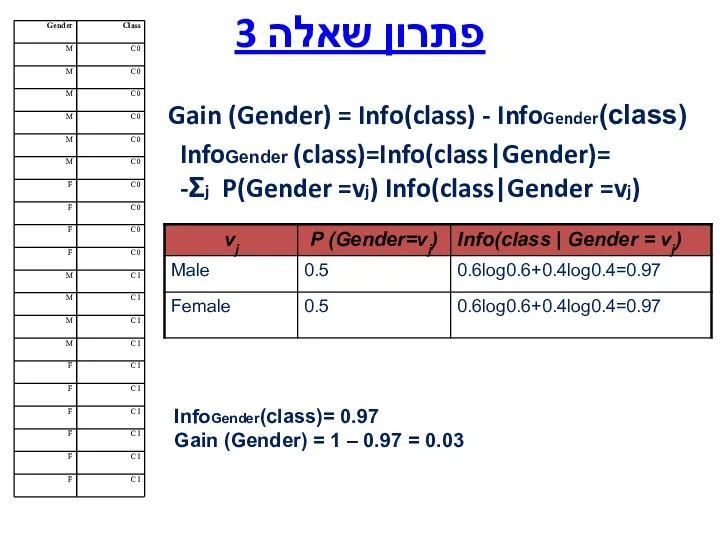

- 24. פתרון שאלה 3 Gain (Gender) = Info(class) - InfoGender(class) InfoGender (class)=Info(class|Gender)= -Σj P(Gender =vj) Info(class|Gender =vj)

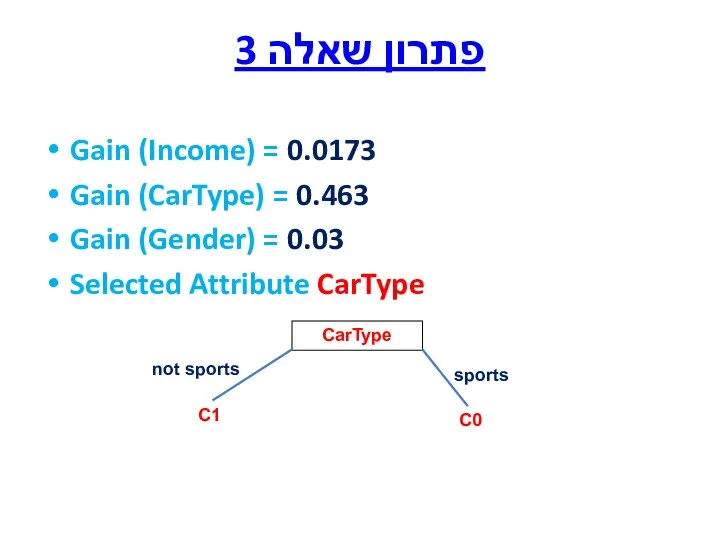

- 25. פתרון שאלה 3 Gain (Income) = 0.0173 Gain (CarType) = 0.463 Gain (Gender) = 0.03 Selected

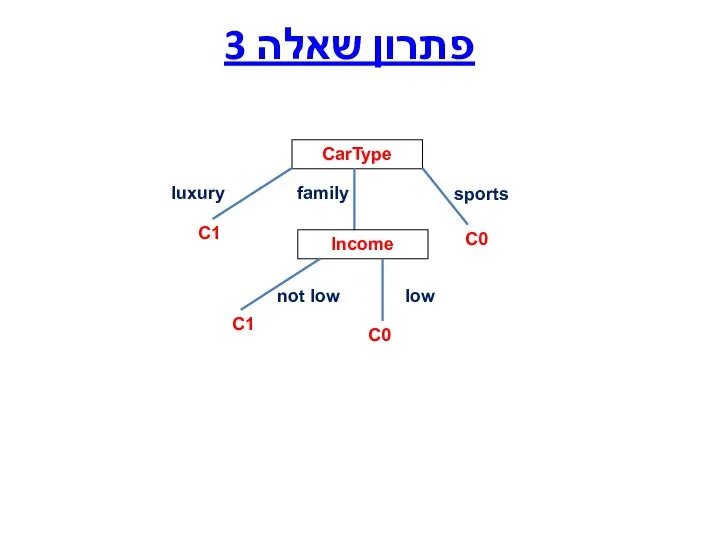

- 26. פתרון שאלה 3 CarType sports luxury C1 family Income not low low C0 C0 C1

- 27. שאלה 4 (20 נקודות)- סיווג וחיזוי (classification and prediction) נתון סט נתונים בו ה Concept הוא

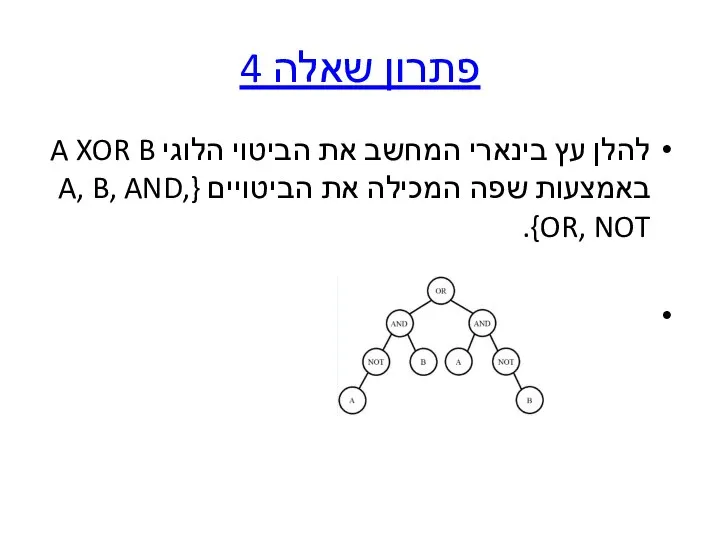

- 28. פתרון שאלה 4 להלן עץ בינארי המחשב את הביטוי הלוגי A XOR B באמצעות שפה המכילה

- 29. פתרון שאלה 4 סריקת Pre-order של העץ תניב את הביטוי: OR(AND(NOT(A),B),AND(A,NOT(B)) אוסף הביטויים, שניתן להציב בצמתים

- 30. שאלה 5 (10 נקודות) במהלך קורס כריית מידע טען אחד הסטודנטים "בחברה בה אני עובד הנתונים

- 31. פתרון שאלה 5 בשאלה זו עליכם להתייחס לנושא של הכנת הנתונים. האם באמת ניתן לבצע כריית

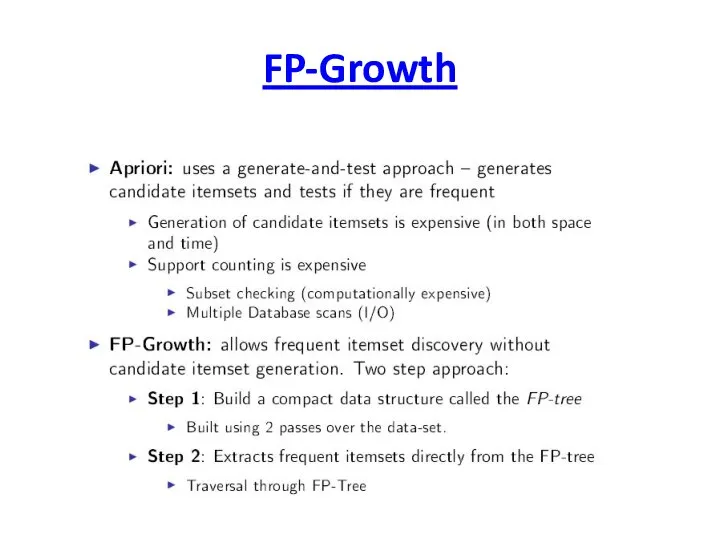

- 32. FP-Growth

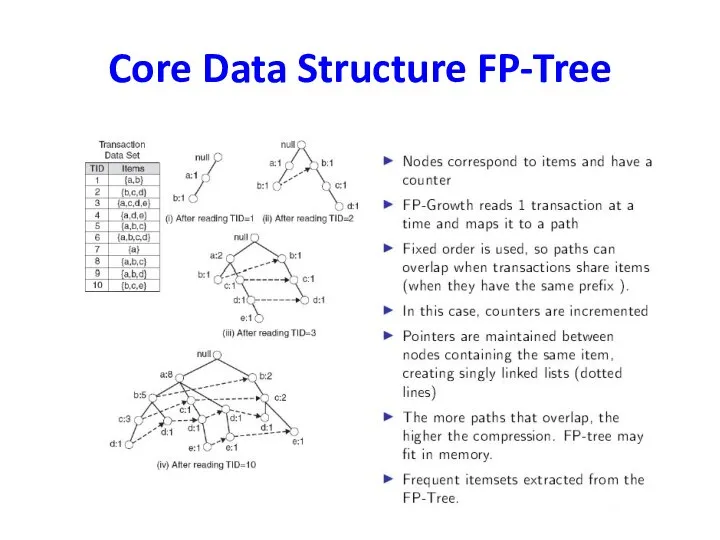

- 33. Core Data Structure FP-Tree

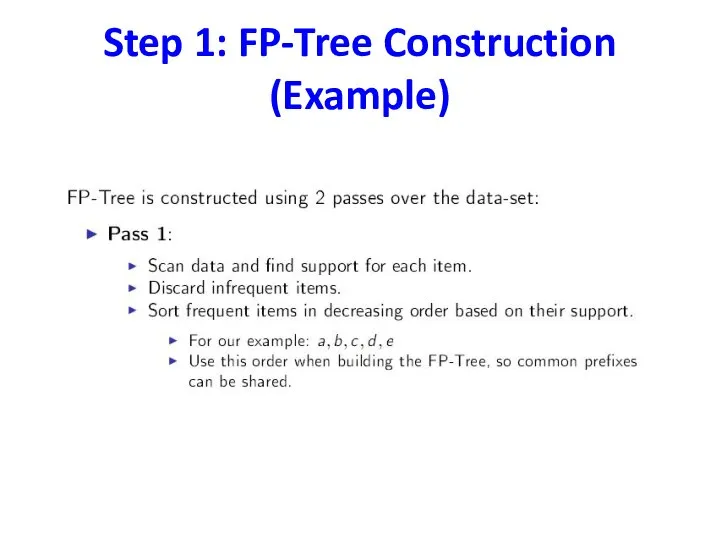

- 34. Step 1: FP-Tree Construction (Example)

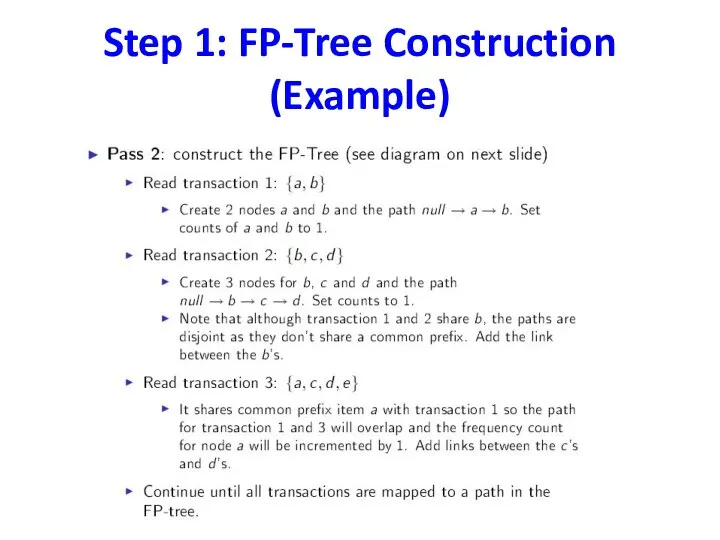

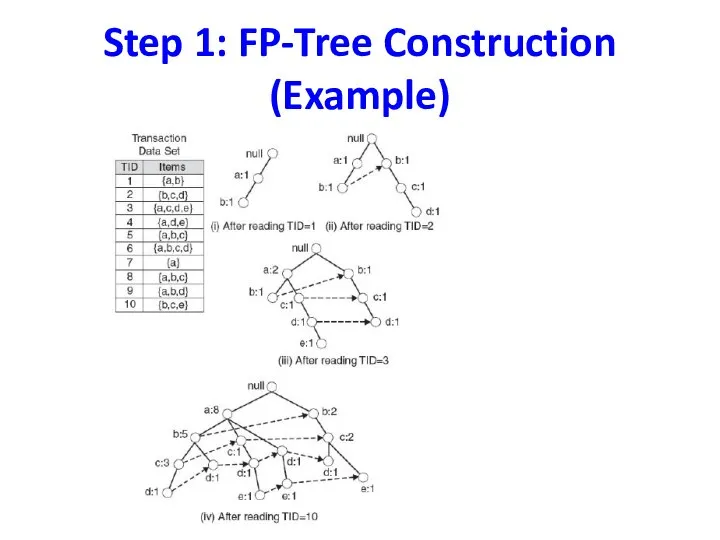

- 35. Step 1: FP-Tree Construction (Example)

- 36. Step 1: FP-Tree Construction (Example)

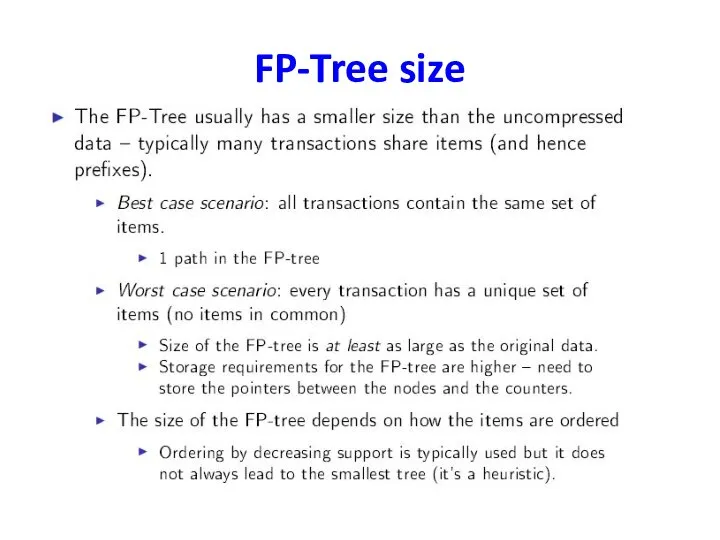

- 37. FP-Tree size

- 38. Step 2 : Frequent Itemset Generation

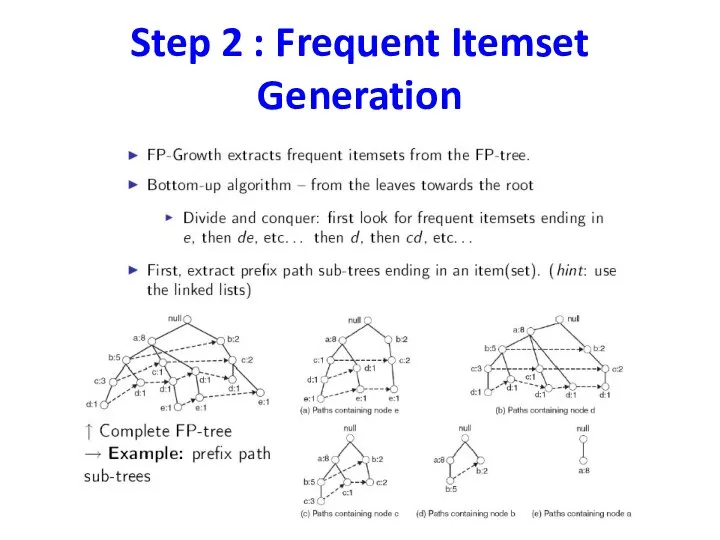

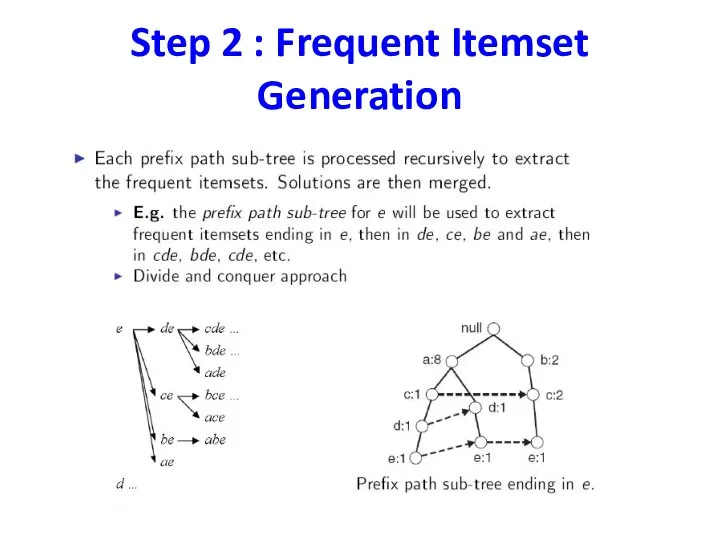

- 39. Step 2 : Frequent Itemset Generation

- 40. Example

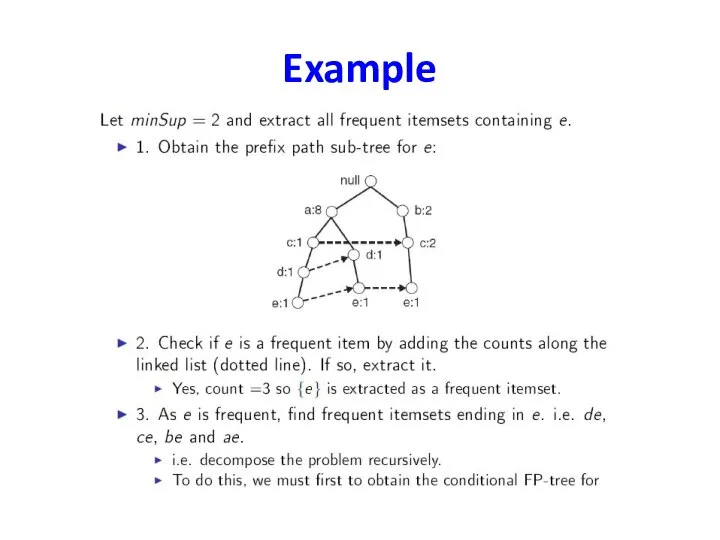

- 41. Conditional FP-Tree

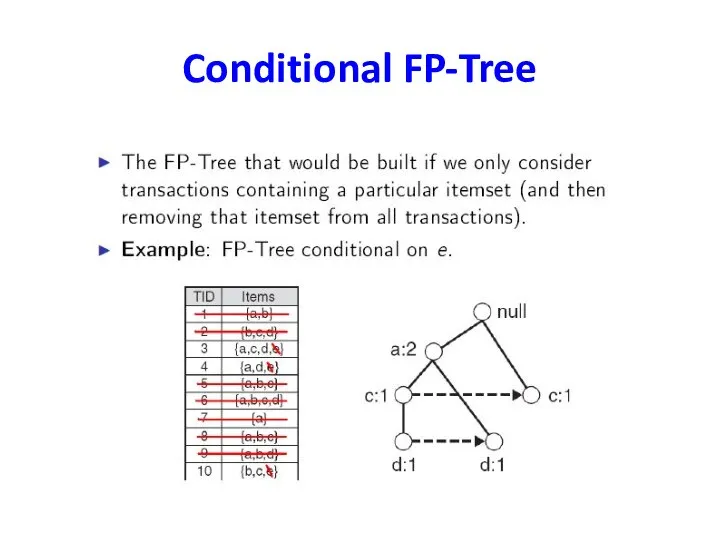

- 42. Conditional FP-Tree

- 43. Conditional FP-Tree

- 44. Conditional FP-Tree

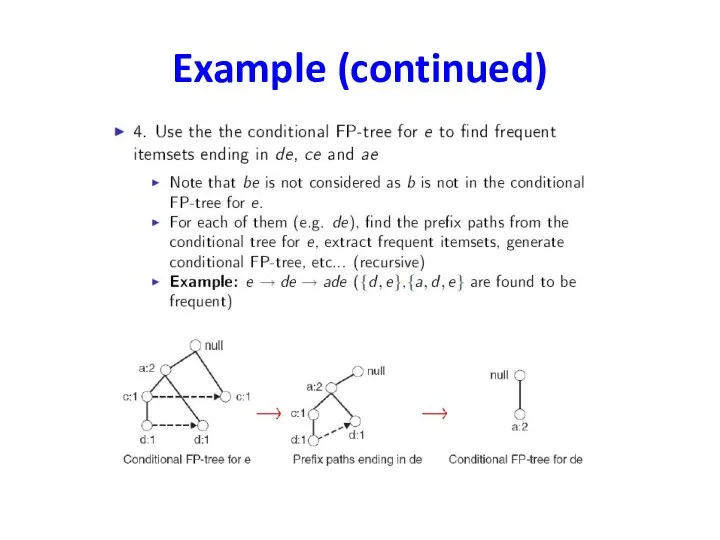

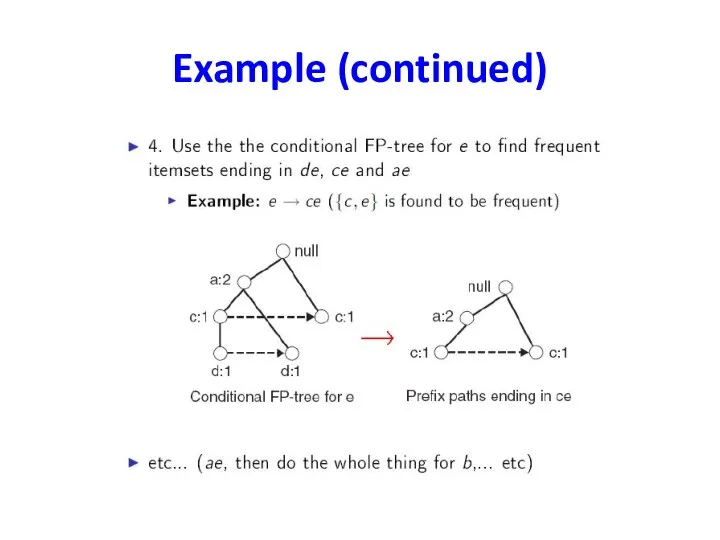

- 45. Example (continued)

- 46. Example (continued)

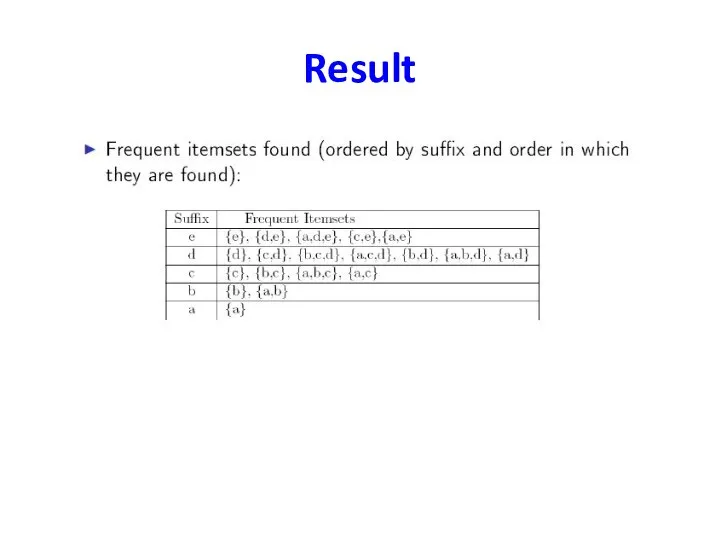

- 47. Result

- 49. Скачать презентацию

Взаимосвязь математики и архитектуры в симметрии

Взаимосвязь математики и архитектуры в симметрии Конкурс "А ну-ка, математики!"

Конкурс "А ну-ка, математики!" Комплексные числа и координатная плоскость. 10 класс

Комплексные числа и координатная плоскость. 10 класс Математика и я

Математика и я Комплексные числа

Комплексные числа Анализ геометрических фигур

Анализ геометрических фигур Фрактальное множество Мандельброта

Фрактальное множество Мандельброта Приемы формирования функциональной грамотности на уроках математики

Приемы формирования функциональной грамотности на уроках математики Числа 1 – 5

Числа 1 – 5 Единицы измерения длины. Сантиметр

Единицы измерения длины. Сантиметр Категориальный аппарат системного анализа

Категориальный аппарат системного анализа Деление десятичной дроби на натуральное число

Деление десятичной дроби на натуральное число Многогранники. Вершины, ребра, грани многогранника

Многогранники. Вершины, ребра, грани многогранника Какие фигуры изображены на эпюре

Какие фигуры изображены на эпюре Числовые и буквенные выражения. Уравнения. Математика – это язык, на котором написана книга природы. (Г. Галилей)

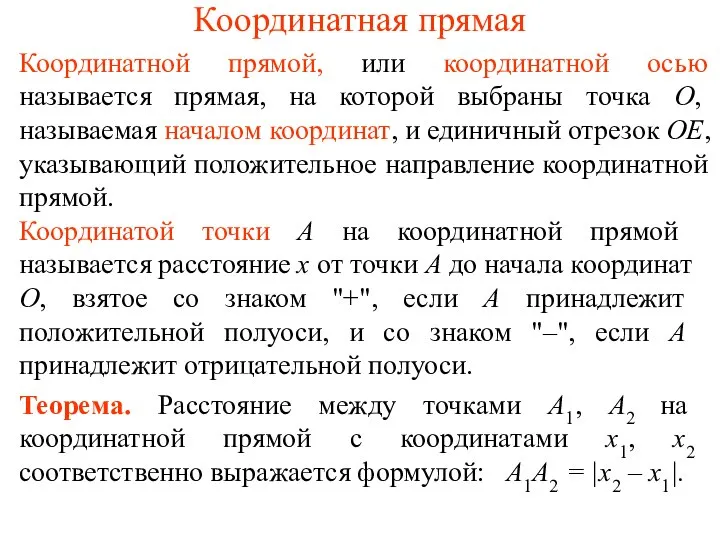

Числовые и буквенные выражения. Уравнения. Математика – это язык, на котором написана книга природы. (Г. Галилей) Координатная прямая

Координатная прямая Интерактивный тренажёр. Внетабличное умножение и деление в пределах 100 (3 класс)

Интерактивный тренажёр. Внетабличное умножение и деление в пределах 100 (3 класс) Тренажёр по математике 1 класс. Сложение и вычитание в пределах 10

Тренажёр по математике 1 класс. Сложение и вычитание в пределах 10 Тригонометрические функции числового аргумента

Тригонометрические функции числового аргумента Теорема Пифагора

Теорема Пифагора Презентация по математике "Решение задач на построение сечений многогранников" - скачать бесплатно

Презентация по математике "Решение задач на построение сечений многогранников" - скачать бесплатно Устный счет. Интерактивная мозаика

Устный счет. Интерактивная мозаика Математика в профессии электромонтёра

Математика в профессии электромонтёра Тренажёр «Теремок». Состав чисел первого десятка

Тренажёр «Теремок». Состав чисел первого десятка Проект программы элективного курса для учащихся 9 класса «В мире уравнений высших степеней»

Проект программы элективного курса для учащихся 9 класса «В мире уравнений высших степеней» Ментальный счет

Ментальный счет Определение степени с натуральным показателем

Определение степени с натуральным показателем Значение физической величины. Количественная оценка измеряемой величины

Значение физической величины. Количественная оценка измеряемой величины