Слайд 14

И на последок

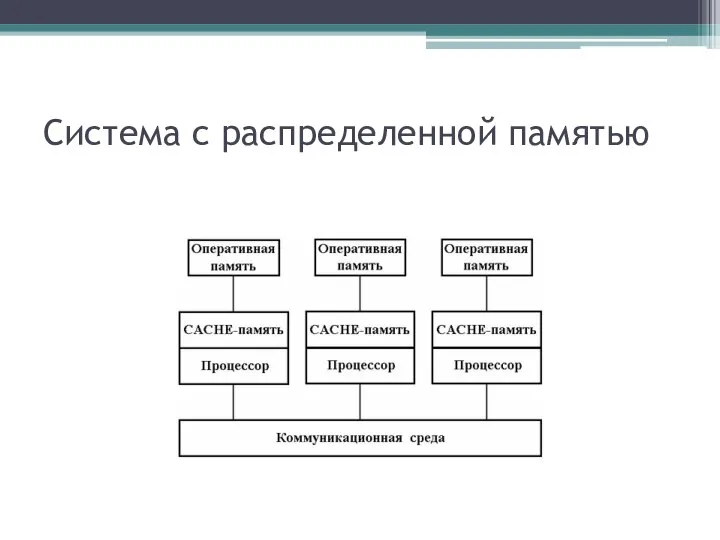

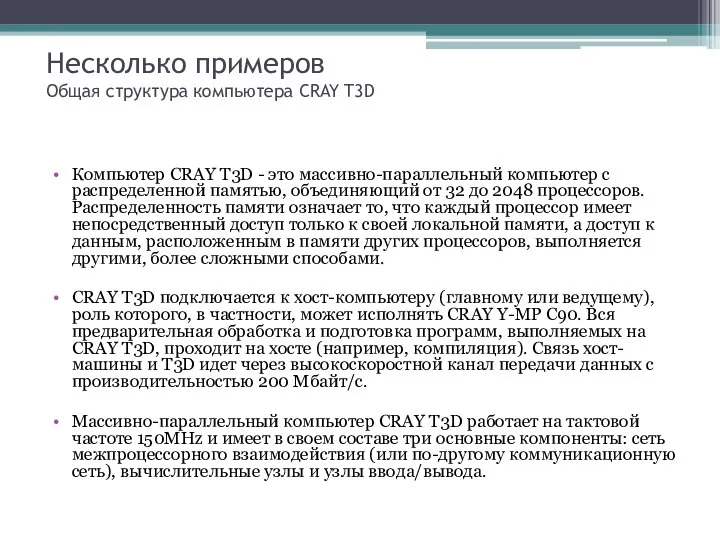

Массивно-параллельные системы остаются достаточно дорогими. Однако заложенная в них

идея - использование большого числа процессоров, каждый из которых имеет собственную локальную память и подключен к сети передачи данных, - может быть реализована иначе. Суперкомпьютером будет служить сеть рабочих станций. В ряде прикладных пакетов эта идея уже воплощена. Вычисления распределяются по сети и выполняются на станциях в фоновом режиме. Разумеется, далеко не все задачи удается распараллелить таким образом, чтобы обычная локальная сеть могла обеспечить требуемый уровень передачи сообщений между процессами. Однако тот факт, что многие пакеты передачи сообщений, в том числе и MPI, существуют в варианте для сетей рабочих станций, говорит о том, что этот вариант имеет право на существование. Вполне вероятно, что с появлением на персональных компьютерах защищенных операционных систем, таких как Windows NT или OS/2, подобные пакеты будут реализованы и для них, тогда локальная сеть учреждения сможет функционировать как распределенный суперкомпьютер.

Программирование на языке высокого уровня. (Лекции 1, 2)

Программирование на языке высокого уровня. (Лекции 1, 2) Понятие консалтинга в области информационных технологий

Понятие консалтинга в области информационных технологий  Физическое воспитание

Физическое воспитание Мольер Жан Батист

Мольер Жан Батист Разработка грунта землеройно-транспортными машинами

Разработка грунта землеройно-транспортными машинами Факторы, усиливающие коррупцию в РФ. Григоров Георгий Т-095

Факторы, усиливающие коррупцию в РФ. Григоров Георгий Т-095 Социология общественного мнения Вводная лекция

Социология общественного мнения Вводная лекция ЕС и Европейските институции Ролята на неправителствения сектор Петър Нацев, Парламентарен сътрудник на Илиана Иванова

ЕС и Европейските институции Ролята на неправителствения сектор Петър Нацев, Парламентарен сътрудник на Илиана Иванова Документальное оформление операций по учету основных средств

Документальное оформление операций по учету основных средств Эталонны

Эталонны  Организация внеурочной деятельности обучающихся: моделирование и проектирование кафедра педагогики и андрагогики ТОГИРРО 201

Организация внеурочной деятельности обучающихся: моделирование и проектирование кафедра педагогики и андрагогики ТОГИРРО 201 Sofaz. The State Oil Fund of the Republic of Azerbaijan

Sofaz. The State Oil Fund of the Republic of Azerbaijan Интерактивные KPI процессов eTOM Ф.В.Краснов

Интерактивные KPI процессов eTOM Ф.В.Краснов  ИНТЕРМОДАЛЬНЫЕ ПЕРЕВОЗКИ ГРУЗОВ Контейнерные перевозки грузов; Операторы смешанной перевозки грузов; Особенности взаимодей

ИНТЕРМОДАЛЬНЫЕ ПЕРЕВОЗКИ ГРУЗОВ Контейнерные перевозки грузов; Операторы смешанной перевозки грузов; Особенности взаимодей Прыжки в высоту способом «фосбери-флоп»

Прыжки в высоту способом «фосбери-флоп» Лекция 4. Курсовая работа по дисциплине «Основы конструирования программ» (2 семестр)

Лекция 4. Курсовая работа по дисциплине «Основы конструирования программ» (2 семестр) ОСНОВОПОЛАГАЮЩИЕ ИДЕИ И ПРИНЦИПЫ УПРАВЛЕНИЯ ИЗМЕНЕНИЯМИ

ОСНОВОПОЛАГАЮЩИЕ ИДЕИ И ПРИНЦИПЫ УПРАВЛЕНИЯ ИЗМЕНЕНИЯМИ Тема: Действия с натуральными числами

Тема: Действия с натуральными числами Президент Н.Назарбаевтың еуразиялық идеясы

Президент Н.Назарбаевтың еуразиялық идеясы Организация ЛПО

Организация ЛПО  Акробатика и воздушная гимнастика на полотнах

Акробатика и воздушная гимнастика на полотнах Тема 7. Трудовой договор План лекции № 1 1.Понятие и содержание трудового договора. 2.Порядок заключения трудового договора. 3.П

Тема 7. Трудовой договор План лекции № 1 1.Понятие и содержание трудового договора. 2.Порядок заключения трудового договора. 3.П Итоги работы предприятий агропромышленного комплекса Жлобинского района за январь-июль 2019 года

Итоги работы предприятий агропромышленного комплекса Жлобинского района за январь-июль 2019 года Проекционное черчение. Проецирование на несколько проекций

Проекционное черчение. Проецирование на несколько проекций Техническое описание и анализ конструкции компрессора газотурбинного двигателя АИ-450 МС

Техническое описание и анализ конструкции компрессора газотурбинного двигателя АИ-450 МС Понятие о физиотерапии. Постоянный ток. Импульсные токи

Понятие о физиотерапии. Постоянный ток. Импульсные токи Почвенно-географическое районирование

Почвенно-географическое районирование How to Download the Firmware image over the USB

How to Download the Firmware image over the USB